предыдущие главы

Кривые обучения

28 Диагностика смещения и разброса: кривые обучения Мы рассмотрели несколько подходов к разделению ошибок на предотвратимую погрешность и разброс.Мы сделали это, оценив оптимальную частоту ошибок путем расчета ошибок на обучающем наборе алгоритма и на проверочном наборе.

Давайте обсудим более информативный подход: графики кривой обучения.

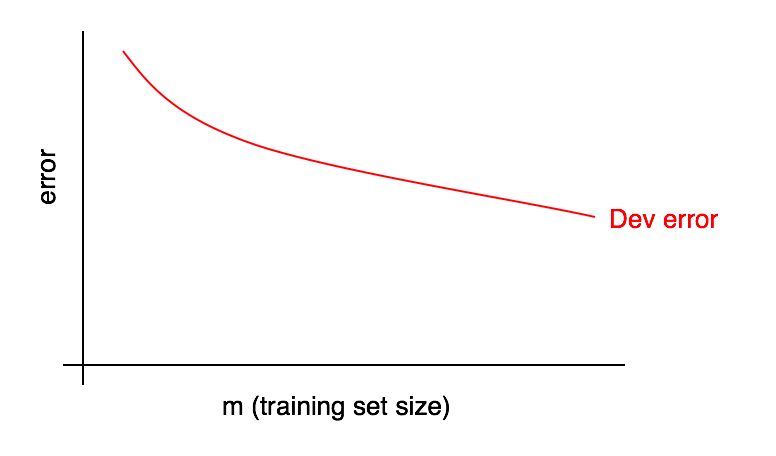

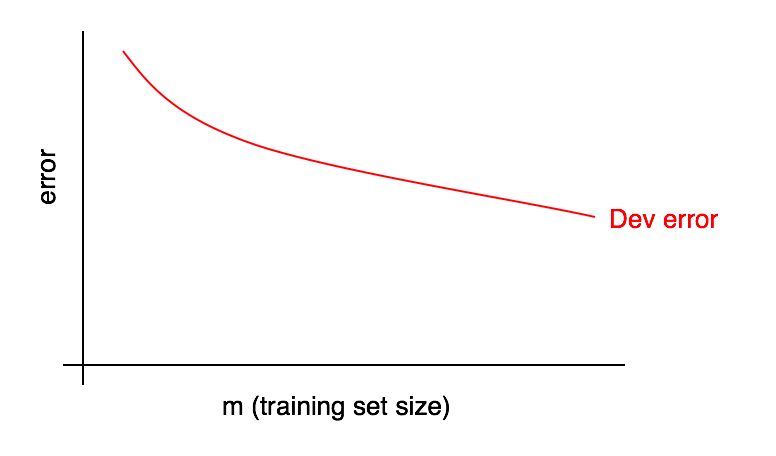

Графики кривой обучения представляют собой зависимость частоты ошибок от количества примеров в обучающей выборке.

По мере увеличения размера обучающего набора ошибка в проверочном наборе должна уменьшаться.

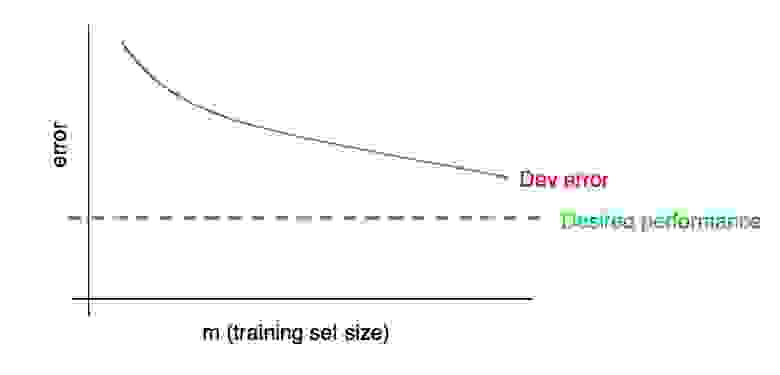

Мы часто стремимся к некоторой «желаемой частоте ошибок», которую, как мы надеемся, в конечном итоге достигнет наш алгоритм.

Например:

- Если мы надеемся достичь уровня качества, достижимого людьми, тогда частота человеческих ошибок должна стать «желаемой частотой ошибок».

- Если в продукте (например, в поставщике изображений кошек) используется алгоритм обучения, мы можем понять, какой уровень качества необходимо достичь, чтобы пользователи получили максимальную выгоду.

- Если вы долгое время работали над важным приложением, у вас может быть разумное понимание того, какого прогресса вы можете достичь в следующем квартале/году.

Вы можете визуально экстраполировать красную кривую ошибок на проверочном наборе и предположить, насколько ближе вы сможете приблизиться к желаемому уровню качества, добавив больше данных.

В примере, показанном на картинке, вполне вероятно, что удвоение размера обучающего набора позволит достичь желаемого уровня качества.

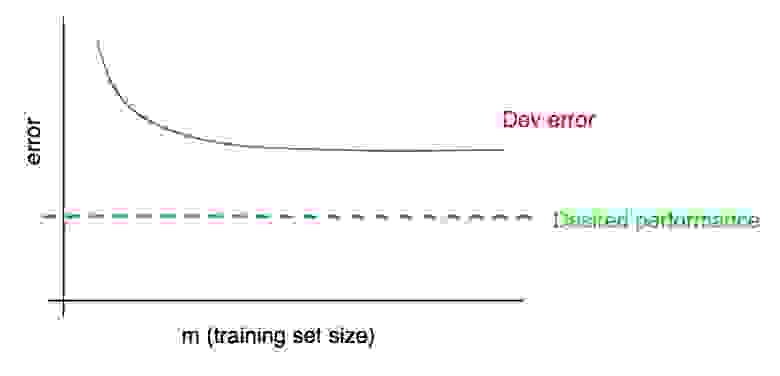

Однако если кривая частоты ошибок проверочной выборки выходит на плато (т. е.

превращается в прямую линию, параллельную оси X), это сразу указывает на то, что добавление дополнительных данных не поможет достичь цели:

Таким образом, анализ кривой обучения может помочь вам не тратить месяцы на сбор вдвое большего объема тренировочных данных только для того, чтобы понять, что добавление большего количества не поможет.

Одним из недостатков этого подхода является то, что если вы посмотрите только на кривую ошибок в наборе проверки, может быть сложно экстраполировать и точно предсказать, как поведет себя красная кривая, если вы добавите больше данных.

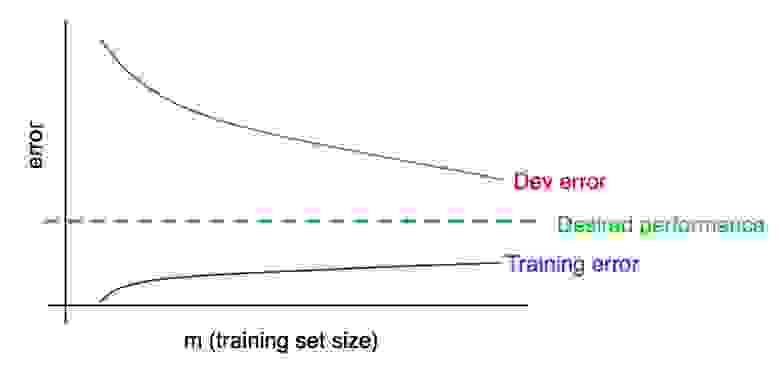

Следовательно, есть еще один график, который может помочь оценить влияние дополнительных данных обучения на частоту ошибок: ошибка обучения.

29 График ошибок обучения Ошибки в проверочных (и тестовых) наборах должны уменьшаться по мере увеличения обучающего набора.

Но на обучающем наборе ошибка обычно увеличивается при добавлении данных.

Проиллюстрируем этот эффект на примере.

Предположим, ваш обучающий набор состоит всего из двух примеров: одна картинка с кошками и одна без кошек.

В этом случае алгоритму обучения легко запомнить оба примера обучающего набора и показать ошибку 0% на обучающем наборе.

Даже если оба обучающих примера помечены неправильно, алгоритм легко запомнит их классы.

Теперь представьте, что ваш обучающий набор состоит из 100 примеров.

Допустим, ряд примеров классифицированы неверно, или по некоторым примерам невозможно определить класс, например, для размытых изображений, когда даже человек не может определить, присутствует на изображении кошка или нет. Предположим, что алгоритм обучения по-прежнему «помнит» большинство примеров в обучающей выборке, но добиться 100% точности теперь сложнее.

По мере увеличения обучающей выборки с 2 до 100 примеров вы обнаружите, что точность алгоритма на обучающей выборке будет постепенно снижаться.

Наконец, давайте представим, что ваш обучающий набор состоит из 10 000 примеров.

В этом случае алгоритму становится все труднее идеально классифицировать все примеры, особенно если обучающий набор содержит размытые изображения и ошибки классификации.

Таким образом, ваш алгоритм будет работать хуже на таком обучающем наборе.

Добавим график ошибок обучения к нашим предыдущим.

Вы можете видеть, что синяя кривая «Ошибка обучения» увеличивается по мере увеличения обучающего набора.

Более того, алгоритм обучения обычно показывает лучшее качество на обучающем наборе, чем на проверочном наборе; Таким образом, красная кривая ошибок на проверочном наборе лежит строго над синей кривой ошибок на обучающем наборе.

Далее давайте обсудим, как интерпретировать эти графики.

продолжение Теги: #Машинное обучение

-

Гийом, Шарль Эдуар

19 Oct, 24 -

Как Это Реализовано В Хабе Distkontrolusb

19 Oct, 24 -

Понимание Пакета Go: Io

19 Oct, 24 -

Как Я Отлаживал Python Httplib И Httplib2

19 Oct, 24