Часто компании сталкиваются с необходимостью установки нового, более мощного оборудования в существующих помещениях.

Эту задачу иногда бывает сложно решить, но существует ряд стандартных подходов, которые помогут вам ее выполнить.

Сегодня мы поговорим о них на примере дата-центра Mediatek. MediaTek, всемирно известный производитель микроэлектроники, решил построить новый центр обработки данных в своей штаб-квартире.

Как обычно, проект нужно было реализовать в кратчайшие сроки, а также обеспечить совместимость нового решения со всем существующим оборудованием.

Кроме того, средства электроснабжения и охлаждения изначально пришлось адаптировать к условиям здания, в котором должен был начать работу новый дата-центр.

ИТ-директор компании получил запрос на технологии автоматизации и мониторинга дата-центров, а также заказчик приветствовал внедрение энергоэффективных решений в области охлаждения и электроснабжения.

То есть на эти технологии был выделен дополнительный бюджет, который позволил создать в данных условиях по-настоящему высокопроизводительный дата-центр.

Большая нагрузка

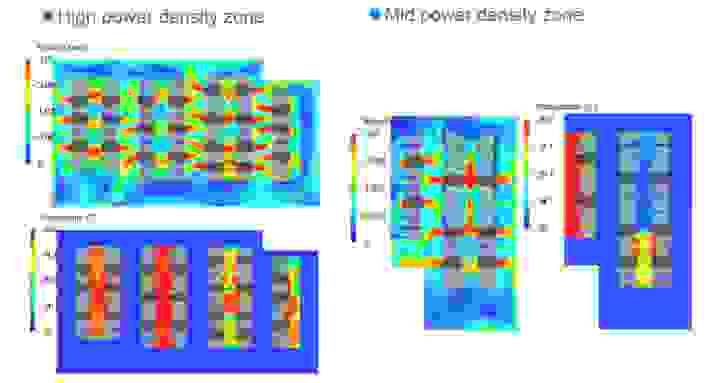

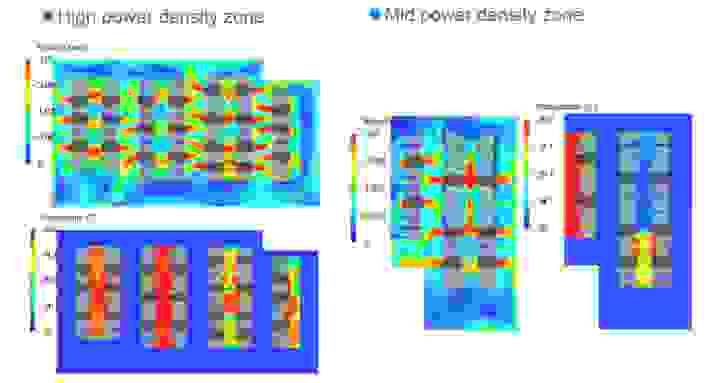

Прежде чем приступить к проекту, необходимо было тщательно изучить особенности размещаемого оборудования – и оно было действительно мощным.В новом дата-центре планировалось установить 80 стоек, часть из которых предполагала размещение нагрузки по 25 кВт. Было проведено моделирование размещения нагрузки и анализ возможных схем охлаждения, после чего было принято решение разделить дата-центр на функциональные зоны.

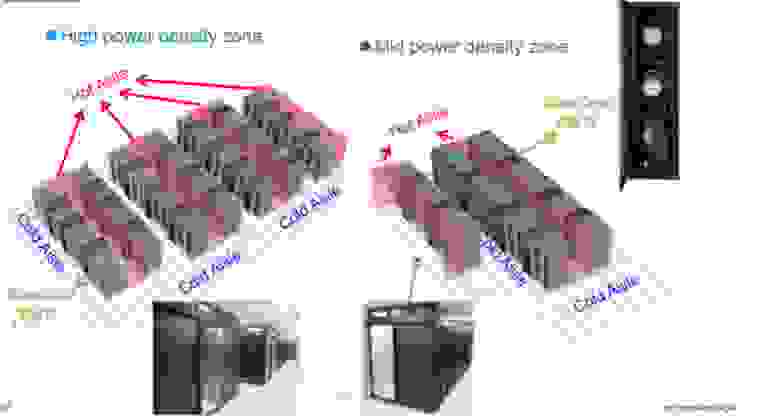

Зону высокой нагрузки, где расположено самое мощное оборудование, выделили, а для охлаждения и электроснабжения решили установить самые мощные и технологичные системы, в том числе внутрирядные кондиционеры RowCool. Отдельно расположилась зона средней плотности, в которой в основном размещалось сетевое коммутационное оборудование, системы хранения и вспомогательные серверы.

Учитывая меньшее энерговыделение стоек, здесь удалось создать более длинный «горячий коридор», а значит сэкономить полезное пространство.

Мы смоделировали движение воздуха и оценили допустимые температурные параметры для обеих зон, рассчитали мощность оборудования и допустимые размеры коридоров, а также параметры размещения оборудования в стойках.

Моделирование движения воздуха помогло найти оптимальные точки для размещения внутрирядных кондиционеров RowCool, чтобы совместное использование активного охлаждения и системы разделения горячих и холодных коридоров давало максимальный эффект.

Для обеих зон были спроектированы и установлены модульные системы распределения нагрузки.

В результате зона высокой нагрузки получила более короткие коридоры и больше кондиционеров RowCool, чем зона средней нагрузки.

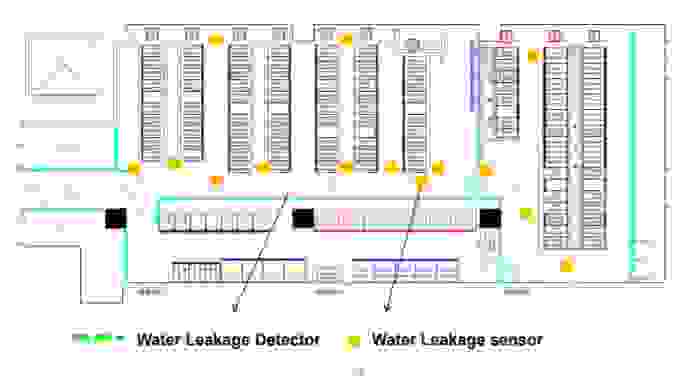

Рядные кондиционеры были подключены к чиллерам с использованием водяного охлаждения.

Для обеспечения безопасности такой системы в дата-центре были установлены десятки датчиков и определены зоны обнаружения возможных утечек жидкости.

Если появится хотя бы одна капля воды, система тут же выдаст уведомление и поможет исправить ситуацию.

При этом кондиционеры RowCool, расположенные в зоне высокой нагрузки, объединяются в группы и между ними настраивается автономное взаимодействие.

Это сделано для того, чтобы при выходе из строя одного кондиционера остальные могли активизировать свою работу и обеспечить достаточное охлаждение с учетом работы «холодного коридора», пока кондиционер будет отремонтирован или заменен.

Для этого также устанавливаются рядные кондиционеры по схеме N+1.

ИБП и распределение электроэнергии

Опираясь на проверенную практику, мы разместили резервные аккумуляторы и системы ИБП в отдельной зоне, чтобы предотвратить смешивание потоков воздуха и потерю мощности систем охлаждения на нагрузках, которые особо не требуют дополнительного охлаждения.

Учитывая, что общая мощность всего дата-центра превышает 1500 кВт, электроинфраструктуру и зону ИБП пришлось проектировать с особой тщательностью.

Модульные ИБП были установлены с учетом резервирования N+1, и каждая стойка была снабжена кольцевым питанием, то есть как минимум двумя силовыми кабелями.

Система мониторинга одновременно отслеживала потребляемую мощность, напряжение и ток, чтобы мгновенно заметить любые аномальные изменения.

В зоне высокой нагрузки блоки распределения питания (PDU) были установлены в задней части стоек Delta, а сверху размещены дополнительные распределительные модули на 60 А.

В зоне средней нагрузки удалось обойтись распределительными шкафами, установленными над стойками.

Такой подход позволил нам сэкономить деньги без ущерба для качества.

Управление и DCIM

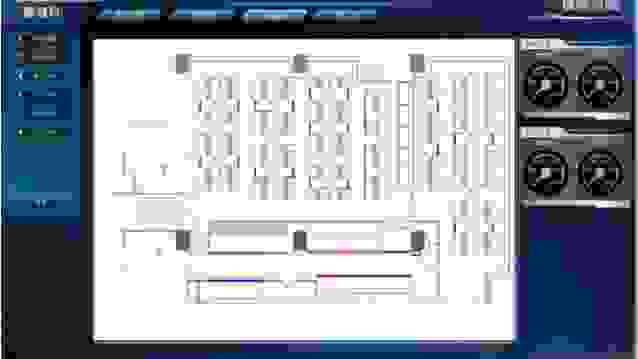

В новом дата-центре внедрены системы управления работой оборудования.Таким образом, через систему DCIM InfraSuite можно отслеживать все оборудование и его расположение в дата-центре, а также все параметры электропитания для каждой отдельной стойки.

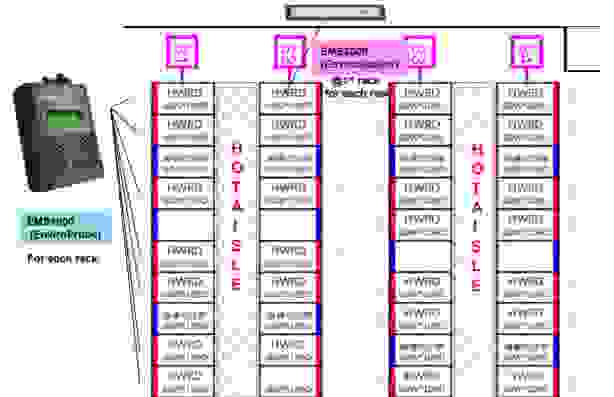

Каждая стойка также была оснащена датчиком и индикатором EnviroProbe, данные с которых собираются на концентраторах EnviroStation для каждого ряда и передаются на центральный сервер управления.

Благодаря этому менеджеры дата-центра могут постоянно контролировать параметры температуры и влажности воздуха в каждой стойке.

Помимо контроля электроснабжения, система InfraSuite позволяет также планировать заполнение дата-центра, поскольку система содержит данные о количестве и мощности установленного оборудования.

Инженеры могут планировать установку новых серверов или систем коммутации, одновременно перераспределяя мощность с помощью интеллектуальных PDU.

Заключение

Практика строительства дата-центра для MediaTek была интересна тем, что нам пришлось разместить множество высокопроизводительных нагрузок на достаточно небольшой площади.И вместо того, чтобы распределять его по всему помещению, оказалось эффективнее выделить в отдельную зону мощные серверы и оснастить их более мощным и технологичным охлаждением.

Комплексная система мониторинга и контроля позволяет постоянно контролировать энергопотребление мощных серверов, а резервные источники охлаждения и питания помогают предотвратить простои даже в случае выхода оборудования из строя.

Именно такие дата-центры необходимо строить для критически важных бизнес-процессов современных компаний.

В опросе могут участвовать только зарегистрированные пользователи.

Войти , Пожалуйста.

Используете ли вы резервирование в своем дата-центре? 8,33% Да, мы также используем кондиционеры N+1 1 25% У нас также есть ИБП N+1 3 25% Мы даже резервируем все еще больше 3 41,67% Нет, мы не используем резервирование 5 Проголосовали 12 пользователей.

7 пользователей воздержались.

Теги: #дата-центр #ИТ-инфраструктура #ИТ-компании #ИТ-компании #ИТ-стандарты #ИБП

-

Мобильная Версия Хабра: Версия 2.0

19 Oct, 24 -

Мошенническая Схема «Страховая Премия»

19 Oct, 24 -

Действует_Как_Конференция 2009

19 Oct, 24 -

Серия Статей По Дизайну Веб-Сервисов

19 Oct, 24 -

Есть Ли Альтернатива Поисковым Системам?

19 Oct, 24