Программно-определяемый подход к хранению данных

В этой статье мы рассмотрим и протестируем новую версию программно-определяемой системы хранения данных (Software-Defined Storage, SDS) Veritas Access 7.3 — многоцелевого масштабируемого хранилища данных на базе обычных серверов с архитектурой x86 с поддержкой файловых, блочных и доступ к объектам.

Наша главная задача — познакомиться с продуктом, его функционалом и возможностями.

Veritas является синонимом надежности и опыта в области управления информацией, имея давнюю традицию лидерства на рынке резервного копирования, предоставляя решения для анализа информации и обеспечения высокой доступности.

Мы видим будущее за решением программно-определяемого хранилища Veritas Access и уверены, что через некоторое время продукт приобретет популярность и займет одну из ключевых позиций на рынке SDS-решений.

Платформой, на которой был создан Access, стал продукт с многолетней историей InfoScale (Veritas Storage Foundation), который в отсутствие виртуализации находился на пике популярности в решениях Highly Available (HA).

А от младшего брата Veritas Access мы ожидаем продолжения истории успеха HA в форме Software-Defined Storage. Одним из преимуществ Veritas Access является цена.

Продукт лицензируется по количеству активных ядер (примерно $1000/1 CORE в GPL (глобальный прайс-лист)), стоимость совершенно не зависит от количества дисков и общего объема СХД.

Для узлов разумно использовать малоядерные высокопроизводительные однопроцессорные серверы.

Грубо говоря, лицензия Access для 4-узлового кластера будет стоить $20 000–$30 000, что выглядит очень привлекательно по сравнению с другими SDS-решениями, где стоимость начинается от $1500 за терабайт сырого пространства по GPL. Главным преимуществом, которое отличает Veritas Access от Ceph и аналогичных SDS-решений, является его «коробочный» характер: Veritas Access — это полноценный продукт уровня Enterprise. Внедрение и поддержка Access не сопряжено с трудностями, с которыми могут справиться только специалисты с глубокими знаниями nix SDS-систем.

В целом внедрение любого решения SDS не является особенно сложной задачей; основные трудности возникают во время эксплуатации в виде добавления узлов при их выходе из строя, передачи данных, обновления и т. д. А в случае с Access все проблемы понятны, поскольку решения описаны для Storage Foundation. А в случае с Ceph вам необходим квалифицированный персонал, способный оказать специализированную поддержку.

Некоторым людям комфортно работать с готовым решением в виде Access, а другим удобно использовать конструктор Ceph с более гибким подходом, но требующим знаний.

Мы не будем сравнивать Access с другими SDS-решениями, а попытаемся дать краткий обзор новинки.

Возможно, это поможет вам сделать выбор, с каким решением SDS вам будет удобнее работать.

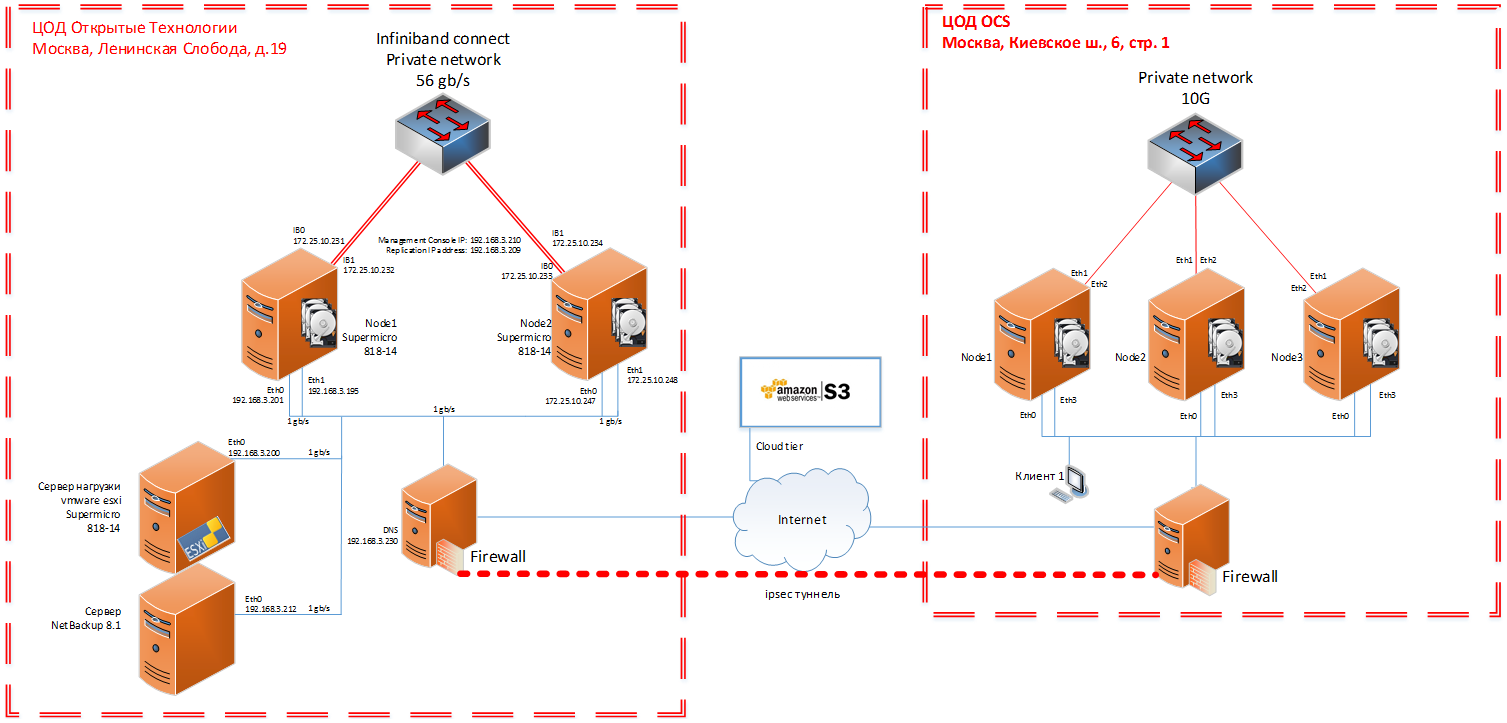

Для прозрачности тестирования, максимально приближенной к производству, мы вместе с коллегами из одного из дистрибьюторов Veritas — компании OCS собрали пятиузловой стенд на физических серверах: двухузловой кластер в дата-центре «Открытые технологии».

и трехузловой кластер в дата-центре OCS. Ниже представлены фотографии и схемы.

Файловое, блочное и объектное хранилище

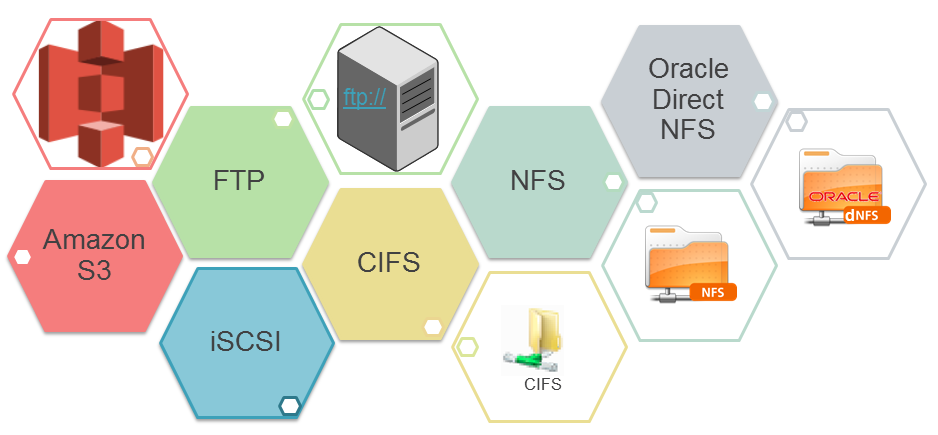

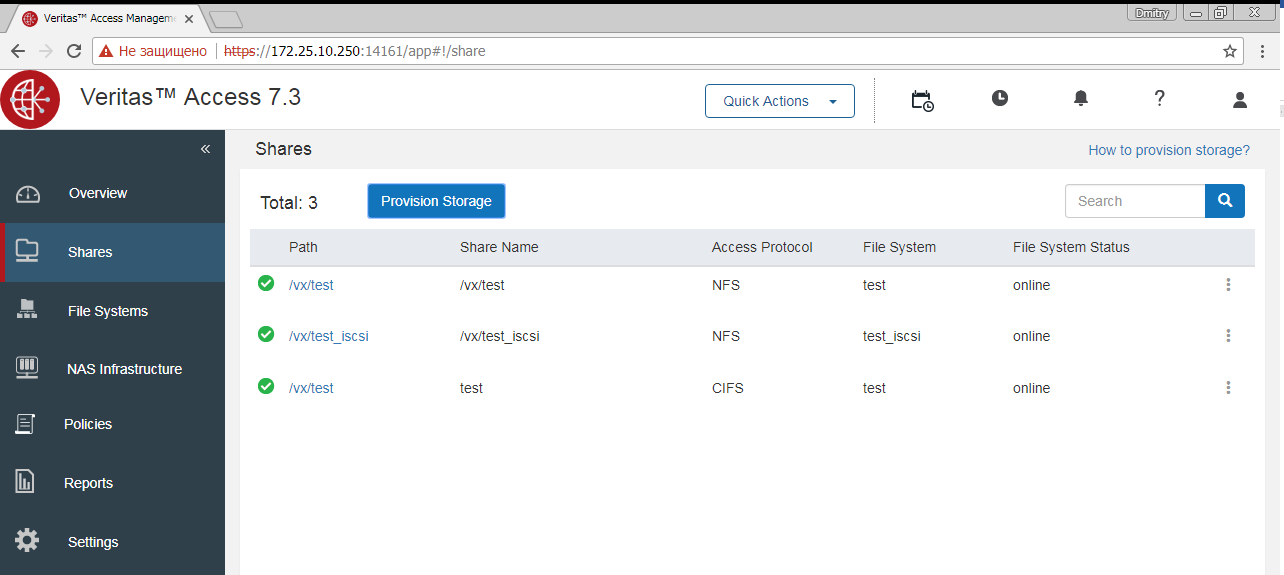

Veritas Access работает для распространения по всем протоколам, обеспечивая доступ к файлам, блокам и объектам.Разница лишь в том, что доступ к файлам очень легко настроить через WEB-интерфейс, тогда как настройка двух других на данный момент плохо описана и сложна.

NFS, S3 работают на узлах в режиме активно-активно.

iSCSI и CIFS в текущей версии 7.3 работают в активно-пассивном режиме.

Службы, подключенные через NFS, S3, продолжат работать при выходе из строя любого из узлов, а службы, подключенные через CIFS, iSCSI, могут не пережить потерю узла, на котором активен CIFS (Samba).

Пройдет некоторое время, пока кластер поймет, что узел вышел из строя, и запустит службу CIFS (Samba) на другом узле, аналогично iSCSI. Активный-активный режим для iSCSI и CIFS обещан в будущих выпусках.

iSCSI в 7.3 представлен как технопревью, в версии Veritas Access 7.3.1, релиз которой обещан 17 декабря 2017 года, будет полная реализация iSCSI в режиме active-active. Подробнее о режимах:

- Активный-активный: с приложением работают два (или более) узла кластера, так называемый режим «приложение стоит на СХД обеими ногами», то есть выход одного узла кластера, работающего с приложением, не приведет к отказу в доступе и потере данных.

- Активно-пассивный: приложение работает только с одним узлом кластера, в этом случае «приложение одной ногой стоит на системе хранения».

Потеря узла критична, возможна потеря записанных данных (возникает ошибка) и кратковременное прекращение доступа.

Для дампа файлов и записи видеоархивов с камер это не критично.

А если вы решите сделать резервную копию своей базы данных с помощью CIFS, и в момент записи резервной копии узел, принявший нагрузку, перестанет работать, произойдет «упс» и вам придется начинать резервное копирование заново.

Соответственно, если выйдет из строя узел, не принявший нагрузку, или узел, на который записано зеркало данных, ничего страшного не произойдет, лишь немного снизится производительность.

Почему СДС?

Немного теории.Традиционные системы хранения хорошо справляются с текущими задачами, обеспечивая необходимую производительность и доступность данных.

Но стоимость хранения и управления различными поколениями систем хранения определенно не является самой сильной стороной традиционных решений.

Масштабирование по архитектуре Scale-up, где производительность повышается за счет замены отдельных компонентов системы, не способно сдержать рост неструктурированных данных в современном ИТ-мире.

Помимо архитектуры вертикального масштабирования Scale-up появились решения Scale-out, где масштабирование осуществляется за счет добавления новых узлов и распределения нагрузки между ними.

Используя этот подход, проблема роста неструктурированных данных решается быстро и доступно.

Недостатки традиционных систем хранения данных: • Высокая цена • Короткий срок хранения систем хранения • Комплексное управление системами хранения различных поколений и производителей.

• Масштабируемая архитектура Плюсы программно-определяемого хранилища с горизонтальным масштабированием: • Нет зависимости от аппаратного обеспечения системы; в качестве узлов можно использовать любой сервер x86 • Гибкое и надежное решение с простым масштабированием и поддержкой резервирования.

• Предсказуемый уровень обслуживания приложений на основе политик.

• Бюджетный • Производительность Минусы программно-определяемого хранилища: • Отсутствие единого пункта технической поддержки • Требуется больше квалифицированных инженеров • Требование N-кратного количества ресурсов (избыточный объем) Пытаясь расширить традиционную СХД после 3-5 лет использования, пользователь сталкивается с резко возрастающими затратами, которые вынуждают покупать новую СХД.

При появлении разрозненных устройств разных производителей теряется контроль над обеспечением уровня качества и надежности подсистемы хранения в целом, что, как правило, существенно усложняет решение бизнес-задач.

Программно-определяемое хранилище позволяет взглянуть на проблему размещения растущих данных с другой стороны: его реализация сохраняет производительность и доступность информации без размножения зоопарка различных производителей и поколений систем хранения, что делает работу с данными более доступной в всем уважением.

Ключевые преимущества для бизнеса

- Доступное и надежное хранилище, поддерживающее существующее оборудование, как старое, так и новое, на платформе x86.

- Высокая производительность для удовлетворения требований к неструктурированным данным — идеально подходит для хранения большого количества небольших файлов с низкой задержкой, а также для обслуживания потоковых рабочих нагрузок за счет высокой скорости записи.

- Высокая доступность.

Благодаря многоузловой масштабируемой файловой системе, которая обеспечивает аварийное переключение локальных, городских и глобальных узлов без прерывания доступа.

- Единое решение хранения для новых и устаревших приложений.

Многопротокольное решение для хранения данных (CIFS, NFS, iSCSI и S3)

- Простой в использовании интерфейс WEB, SSH и RESTful API.

- Гибкая, масштабируемая архитектура.

Легко добавляйте новые узлы для повышения производительности, отказоустойчивости и емкости.

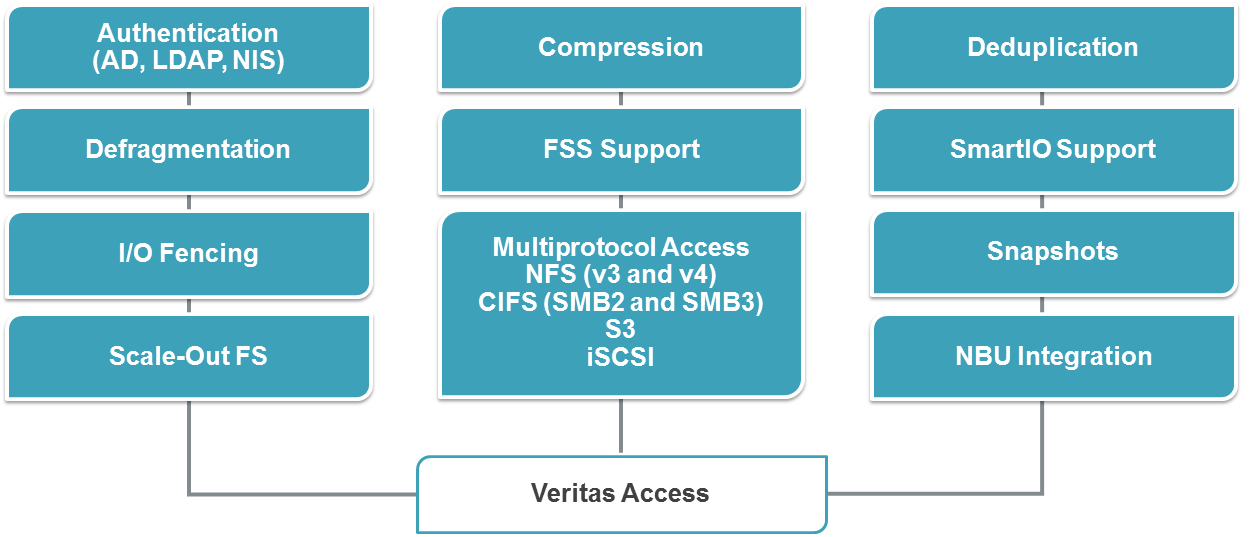

Основные технические характеристики

- Высокодоступная масштабируемая файловая система обеспечивает отказоустойчивость как локально, так и глобально посредством репликации.

- Управление хранилищем на основе политик, позволяющее гибко настраивать уровень доступности, производительности, защиты данных и безопасности томов.

- Многопротокольный доступ к файлам и объектам: работа с NFS, SMB3/CIFS, iSCSI, FTP и S3, включая поддержку чтения и записи на один и тот же том с использованием разных протоколов.

- Гибридное облако: - OpenStack: поддержка Cinder и Manila. — Amazon (AWS): поддержка интерфейса и протокола S3.

- Централизованный пользовательский интерфейс — единое окно для управления всеми узлами с простым и интуитивно понятным интерфейсом.

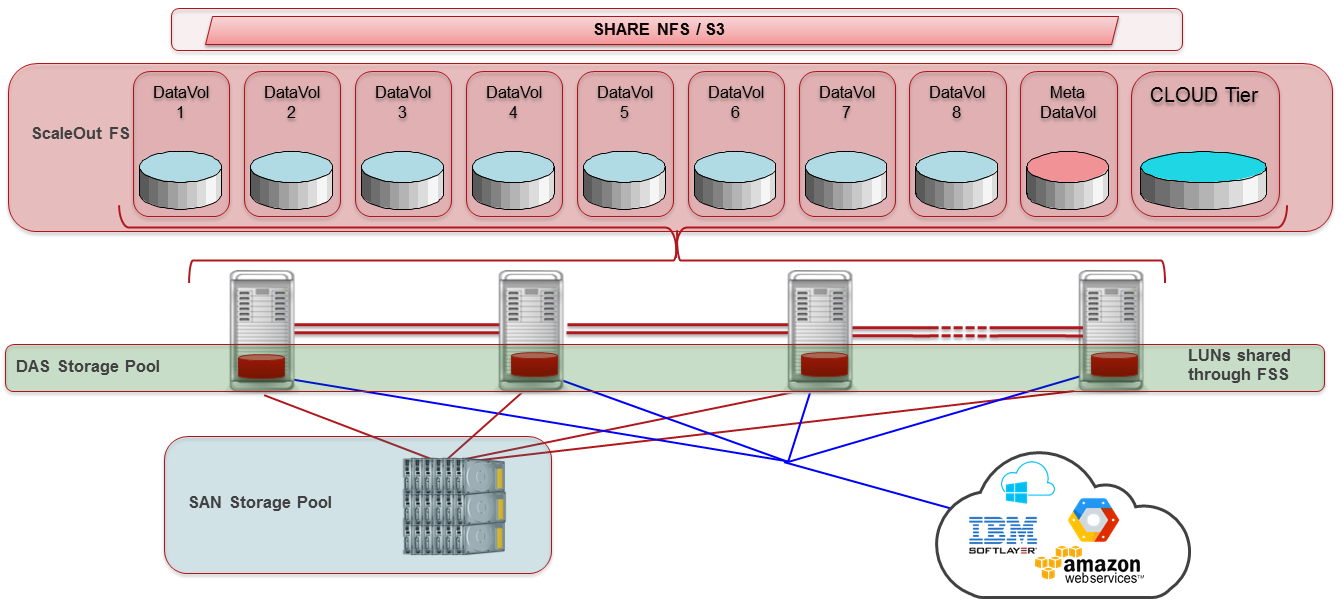

- Поддерживает гетерогенную память DAS, SSD, SAN и облако.

- Многоуровневое хранение: поддержка многоуровневого хранения между различными томами хранения: облаком, SAN, DAS и SSD.

- Кэширование чтения: возможность использовать SSD для кэша.

- Оптимизация хранилища: поддержка дедупликации и сжатия.

- Снимки.

- Готовность к прямому резервному копированию: встроенный клиент NetBackup для резервного копирования, а также поддержка Veritas Enterprise Vault.

- Гибкие возможности аутентификации с поддержкой LDAP, NIS и AD.

- Гибкие возможности управления с поддержкой WEB, SSH и RESTful API.

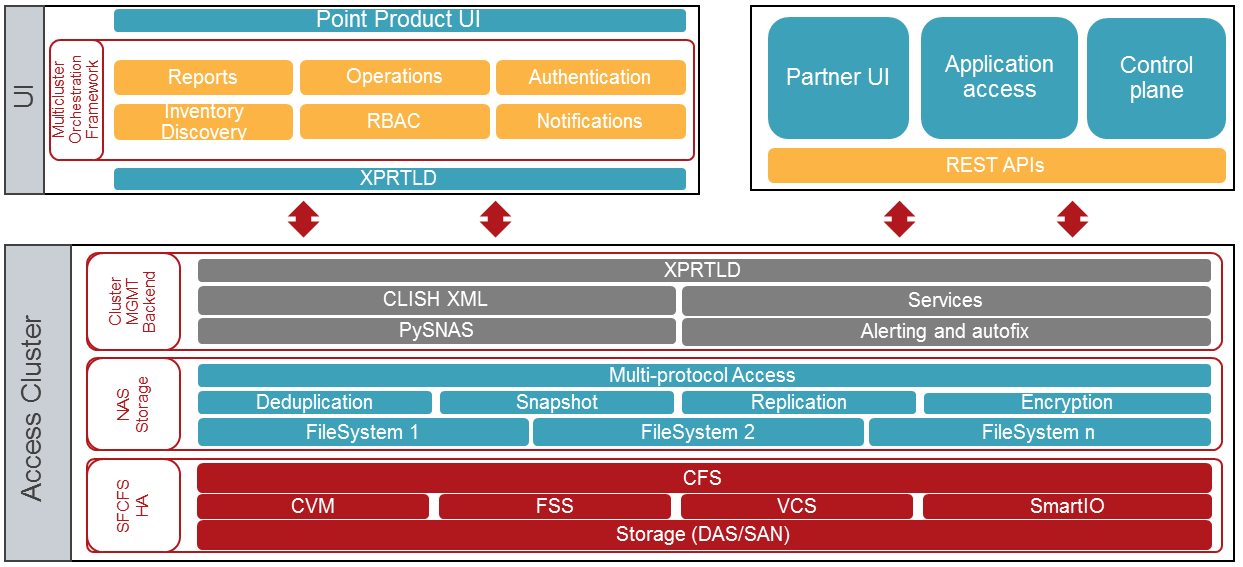

АРХИТЕКТУРА

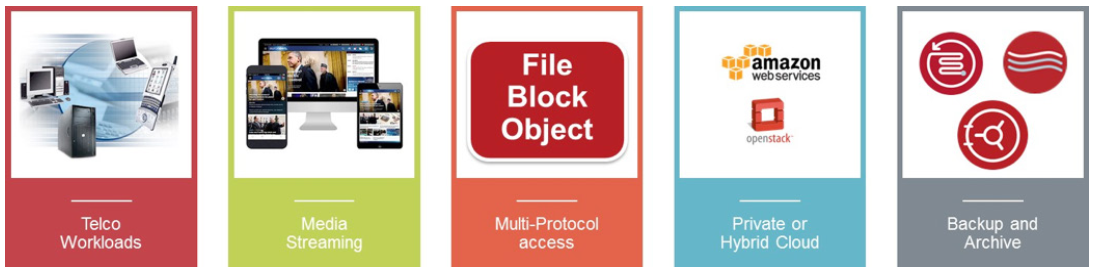

Veritas Access легко и гибко масштабируется за счет большего количества узлов.Данное решение в первую очередь подходит для работы с неструктурированными данными, а также других задач хранения.

Потребность в программно-определяемых системах хранения данных диктует переход к многофункциональным, мультипротокольным продуктам, сочетающим в себе надежность, высокую производительность и доступную стоимость.

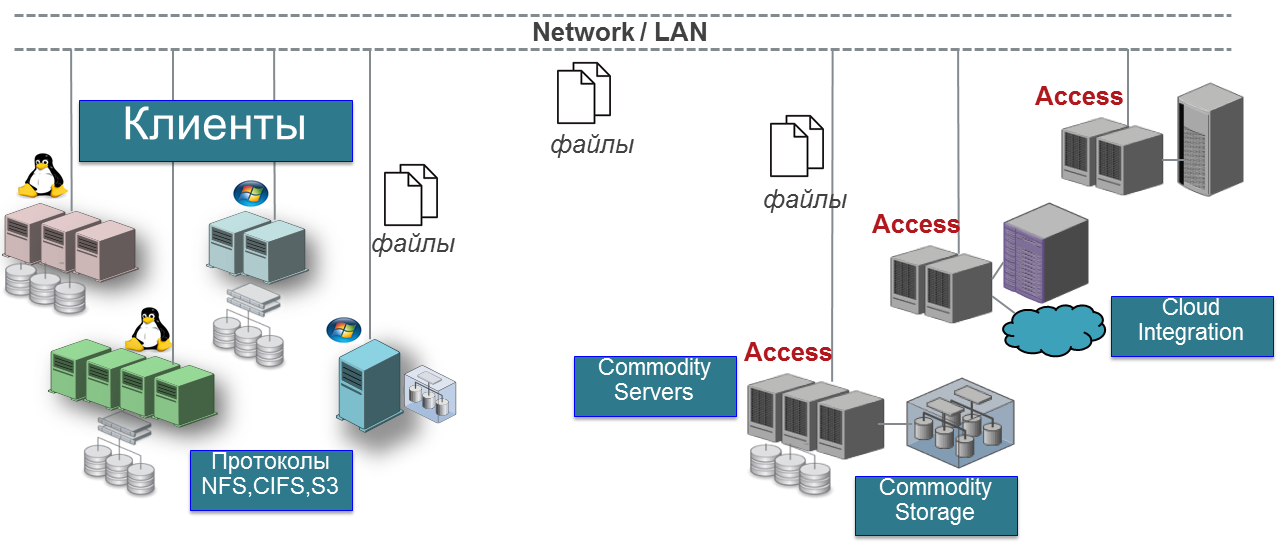

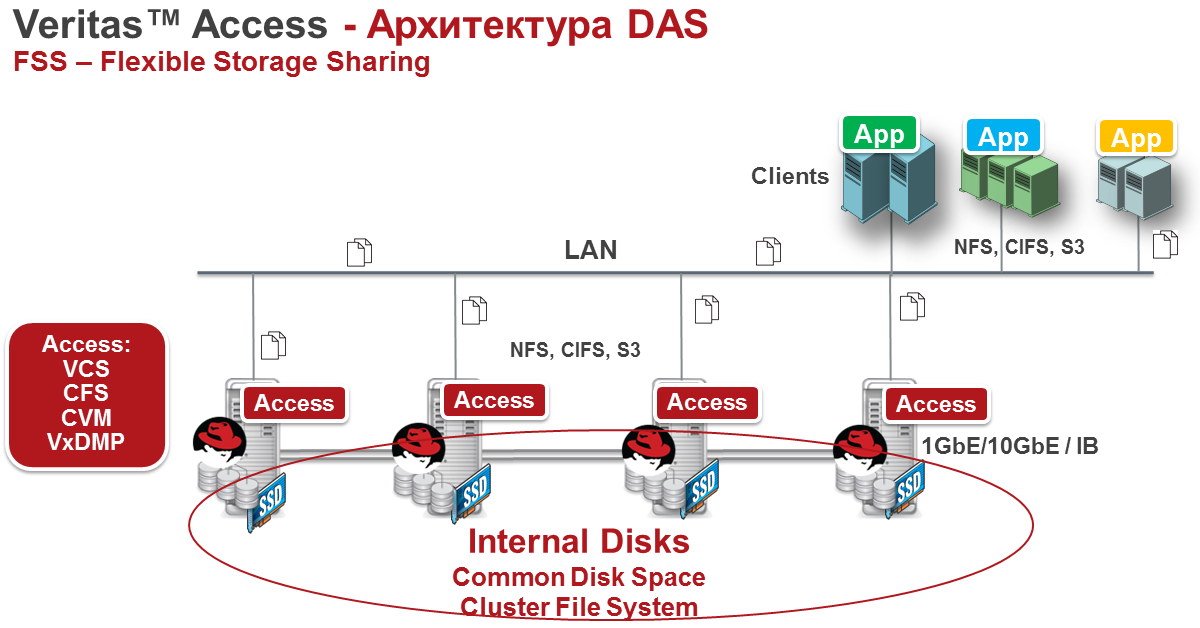

Кластер Veritas Access состоит из связанных серверов, называемых узлами.

Вместе они образуют единый кластер, разделяющий все основные ресурсы.

Минимальная эталонная архитектура состоит из двухузлового решения конвергентной системы хранения данных.

Veritas Access Foundation — Veritas Storage Foundation

Наработки, полученные за время жизненного цикла Veritas Storage Foundation, нашли свое логическое применение в современном продукте класса SDS – Veritas Access. В Access в основном проявляются следующие компоненты:

- Кластерный сервер Veritas (VCS) — система кластеризации сервисов приложений.

- Кластерная файловая система Veritas (CFS) - кластерная файловая система.

- Менеджер томов кластера Veritas (CVM) — менеджер кластера логических томов.

- Гибкое совместное использование хранилища (FSS) — технология, позволяющая объединить все локальные ресурсы хранения узлов в единый пул, доступный любому узлу кластера.

Чтобы добавить узел в кластер, сервер должен иметь как минимум 4 порта Ethernet. Как минимум 2 порта предназначены для клиентского доступа и как минимум 2 порта предназначены для межузлового соединения.

Для межузлового соединения Veritas рекомендует использовать InfiniBand. Минимальные требования для межсоединения 1 ГБ Ethernet. Что касается оперативной памяти, рекомендуется использовать 32 ГБ для производства.

Veritas Cluster File System (CFS) позволяет кэшировать данные с помощью оперативной памяти, поэтому любой объем памяти выше 32 ГБ не будет лишним, но меньше лучше не использовать.

8 ГБ достаточно для тестирования; программных ограничений нет. Лучше избегать трехузловой конфигурации; мы рекомендуем использовать два узла или четыре, пять и т. д. одновременно.

Текущий лимит для одного кластера — 20 узлов.

Кластер InfoScale поддерживает 60 узлов, поэтому 20 узлов — не предел.

Кластер VCS обеспечивает отказоустойчивую работу сервисов доступа к данным по протоколам NFS, CIFS, S3, FTP, Oracle Direct NFS и сопутствующей инфраструктуре на узлах Veritas Access, а в определенных конфигурациях можно обеспечить запись и чтение одних и тех же данных с помощью разные протоколы.

Для организации файловых систем размером до 3 ПБ может использоваться масштабируемая файловая система (Scale-out), позволяющая, в частности, подключать внешние облачные хранилища в рамках единого пространства имен.

При построении распределенных систем хранения или аварийном восстановлении репликацию файлов можно настроить между различными хранилищами Veritas Access. Эта технология позволяет асинхронно реплицировать файловую систему исходного кластера на удаленный кластер с минимальным интервалом в 15 минут, при этом удаленная файловая система остается открытой для чтения во время репликации.

Поддерживает балансировку нагрузки между каналами репликации и мгновенное переключение удаленной файловой системы в режим записи при недоступности источника и переключение службы репликации с одного узла на другой в случае сбоя.

Количество параллельных операций репликации не ограничено.

Важно отметить, что технология репликации использует функциональность Veritas CFS/VxFS (Журнал изменений файлов и мгновенное копирование на уровне файловой системы) для быстрого обнаружения изменений, что позволяет избежать траты времени на сканирование файловой системы и существенно повышает производительность репликации.

ДИСКОВАЯ АРХИТЕКТУРА

Схема стенда вместе с OCS:

Фото стенда на Открытых Технологиях:

|

|

|---|

Загрузка и установка

Вы можете получить дистрибутив Red Hat Enterprise Linux по 30-дневной подписке.После завершения пробной версии дистрибутивы Red Hat будут доступны для скачивания, в частности необходимые релизы 6.6–6.8. Вы можете получить дистрибутив Veritas Access по этой ссылке .

Для этого вам необходимо заполнить пробную форму.

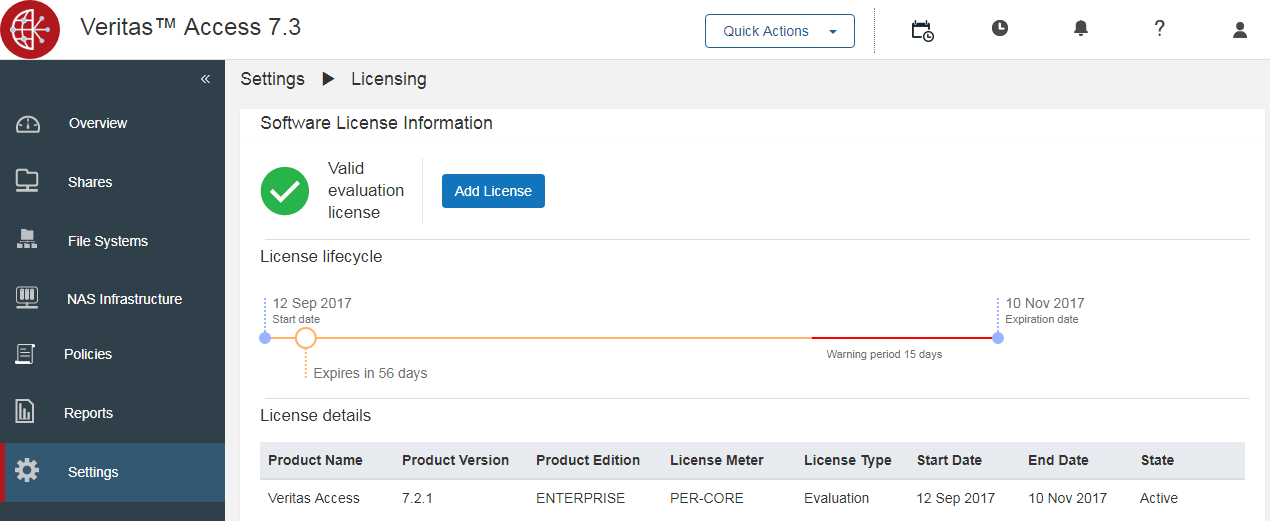

В процессе установки система сама предложит ключ на 60 дней.

Вы можете добавить основную лицензию позже через панель веб-администрирования в разделе «Настройки» → «Лицензирование».

Вся документация для версии 7.3 доступна.

связь .

Установку Veritas Access можно условно разделить на два этапа:

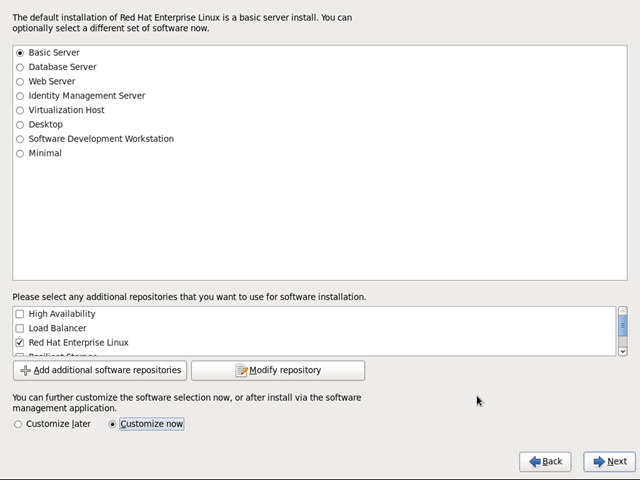

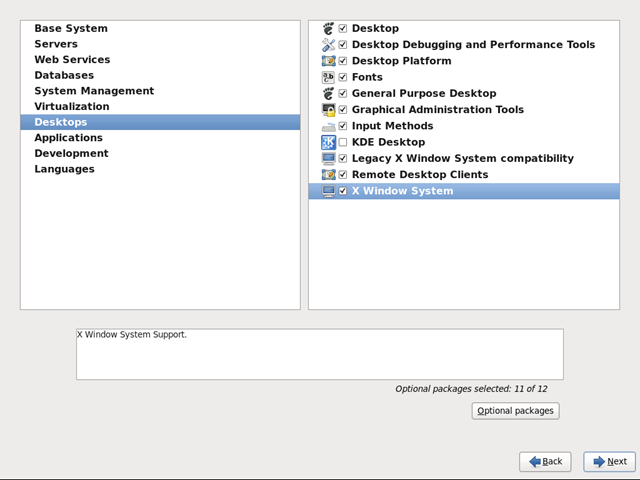

1. Установка и настройка Red Hat Enterprise Linux

2. Установите Veritas Access. Установка Linux Red Hat Enterprise Linux

Простая установка Linux без каких-либо сложностей.

Требования Red Hat:

Если у вас есть подписка Red Hat, установщик Veritas Access автоматически установит необходимые модули RPM. Начиная с выпуска Access 7.3, в репозиторий установщика добавлены все необходимые модули.

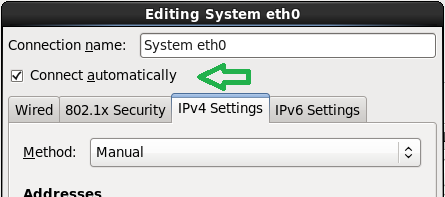

На общедоступных интерфейсах помимо IP-адресов необходимо установить флаг «Соединение автоматически» или «ONBOOT=yes» в файле конфигурации интерфейса.

Установка Veritas Access:

Установочные файлы должны быть размещены на одном узле.

Установка запускается командой:

где node1_ip, node2_ip — любой из IP-адресов общедоступного интерфейса.# ./installaccess node1_ip node2_ip nodeN_ip

В процессе установки Veritas Access следует обратить внимание на некоторые моменты:

- Программа установки Veritas Access создана для идеальной установки.

Любой шаг влево-вправо для него критичен и может привести к ошибке установки.

Внимательно вводите адреса, маски, имена.

- Установку необходимо запускать локально с любого хоста или через механизм управления серверами при отсутствии к ним физического доступа, а не ssh.

- Если вам не удалось установить Veritas Access с первого раза, я рекомендую переустановить Red Hat и начать установку Veritas Access с нуля.

В случае возникновения ошибки программа установки не выполняет откат системы перед установкой, что приводит к повторной установке с частично запущенными службами Veritas Access и может вызвать проблемы.

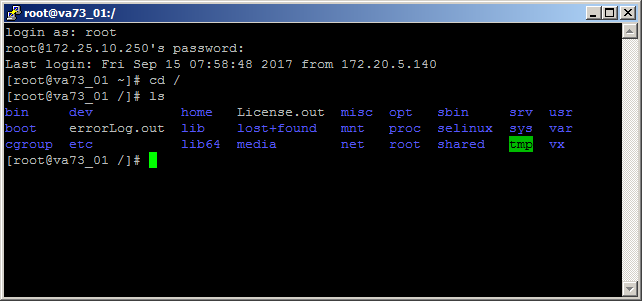

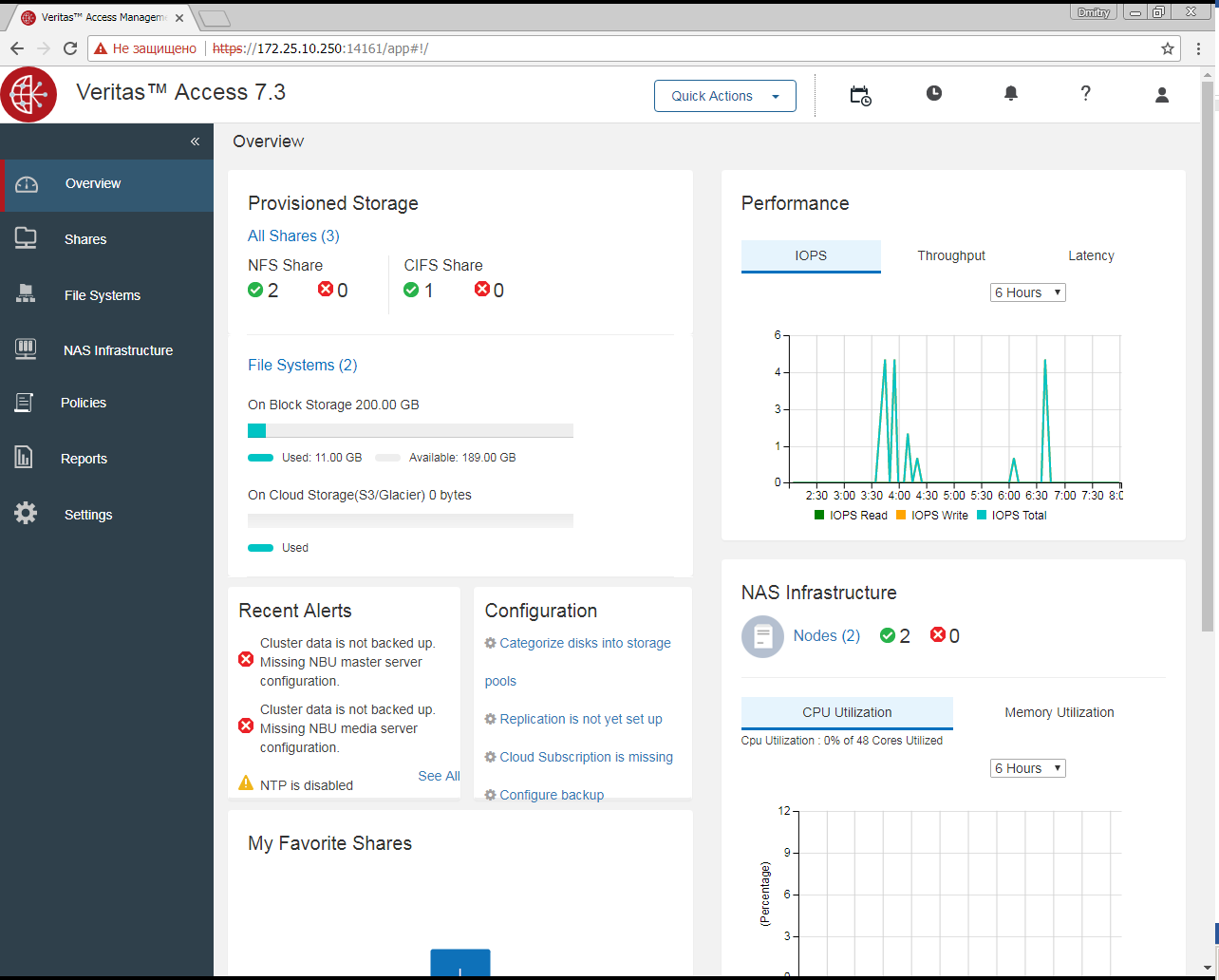

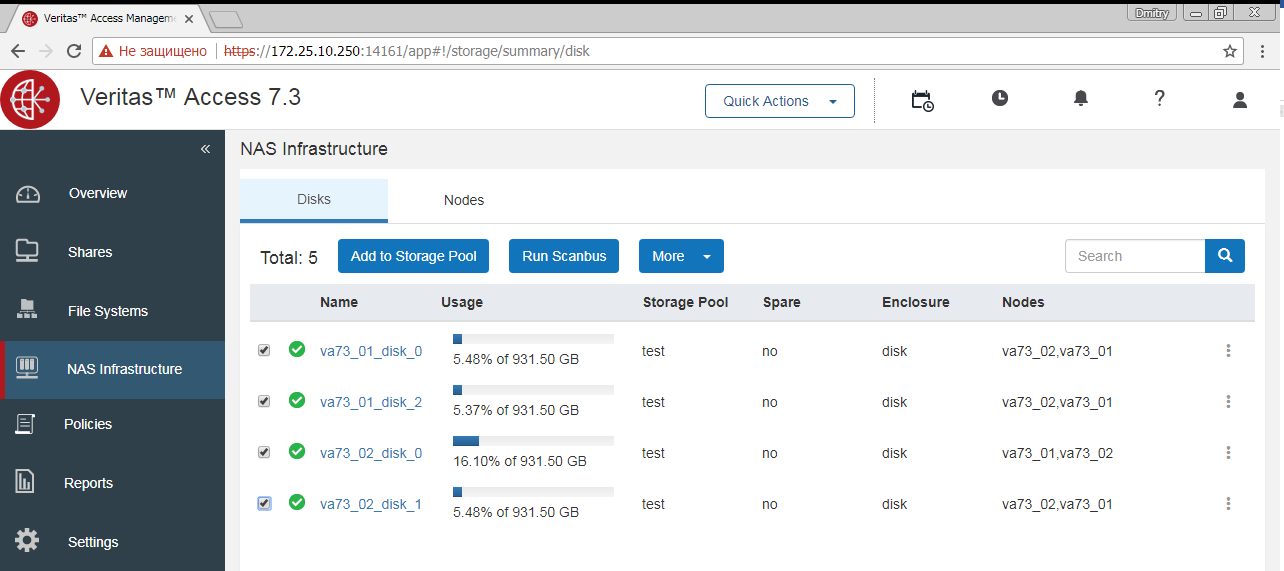

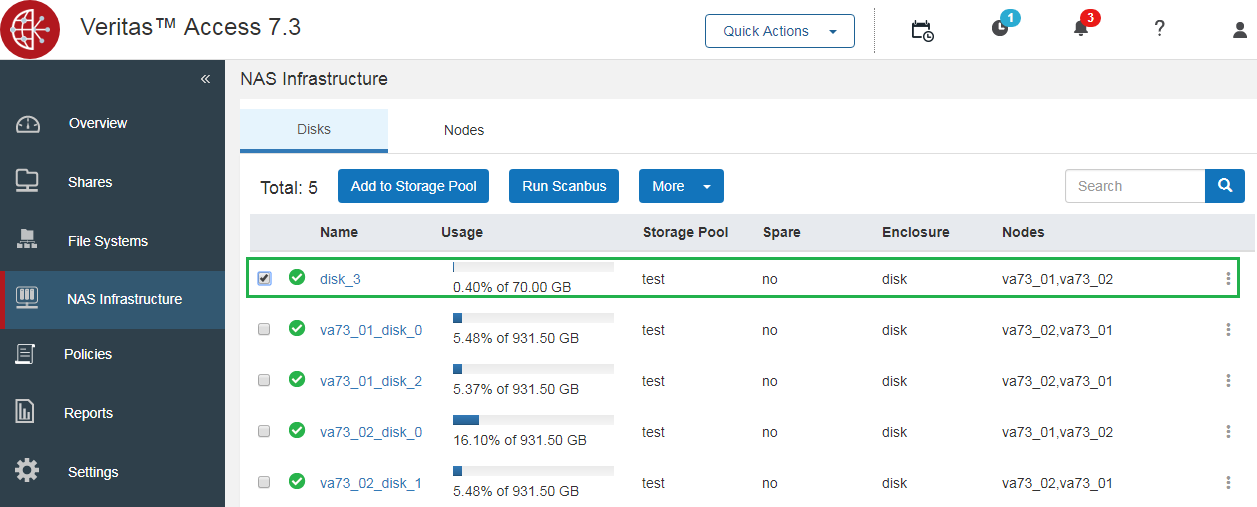

• веб – в нашем случае это https://172.25.10.250:14161 • ssh — к 172.25.10.250 с мастером входа (мастер паролей по умолчанию) и пользователем root. После установки Access необходимо предоставить кластеру все диски каждого узла, которые вы планируете использовать в кластере для данных.

Этот процесс не является автоматическим, поскольку у вас могут быть другие планы для некоторых дисков кластера.

CLISH-команды: # vxdisk list

# vxdisk export diskname1-N

# vxdisk scandisks

Для «нестандартных» серверных дисков необходимо указать модель диска и адрес, по которому находится серийный номер диска.

В моем случае на SATA-дисках команда оказалась такой: # vxddladm addjbod vid=ATA pid="WDC WD1003FBYX-0" serialnum=18/131/16/12

Это небольшой минус SDS-систем по сравнению с жесткими дисками, изготовленными не из Списки совместимого оборудования .

Каждый вендор закладывает в диски свои стандарты, видя терабайты в разном количестве байтов, секторов, размещая идентификаторы по разным адресам.

И ситуация вполне нормальная.

Если система хранения SDS неправильно определяет диски, ей нужна небольшая помощь, в случае с Access — инструкции Здесь .

И вот в чем преимущество Access: возникла нестандартная ситуация — есть документ с ее решением, который ищет гугл, кроме того, в самом модуле vxddladm есть подробная справка.

Не надо читать буржуйские форумы и доделывать это на коленях с непредсказуемыми результатами в производстве.

Если вы не можете решить проблему самостоятельно, вы всегда можете обратиться в техподдержку.

В результате каждый диск должен быть доступен каждому узлу кластера.

После установки папка с установочными файлами будет удалена.

Как все это работает

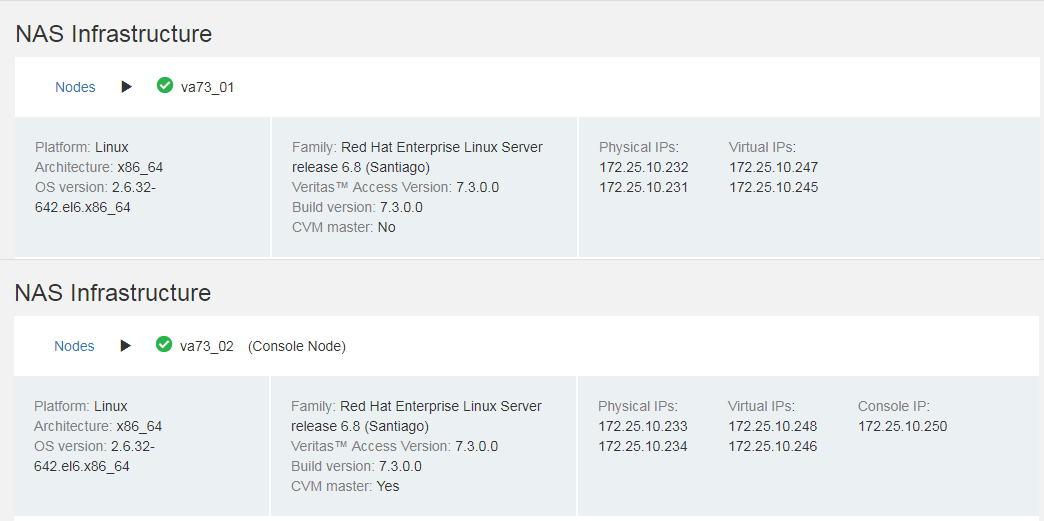

В нашем случае кластер состоит из двух узлов:

Каждый узел имеет физические и виртуальные IP-адреса.

Физические IP-адреса назначаются каждому узлу как уникальные, виртуальные IP-адреса обслуживают все узлы в кластере.

Проверить доступность узла можно с помощью физических интерфейсов и подключиться напрямую по ssh. Если узел недоступен, его физические интерфейсы будут недоступны.

Виртуальные IP-адреса каждого узла обслуживают все узлы в кластере и активны, пока в кластере есть хотя бы один работающий узел.

Клиенты работают только с виртуальными адресами.

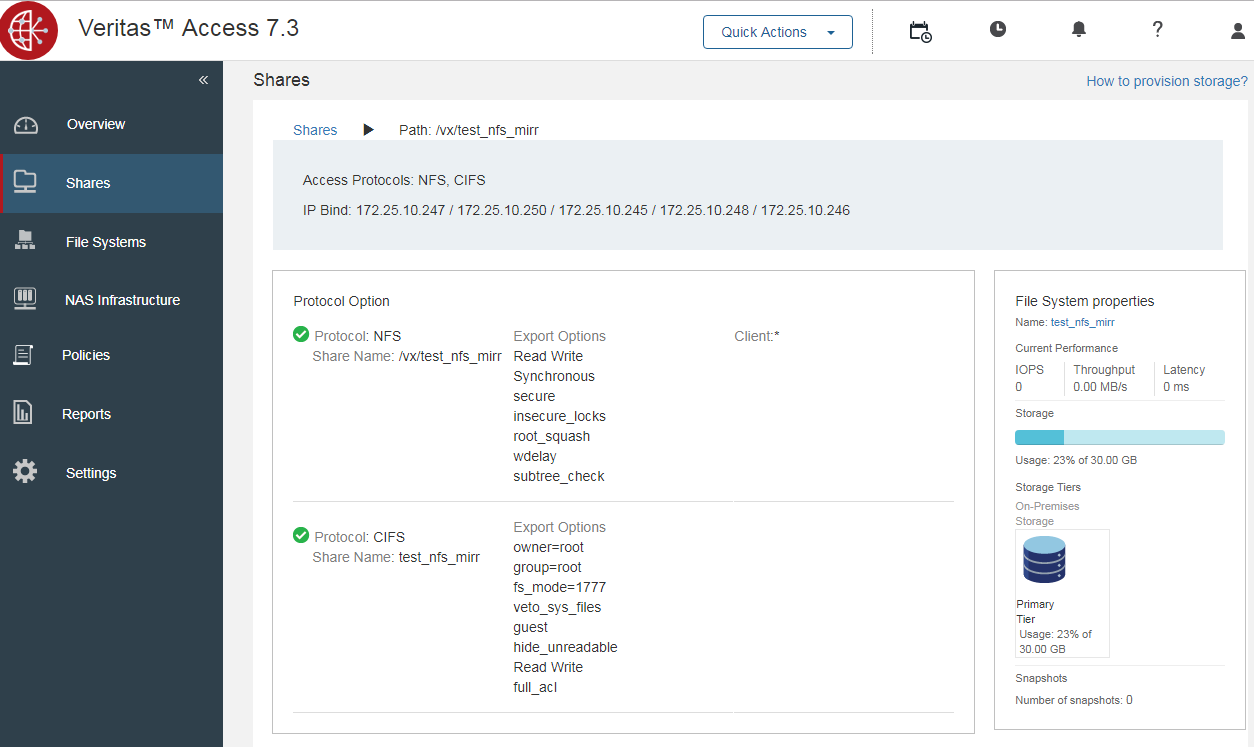

На каждом общем ресурсе отображается информация о том, на каких IP-адресах он доступен.

В любой момент времени один узел действует как главный; на скриншоте это узел va73_02. Главный узел выполняет задачи администрирования и распределения нагрузки.

Роль мастера узла может быть передана или принята на себя другим узлом в случае потери доступности или выполнения определенных условий, встроенных в логику кластера Veritas Access. При потере внутреннего межсоединения может возникнуть неприятная ситуация, при которой каждый узел становится мастером.

Надежности внутреннего межсоединения необходимо уделять особое внимание.

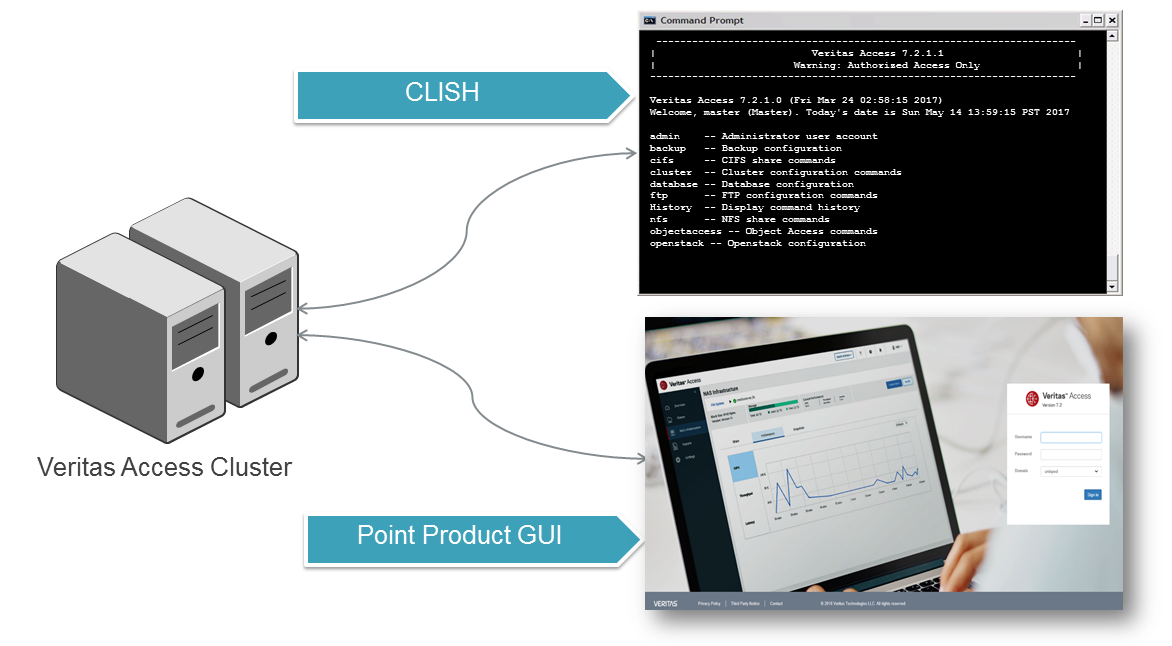

Контроль

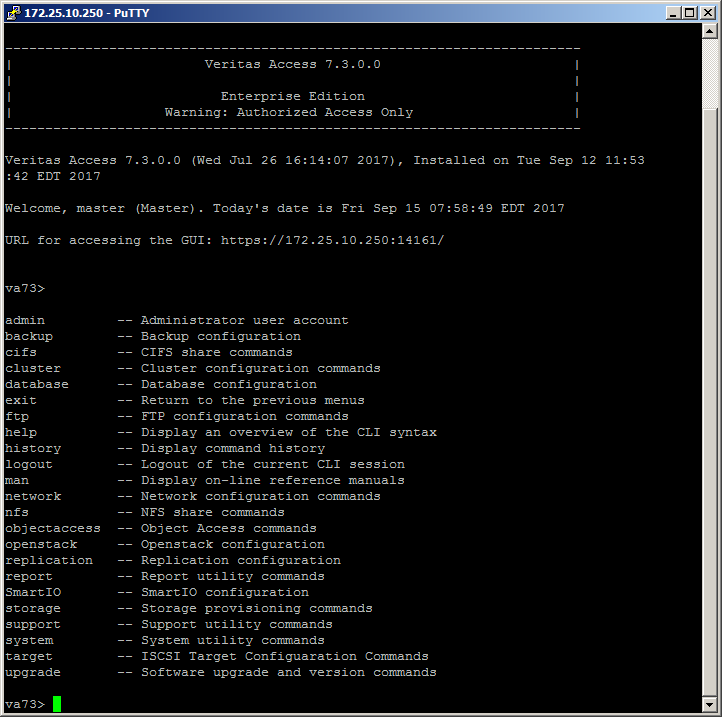

Veritas Access имеет 3 доступных интерфейса управления: CLISH в корневом и главном режиме, WEB и REST API.| мастер-режим ssh (вход в систему root, master) | сеть |

|---|---|

|

|

Он имеет интуитивно понятный, упрощенный набор команд и подробную справку.

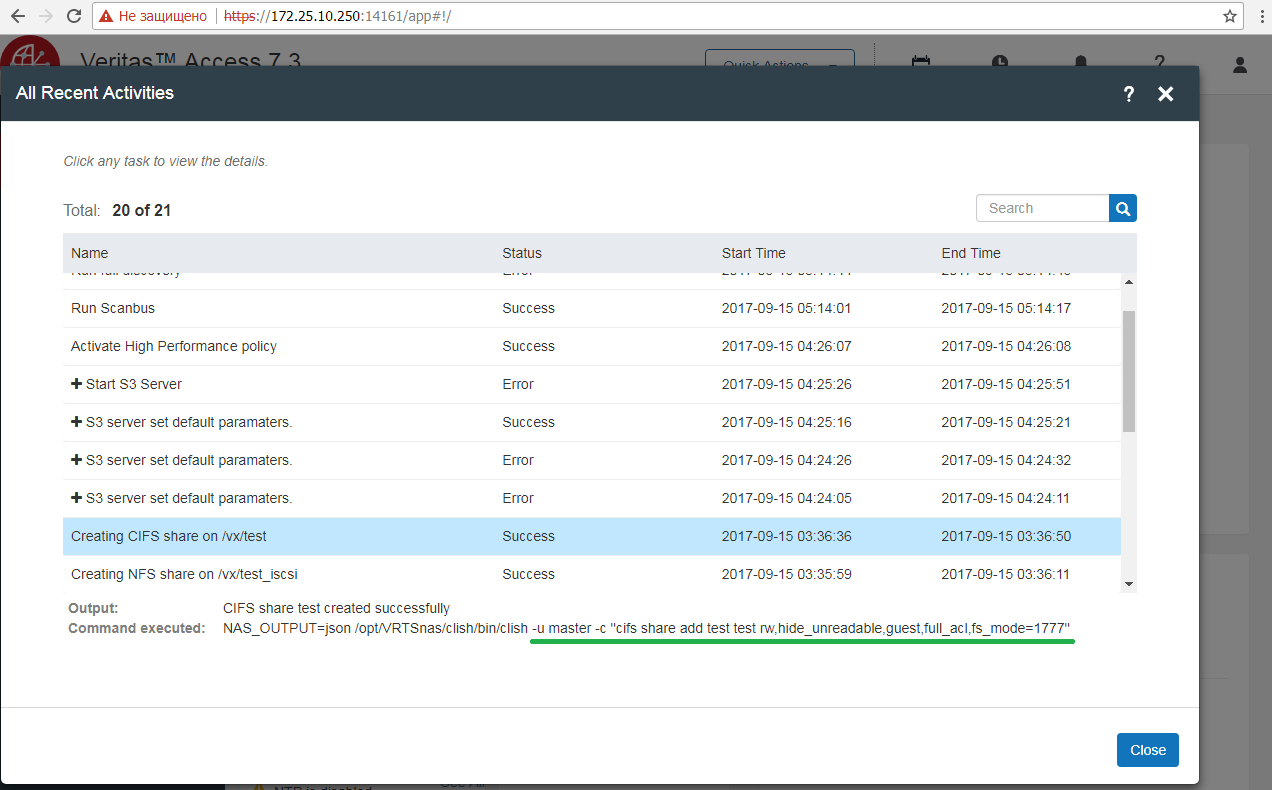

режим узла SSH Обычная консоль управления Linux, доступ осуществляется через ssh с root-логином на управляющем IP. ВЕБ Консоль управления WEB кластером, доступ осуществляется под root или master логином на IP управления по порту: 14161, протокол https. WEB-консоль интерпретирует команды в мастер-режим SSH .

С каждым выпуском происходит расширение возможностей WEB-управления.

Начальная настройка

Несколько слов о запуске Veritas Access в качестве системы хранения данных.

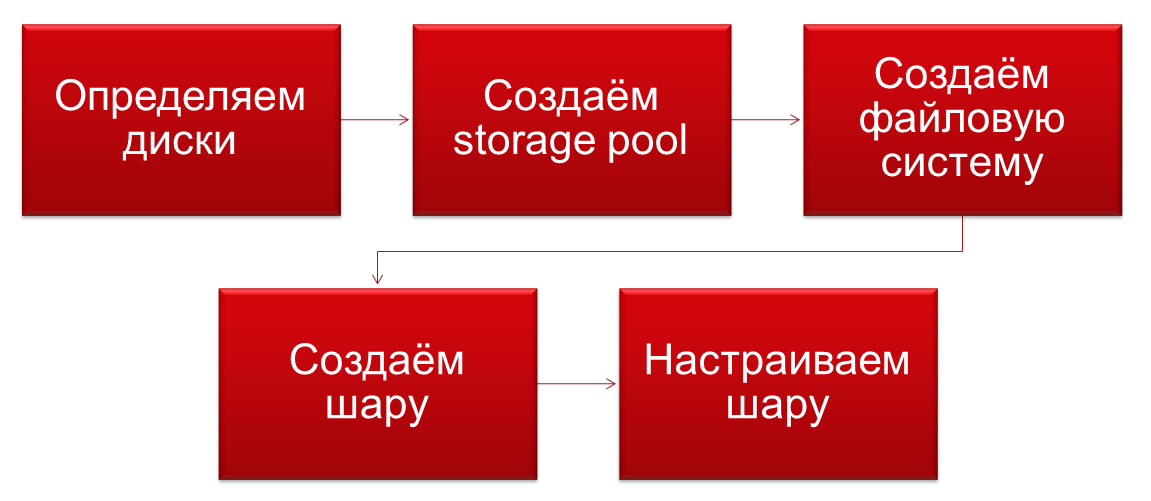

1. Объедините диски в пул носителей.

2. Создайте файловую систему с учетом типа диска, данных и необходимой защиты (аналог RAID)

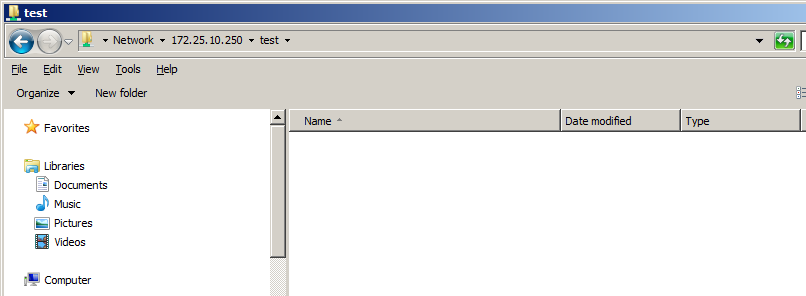

3. Расшарьте файловую систему, используя необходимые протоколы.

Одна файловая система может использоваться несколькими протоколами, и, например, к одним и тем же файлам можно обращаться как через NFS, так и через CIFS, как временно, так и постоянно.

4. Ты молодец.

Подключение по ISCSI к внешним СХД и любым другим устройствам хранения данных

Veritas Access поддерживает использование любых томов iSCSI или сторонних систем хранения данных для хранения.Диски сторонних систем хранения необходимо предоставлять отдельно в формате RAW. Если это невозможно, используется RAID 5 из 3 дисков.

Защита данных обеспечивается файловой системой Veritas Access и представлена в разделе выше.

Нет необходимости защищать данные на уровне аппаратного рейда; В настройках файловой системы Access указано количество узлов, на которых будут зеркалироваться ваши данные.

Тома, подключенные через iSCSI, можно включать в общие пулы.

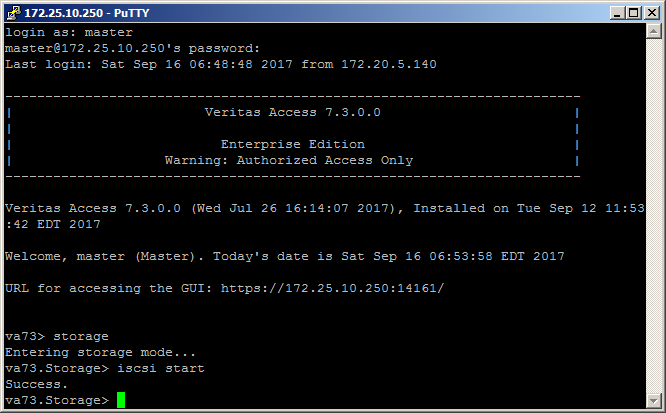

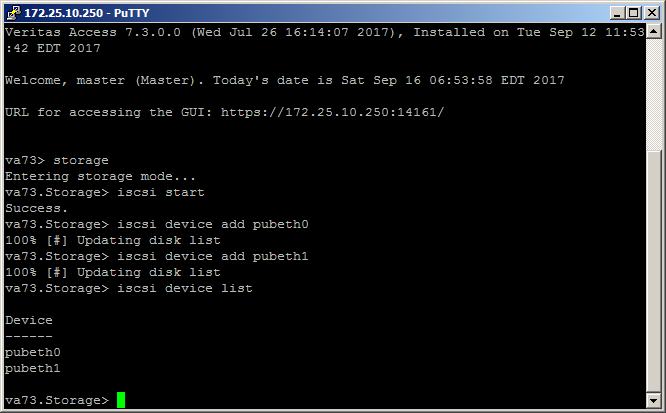

Добавление диска iSCSI выглядит следующим образом:

1. Включите iSCSI в разделе хранилища:

2. Добавьте устройство iSCSI:

3. Подключите iSCSI-диск:

В качестве тестового диска iSCSI — win2012.

Распределение томов хранения через ISCSI

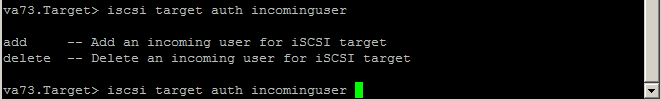

Процесс настройки в текущем релизе немного своеобразен, подробно с ним можно ознакомиться на стр.437 в Справочное руководство по командам (целевая служба iSCSI).

У многих команд в текущем релизе нет возможности просмотра настроек, т.е.

все параметры лучше заранее записать в TXT-файл.

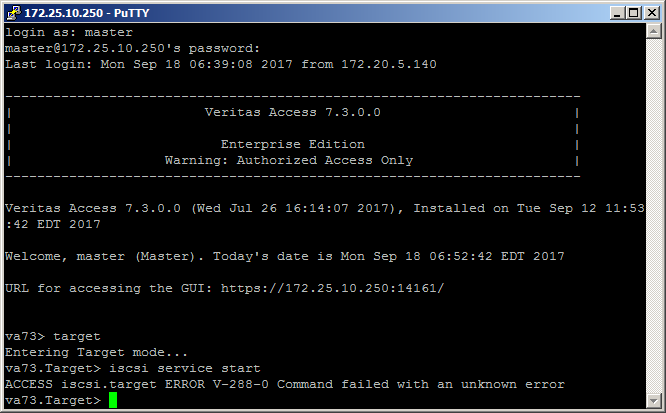

Важное замечание: в версии 7.3 есть ошибка, из-за которой не запускается служба iSCSI!

Вы можете исправить это следующим образом:

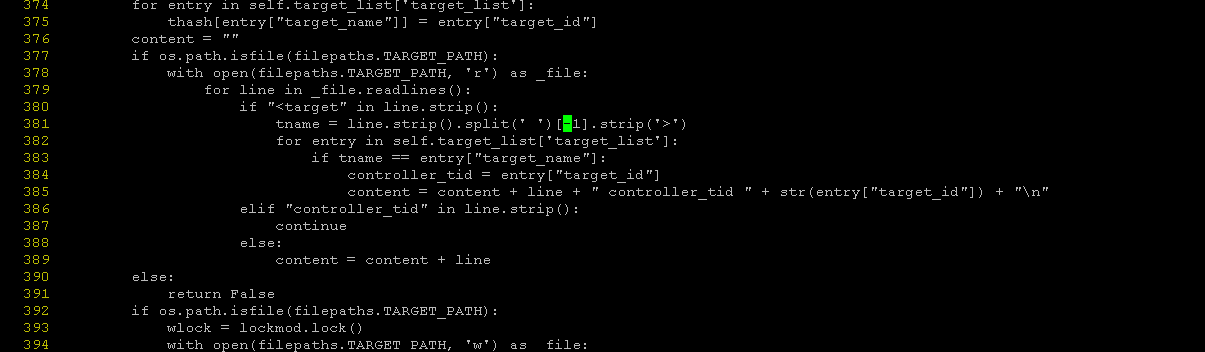

На узлах нужно исправить файл /opt/VRTSnas/pysnas/target/target_manager.py

В строке 381 измените [1] на [-1].

Процесс запуска раздачи iSCSI выглядит так: va73.Target> iscsi service start

ACCESS Target SUCCESS V-288-0 iSCSI Target service started

va73.Target> iscsi target portal add 172.25.10.247

ACCESS Target SUCCESS V-288-0 Portal add successful.

va73.Target> iscsi target create iqn.2017-09.com.veritas:target

ACCESS Target SUCCESS V-288-0 Target iqn.2017-09.com.veritas:target created successfull

va73.Target> iscsi target store add testiscsi iqn.2017-09.com.veritas:target

ACCESS Target SUCCESS V-288-0 FS testiscsi is added to iSCSI target iqn.2017-09.com.veritas:target.

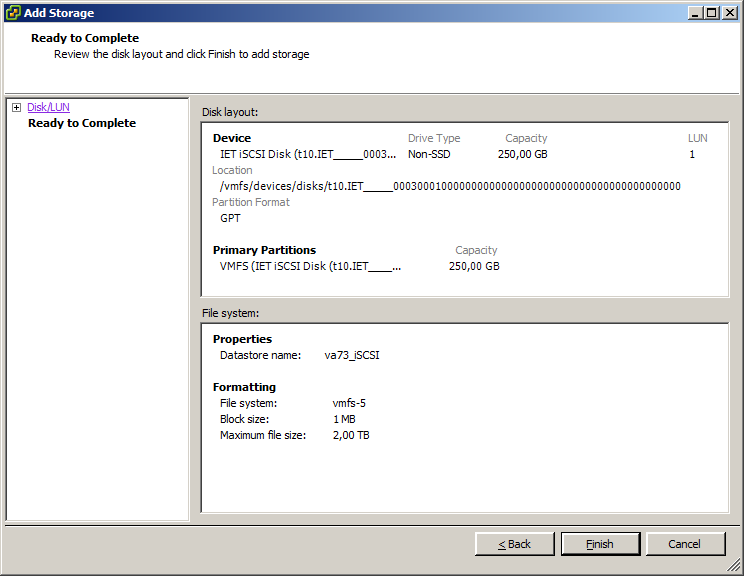

va73.Target> iscsi lun create lun3 3 iqn.2017-09.com.veritas:target 250g

ACCESS Target SUCCESS V-288-0 Lun lun3 created successfully and added to target iqn.2017-09.com.veritas:target

va73.Target> iscsi service stop

ACCESS Target SUCCESS V-288-0 iSCSI Target service stopped

va73.Target> iscsi service start

ACCESS Target SUCCESS V-288-0 iSCSI Target service started

Еще одно важное замечание: без перезапуска службы iSCSI новые настройки не будут применены!

Если что-то пойдет не так, целевые журналы iSCSI можно просмотреть по следующим путям: /opt/VRTSnas/log/iscsi.target.log

/opt/VRTSnas/log/api.log

/var/log/messages

Вот и все, собственно.

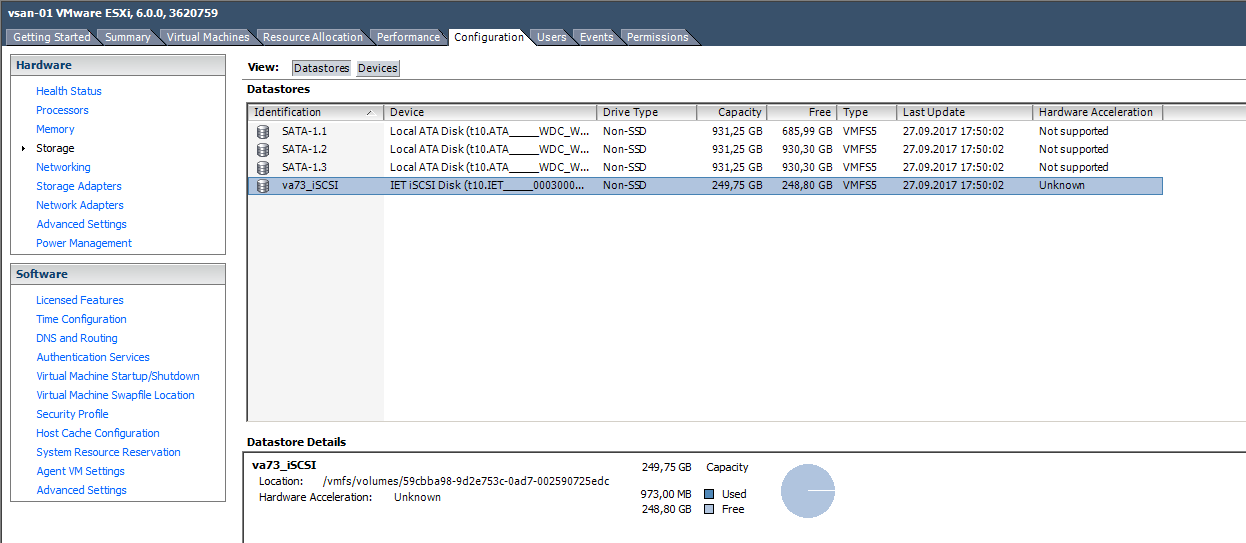

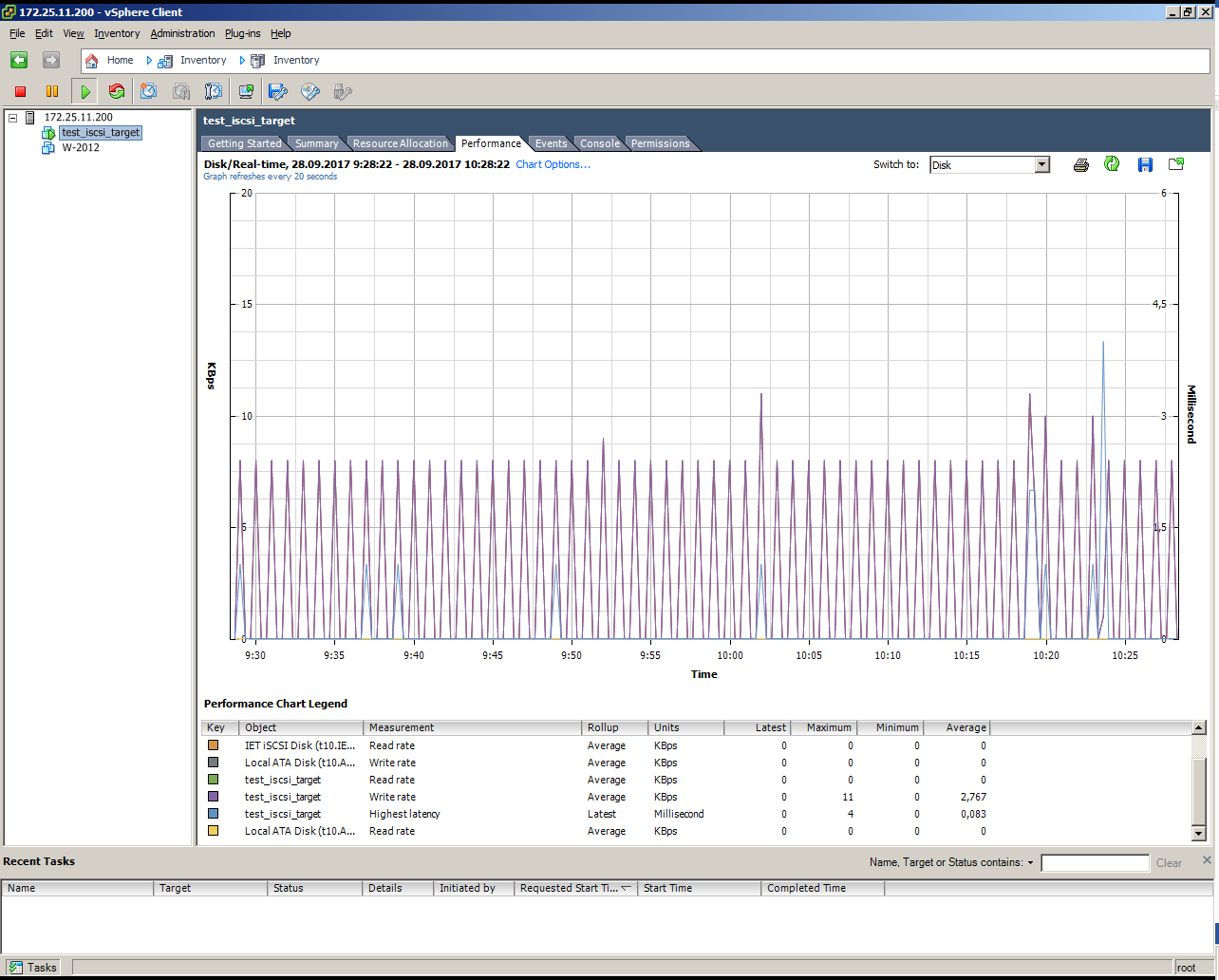

Подключаем наш том iSCSI к VMware ESXi.

Устанавливаем виртуальную машину на том iSCSI, работающий без нагрузки:

Теги: #Хранение данных #ИТ-инфраструктура #Системное администрирование #Хранилище данных #s3 #aws #программно-определяемое хранилище #sds #Veritas #Veritas Access #InfoScale #Storage Foundation

-

Вы Не Можете Просто Пойти И Найти Работу.

19 Oct, 24 -

Crossover Бесплатно В Течение Года!

19 Oct, 24 -

Воин Кастанеды В Управлении Рисками

19 Oct, 24 -

Webp — Новый Формат Изображений В Интернете

19 Oct, 24 -

Индуистский Подход

19 Oct, 24