Всем привет! Представляю вашему вниманию новую версию программы СайтАнализатор , предназначенный для технического аудита и SEO-анализа веб-сайтов (бесплатный аналог Screaming Frog SEO Spider).

В новой версии SiteAnalyzer 2.2 мы постарались добавить несколько давно назревших функций, а также оптимизировать и сделать удобнее некоторые существующие инструменты.

Ниже мы расскажем обо всем подробнее.

Большие перемены

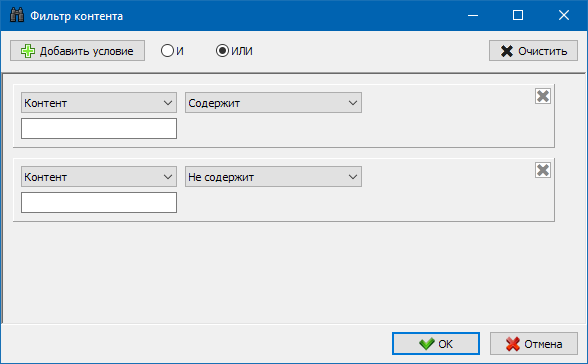

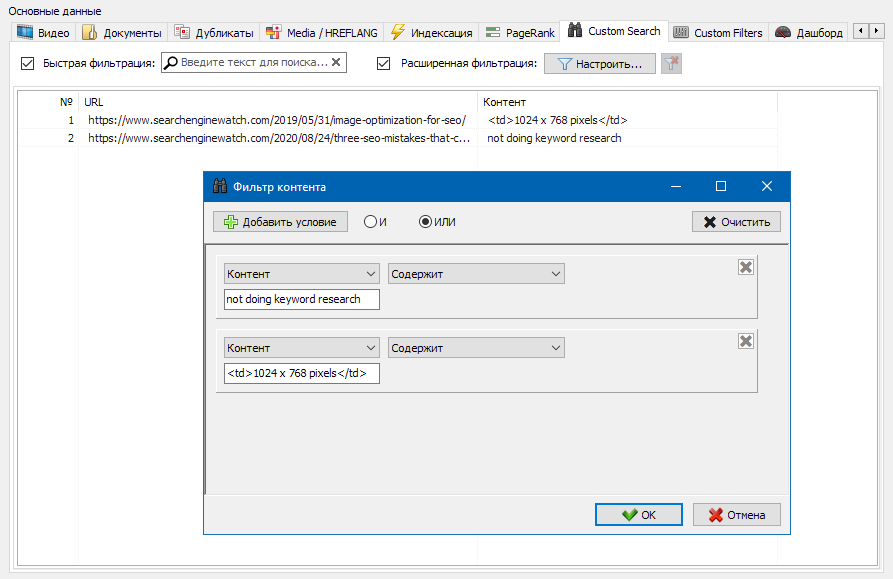

1).Добавлен модуль настраиваемых фильтров для поиска контента на страницах сайта во время сканирования.

По многочисленным просьбам мы добавили долгожданную функцию поиска по контенту сайта, которая позволяет осуществлять поиск по исходному коду и отображать веб-страницы, содержащие искомый вами контент. Модуль настраиваемых фильтров позволяет проверить наличие на сайте микроразметки, метатегов, систем аналитики, фрагментов произвольного текста или HTML-кода.

В окне настройки фильтра имеется несколько параметров для поиска определенных фрагментов текста на страницах сайта или, наоборот, исключения из результатов поиска страниц, содержащих определенный текст или фрагменты HTML-кода (эта функция аналогична поиску контента в исходном коде).

страницы с помощью Ctrl-F).

Примечание.

Чтобы ознакомиться с тем, как работает модуль пользовательского фильтра, вы можете выбрать «Не содержит» в раскрывающемся списке фильтра, а затем ввести название своего бренда в поле ввода текста.

В результате после сканирования сайта вы можете получить список страниц, не содержащих название вашего бренда, и проанализировать, по каким причинам эти страницы содержат шаблон, отличный от основного сайта.

2).

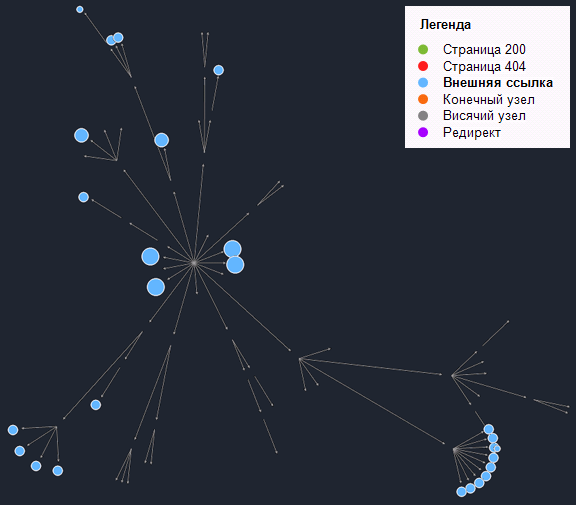

Добавлен график распределения внутренних ссылок по страницам сайта.

На этом графике показано распределение внутренней ссылочной массы по страницам сайта (можно сказать, что это визуализация ссылочной массы в более наглядном виде, чем она представлена в Графике Визуализации).

Слева отображается количество страниц, справа — количество ссылок.

Ниже приведены процентные квантили по страницам.

При построении графика дублирующиеся ссылки отбрасываются (если со страницы А на страницу Б 3 ссылки, то мы считаем их за одну).

Например, исходя из скриншота выше, для сайта около 70 страниц:

- 1% страниц имеют ~68 входящих ссылок.

- 10% страниц имеют ~66 входящих ссылок.

- 20% страниц имеют ~15 входящих ссылок.

- 30% страниц имеют ~8 входящих ссылок.

- 40% страниц имеют ~7 входящих ссылок.

- 50% страниц имеют ~6 входящих ссылок.

- 60% страниц имеют ~5 входящих ссылок.

- 70% страниц имеют ~5 входящих ссылок.

- 80% страниц имеют ~3 входящие ссылки.

- 90% страниц имеют ~2 входящие ссылки.

Исходя из этого, мы можем либо поставить больше внутренних ссылок на эти слабосвязанные страницы (если страницы важны для продвижения), либо оставить их как есть, если такие страницы маловажны и имеют низкий приоритет. Как правило, страницы с количеством внутренних ссылок менее 10 хуже сканируются поисковыми роботами, в частности ботами Google. Поэтому, если вы видите сайт, на котором нормально ссылаются только 20-30% страниц от общего количества страниц сайта, то имеет смысл углубиться в настройку перелинковки или подумать, что делать с этими 80. -70% слабо связанных страниц (удалить, скрыть от индексации, установить редиректы).

Пример сайта со слабой ссылкой:

Пример сайта с хорошими ссылками:

Более подробное описание того, как работает график распределения внутренних ссылок, можно найти в разделе «Документация».

3).

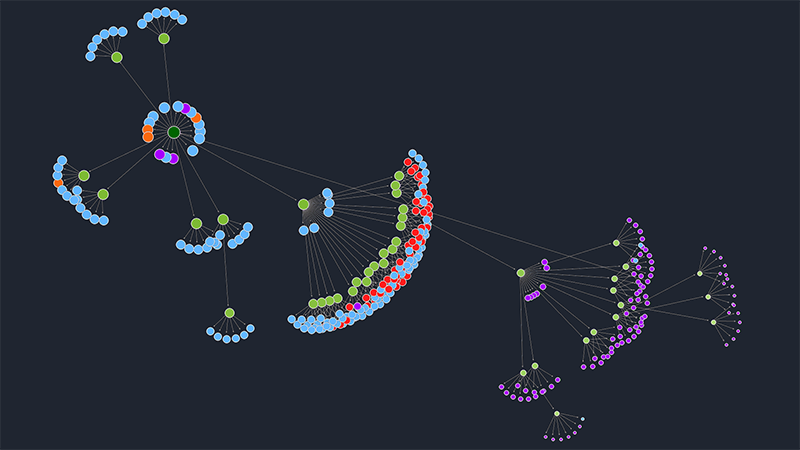

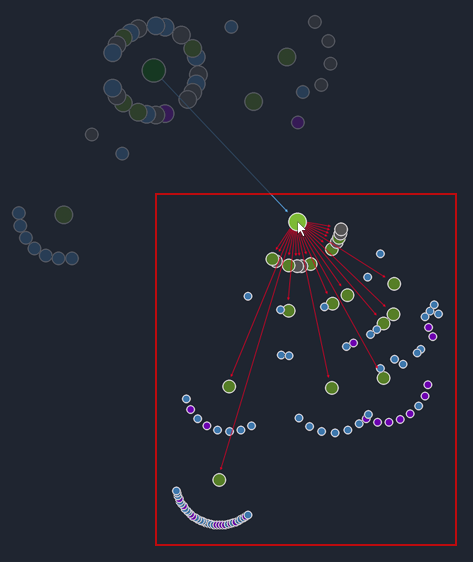

Оптимизирована работа с графом визуализации.

- Добавлен пропорциональный перенос дочерних элементов при перетаскивании узлов графа.

- При выборе узла на графике входящие и исходящие ссылки стали окрашиваться в разные цвета для большей наглядности.

- В блок легенды графика визуализации добавлена интерактивность: при нажатии на элементы легенды на графике подсвечиваются соответствующие узлы.

4).

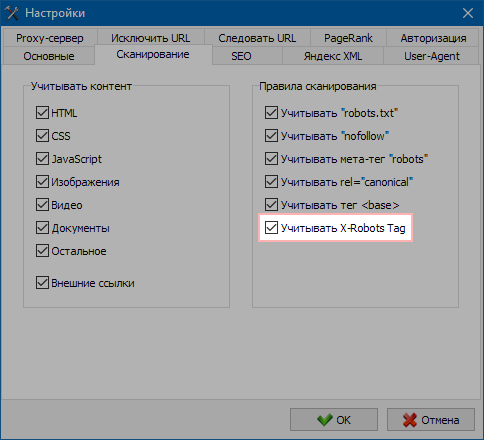

Добавлен учет заголовка «X-Robots Tag» при сканировании сайтов.

В настройках программы при сканировании сайта появилась возможность отключить или включить включение параметра «Тег X-Robots», поскольку раньше он отображался только в статистике.

Примечание.

Заголовок X-Robots-Tag включается в ответ HTTP для определенного URL-адреса.

Заголовки X-Robots-Tag поддерживают те же директивы, что и метатеги роботов.

Любую директиву, которую можно использовать в метатеге robots, можно указать в X-Robots-Tag.

Другие изменения

- Оптимизирован анализ заголовков H1-H6 с использованием классов.

- Исправлено зависание программы в конце сканирования на больших проектах.

- Исправлено некорректное отображение статистики в разделе Описание дубликатов.

- Исправлено некорректное отображение статистики для страниц с кодом ответа 404.

- Для страниц, заблокированных в Robots.txt, теперь возвращается код ответа 600.

- Параметр «Время отклика» теперь рассчитывается более корректно.

- Исправлен не всегда корректный макет карты сайта Sitemap.xml.

- Редиректы теперь отображаются корректнее.

- Сортировка по URL стала более логичной.

Буду рад любым комментариям и предложениям по улучшению функционала программы.

Теги: #аудит сайта #seo продвижение #SEO аудит #разработка веб-сайта #поисковая оптимизация

-

У Кого-Нибудь Что-Нибудь Работает?

19 Oct, 24 -

Phdays Iii Ctf: Взгляд Изнутри (Часть 1)

19 Oct, 24