В статье описан процесс оптимизации складской инфраструктуры компании среднего уровня.

Рассмотрено обоснование такого перехода и краткое описание процесса настройки новой системы хранения данных.

Приведем пример плюсов и минусов перехода на выбранную систему.

Введение

Инфраструктура одного из наших клиентов состояла из множества разнородных систем хранения данных разного уровня: от систем SOHO QNAP, Synology для пользовательских данных до СХД Entry и Mid-range уровня Eternus DX90 и DX600 для iSCSI и FC для служебных данных и системы виртуализации.Все это различалось как по поколениям, так и по используемым дискам; Некоторые из систем представляли собой устаревшее оборудование, не имевшее поддержки со стороны поставщиков.

Отдельной проблемой было управление свободным пространством, поскольку все доступное дисковое пространство было сильно фрагментировано по нескольким системам.

В результате администрирование неудобно, а стоимость содержания парка систем высока.

Перед нами стояла задача оптимизировать инфраструктуру хранения данных с целью снижения стоимости владения и унификации.

Задача была всесторонне проанализирована специалистами нашей компании с учетом требований заказчика по доступности данных, IOPS, RPO/RTO, а также возможности модернизации существующей инфраструктуры.

Выполнение

Основными игроками на рынке систем хранения данных среднего (и выше) уровня являются IBM со своим продуктом Storwize; Fujitsu, представленная линейкой Eternus, и NetApp с серией FAS. В качестве СХД, соответствующей заданным требованиям, рассматривались данные системы, а именно: IBM Storwize V7000U, Fujitsu Eternus DX100, NetApp FAS2620. Все три являются унифицированными системами хранения, то есть обеспечивают как блочный, так и файловый доступ, а также предоставляют схожие показатели производительности.Но в случае со Storwize V7000U доступ к файлам организован через отдельный контроллер — файловый модуль, подключенный к контроллеру основного блока, что является дополнительной точкой отказа.

Кроме того, эта система относительно сложна в управлении и не обеспечивает адекватной изоляции сервисов.

Система хранения данных Eternus DX100, также являющаяся унифицированной системой хранения данных, имеет серьезные ограничения на количество создаваемых файловых систем, не обеспечивая необходимой изоляции.

Кроме того, процесс создания новой файловой системы занимает много времени (до получаса).

Обе описанные системы не позволяют разделить используемые CIFS/NFS-серверы на сетевом уровне.

С учетом всех параметров, в том числе совокупной стоимости владения системой, был выбран NetApp FAS2620, состоящий из пары контроллеров, работающих в режиме Active-Active и позволяющих распределять нагрузку между контроллерами.

А в сочетании со встроенными механизмами онлайн-дедупликации и сжатия позволяет существенно экономить место, занимаемое данными на дисках.

Эти механизмы становятся существенно более эффективными при агрегации данных в одной системе по сравнению с исходной ситуацией, когда потенциально идентичные данные располагались на разных системах хранения и дедуплицировать их между собой было невозможно.

Эта система позволила разместить под контролем единого отказоустойчивого кластера все виды сервисов: SAN в виде блочных устройств для виртуализации и NAS в виде CIFS, общие ресурсы NFS для пользовательских данных Windows и *nix-системы.

При этом сохраняется возможность безопасного логического разделения этих сервисов благодаря технологии SVM (Storage Virtual Machine): сервисы, отвечающие за разные компоненты, не влияют на своих «соседей» и не разрешают к ним доступ.

Также остаётся возможность изолировать сервисы на уровне дисков, предотвращая деградацию производительности при большой нагрузке от «соседей».

Для сервисов, которым требуется быстрое чтение/запись, вы можете использовать RAID-массив гибридного типа, добавив несколько твердотельных накопителей к блоку жестких дисков.

Система сама будет размещать на них «горячие» данные, сокращая задержки при чтении часто используемых данных.

Это помимо кэша NVRAM, который помимо высокой скорости записи обеспечивает его атомарность и целостность (данные будут храниться в NVRAM, питаемом от батареи, до тех пор, пока не будет получено подтверждение их полной записи от файловой системы) в случае внезапного отключения электроэнергии.

После миграции данных в новую систему хранения появляется возможность более эффективно использовать пространство кеширующих дисков.

Положительные стороны

Как уже говорилось выше, использование данной системы позволило решить сразу две задачи: — Объединение- Один кластер в одном шасси, состоящий из двух контроллеров, позволяющий решить весь спектр задач, стоящих перед компанией.

- Единая точка контроля всех сервисов хранения данных.

Вам больше не нужно искать, к какой системе хранения был назначен LUN, куда какие данные можно перенести в случае нехватки места и так далее.

- Единая точка обслуживания.

Теперь используются однотипные диски, вставленные в общую дисковую полку.

Система монтируется в одну стойку, что позволяет сократить необходимое количество кабелей и коммутаторов Ethernet и Fibre Channel.

- Поскольку новый кластер имеет доступ ко всем хранимым данным, появляется возможность эффективно сжимать данные путем поиска внутри него идентичных блоков.

Наиболее эффективно это работает для виртуальных машин и резервных копий.

- Технология SVM (Storage Virtual Machine), используемая в NetApp, как упоминалось выше, позволяет дифференцировать сервисы, сохраняя при этом преимущества унификации.

Теперь для каждой задачи можно создать отдельную SVM, которая будет решать свою задачу.

Предоставляйте данные по одному протоколу только строго указанным пользователям/сервисам.

- Изоляция на уровне сети.

Каждая SVM использует собственный виртуальный сетевой интерфейс, который использует строго определенную группу физических портов или VLAN-интерфейсов.

Таким образом, даже если трафик от разных SVM проходит через один и тот же физический порт, этот трафик находится в разных VLAN. То есть сетевой порт СХД является магистральным портом.

Группы портов выделяются для трафика iSCSI, чтобы отделить высокие нагрузки сети SAN от пользовательского трафика до такой степени, что отдельным системам можно зарезервировать отдельный физический порт, не «разделяя» его ни с кем.

- Изоляция на уровне дисковой подсистемы.

В типовой реализации создается минимально возможное количество RAID-групп (максимальное количество дисков в одной RAID-группе увеличивает производительность массива), на которых затем создаются отдельные файловые системы в виде Volume. Том назначается SVM, что гарантирует невозможность доступа к данным между SVM в случае компрометации.

И если «объем» заполнится одним сервисом, «объемы» других SVM не пострадают. В некоторых случаях в соответствии с требованиями безопасности для особо критичных данных создаются выделенные RAID-группы, чтобы гарантировать изоляцию данных даже на физическом уровне.

- По мере роста объема данных без сложных манипуляций добавляется необходимое количество дисковых полок без остановки сервиса.

Новые диски сразу же доступны обоим контроллерам для расширения существующих RAID-групп или создания новых.

- Увеличение количества сервисов может привести к нехватке вычислительных ресурсов системы (ЦП, ОЗУ).

В этом случае вы можете добавить в существующий кластер еще один узел хранения, включив его в существующий кластер, расширив в нем количество интерфейсов ввода-вывода, объем памяти и отказоустойчивость.

- NetApp поддерживает S3-совместимое объектное хранилище как в виде сторонних сервисов, так и путем предоставления своих продуктов для создания локальных объектных хранилищ для хранения холодных данных и архивов.

Отрицательные стороны

— Подведя все сервисы под контроль одной системы, мы ожидаемо получаем больший эффект от отключения одного компонента (1 из 2 контроллеров против 1 из 10+ в старой инфраструктуре).— Распределенность складской инфраструктуры снизилась.

Если раньше системы хранения могли располагаться на разных этажах/в разных зданиях, то теперь все сосредоточено в одном стеллаже.

Этот момент можно компенсировать покупкой менее производительной системы и использованием синхронной/асинхронной репликации на случай форс-мажорных ситуаций.

Пошаговая настройка

Ввиду конфиденциальности информации скриншоты из реальной среды заказчика не могут быть продемонстрированы, поэтому этапы настройки представлены в тестовой среде и полностью повторяют шаги, выполненные в производственной среде заказчика.

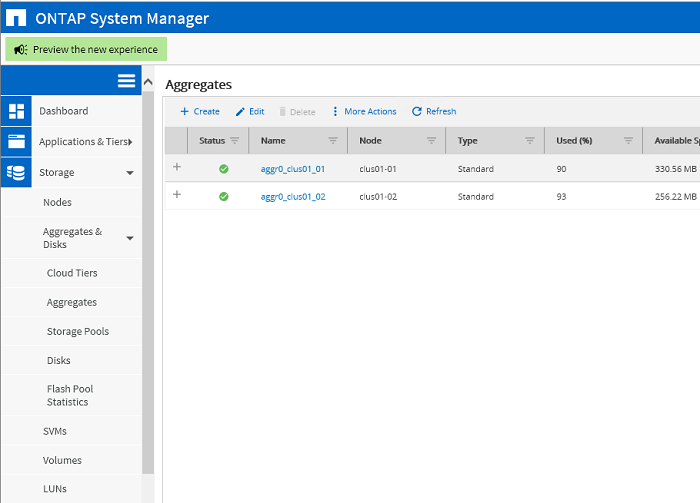

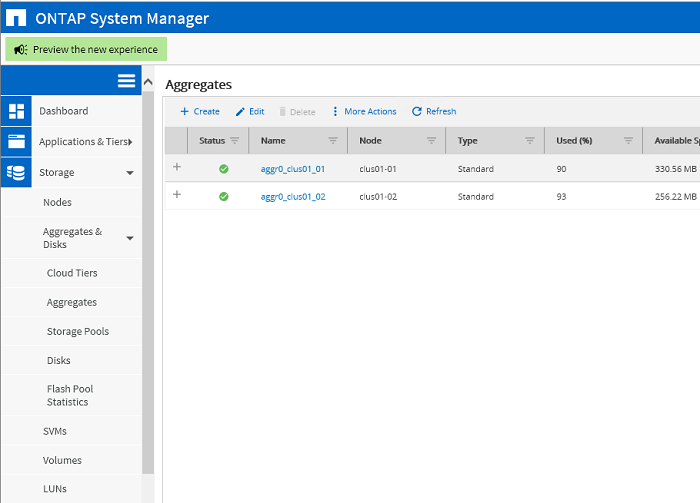

Исходное состояние кластера.

Два блока для корневых разделов соответствующих узлов кластера clus01_01, clus01_02

Создание агрегатов для данных.

Для каждого узла создан свой блок, состоящий из одного массива RAID-DP.

Результат: созданы два агрегата: rg0_node02, rg1_node01. Данных о них пока нет.

Создание SVM в качестве CIFS-сервера.

Для SVM необходимо создать корневой том, для которого выбран корневой агрегат — rg1_node01. В этом томе будут храниться отдельные настройки SVM.

Настройте протокол CIFS для этой SVM. Здесь вы задаете IP-адрес сервера и физический интерфейс, через который должен проходить трафик сервера.

В качестве порта можно выбрать порт VLAN или объединенный порт LACP. На этом же этапе создается том для хранения данных и общая папка, которая будет доступна пользователям по сети.

После добавления пользовательских данных в общую папку механизмы автоматического сжатия и дедупликации демонстрируют следующую эффективность.

Реально занятое место на сервере оказалось в 4,9 раза меньше общего размера файла.

Фактический коэффициент сжатия зависит от типа записываемых данных.

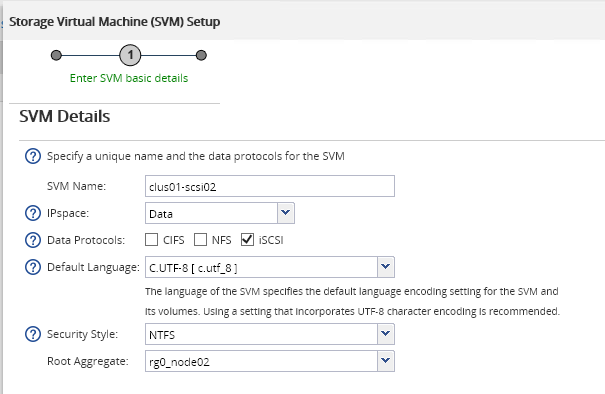

Создание SVM в качестве цели iSCSI. Аналогично выбирается единица, на которой будет располагаться Корневой Том этого сервера.

На втором шаге данного Мастера по аналогии с CIFS-сервером указывается IP-адрес виртуального интерфейса iSCSI-сервера, физический порт для него, а также блочное устройство (LUN), которое будет представлено инициатору.

указано.

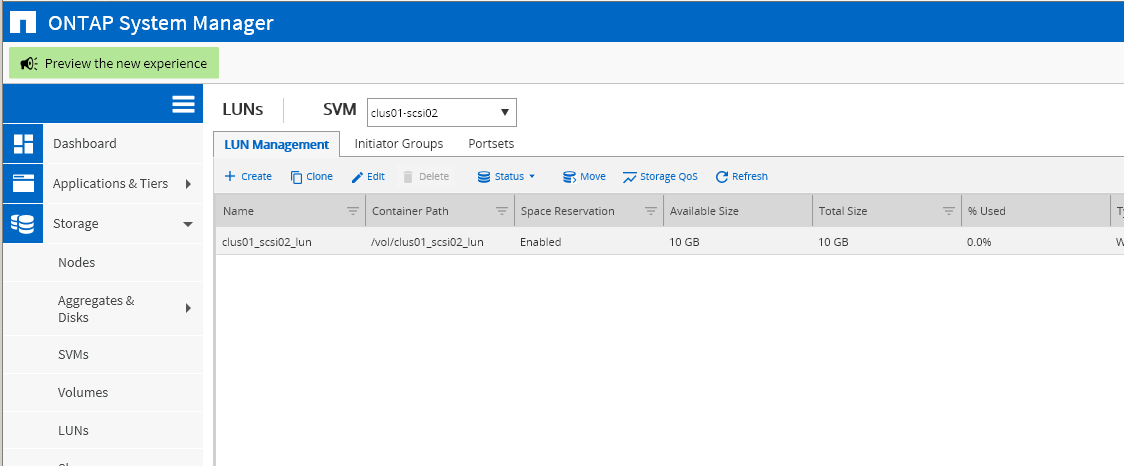

Готовый LUN размером 10 ГБ.

Ему должна быть предоставлена группа инициаторов, которым он должен быть доступен.

Группа инициаторов состоит из одного сервера Hyper-V с указанным ниже iqn.

Файл жесткого диска для виртуальной машины Linux был создан в LUN, подключенном к серверу Hyper-V. После проведения штатной оптимизации данные внутри Тома, расположенного в СХД, были сжаты более чем наполовину.

Если бы в данном LUN было больше виртуальных машин одного типа, экономия была бы еще выше.

Теги: #Оптимизация серверов #инфраструктура #ит-инфраструктура #Хранение данных #ИТ-компании #ИТ-компании #оптимизация #системы хранения данных #настройка системы

-

Создание Приложения На Gtk

19 Oct, 24 -

Дайджест It-Событий За Июль

19 Oct, 24 -

Сохранение Документов Excel В Pdf На Сервере

19 Oct, 24