Всем привет! Меня зовут Влад, и я работаю data science в команде Тинькофф по речевым технологиям, которые используются в нашем голосовом помощнике Олега.

В этой статье я хотел бы сделать краткий обзор технологий синтеза речи, используемых в отрасли, и поделиться опытом нашей команды по созданию собственного движка синтеза.

Синтез речи

Синтез речи – это создание звука из текста.Эта проблема сегодня решается двумя подходами:

- Выбор единицы измерения [1] или конкатенативный подход. Он основан на сшивании фрагментов записанного звука.

С конца 90-х годов он долгое время считался стандартом де-факто для разработки движков синтеза речи.

Например, голос, использующий метод выбора единиц измерения, можно найти в Siri [2].

- Параметрический синтез речи [3], суть которого заключается в построении вероятностной модели, прогнозирующей акустические свойства звукового сигнала для заданного текста.

В то же время параметрические модели требуют гораздо меньше данных для обучения, они генерируют более разнообразные интонации, но до недавнего времени страдали от общего довольно низкого качества звука по сравнению с подходом с выбором единиц измерения.

Однако с развитием технологий глубокого обучения модели параметрического синтеза достигли значительных успехов по всем показателям качества и способны создавать речь, практически неотличимую от человеческой речи.

Метрики качества

Прежде чем говорить о том, какие модели синтеза речи лучше, нам необходимо определить метрики качества, по которым будут сравниваться алгоритмы.Поскольку один и тот же текст можно прочитать бесконечным количеством способов, априори правильного способа произнесения той или иной фразы не существует. Поэтому показатели качества синтеза речи зачастую субъективны и зависят от восприятия слушателя.

Стандартной метрикой является MOS (средний балл мнения), средняя оценка естественности речи, выдаваемая оценщиками синтезированного звука по шкале от 1 до 5. Единица означает, что она звучит совершенно неправдоподобно, а пять означает речь, неотличимую от человеческой речи.

.

Реальные записи человека обычно получают значения около 4,5, а значение больше 4 считается довольно высоким.

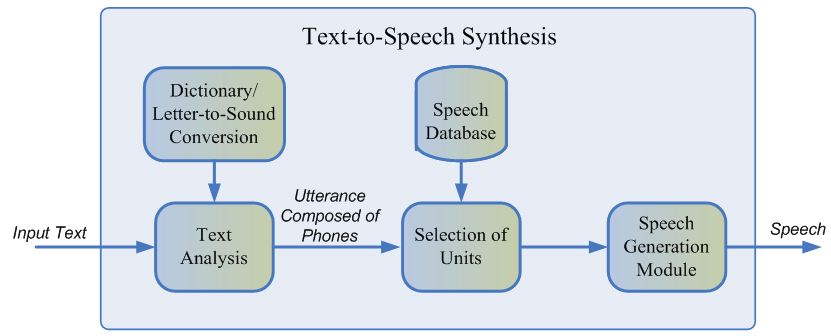

Как работает синтез речи

Первым шагом к созданию любой системы синтеза речи является сбор обучающих данных.Обычно это качественные аудиозаписи, на которых диктор зачитывает специально подобранные фразы.

Приблизительный размер набора данных, необходимый для обучения моделей выбора единиц, составляет 10–20 часов чистой речи [2], тогда как для параметрических методов нейронных сетей верхняя оценка составляет примерно 25 часов [4, 5].

Обсудим обе технологии синтеза.

Выбор единицы измерения

Обычно записанная речь говорящего не может охватить все возможные случаи, в которых будет использоваться синтез.

Поэтому суть метода состоит в том, чтобы разбить всю аудиобазу на небольшие фрагменты, называемые единицами, которые затем склеиваются с помощью минимальной постобработки.

Единицами обычно являются минимальные акустические единицы языка, такие как полуфоны или дифоны [2].

Весь процесс генерации состоит из двух этапов: фронтенда НЛП, отвечающего за извлечение лингвистического представления текста, и бэкенда, вычисляющего функцию единичного штрафа для заданных лингвистических особенностей.

Интерфейс НЛП включает в себя:

- Задача нормализации текста — перевести все небуквенные символы (цифры, знаки процентов, валюты и т. д.) в их вербальное представление.

Например, «5%» следует перевести как «пять процентов».

- Извлечение лингвистических признаков из нормализованного текста: фонематического представления, ударения, частей речи и т. д.

Штраф, налагаемый серверной подсистемой, представляет собой сумму целевой стоимости, или соответствия акустического представления единицы конкретной фонеме, и стоимости конкатенации, то есть целесообразности соединения двух соседних единиц.

Для оценки штрафных функций можно использовать правила или уже обученную модель акустического параметрического синтеза [2].

Выбор наиболее оптимальной последовательности единиц с точки зрения определенных выше штрафов осуществляется с помощью алгоритма Витерби [1].

Ориентировочные значения MOS моделей выбора единиц для английского языка: 3,7—4,1 [2, 4, 5].

Преимущества подхода к выбору агрегатов:

- Натуральный звук.

- Высокая скорость генерации.

- Небольшой размер моделей позволяет использовать синтез непосредственно на мобильном устройстве.

- Синтезированная речь монотонна и не содержит эмоций.

- Характерные артефакты склейки.

- Требуется достаточно большая база данных обучающих аудио, чтобы охватить все возможные контексты.

- В принципе, он не может генерировать звуки, которых нет в обучающем наборе.

Параметрический синтез речи

Параметрический подход основан на идее построения вероятностной модели, оценивающей распределение акустических особенностей заданного текста.Процесс генерации речи при параметрическом синтезе можно разделить на четыре этапа:

- Интерфейс НЛП — это тот же этап предварительной обработки данных, что и в подходе выбора единиц, результатом которого является большое количество контекстно-зависимых лингвистических особенностей.

- Модель длительности, прогнозирующая длительность фонем.

- Акустическая модель, реконструирующая распределение акустических характеристик по лингвистическим.

Акустические характеристики включают значения основных частот, спектральное представление сигнала и т. д.

- Вокодер, преобразующий акустические характеристики в звуковую волну.

Традиционный вокодер представляет собой алгоритм, основанный на модели исходного фильтра [3], который предполагает, что речь является результатом применения линейного фильтра шума к исходному сигналу.

Общее качество речи классических параметрических методов оказывается достаточно низким из-за большого количества независимых предположений о структуре процесса генерации звука.

Однако с появлением технологий глубокого обучения стало возможным обучать сквозные модели, которые напрямую предсказывают акустические характеристики по буквам.

Например, нейронные сети Tacotron [4] и Tacotron 2 [5] принимают на вход последовательность букв и возвращают меловую спектрограмму с помощью алгоритма seq2seq [8].

Таким образом, шаги 1–3 классического подхода заменяются одной нейронной сетью.

На схеме ниже показана архитектура сети Tacotron 2, позволяющая добиться достаточно высокого качества звука.

Еще одним фактором существенного повышения качества синтезированной речи стало использование нейросетевых вокодеров вместо алгоритмов цифровой обработки сигналов.

Первым таким вокодером стала нейросеть WaveNet [9], которая последовательно, шаг за шагом, предсказывала значения амплитуды звуковой волны.

Используя большое количество сверточных слоев пропуска для захвата большего количества контекста и пропуска соединений в сетевой архитектуре, удалось добиться улучшения MOS примерно на 10% по сравнению с моделями выбора модулей.

На схеме ниже показана архитектура сети WaveNet.

Основным недостатком WaveNet является низкая скорость работы, связанная с последовательной схемой дискретизации сигнала.

Эту проблему можно решить либо инженерной оптимизацией под конкретную аппаратную архитектуру, либо заменой схемы дискретизации на более быструю.

Оба подхода успешно реализованы в отрасли.

Первый есть в Тинькофф.

ру, а в рамках второго подхода компания Google в 2017 году представила сеть Parallel WaveNet [10], разработки которой используются в Google Assistant. Ориентировочные значения MOS для нейросетевых методов: 4,4—4,5 [5, 11], то есть синтезированная речь практически не отличается от человеческой речи.

Преимущества параметрического синтеза:

- Естественный и плавный звук с использованием комплексного подхода.

- Большее разнообразие интонаций.

- Использует меньше данных по сравнению с моделями выбора единиц измерения.

- Низкая скорость работы по сравнению с выбором агрегата.

- Высокая вычислительная сложность.

Как работает синтез речи в Тинькофф

Как следует из обзора, методы параметрического синтеза речи на основе нейронных сетей в настоящее время значительно превосходят по качеству подход с подбором единиц и гораздо проще в разработке.Поэтому мы использовали их для создания собственного механизма синтеза.

Для обучения моделей было использовано около 25 часов чистой речи профессионального диктора.

Тексты для чтения были специально подобраны так, чтобы наилучшим образом охватить фонетику разговорной речи.

Кроме того, чтобы внести в синтез больше интонационного разнообразия, мы просили говорящего читать тексты с выражениями, зависящими от контекста.

Концептуально архитектура нашего решения выглядит так:

- Интерфейс НЛП, включающий нормализацию текста нейронной сети и модель размещения пауз и стрессов.

- Tacotron 2, который принимает буквы в качестве входных данных.

- Авторегрессия WaveNet, работающая в реальном времени на процессоре.

Вы можете прослушать примеры синтезированного звука, перейдя по ссылке связь .

Ссылки:

[1] А.Дж.

Хант, А.

В.

Блэк.

Выбор единиц измерения в системе конкатенативного синтеза речи с использованием большой базы данных речи, ICASSP, 1996. [2] Т.

Кейпс, П.

Коулз, А.

Конки, Л.

Голипур, А.

Хаджитархани, К.

Ху, Н.

Хаддлстон, М.

Хант, Дж.

Ли, М.

Нирачер, К.

Прахаллад, Т.

Райтио.

, Р.

Расипурам, Г.

Таунсенд, Б.

Уильямсон, Д.

Винарски, З.

Ву, Х.

Чжан.

Система преобразования текста в речь на устройстве с поддержкой глубокого обучения Siri, Interspeech, 2017. [3] Х.

Зен, К.

Токуда, А.

В.

Блэк.

Статистический параметрический синтез речи, Речевая коммуникация, Том.

51, нет. 11, стр.

1039–1064, 2009. [4] Юйсюань Ван, Р.

Дж.

Скерри-Райан, Дэйзи Стэнтон, Юнхуэй Ву, Рон Дж.

Вайс, Навдип Джейтли, Цзунхэн Ян, Ин Сяо, Чжифэн Чен, Сами Бенджио, Куок Ле, Яннис Агиомирджаннакис, Роб Кларк, Риф А.

Саурус .

Такотрон: к сквозному синтезу речи.

[5] Джонатан Шен, Руоминг Панг, Рон Дж.

Вайс, Майк Шустер, Навдип Джейтли, Цзунхэн Ян, Чжифэн Чен, Ю Чжан, Юйсюань Ван, Р.

Дж.

Скерри-Райан, Риф А.

Саурус, Яннис Агиомирджаннакис, Юнхуэй Ву.

Естественный синтез TTS путем обработки WaveNet на основе предсказаний Mel-спектрограммы.

[6] Хейга Зен, Эндрю Сеньор, Майк Шустер.

Статистический параметрический синтез речи с использованием глубоких нейронных сетей.

[7] Хао Чжан, Ричард Спрот, Аксель Х.

Нг, Феликс Сталберг, Сяочан Пэн, Кайл Горман, Брайан Роарк.

Нейронные модели нормализации текста для речевых приложений.

[8] Илья Суцкевер, Ориол Виньялс, Куок В.

Ле.

Последовательное обучение с помощью нейронных сетей.

[9] Аарон ван ден Оорд, Сандер Дилеман, Хейга Зен, Карен Симонян, Ориол Виньялс, Алекс Грейвс, Нал Калчбреннер, Эндрю Сениор, Корай Кавукчуоглу.

WaveNet: генеративная модель для необработанного аудио.

[10] Аарон ван ден Оорд, Яже Ли, Игорь Бабушкин, Карен Симонян, Ориол Виньялс, Корай Кавукчуоглу, Джордж ван ден Дрисше, Эдвард Локхарт, Луис К.

Кобо, Флориан Стимберг, Норман Касагранде, Доминик Греве, Себ Нури, Сандер Дилеман , Эрих Элсен, Нал Кальхбреннер, Хейга Зен, Алекс Грейвс, Хелен Кинг, Том Уолтерс, Дэн Белов, Демис Хассабис.

Параллельная WaveNet: быстрый высококачественный синтез речи.

[11] Вэй Пин Кайнань Пэн Цзитун Чен.

ClariNet: параллельная генерация волн при сквозном преобразовании текста в речь.

[12] Дарио Ретаге, Хорди Понс, Ксавье Серра.

Wavenet для шумоподавления речи.

Теги: #Машинное обучение #искусственный интеллект #tts #синтез речи

-

Новые Гаджеты, Работающие С Биткойнами

19 Oct, 24 -

Подкаст «Я Сказал На Каннада» (№3)

19 Oct, 24 -

Arduino В Закусочном Автомате

19 Oct, 24 -

Любовь – Предвестник Технологического Успеха

19 Oct, 24