Хочу поделиться с вами своим практическим опытом тестирования и использования системы хранения данных HPE Nimble; в нашем случае мы поделимся впечатлениями относительно модели All-Flash — HPE Nimble AF40. Насколько актуальной и интересной будет эта статья – решать вам, но в свое время мы столкнулись с проблемой поиска реальных историй (не путать с историями успеха), в которых автор по большей части делился бы своими мыслями, опытом.

и впечатления, т. е.

чистые эмоции от души, а не сухие факты или вездесущий маркетинг.

Поэтому мы решили потратить немного своего времени и попробовать написать что-то подобное, так что не судите строго, потому что.

Это моя первая попытка написания.

Итак, начнем.

Чтобы немного ввести вас в курс дела, давайте сначала дадим краткую информацию о нашем подопытном.

HPE позиционирует эту модель среди собственного семейства массивов All-Flash Nimble как оптимальный выбор по соотношению цена/производительность.

По производительности система довольно сильно отличается от младшей модели AF20 (почти в 5 раз выше!), но при этом не так сильно уступает старшим моделям - AF60 и AF80. По паспорту наш экземпляр уступает самой старой модели в среднем в 3 раза, по некоторым показателям даже меньше, а модель Nimble AF60 уступает не более чем в 2 раза.

Массивы всей линейки HPE Nimble обладают всем необходимым функционалом, в соответствии со своим статусом — массивы среднего ценового сегмента.

Тут и сжатие с дедупликацией, последнее с переменным блоком, и аппаратные снимки с согласованием на уровне приложений, и синхронная репликация, с возможностью реализации концепции Metro Storage Cluster, и поддержка технологии VVOL, QoS, возможность собрать Storage Pool из нескольких массивов — какой-то подобие федерации, и еще парочка хитростей в рукаве в виде искусственного интеллекта и продвинутой аналитики.

Ну а теперь о цифрах

По паспорту система позволяет получить до 130K IOPS на 4K блоках при смешанной нагрузке 50/50 на произвольных операциях ввода-вывода, 150K IOPS на тех же 4K блоках при 100% случайном чтении и 150K IOPS при 100% случайном чтении.% случайной записи — все это без учета дедупликации.

С учетом этого итоговые показатели будут зависеть от его общего коэффициента.

Например, при общем коэффициенте дедупликации 10:1 количество операций случайной записи немного снизится — до 130 КБ на блоках по 4 КБ.

При этом количество IOPS для операций чтения увеличится до 170K, а в смешанном режиме 50/50 заявлено 96K IOPS. По сегодняшним меркам это более чем скромно для массива All-Flash. Более того, массив является представителем среднего сегмента, и от них ожидаешь действительно приличных показателей, поскольку сегмент похож на гоночный трек, где на счету каждая доля секунды и производители выкладывают все самое лучшее, чтобы поразить конкурентов.

искушенной публике и завоевать их сердца (а заодно и кошельки).

В цифрах тут удивляться нечему, тем более, что теперь даже массивы Entry-Level (начального уровня) могут похвастаться 300+K IOPS, чему, кстати, могло бы позавидовать приличное количество Hi-End системы хранения данных 8-10 лет назад. Да, прогресс не стоит на месте – так оно и есть.

Другой вопрос, что критерии выбора у всех разные и не всем нужна самая быстрая машина.

Я определенно больше люблю комфорт. Да, динамика, несомненно, важная и нужная вещь (в определенной степени) для формирования того самого комфорта: когда машина едет и позволяет без напряжения, когда нужно ускориться, совершить динамичный маневр и вообще приятно, когда под капотом мощный двигатель, который, возможно, никогда не будет использован в полную силу, но какая разница.

Сразу вспоминаются спортивные машины, которые весело и задорно гудят в городе от светофора до светофоры, заметно встряхивающие тушки своих дерзких владельцев – очень динамичный разгон и не менее динамичное торможение.

На вкус и цвет фломастеры разные: кому-то нравится, кому-то нет. Я за практичность, т. е.

суп можно есть вилкой, но зачем, когда есть ложка.

Или зачем есть борщ половником из 10-литровой кастрюли, если есть тарелка и такая же ложка.

Ну в общем, думаю, вы меня поняли.

Вернемся к нашему подопытному.

Мы определились с цифрами и записали их в голове.

Таким образом, для нас не было никакого откровения по этому поводу.

Теперь я надеюсь, что вы тоже.

Когда мы определились с ожидаемой производительностью массива, остался только один вопрос: насколько справедливыми будут эти цифры, потому что.

Производители часто иногда завышают эти показатели и регулярно иногда невозможно добиться таких же показателей при тестировании устройства (например, это если вы тоже стали жертвой маркетинга и обладателем годового запаса лапши).

Кстати, в нашей практике HPE не была замечена в каких-либо манипуляциях с цифрами, неполноте или недостоверности технических характеристик продукции.Плавно переходя к тестированию, естественно, нельзя не упомянуть о составе нашего тестового стенда: здесь, что называется, не учитывались лучшие практики.Чего нельзя сказать о документации по работе с оборудованием, извините, больно.

Поэтому мы, конечно, отнеслись к заявленным цифрам с доверием… и сразу решили их проверить (доверяй, но проверяй – к этой простой жизненной мудрости мы пришли, проводя теплые летние дни за очередной миской лапши).

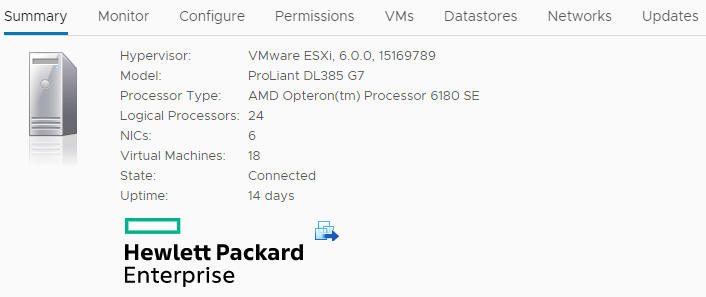

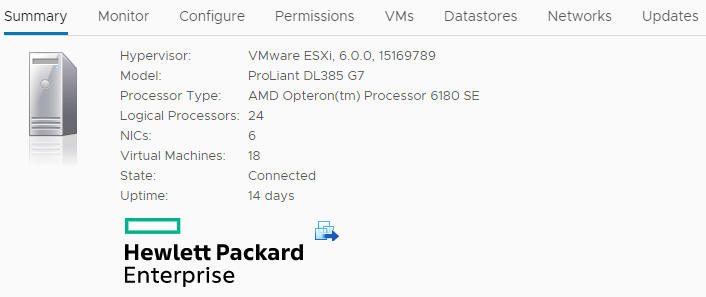

Серьезно, оборудование уже сильно устало, процессоры на подключенных хостах не канонические (те самые красные), гипервизоры - Конец общей поддержки.

Что действительно радует, так это наличие сети SAN на коммутаторах SN6000 (8-гигабитный Qloqic SANbox 5800 — привет из 2010 года).

В общем, не 4 Гбит — и это хорошо.

Но, к сожалению, открыть те самые 16 Гбит FC на HPE Nimble AF40 не получится.

Да и конфигурация самого массива тоже, скажем так, не лучшая практика, т.к.

официально рекомендуется использовать минимум 4 порта ввода-вывода на каждом контроллере, а в нашем случае у нас всего 2 порта FC по 16 Гбит в 8. Режим Гбит.

сервер DL385 Gen7, AMD Opteron 6180 SE, VMware ESXi 6.0.0 Кластер виртуализации на VMware ESXi 6.0.0 был собран из трёх серверов DL385 Gen7. Управление через VMware vCenter в формате устройства на Linux. Каждый хост оснащен двумя процессорами AMD Opteron 6180 SE и 192 ГБ оперативной памяти DDR3 PC3-10600 ECC RDIMM (1300 МГц).

Для подключения к сети SAN на каждом хосте используются два однопортовых адаптера FC 8 Гбит (HPE 81Q).

Сам HPE Nimble AF40 оснащен 24 твердотельными накопителями по 480 ГБ, двумя контроллерами и одним двухпортовым 16-гигабитным FC HBA в каждом из них.

Что касается выбора ПО для нагрузочного тестирования, то мы изначально выбрали классику жанра — vdbench, но затем остановились на HCIbench из-за его большей простоты и наглядности, а также ориентации на виртуальную среду VMware. Пока все ходили вокруг да около, о самой СХД HPE Nimble AF40 ничего не было сказано, кроме заявленных характеристик производительности.

Поэтому пора, так сказать, исправить ситуацию, тем более, что после долгого аперитива мы как раз подошли к этому очень вкусному моменту.

Впечатлениями и результатами мы будем делиться последовательно: начиная с настройки самой системы, затем переходим к тестам и еще чему-то очень интересному.

Но обо всем по порядку.

Впечатление №1: распаковка, установка и первоначальная настройка

С вашего позволения, не буду здесь задерживаться, хотя есть любители смаковать этот момент по полной.Что могу сказать, упаковка внушает доверие, все очень добротно: толстая картонная коробка, прикрученная болтами к деревянному поддону, внутри массив защищен плотным полиэтиленовым пакетом и черным типом пенопласта (эластичный и не крошится).

Все на своих местах – коробки и сумки с аксессуарами.

В общем, на упаковке экономить точно не стали.

Сам массив представляет собой полку высотой 4U, очень тяжелую и большую, глубина полки этого «мастодонта» — целых 89 см, а вес — более 50 кг.

Хотя, чему удивляться — сама коробка по меркам среднего массива огромна и словно намекает на сидящего в ней «монстра».

Если серьезно, вес имеет значение, особенно при установке.

Так и здесь – много металла, минимум пластика, очень прочный и прочный.

При желании его можно монтировать и разбирать хоть 10 раз – ничего не погнется, не сломается, не треснет и не отлетит. На самом деле, это уже давно проблема современного оборудования, изобилующего пластиком; детали имеют тенденцию трескаться или ломаться даже после установки.

Первоначальная настройка массива невероятно проста и интуитивно понятна.

И это поможет вам обрести дополнительную веру в свои силы.

Приветственный центр для Nimble .

Производитель предлагает в помощь онлайн-портал с пошаговыми текстовыми и видеоинструкциями, которые будут не только полезными и удобными, но и наглядными.

Дело не ограничивается одним только Нимблом; Также доступны материалы для другой системы хранения данных — HPE Primera.

Сначала вам необходимо выбрать интересующую вас модель, после чего отобразится список дальнейших рекомендаций, в том числе предустановочный чек-лист с указанием основных подготовительных моментов, на которые следует обратить пристальное внимание, чтобы каретка в конечном итоге не перевернулась.

в тыкву к полуночи.

И, конечно же, увлекательное видео-сопровождение, а в качестве бонуса еще и ссылка на Руководство по установке:

В общей сложности подготовка массива к работе занимает 15-30 минут. За качество изготовления, упаковку, внешний вид и простоту первоначальной настройки – «5» из «5».

Вес и габариты, конечно, дают о себе знать, но можно потерпеть.

Впечатление №2: подключение HPE Nimble AF40 к кластеру VMware

И здесь нас ждал первый приятный сюрприз и важное преимущество HPE Nimble — простая и понятная интеграция с VMware с помощью технологии VVOL. Это особенно впечатляет в связи с тем, что мы раньше не использовали технологию VVOL, а идеологически пытались воссоздать ее вручную, используя выделенные VMware VMFS Datastores для каждого виртуального диска каждой виртуальной машины.Такой ручной подход был призван упростить использование аппаратных снимков, защитить от возможных проблем с очередями на уровне LUN (когда есть один толстый VMware VMFS Datastore и на нем живут все виртуальные машины, как в большой коммуналке с общим кухня, где периодически могут происходить ножевые бои).

Если система хранения данных имела механизмы QoS, это также позволяло настраивать собственные ограничения производительности для каждого отдельного диска виртуальной машины или, наоборот, гарантировать заданный минимум.

Снимки оборудования делались только на тех виртуальных томах СХД, которые принадлежали данной виртуальной машине, а не на всем общем хранилище данных VMware VMFS. Такая же ситуация и с их восстановлением.

Плюс была устранена проблема нехватки места в общем хранилище данных VMware VMFS и остановки всех виртуальных машин из-за ошибки записи, если администратор вдруг ее проглядел.

То есть по большей части все ради управляемости, контроля и исключения взаимного влияния.

Но, несмотря на такое значительное количество преимуществ, было и немало недостатков, особенно в плане трудозатрат. Речь идет о ручном создании всех необходимых виртуальных томов на уровне массива, представлении их кластеру, создании каждого из дисков виртуальной машины на собственном выделенном хранилище данных VMware VMFS и так далее.

Стоит отметить, что этот вариант явно подойдет не всем, так как существуют ограничения на их количество — для ESXi 6.0.0 это значение равно 256. Но в нашем случае мы уложились в лимит, смирились с неудобством и трудозатраты ради управляемости.

Технология VVOL в целом позволила нам пойти еще дальше.

Помимо этих преимуществ и отсутствия явных недостатков, это позволило перенести и полностью автоматизировать операции создания виртуальных томов в системе хранения данных для виртуальных машин на VMware vCenter. То есть, настроив интеграцию один раз, теперь вообще нет необходимости заходить в интерфейс управления HPE Nimble AF40 или создавать новые презентации для новых томов.

Даже не обязательно заранее готовить тома на СХД, если используются определенные настройки (тип толстого или тонкого диска, включено ли сжатие и дедупликация, размер блока дедупликации).

Теперь все это делается с помощью vCenter и политик хранения виртуальных машин.

Для этого удовольствия вам достаточно выполнить пять основных шагов (не считая стандартных требований по подключению СХД к серверам через Fabric SAN, таких как зонирование).

- Шаг 1. Интеграция с vCenter

- Шаг 2. Создайте структурный каталог на HPE Nimble — Папка с указанием типа управления VVOL:

- Шаг 3. Ознакомьтесь с политиками производительности на HPE Nimble для создания политик хранения ВМ (также вы можете создать свои собственные политики производительности на HPE Nimble с указанием предварительных настроек — это, по сути, профиль для создания виртуального тома):

- Шаг 4. Создайте необходимый набор политик хранения виртуальных машин в vCenter на основе политик производительности:

- Шаг 5. Подключите папку к кластеру в vCenter:

Для опытных также есть возможность просматривать различные типы информации о VVOL через плагин HPE Nimble в vCenter, а также настроить расписание создания согласованных снимков на уровне VM Storage Policies:

Впечатление №3: нагрузочное тестирование синтетическими тестами

Теперь самое время проверить заявленные ТТХ массива.Самый простой шаблон загрузки — 100% случайное чтение блоками по 4 КБ (без использования дедупликации).

Мы используем инструмент загрузки, встроенный в HCIbench, со следующими настройками:

Общее количество виртуальных машин - 12, в каждой по 8 дисков емкостью 10 ГБ, прогрев - 6 минут, время теста - 1 час, общее количество потоков - 384. Важный момент - перед тестом абсолютно рандомно.

данные записываются на диски таким образом, что полностью отсутствуют блоки с 0, поэтому сжатие на этих дисках показывает соотношение 1:1. Это важно, т.к.

при наличии нулевых блоков операции чтения можно значительно ускорить при включении сжатия.

По результатам получаем следующее.

Аналитика из интерфейса управления HPE Nimble AF40:

Результаты HCIbench (для самых внимательных: время отчета дано с учетом часового пояса GMT -07:00, что составляет разницу в 10 часов по сравнению с GMT +03:00):

Задержки чтения довольно высокие — нам хотелось бы держать их в пределах 2 мс — поэтому пробуем второй подход: настройки те же, но уменьшаем количество виртуальных машин до 6, тем самым уменьшая количество потоков до 192:

Уже намного лучше.

Конечно, было интересно, как будет работать QoS, поэтому мы установили ограничение для тестируемых VVOL на уровне 20K IOPS и снова провели первый тест на 384 потока, но в целях экономии времени, продолжительностью всего 10 минут. Используя SSH-подключение к ESXi-хостам и встроенную утилиту esxtop, мы видим, что с каждого хоста генерируется нагрузка в 125-128 потоков и при этом мы получаем очень высокие показатели задержки от FC HBA-сервера до СХД.

.

И здесь нет ничего удивительного: система хранения отрабатывает политику QoS, снижая максимальное количество операций ввода-вывода в секунду до 20 000, что приводит к накоплению очередей и задержкам ввода-вывода.

Собственно, другого пути здесь нет. Функциональность чрезвычайно полезна и поможет защитить вашу производственную среду или критически важные сервисы от паразитной нагрузки со стороны тестовых лабораторий или других менее важных сервисов, не чувствительных к задержкам.

Как обстоят дела с записью? Запускаем тест 100% случайной записи, размер блока 4К, остальные параметры те же.

Опять же для начала 384 потока.

По традиции мы запускаем тест второй раз, но уже с 6 виртуальными машинами, а значит, и 192 потоками.

Здесь нам также удалось уложиться в 2 мс.

Результат очень близок к аналогичным измерениям, основанным на 100% случайных показаниях.

Это говорит о том, что заявленные производителем показатели IOPS актуальны.

Напомню, 150K IOPS для 100% случайного чтения в блоках по 4К и для 100% случайной записи в блоках по 4К.

Хотя на практике запись всегда отстает от чтения, это, вероятно, связано с чудесной магией собственной архитектуры HPE Nimble CASL с многоуровневым кэшированием как для записи, так и для чтения.

Есть, конечно, и сложный тест через vdbench для виртуальной среды, максимально приближенный к реальным нагрузкам, но, к сожалению, не хватило времени запустить его еще раз, и предыдущие результаты не сохранились (возможно в следующий раз, если тема появится).

Заключение: довольно хорошие результаты, учитывая устаревшее оборудование и отсутствие 16-гигабитного FC, что, на наш взгляд, и помешало нам достичь заявленных цифр.Когда с синтетикой покончено, пора переходить к продвинутой аналитике и искусственному интеллекту SkyNet HPE Infosight, который призван убить всех людей для упрощения процессов мониторинга, управления и поддержки системы хранения на протяжении всего ее жизненного цикла.

Впечатление №4: HPE Infosight AI — с ним в шахматы не поиграешь, но он поможет найти и решить проблемы

HPE Infosight AI здесь выступает в роли бесплатного десерта, который вам приносят в дорогом ресторане после сочного стейка.Не думаю, что я его заказывал, но его привезли за счет ресторана.

Вроде бы и не хотелось, но раз принесли, то было бы обидно не попробовать.

Но попробовать стоило, скажу я вам.

Попадая на главную страницу HPE Infosight (после предварительной регистрации, авторизации и привязки массива), мы видим несколько разных меню, в которых есть что посмотреть.

В том числе различные панели управления.

Например, Оперативное, позволяющее оценить общее состояние массива, или Рекомендации, позволяющие подробно ознакомиться с рекомендациями на рисунке выше в правой части скриншота.

Рекомендации, кстати, формируются на основе аналитики, которую производит искусственный интеллект с использованием машинного обучения и телеметрии всей инсталляционной базы HPE Nimble по всему миру (в лабораториях HPE Nimble это Cross Stack Assessments).

Ниже приведен пример рекомендаций по одной из проблем — Физическая перегрузка ЦП с указанием масштаба катастрофы.

Рекомендации также доступны для оставшихся двух проблем — Повышенная задержка, Перераспределение виртуальных процессоров, а иногда щедрость тоже портит:

Также есть отчеты для руководителей, в которых показано, есть ли открытые дела, над которыми ведется работа, экономические показатели массива (сколько места сэкономлено благодаря технологиям сжатия и дедупликации), а также рекомендации при необходимости обновления массива.

множество.

Wellness позволяет получить список проблем, если они есть, а Performance показывает разного рода тенденции в динамике наполнения массива.

И, наконец, одно из самых полезных и интересных — лаборатории HPE Infosight, где можно примерить халат лаборанта и провести парочку экспериментов или исследований.

Вот вышеупомянутые Рекомендации по перекрестному стеку и Планировщик ресурсов, который позволит вам смоделировать добавление любой нагрузки в массив и изучить, как это повлияет на общую производительность массива.

В этом случае происходит тонкая настройка выбранной нагрузки.

Раньше, кстати, все это требовало отдельных продуктов, например HP Virtualization Performance Viewer, который, естественно, стоил денег и его нужно было развертывать и поддерживать.

Если вы считаете, что есть проблемы с производительностью системы хранения, вы можете запустить Рекомендации по производительности AI и получить анализ за выбранный период. Соответственно, если есть проблемы, будут рекомендации по их устранению.

Словом, здесь есть где разгуляться, а самое главное – с минимальными усилиями (не нужно ничего собирать, строить графики, вести таблицы Excel и т. д.) получать отчеты и конкретную информацию, которую можно предоставить руководство, пояснив, что это ИИ на основе машинного обучения, проводит анализ и интерпретацию входных данных.

Опытный сборщик виртуальных машин может подумать: «Хотелось бы, чтобы была корреляция между показателями производительности виртуальной инфраструктуры и показателями СХД, иначе как-то неудобно искать что-то в VMware vCenter, или что-то в интерфейсе управления HPE Nimble в Мониторинге».

раздел , а затем сравните одно с другим, используя ваш любимый эмпирический метод».

И да, это тоже здесь.

В разделах Инфраструктура -> Виртуализация, в зависимости от того, что вы используете (на данный момент поддержка есть только для VMware и Hyper-V), вы можете получить информацию о ваших дата-центрах, кластерах, хостах, хранилищах данных и виртуальных машинах (их загрузка, производительность).

, метрики).

В контексте виртуальных машин можно увидеть статистику по потребляемым ресурсам как вычислительной инфраструктуры, так и системы хранения данных, что также будет крайне полезно.

И, наконец, мы решили дополнить все это самыми полезными ресурсами на HPE Nimble. Там есть документация, прошивки, дополнительное ПО, разного рода матрицы совместимости (куда бы мы без них) и ссылка на портал поддержки, где можно работать над кейсами.

Теги: #Компьютерное оборудование #ИТ-инфраструктура #Системное администрирование #Хранение данных #Высокая производительность #Тестирование ИТ-систем #Системы хранения данных #hpe #nimble Storage #nimble

-

Город Героев И Злодеев - Обзор Игры

19 Oct, 24 -

Так Что Же Такое Этот Фронтьервиль?

19 Oct, 24 -

Есть Ли Жизнь Без Решарпера?

19 Oct, 24