Пусть жираф ошибается Но виноват не Жираф, И тот, кто кричал из ветвей: «Жираф большой — он знает лучше!» (С) Нужно было быстро разобраться в технологии Апач Спарк адаптированный для использования больших данных.

В процессе выяснения я активно пользовался хабрахабром, поэтому постараюсь вернуть информационную пользу, поделившись полученным опытом.

А именно: установка системы с нуля, настройка и собственно программирование кода, решающего задачу обработки данных для создания модели, рассчитывающей вероятность банкротства клиента банка на основе набора характеристик, таких как сумма кредита, ставка и т.д. Вроде бы больших данных должно быть много, но почему-то не так-то просто найти ту горячую точку, где все их ищут. Сначала я попробовал вариант с амбари , но на моей Windows7 были ошибки в настройках сетевого моста.

В итоге попробовал вариант с преднастроенной виртуальной машиной от Cloudera ( CDH ).

Просто устанавливаем VirtualBox, запускаем скачанный файл, указываем основные параметры (память, место) и через 5 минут почтенный джинн Апач Хадуп жаждет ваших указаний.

Несколько слов о том, почему Spark. Насколько я понимаю, ключевые отличия от оригинального MapReduce заключаются в том, что данные хранятся в памяти, а не сбрасываются на диск, что дает ускорение во много раз.

Но, пожалуй, более важным является реализация ряда статистических функций и удобный интерфейс загрузки/обработки данных.

Ниже приведен фактический код для решения следующей проблемы.

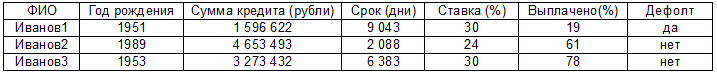

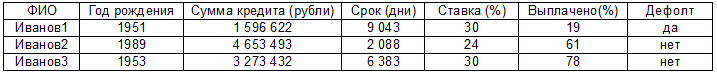

Там действительно большие данные (потому что рука очень устает прокручивать эти 2000 строк) в формате:

Есть предположение, что значение по умолчанию как-то связано с остальными параметрами (кроме первого, уважаемый Иванов1.Н претензий не имеет) и необходимо построить модель линейной регрессии.

Прежде чем начать, стоит отметить, что это мой первый код на Java, сам работаю аналитиком и вообще это мой первый запуск Eclipse, настройка Maven и т.д. Так что не ждите сложных чудес; ниже представлено простое решение проблемы с использованием метода, который каким-то образом сработал.

Идти: 1. Создайте сеанс Spark. Важным моментом является то, что всё работает только с версией 2.0.0, а CDH идёт с v1.6. Значит нужно обновиться, иначе при запуске будет исключение.

Теги: #Большие данные #spark #java #ASP #ASP #Большие данные #Машинное обучениеSparkSession ss = SparkSession

-

Как Монетизировать Свой Бесплатный Сайт

19 Oct, 24 -

«Умная» Детская Коляска «Максимка»

19 Oct, 24 -

Написание Простого Плагина Для Virtualdub

19 Oct, 24