Добрый день всем, кто читает эти строки.

Недавно мне представилась возможность настроить дисковую полку EMC VNX 5100 в качестве системы хранения данных для кластера.

Как оказалось, ничего особо сложного в этом нет, но в процессе есть некоторые особенности, отвлекающие время и внимание.

Если вы хотите использовать эту систему хранения, но не желаете тратить лишнее время на перебирание граблей, смотрите кат. Дисковая полка VNX 5100 — это система хранения начального уровня, структурно состоящая из самого дискового массива и модуля SPS (Standby Power Supply).

Массив занимает 3 блока и может содержать 15 накопителей формата 3,5 дюйма (мой вариант), либо 25 накопителей формата 2,5 дюйма.

Первые четыре диска заняты операционной системой и не рекомендуются к использованию.

Модуль SPS занимает 1 блок, содержит встроенные аккумуляторы и может вместить два дисковых массива.

Его основная задача — корректно выполнять все дисковые операции и записывать содержимое кэша на диски при выключенной полке.

Ничего больше.

Это не просто грабли, а детские грабли.

С соответствующими последствиями в случае нападения.

Несмотря на наличие собственной батареи, система не делает ни малейшей попытки выдать себя за ИБП, а если пропадает питание, то спокойно выходит из строя.

Так что эту батарею надо включать во внешний источник бесперебойного питания, хотя опыт активно протестует. Упакована система с душой, вес упаковки чуть больше 90 кг, так что на «бодискид» лучше пригласить мускулистых друзей.

А если на пути к серверной комнате крутая лестница и узкие двери, то ваши друзья будут особенно благодарны за доставленное удовольствие.

Устройство может продаваться как с включенным программным обеспечением, так и без него.

Как бы то ни было, если в коробке вы не обнаружите установочных дисков, не расстраивайтесь.

Это отлично.

На монтаже в стойку останавливаться не будем; все собирается без проблем.

Единственное, стоит обратить внимание на шнуры питания, входящие в комплект. Может, мне так повезло с полками, может, со стоечными источниками бесперебойного питания, но шнуры из комплекта довольно свободно сидят в разъемах ИБП.

Из трех моих полок один комплект шнуров пришлось почти полностью заменить на шнуры от ИБП, иначе они бы просто выпали.

Прежде чем приступить к настройке, зарегистрируйтесь на сайте производителя.

emc.com и загрузите необходимое программное обеспечение.

Сети рекомендуют скачать установочный пакет Набор инструментов для установки VNX , в котором есть практически все необходимое, но я бы советовал брать необходимые утилиты оптом.

Во-первых, в набор инструментов не включены все необходимые утилиты, во-вторых, они созданы установщиком.

Установить где угодно , которая некорректно работает под Windows Server 2012. Вам потребуются последние версии следующих утилит (они уже сжаты установщиком УстановитьAware который работает нормально):

- ЭМС PowerPath

- Инициализация системы хранения данных EMC Unisphere

- Серверная утилита EMC Unisphere

- Клиент EMC Unisphere VNX

- Сервер EMC Unisphere

- Менеджер по обслуживанию EMC Unisphere

Советую при настройке отключить внутренние интерфейсы на всех узлах будущего кластера, иначе полка при регистрации может подхватить именно их, а не внешние.

Не то чтобы это критично, в любом случае работать будет, но вдруг когда-нибудь в будущем полке вам захочется общаться по сети со своими хостами.

Далее я опишу каждую утилиту с указанием ее версии.

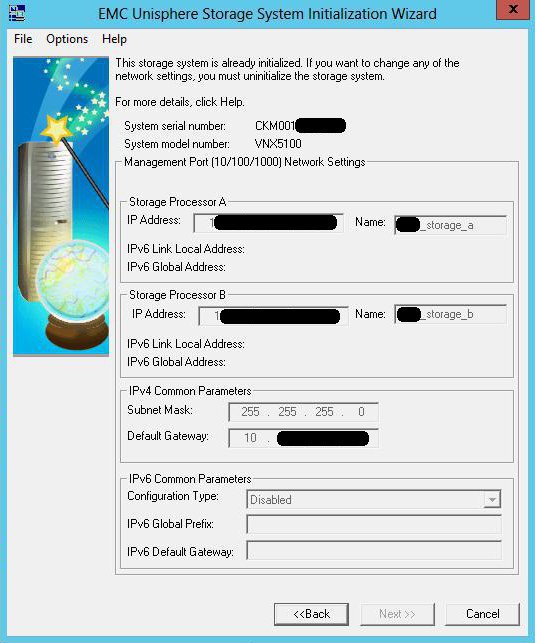

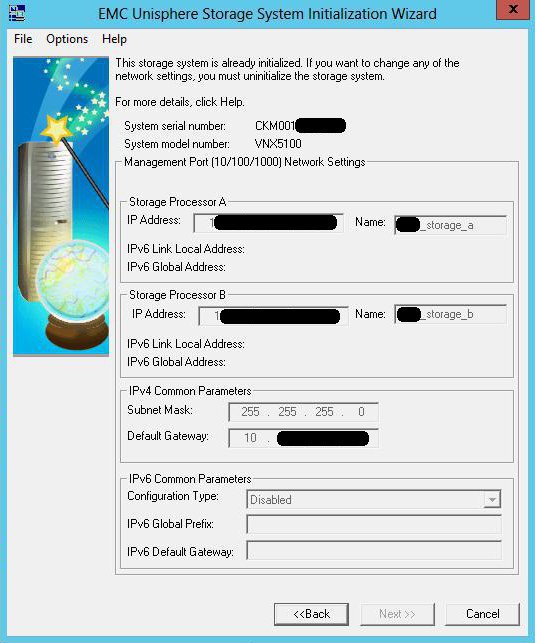

Это не обязательно последняя версия на данный момент, но эта версия гарантированно мне подойдет. Инициализация системы хранения данных EMC Unisphere (UnisphereInitTool-Win-32-x86-en_US-1.2.25.1.0163-1.exe) Эта утилита инициализирует вашу полку.

Перед установкой подключите хост-интерфейс и интерфейсы управления дисковой полки к одной подсети, на одном физическом коммутаторе.

Включите полку.

Начинается довольно медленно, поэтому есть время и на чашечку кофе.

Устанавливаем, запускаем утилиту, она ищет подсеть и показывает все найденные СХД с указанием их серийного номера.

Обратите внимание, что на время работы утилиты необходимо отключить брандмауэр, иначе поиск будет неудачным.

Определяем по номеру тот, который нам нужен, инициализируем его и задаем IP-адреса на интерфейсах управления.

К сожалению, на этот счет мои знания только теоретические, из мануалов, так как мое оборудование пришло от поставщика уже инициализированным, с адресами на интерфейсах типа 1.1.1.1. Так что я просто убедился, что устройство инициализировалось и определил его ip. Если у кого есть практический опыт данной операции, буду благодарен за разъяснения.

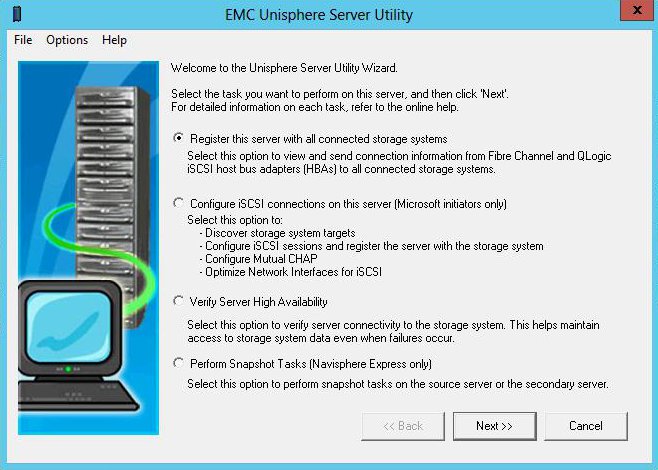

Серверная утилита EMC Unisphere

(UnisphereServerUtil-Win-32-x86-en_US-1.2.25.1.0163-1.exe) Утилита регистрирует хост на дисковой полке, позволяя в дальнейшем назначить ему логические диски.

Если инициатор iSCSI не запущен, то он тоже запускается.

При необходимости регистрацию можно провести вручную из веб-интерфейса – все получится.

Но правильнее было бы сделать это автоматически.

После запуска выберите пункт Зарегистрировать этот сервер со всеми подключенными СХД.

Сервер EMC Unisphere

(UnisphereServer-Win-32-x86-en_US-1.2.25.1.0156-1.exe)

Клиент EMC Unisphere VNX

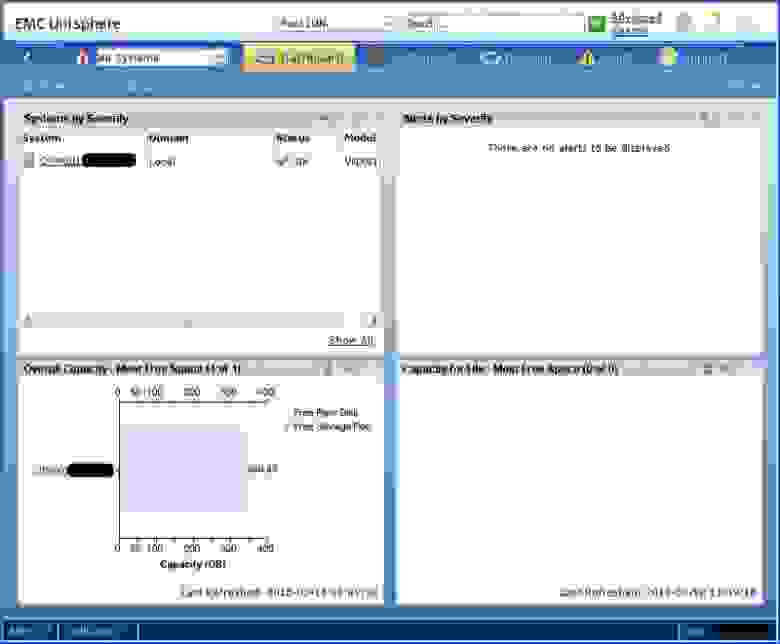

(UnisphereClient-Win-32-x86-en_US-1.2.25.1.0156-1.exe) Обеспечивает доступ к веб-интерфейсу управления полками.

Клиентская часть просит ввести адрес полки и подключается к ней, серверная часть предоставляет то же самое на IP-адресе хоста.

Работает на Java. Чтобы обеспечить корректную работу серверной части, настройте разрешения брандмауэра.

Вы можете подключиться к тому же интерфейсу полки, просто введя IP-адрес полки в браузере.

Обратите внимание, что при первом подключении вам необходимо создать учетную запись администратора.

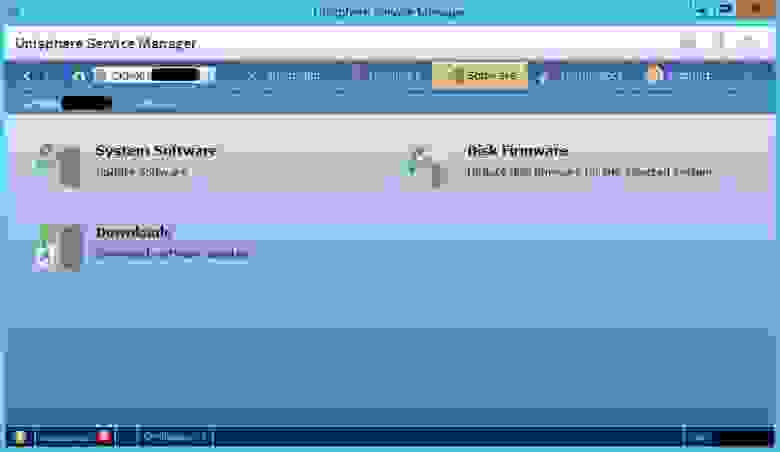

Менеджер по обслуживанию EMC Unisphere

(UnisphereServiceManager-Win-32-x86-en_US-1.2.26.1.0068-1.exe)

Сервисная утилита, используемая для смены прошивки, ОС, обновления оборудования, сбора диагностики и т.п.

В обычной работе не используется.

ЭМС PowerPath

(EMCPower.X64.signed.5.5.b289.exe) Утилита PowerPath — это отдельный продукт для балансировки нагрузки между разными FC, может использоваться с СХД разных производителей и, вообще говоря, является лицензионной и платной вещью.

Однако для подключений к системам EMC Clarion и EMC VNX производитель разрешает использование без лицензии.

Для этого при установке указываем «Да», к этому хосту у нас подключены только массивы Clarion. Я использовал версию 5.5 без патча.

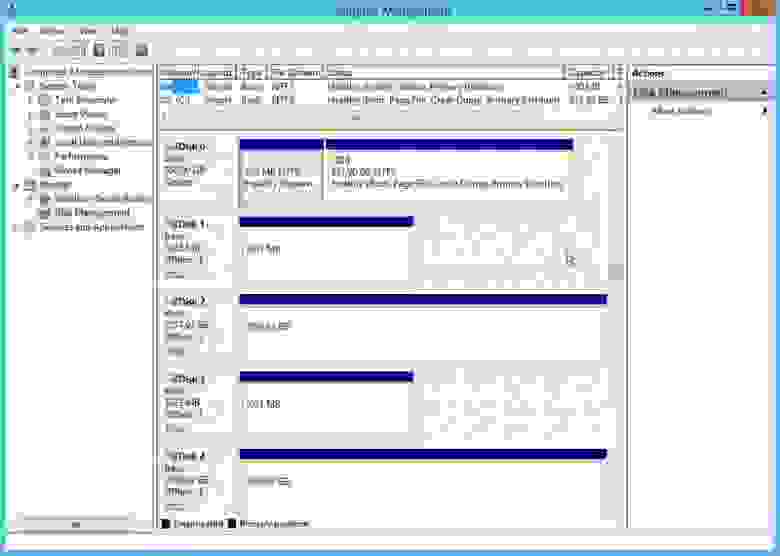

На сайте есть патч, а в документации есть упоминания о версии 5.7. Структурно полка содержит два блока, каждый из которых передает хосту информацию о закрепленных за ним логических дисках.

Таким образом, в Диспетчере компьютеров вы увидите два набора дисков-хранилищ, один из которых подключен, а второй выдает ошибку (и неудивительно, ведь диски уже заняты).

PowerPath автоматически обрабатывает все FC и скрывает дополнительный набор дисков.

Без этого все получится, но лучше сделать красиво и правильно.

Утилита поддерживает три режима работы:

Активный-активный – FC работают одновременно с балансировкой нагрузки.

Активно-пассивный – один ФК активен, а остальные находятся в резерве и подключаются при выходе из строя активного.

Одновременно работает только один FC. АЛУА – Это протокол выбора предпочтительного пути к данным, расположенным на контроллерах с разными приоритетами, например, один из двух в качестве пути доступа более предпочтителен, чем другой.

Итак, с помощью протокола ALUA (если ОС может его использовать) из нескольких путей выбирается тот, по которому выгоднее получить доступ к заданной порции данных (например, LUN).

Если контроллер с приоритетом этих данных недоступен, то доступ будет идти через контроллер, имеющий «второй по приоритету» приоритет и так далее.

Но тем не менее, оба они активны, хотя в данный конкретный момент времени преимущественно один используется для конкретного LUN (в этом отличие от Active-Passive).

(с) трек Именно этот режим поддерживает наше устройство, в отличие от двух предыдущих, работать с которыми могут только старшие модели.

Итак, все программное обеспечение установлено, и теперь можно работать на самой полке.

Подключитесь к веб-интерфейсу и перейдите на вкладку Хосты > Список хостов .

Поскольку мы уже зарегистрированы, на этой вкладке мы можем видеть наши серверы.

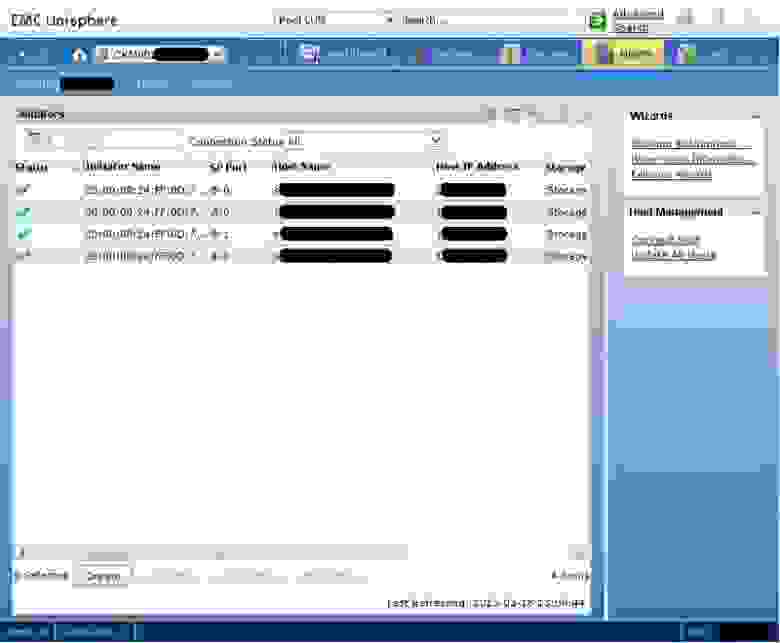

На вкладке Хозяева > Инициаторы перечислены инициаторы подключения серверов к хранилищам.

Вы можете отменить регистрацию инициатора и вручную создать вместо него новый, выбрав имя сервера из существующих или указав новое.

Это будет работать.

На данный момент все инициаторы в списке отмечены желтыми предупреждающими треугольниками - потому что они еще никуда не подключены.

На вкладке Настройки > Сеть > Изменить настройки сети.

перенастроить IP-адреса в вашей сети.

Поскольку наша система готовится к работе в кластере, мы создадим два LUN — кворум на 1 ГБ и LUN данных на остальное пространство.

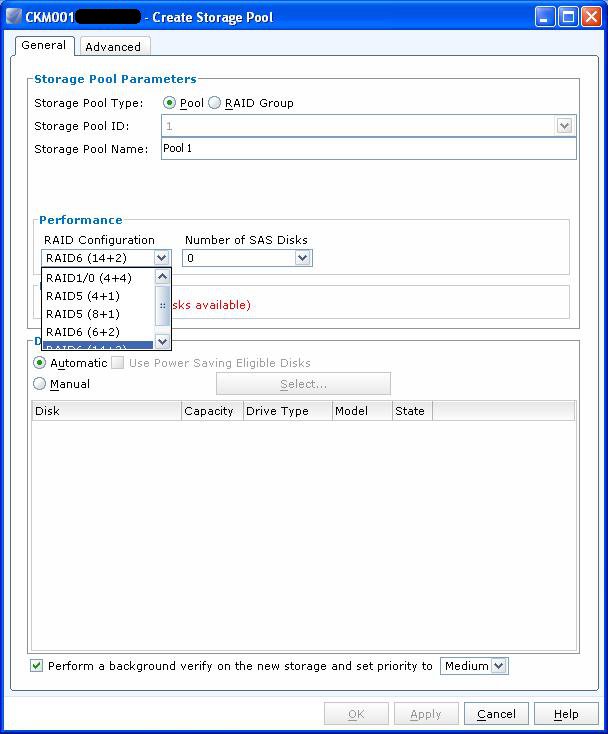

Сначала мы готовим пул для размещения этих LUN. На вкладке Хранилище > Пулы хранения данных выберите тип рейда и общий размер пула.

Здесь тоже есть особенность — система не может создавать рейды на произвольное количество жестких дисков.

Вместо этого вы можете выбрать один из предустановленных шаблонов.

Итак, 10 дисков в рейде5 вовсе не означают схему 9+1. А означает (4+1)+(4+1), с соответствующим падением общей мощности.

А рейд5 на 8 дисков означает комбинацию (4+1)+(2+1).

Хорошо, если этот рейд будет содержать только файловые данные, но если это данные приложений, то нас ждут непредсказуемые проблемы с производительностью.

Учитывая, что изначально я могу рассчитывать на 10 дисков (15 минус 4 под операционную систему и минус 1 HotSpare), мне приходится выбирать между RAID5 на 10 дисков и RAID6 на 8 дисков плюс два в зеркале.

Из соображений емкости диска было решено использовать RAID5. Итак — указываем тип рейда, указываем количество выделенных для него дисков, имя нового пула — и ОК.

Сейчас Хранилище > Луны .

Указываем имя пула, на котором будет располагаться вновь созданный LUN, его имя и размер.

И наконец, на вкладке Хосты > Группы хранения создайте новую группу хранения, связав LUN и хосты вместе: Создавать , затем Подключите LUN , затем Подключить хосты .

Группы хранения фактически сопоставляют один или несколько LUN с одним или несколькими хостами.

Обратите внимание, что подключить несколько хостов к одному LUN можно только в том случае, если они будут будущими членами кластера.

В противном случае хосты повредят данные друг друга из-за несогласованной записи на диск.

Теперь вы можете перейти на вкладку Хозяева > Инициаторы и полюбуйтесь зелеными галочками возле всех инициаторов, обозначающими правильное подключение.

На этом настройку дисковой полки можно считать завершенной.

На каждом хосте заходим в Управление дисками и переносим наши новые диски онлайн без присвоения буквы.

Форматируем его в NTFS, поднимаем кластер и присоединяем к нему диски.

Вы можете работать.

Кластер я поднимал на Windows Server 2012, отличия в процессе от Server 2008 косметические.

Но, если кому интересно, могу описать.

Фу.

Вот вроде бы "все, что я хотел сказать о войне во Вьетнаме" (с) P.S. Большое спасибо хаббраузерам Литвег И отслеживать за интересные и полезные дополнения.

Теги: #инфраструктура #ИТ-инфраструктура #Администрирование серверов #системы хранения данных

-

Хрящ

19 Oct, 24 -

Зачем И Как Проводить Исследования Клиентов?

19 Oct, 24 -

Как Интернет Убивает Вашу Продуктивность

19 Oct, 24 -

Универсальная Теория Афины

19 Oct, 24 -

Heroku — Экспериментальная Поддержка Node.js

19 Oct, 24