В этом году на форуме управления данными INFADAY 2020 было много интересных технических кейсов.

Один из них — настройка сбора потоковых данных с датчиков IoT и SCADA-систем, чтобы эти данные можно было сразу включить в процессы управления стратегическими данными в организации — Data Governance. Другими словами, эксперт показал, как собирать данные с датчиков, чтобы эти данные можно было использовать для отчетности, автоматически применять к ним критерии качества и так далее.

При этом эксперт предложил реализовать процессы управления данными в продуктивной среде с помощью решений платформы Informatica, а сбор данных с многочисленных устройств на периферии — с помощью платформы Tibbo AggreGate. Если вы работаете в крупной промышленной компании, скорее всего, вы уже сталкивались с подобными проблемами.

И если вы с этим еще не столкнулись, то очень скоро столкнетесь.

Особенно это актуально для нефтегазовых компаний.

Такие компании широко используют датчики SCADA для мониторинга инфраструктуры добычи и транспортировки нефтепродуктов.

При этом вам необходимо очень быстро управлять собранными потоковыми данными (улучшая их качество, интегрируя, перемещая в различные системы).

Важно реагировать на показания датчиков сразу, в режиме реального времени.

Если вовремя отреагировать на уведомление о происшествии, можно избежать очень больших проблем.

Ниже я расскажу, как можно настроить сбор данных с датчиков с учетом Data Governance на примере Tibbo Aggregate Network Manager и платформы Informatica. Если вы хотите посмотреть видео демонстрации на INFADAY 2020, вы можете сделать это на сайте мероприятия.

Сбор данных с датчиков в хранилище и Kafka Например, соберем данные с коммутатора Ubiquity, обработаем их и передадим в хранилище данных и Kafka. Первоначальный сбор мы проведем с помощью решения AggreGate Network Manager (NM) от Tibbo, которое хорошо работает с разными типами датчиков и данными, которые с них собираются.

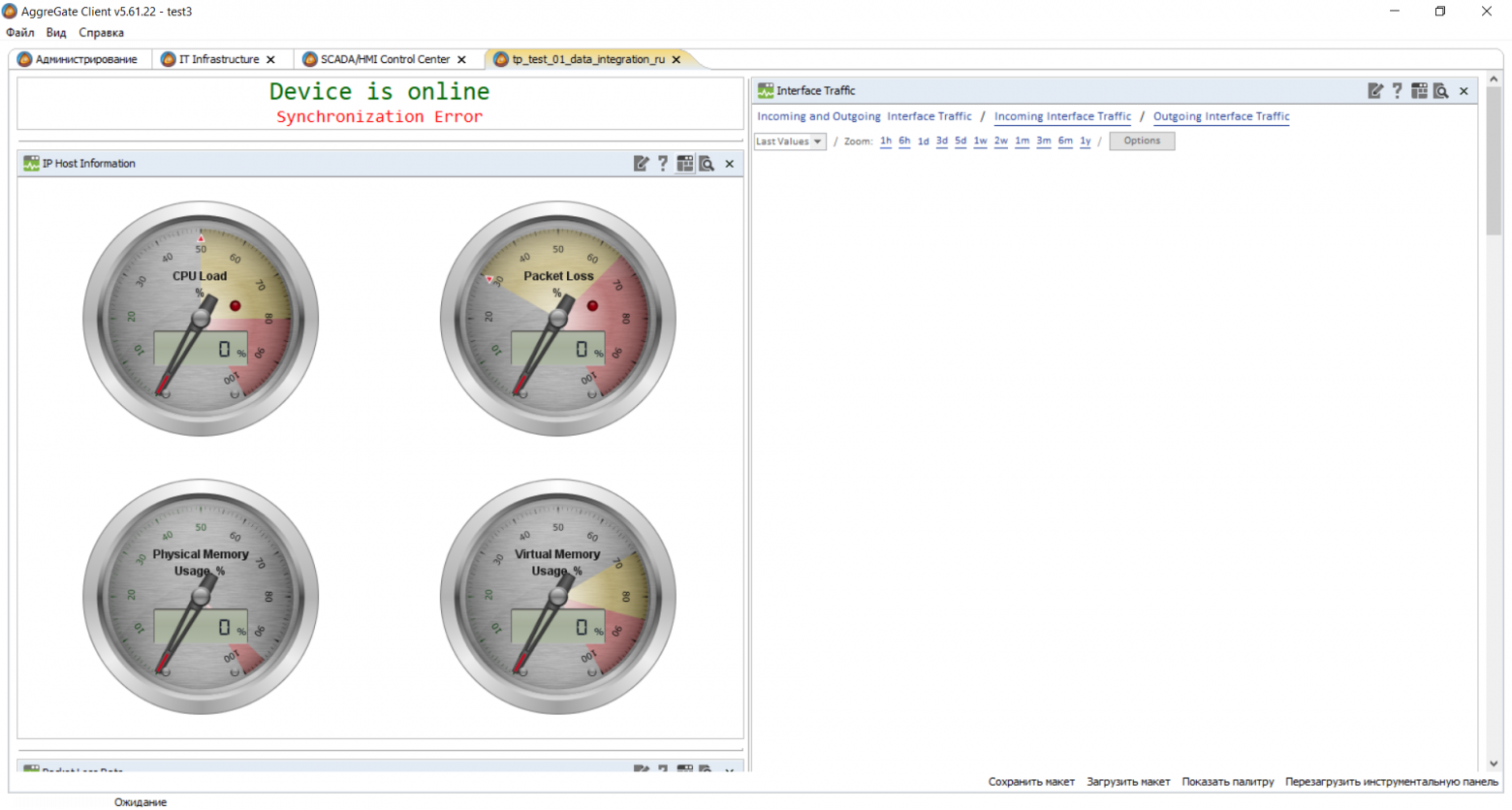

Ниже вы можете увидеть папку «Устройства» — «Ubiquity Switch».

Здесь теперь хранятся наши данные с коммутатора.

Вот как выглядят рабочие параметры выключателя, данные о которых мы собрали.

AggreGate NM взаимодействует с Informatica через промежуточный MQTT-брокер.

Network Manager отправляет данные протокола IoT MQTT (Message Queuing Telemetry Transport), упакованные в формат JSON. Заходим в раздел «Модели», выбираем ранее созданный объект Informatica_MQTT_Sender и во вкладке дизайнера правил находим задачу: упаковать таблицу интерфейса ifXtable в формат JSON и отправить ее на сервер MQTT-брокера.

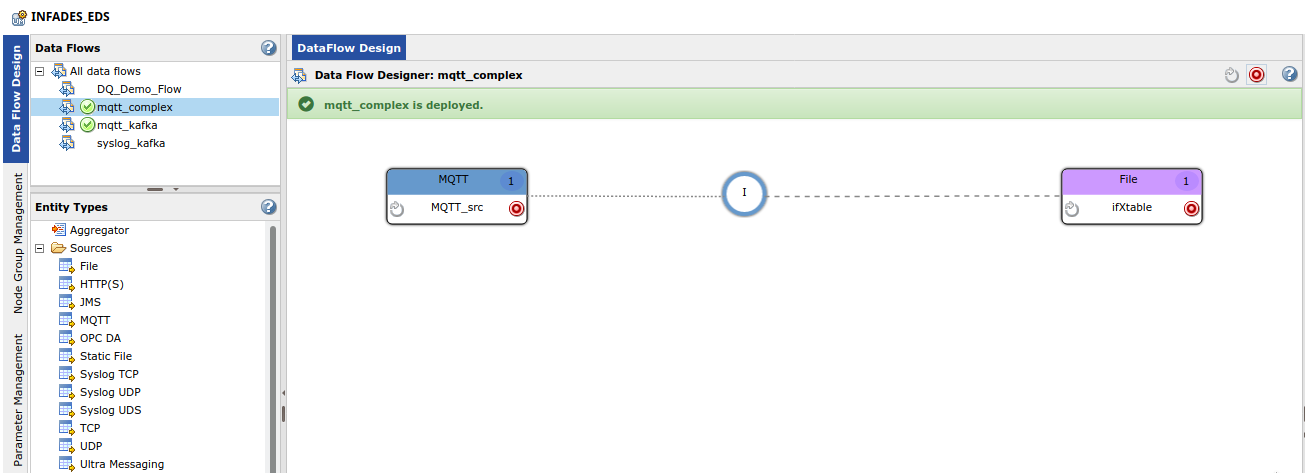

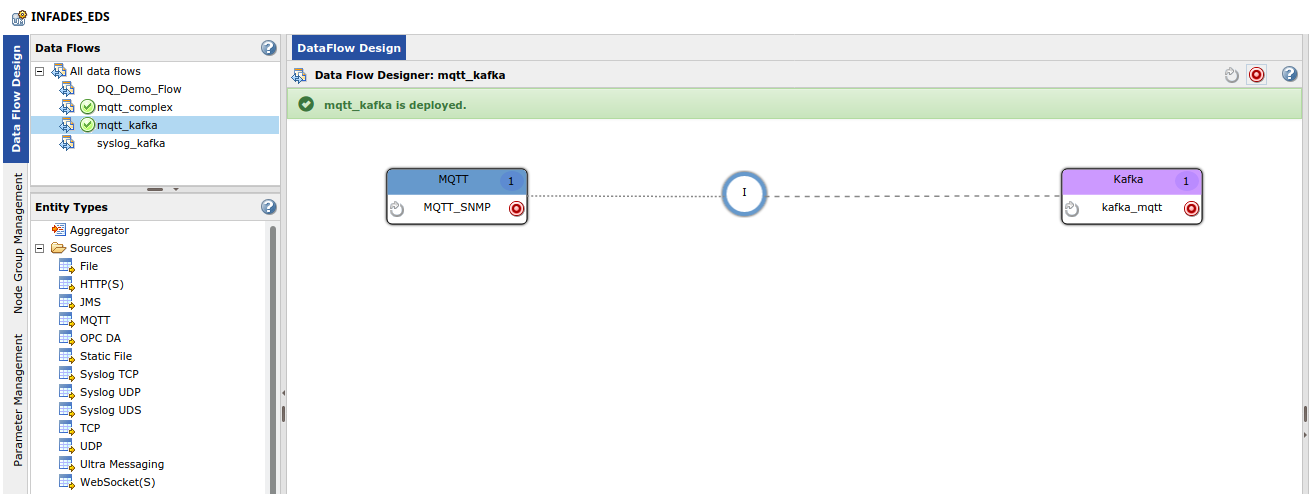

Открываем Data Engineering Streaming, в нем настраиваем два простых маппинга для захвата данных от MQTT-брокера и перемещения их в хранилище Kafka и Hadoop.

В интерфейсе платформы Информатика отображение перемещения в хранилище будет выглядеть так.

Преобразование (строка) необходимо для разделения потока данных на отдельные строки с помощью символов #CRLF (возврат каретки, перевод строки).

Во втором случае мы отправляем в Kafka те же данные и используем то же преобразование.

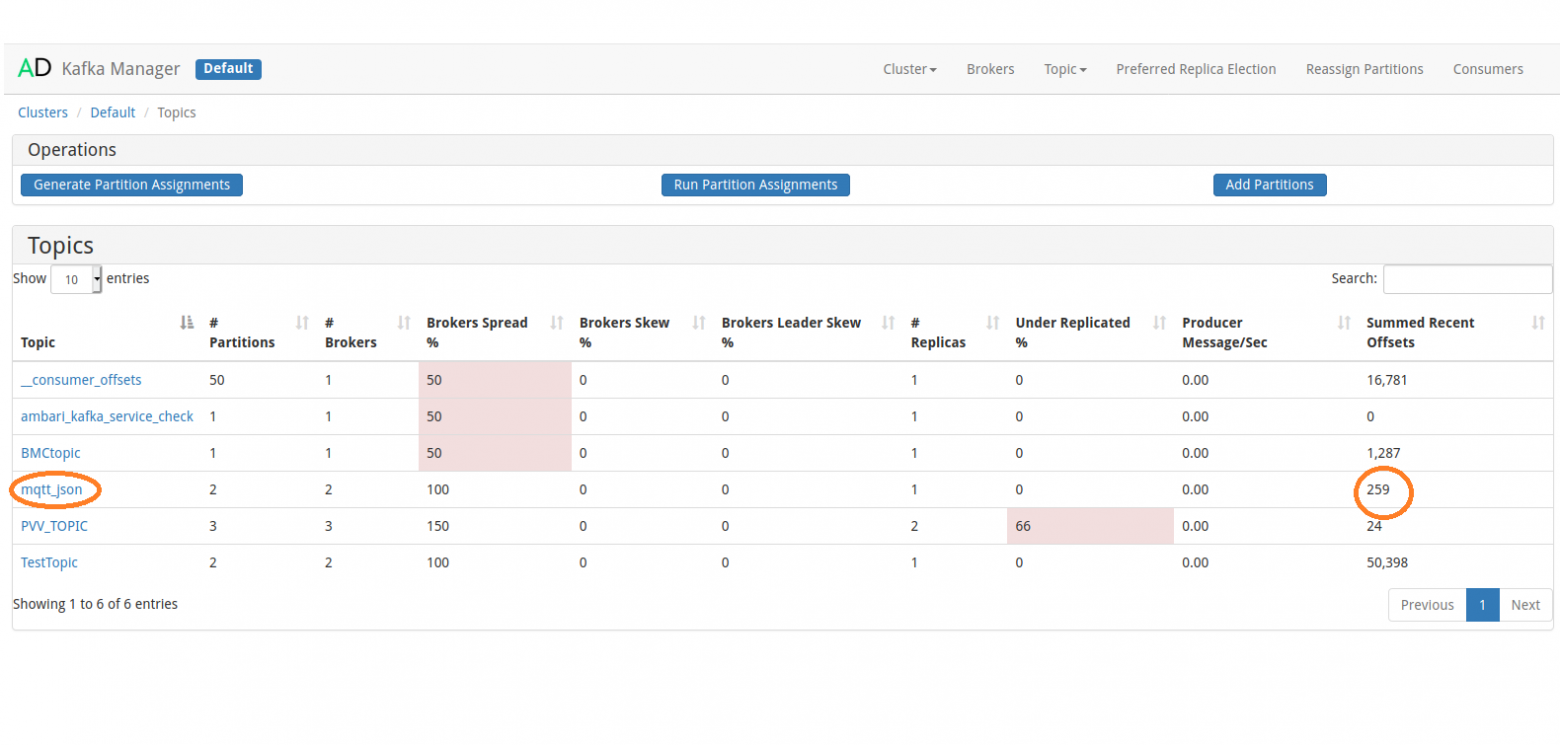

А это интерфейс брокера Kafka с загруженными данными.

Если маршрутизация MQTT-трафика не создает значительной нагрузки, то на сервер Informatica можно установить брокер.

Это позволит удалить лишнее из вычислительной цепочки и сократить задержки обработки данных.

Обратите внимание, что консоль управления Kafka доступна в сборке кластера ArenaData; сборка Hortonworks не имеет веб-интерфейса брокера Kafka. Не забудьте включить данные от датчиков в процессы управления данными.

Если вы работали с платформой Informatica, вы знаете, что она может не только интегрировать данные и оптимально перемещать их между ИТ-системами, но также обеспечивает комплексные процессы управления данными.

В частности, перед отправкой данных из Data Engineering Streaming в хранилище предприятия вы можете проверить их качество на платформе Informatica с помощью Informatica Data Quality. Теги: #iot #Интернет вещей #Хранение данных #Большие данные #Инженерия данных #etl #etl процессы #промышленный интернет вещей #сбор данных #управление данными #tibbo

-

Цифровой Юридический Адрес

19 Oct, 24 -

О Хабрахабре, Статистике И... Облаках Тегов

19 Oct, 24 -

Эмулятор I8080 На Bash

19 Oct, 24