При строительстве центра технической поддержки одного из крупнейших российских технопарков я отвечал за инженерную инфраструктуру.

Объект стал седьмым в России, сертифицированным по стандарту Tier Facility авторитетным международным институтом Uptime Institute. О том, чего нам это стоило, какие решения мы использовали и как проверяли дата-центр на соответствие международным стандартам, я расскажу в этом фотопосте.

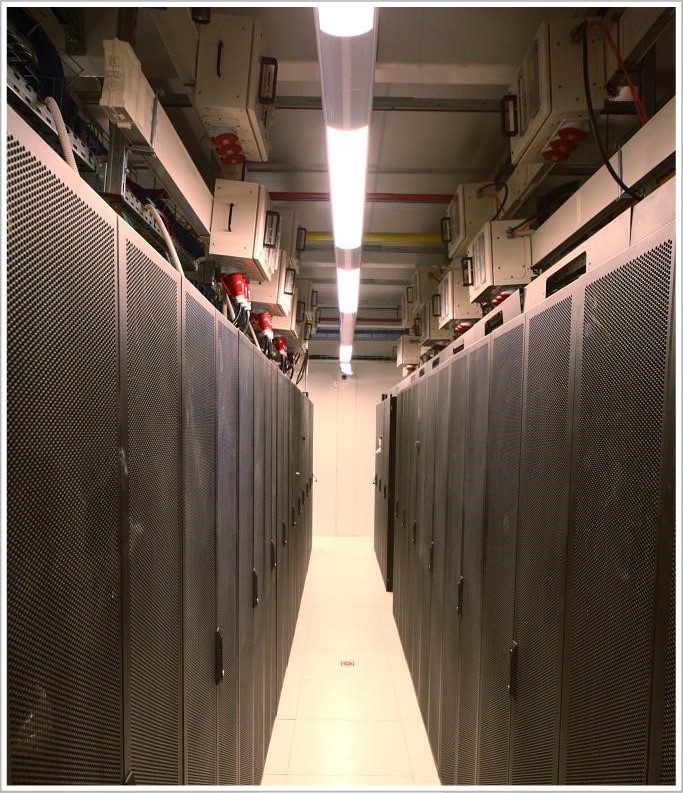

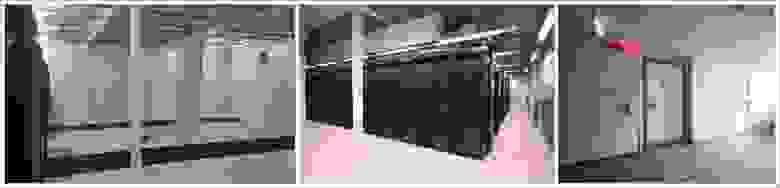

Центр технической поддержки (ЦТП) технопарка «Жигулевская долина» представляет собой двухэтажное здание.

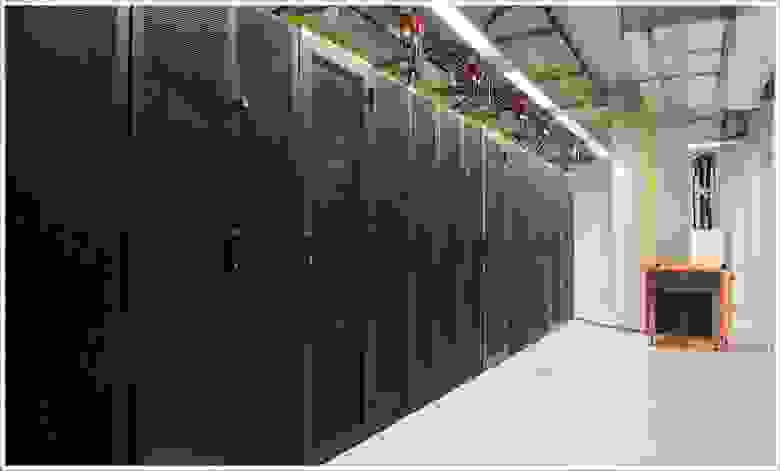

Он включает в себя шесть машинных залов общей площадью 843 квадратных метра.

м и вмещает 326 стоек средней мощностью 7 кВт каждая (максимальная нагрузка на стойку — 20 кВт).

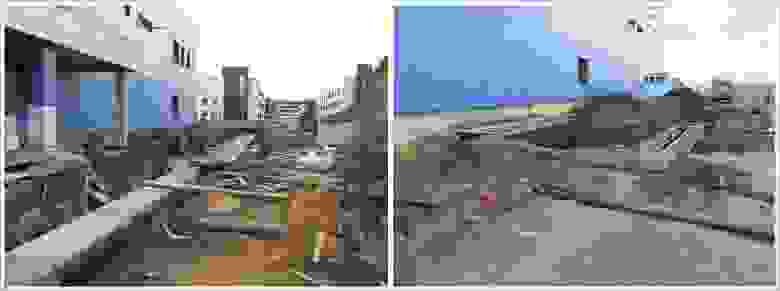

И мы, специалисты компании «ЛАНИТ-Интеграция» , мы впервые увидели это на этапе бетонного каркаса.

В то время здесь не было никаких коммуникаций.

Нам предстояло создать всю инженерную и сетевую инфраструктуру, а также часть вычислительной инфраструктуры для автоматизации инженерных систем.

Для начала я расскажу немного о проекте в целом, а потом покажу всю «начинку».

Так, в центре технической поддержки «Жигулевской долины» необходимо было установить серверы, системы хранения данных и другое оборудование, необходимое жителям инновационного центра Самарской области.

Конечно, такое оборудование требует особых условий эксплуатации: электроснабжения, теплового режима, уровня влажности и т. д., поэтому экономически целесообразно было установить оборудование в одном месте.

Мы осмотрели здание, изучили имеющуюся у заказчика документацию и приступили к разработке проектной документации (которая должна была пройти государственную экспертизу).

Самая большая сложность заключалась в том, что на разработку проектной и рабочей документации нам дали всего три месяца.

Параллельно с рабочей документацией нам нужно было подготовить часть документации на английском языке для прохождения экспертизы международного Uptime Institute.

В рамках проекта нам предстояло:Поскольку плотность инженерных систем в дата-центре очень высока, а сроки сжаты, нам пришлось детально планировать работы, поставки материалов и оборудования.

- сделать дата-центр энергоэффективным;

- построить в короткие сроки;

- сдать экзамен Uptime Institute и получить сертификат Tier III.

Опять же из-за сжатых сроков мы решили использовать высокотехнологичные сборные модульные конструкции – с их помощью мы избежали дополнительных строительных работ, не сделали огнестойкие перегородки и мощную гидроизоляцию.

Такое решение защищает помещение от воды, огня, пыли и других факторов, опасных для ИТ-оборудования, а сборка модульной конструкции занимает всего 1-2 недели.

Изучив проект, приступили к разработке рабочей документации и заказу оборудования.

Кстати, об оборудовании: так как проект попал в кризисный год и возникли трудности с финансированием, пришлось подгонять все работы под финансовый план и прежде всего закупать дорогое крупногабаритное оборудование - цена на него было исправлено производителем.

Изменения в планах поставок техники потребовали еще более тщательного планирования.Команда проекта и менеджеры по закупкам работали в Москве, а основная команда работала непосредственно в технопарке.Чтобы организовать работу 100-150 человек на объекте без простоев, команда проекта уделила большое внимание процедурам управления изменениями и рисками.

Основное внимание уделялось коммуникациям: любая информация о проблемах и задержках практически мгновенно передавалась по всей цепочке от мастеров до руководителя проекта и инженеров в головном офисе компании.

Инженерам не раз приходилось ездить в командировки на объект для уточнения и корректировки проектных решений, а ведь от нашего московского офиса до технопарка почти 1000 км по трассе.

Непосредственно на объекте мы организовали строительный штаб – там проводились регулярные совещания с участием заказчика и руководителей работ, после чего вся обновленная текущая информация передавалась инженерной команде.

Мы набрали большую часть рабочих специальностей в регионе (до 150 человек), а узких специалистов и инженеров пришлось отправить в длительную командировку из Москвы.

В конце концов, все получилось.

Рассказ о главном тесте — сертификации Uptime Institute — я приберег на самый конец.

Теперь посмотрим, как все работает у нас.

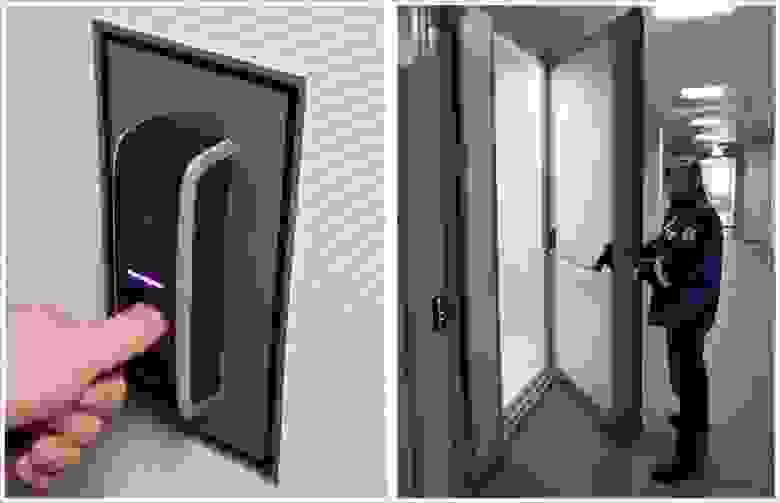

Чтобы попасть в дата-центр, необходимо иметь RFID-пропуск и пройти идентификацию на входе в дата-центр.

Все двери в здании также под контролем; доступ в некоторые помещения действителен только после двойной идентификации сотрудника.

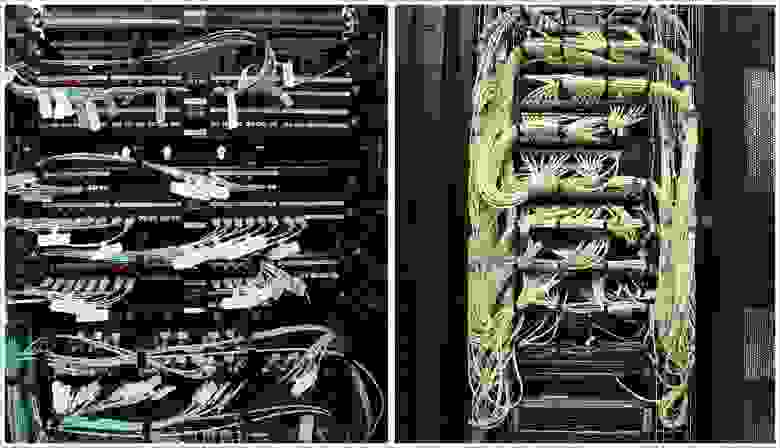

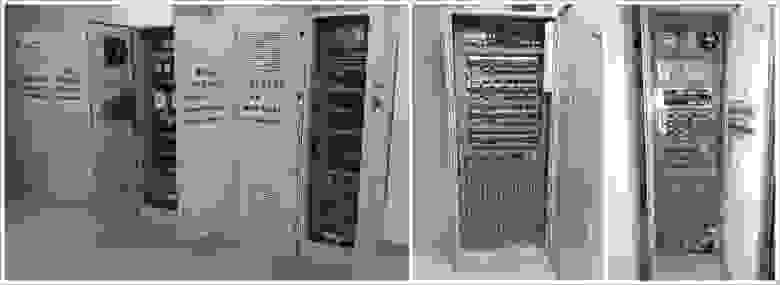

Структурированные кабельные системы

Для сети передачи данных мы использовали коммутаторы HP FlexFabric и Juniper QFabric. Интеллектуальная СКС Panduit с системой управления физической инфраструктурой PanView iQ позволяет удаленно отслеживать и автоматически документировать состояние физического уровня сети, а также интеллектуально управлять полем коммутации.

Есть возможность отслеживать правильность подключения оборудования или нештатное подключение к портам СКС.

Претерминированные кабели позволяют при необходимости изменить конфигурацию СКС в тех участках, где это требуется.

Ээлектроснабжение дата-центра

В собственной трансформаторной подстанции ЦТП установлены 4 независимых трансформатора, которые подают электроэнергию на вводно-распределительные устройства (ВРУ1-4) ЦТП.

Общая выделенная мощность дата-центра составляет 4,7 МВт.

От трансформаторной подстанции в ВРУ ЦОД отходят 8 независимых лучей и через систему гарантированного электроснабжения на базе дизельных роторных источников бесперебойного питания (ДДИУПС) питают 8 ВРУ ЦОД, 4 ВРУ бесперебойного питания и 4 ВРУ гарантированного питания.

.

Система электроснабжения построена по схеме 2Н, кабели входят с двух разных сторон здания дата-центра в два отдельных электрощита.

Схема 2N реализует резервирование источника питания.

Любой силовой луч на техническое обслуживание можно вывести из эксплуатации, при этом дата-центр будет полностью работоспособен.

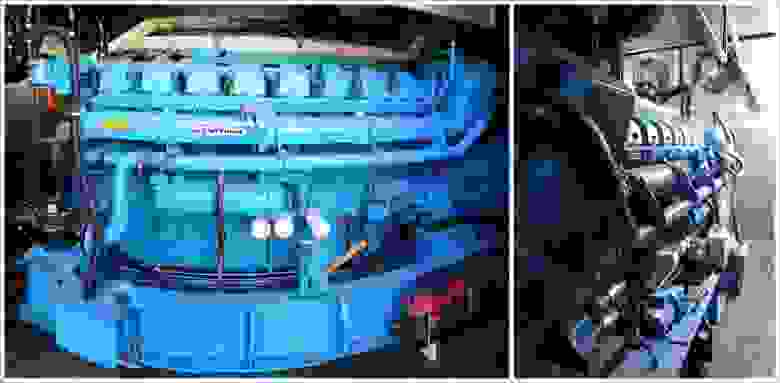

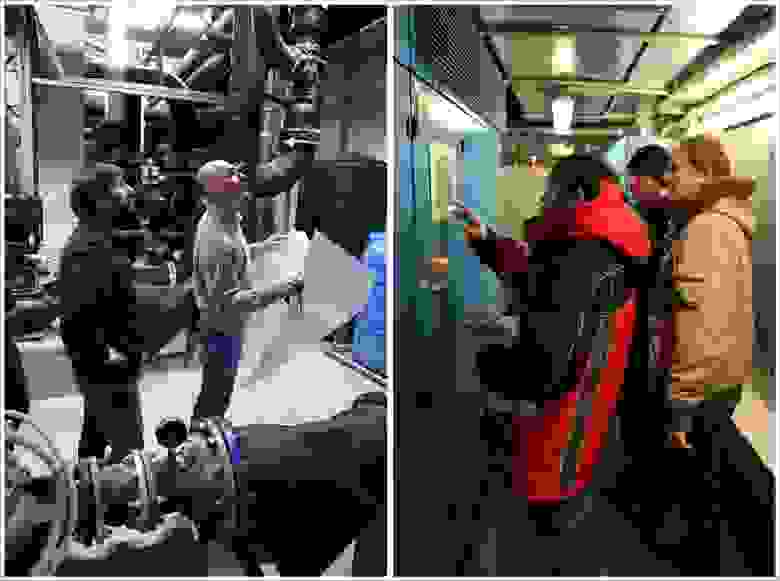

Для бесперебойного и гарантированного электроснабжения мы установили дизель-динамические источники бесперебойного питания Piller. Мощность каждого составляет 1 МВт бесперебойного питания и 650 кВт гарантированной мощности, что позволяет обеспечить полноценную работу дата-центра.

В случае отключения электроэнергии ротор вращается по инерции и электроустановка продолжает вырабатывать ток еще несколько секунд. Этого короткого промежутка времени достаточно, чтобы запустить дизель-генератор и выйти на рабочую скорость.

Таким образом, работа оборудования не прекращается ни на секунду.

Схема строительства N+1. При такой мощности, вырабатываемой за счет электроэнергии, дизель имеет высокий расход топлива – более 350 литров в час, что потребовало дополнительных внешних топливных емкостей объемом более 100 тонн дизельного топлива.

В здании дата-центра имеется два отдельных электрощита.

В каждом имеется по 2 ВРУ систем бесперебойного питания и по 2 ВРУ систем гарантированного электропитания.

Диспетчерская система контролирует состояние всех автоматических выключателей.

Также установлены технологические приборы учета, позволяющие контролировать расход электроэнергии по каждому направлению электроснабжения.

Для обеспечения бесперебойной работы вспомогательных систем установлен шкаф со статическим электронным байпасом.

Система распределения также контролируется диспетчерской системой, каждая линия оснащена устройством учета процесса.

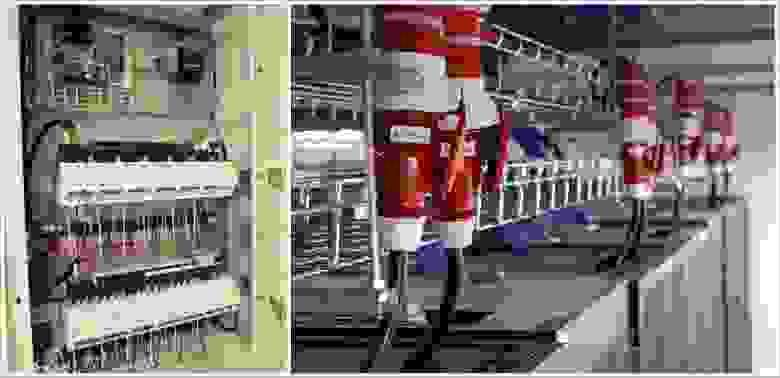

Распределительные шкафы располагаются в небольших залах; От них проходят линии к каждому серверному шкафу, в котором установлены два блока распределения питания.

В больших залах для распределения электропитания использовался шинопровод. В отводных коробках каждый автомат также контролируется системой диспетчеризации, что позволяет постоянно получать полную картину о работе системы электроснабжения ЦОД.

Блоки распределения питания устанавливаются непосредственно в серверные шкафы для распределения электроэнергии.

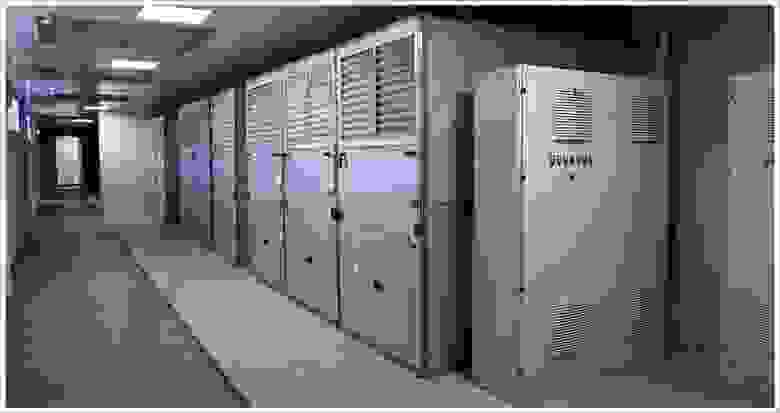

Охлаждение залов

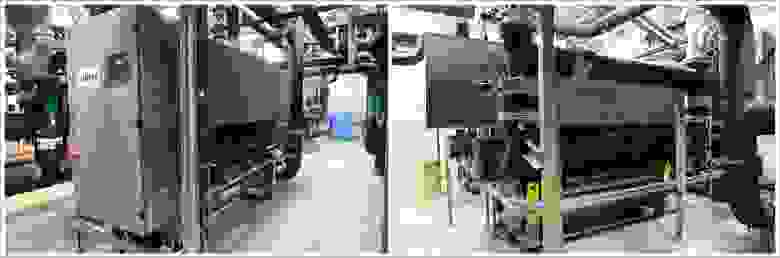

На первом этаже в аппаратно-машинных залах ЦТП охлаждение оборудования осуществляется с помощью внутрирядных прецизионных кондиционеров Emerson (ранее приобретенных заказчиком), а также с помощью водоохладителей и сухих градирен для подготовки холодной воды.

Для охлаждения залов второго этажа (с основной нагрузкой) мы использовали кондиционеры с рекуператором воздух-воздух.

Инновационная система охлаждения от AST Modular, включающая 44 модуля внешнего воздушного охлаждения Natural Free Cooling, развернута в четырех машинных залах на втором этаже.

Система состоит из двух разомкнутых контуров.

В одном из них циркулирует воздух из машинного помещения, а в другом через систему технологической вентиляции подается прохладный воздух с улицы.

Оба потока проходят через рекуперативный теплообменник, в котором происходит обмен тепла между наружным и внутренним воздухом.

Таким образом, оборудование может охлаждаться наружным воздухом до 90% времени года, что позволяет снизить затраты на традиционное активное охлаждение на 20-30% с использованием водоохладителей и сухих градирен.

Летом воздух охлаждается охлажденной водой из чиллеров.

К началу проекта у нас уже был опыт создания подобных систем охлаждения: мы использовали Natural Fresh Aircooling в высокотехнологичном модульном дата-центре «ВымпелКома» в Ярославле.

Но в каждом новом проекте есть свои трудности.

Чтобы связать работу кондиционеров МНФК с приточными установками (подготавливающими уличный воздух и затем подающими его в технический коридор для МНФК), нам пришлось математически просчитать зависимость между объемами подаваемого и выбрасываемого вентустановками воздуха.

для кондиционеров MNFC. Это связано с тем, что объем воздуха, поступающего в технический коридор, не должен превышать определенного предела (чтобы не задушить вентиляторы кондиционера) и в то же время быть достаточным (чтобы воздух в коридоре не стать разреженным).

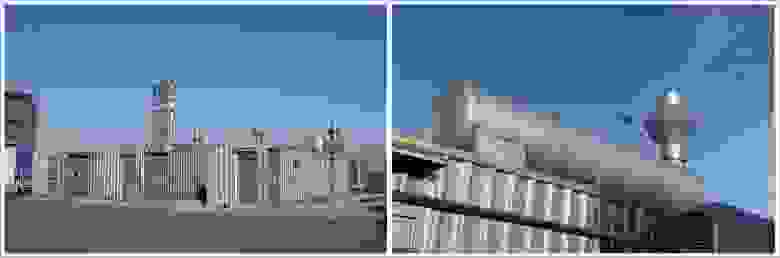

Холодильный центр на первом этаже и оборудование на крыше.

В холодильном центре (ХЦ) разместили чиллеры, насосные группы, теплообменники и т.д.

Водоохладители и сухие охладители используются для подачи холодной воды в установки естественного естественного охлаждения на втором этаже в жаркое время года и в кондиционеры на первом этаже в любое время.

Зимой вода охлаждается через теплообменник в холодильном центре и градирнях на крыше, что также дает возможность не включать чиллеры и экономить электроэнергию.

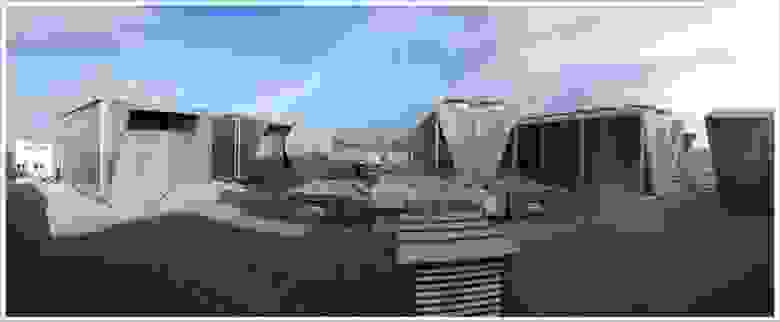

По проекту нам нужно было установить большое количество оборудования на крыше ЦТП, поэтому пришлось практически построить третий этаж в виде стотонного каркаса и установить на нем около 60 тонн оборудования.

: градирни, длина которых достигала 14 м, и мощные вентиляционные установки высотой в человеческий рост.

С градирнями мы, конечно, попотели: попробуйте поднять такую огромную штуку на крышу! Из-за больших габаритов техники пришлось сваривать специальную балку для разгрузки, а также использовать кран грузоподъемностью 160 тонн с большой стрелой, и даже этот кран местами тонул.

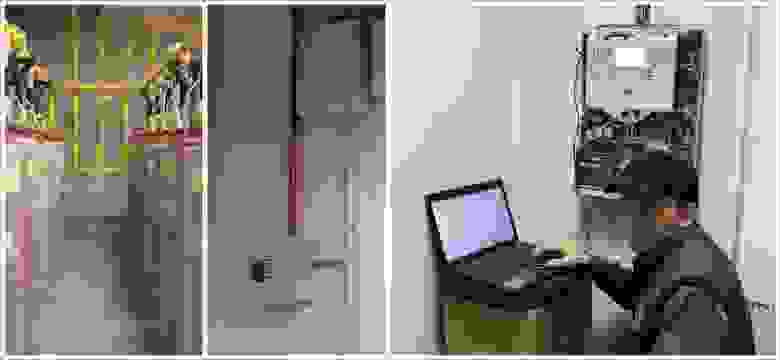

Пожарная безопасность

Для обеспечения пожарной безопасности на объекте развернуты системы пожарной сигнализации, раннего обнаружения пожара (аспирационная система – датчики, анализирующие состав воздуха), автоматического газового пожаротушения и система газоудаления, позволяющая удалять остатки газа после срабатывания системы пожаротушения.был использован.

Система пожарной сигнализации работает следующим образом: датчики пожара в машинных, аппаратных и вспомогательных помещениях выдают соответствующие сигналы на центральную автоматическую станцию пожарной сигнализации, которая, в свою очередь, запускает систему автоматического газового пожаротушения, систему пожарной автоматики и оповещения, в зависимости от пожароопасных зон.

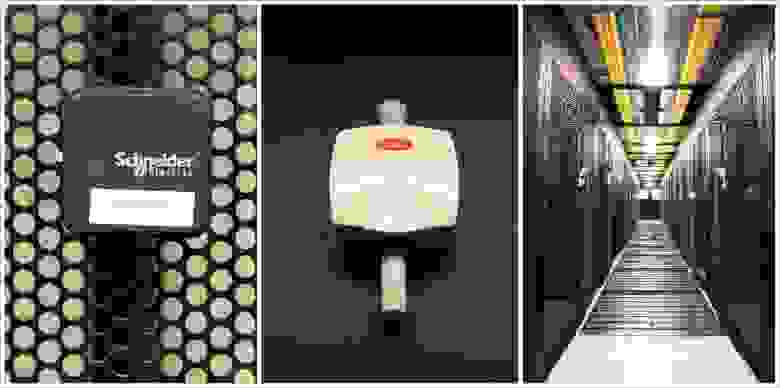

В качестве основного использовалось оборудование ESMI (Schneider Electric).

Он выполнил все задачи по пожарной безопасности и отображается на рабочем месте оператора в диспетчерской.

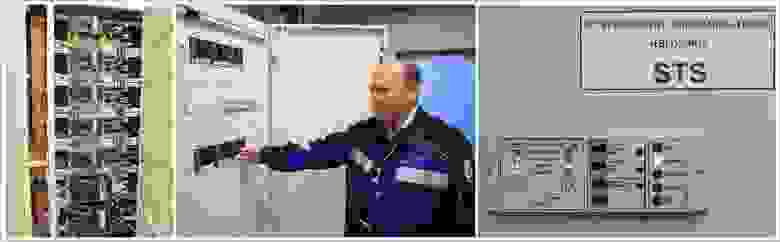

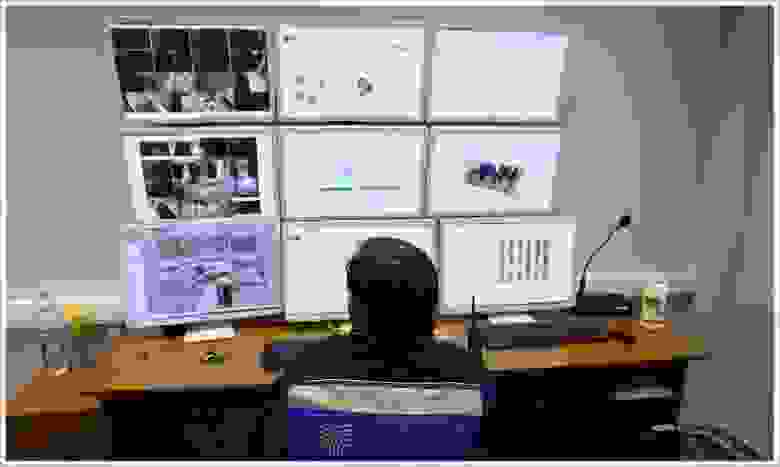

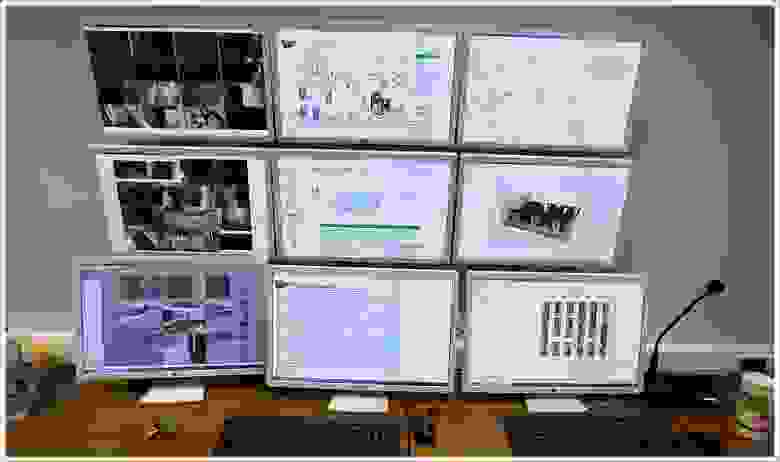

Система автоматизации и диспетчеризации дата-центра

В большинстве дата-центров устанавливается только локальная автоматика с минимальным набором функций мониторинга, но у нас все подсистемы интегрированы в единое техническое решение с общей системой управления.Система управления отслеживает состояние более 10 систем и отображает более 20 тысяч параметров.

Вы хотите знать температуру и влажность в компьютерных залах или вас интересует энергопотребление каждой ИТ-стойки? Без проблем.

В рамках системы мониторинга и диспетчеризации мы использовали как систему SCADA, так и систему мониторинга и управления дата-центром.

Система SCADA (Диспетчерское управление и сбор данных) позволяет просматривать данные и управлять автоматикой установленного оборудования: чиллера, кондиционера, дизель-роторного ИБП, вентиляции, насосов и т.д. Система учета ресурсов дата-центра позволяет вести полный учет всего оборудования, установленного в стойках.

Он отображает аварийные сообщения и данные о состоянии оборудования в режиме реального времени с визуализацией на подробном плане компоновки.

Благодаря детализации мы можем увидеть любое устройство, находящееся в дата-центре.

Система позволяет моделировать нештатные ситуации и дает рекомендации по решению проблем, а также позволяет планировать и оптимизировать работу технических ресурсов дата-центра.

Здесь также осуществляется контроль и управление системами вентиляции (в том числе за температурой подаваемого ими воздуха, поскольку они участвуют в технологическом процессе охлаждения ИТ-оборудования).

Учитываются все параметры кондиционеров, вентиляционных установок и холодильных систем.

Система контролирует и контролирует состояние оборудования (и различных клапанов).

Кроме того, он дополнительно защищает оборудование от критических условий.

Система контролирует состояние всех основных устройств защиты в электрошкафах, а также энергопотребление на этих линиях.

Система позволяет отслеживать установленное оборудование в ИТ-стойках, а также хранить информацию о его принадлежности.

Сюда поступают данные из систем противопожарной защиты и систем безопасности зданий.

Управление зданием осуществляется с помощью решений, построенных на оборудовании Schneider Electric. Автоматизированная система диспетчеризации, контроля и управления инженерными системами предоставляет всю необходимую информацию диспетчеру на его рабочем месте.

Системы связаны между собой через технологический сегмент сети передачи данных.

Программное обеспечение устанавливается на виртуальные машины и обеспечивается резервное копирование данных.

Для обеспечения безопасности, видеонаблюдения и контроля доступа в дата-центре также установлено централизованное решение от Schneider Electric. Он предоставляет необходимую информацию в диспетчерскую систему центра обработки данных.

Все оборудование, о котором я рассказал, собрано в отказоустойчивой конфигурации и размещено в модульных помещениях «Умный Шелтер», которые обеспечивают надежную защиту ЦТП от огня, влаги, вибрации и других внешних воздействий.

Данное решение позволило сократить сроки реализации проекта.

На сборку одной комнаты уходило в среднем две недели.

Сдать экзамен «Огонь, вода и.

Uptime Institute» Для сдачи экзамена на соответствие дата-центра стандартам Tier III Design и Tier III Facility нам пришлось оформить всю документацию в соответствии с требованиями Uptime Institute, пройти его сертификацию, а также установить и запустить все системы с использованием этой документации.

В финале мы прошли тестирование систем дата-центра на соответствие Tier III Facility. А это около 50 тестов!

Подготовка к испытаниям оказалась непростой: хотя сертификационная документация понятна, найти информацию о том, как проходила сертификация самого объекта, было крайне сложно (на тот момент дата-центр «Жигулевская долина» оказался седьмой дата-центр в России, проходящий сертификацию).

Много сил ушло на внутренний аудит (ранее были проведены нагрузочные тесты для заказчика).

Две недели мы проверяли все одно за другим в соответствии с проектной документацией и тестами, полученными от Uptime Institute, и все равно, конечно, нервничали во время сертификации.

Когда специалисты Uptime Institute приехали с проверкой в дата-центр и начали осматривать залы, я сделал для себя важный вывод на будущее — в команде должен быть один лидер, который возьмет на себя общение с «экспертами».

О том, кто станет таким человеком, нужно подумать еще на этапе формирования команды.

Мы пытались сделать именно это, и все же в процессе тестирования некоторые наши сотрудники попытались проявить инициативу.

Представители Uptime Institute, заметив сторонние обсуждения, сразу же задали дополнительные вопросы.

Первый день был ознакомительным: инспектор проверил дата-центр на соответствие проектной документации.

На следующий день для ключевого тестирования Uptime Institute дата-центр должен был быть полностью загружен как по тепловому режиму, так и по энергопотреблению.

Нагрузка имитировалась специально установленными тепловыми пушками мощностью 30-100 кВт.

Для некоторых испытаний оборудование было переведено в критический режим, и были опасения, что системы не выдержат. Чтобы защитить оборудование от возможных последствий (как говорится, Бог бережет), мы пригласили инженеров производителей оборудования.

Один из инспекторов Uptime Institute Фред Дикерман наблюдал за всем происходящим из диспетчерской в режиме реального времени.

Автоматизированная система диспетчерского управления и множество датчиков позволяли следить за текущим состоянием оборудования и изменением температуры в машинных залах.

Результаты сертификации показали, что мы изначально заложили правильные технические решения, все правильно установили и запустили.

По мнению экспертов, этот дата-центр оказался единственным в России, прошедшим тест Uptime Institute без каких-либо замечаний.

Хотите стать частью нашей команды? У нас есть вакансии для вас!

Теги: #Управление проектами #ЦОД #ИТ-инфраструктура #ЦОД #Хранение данных #ланит #ИТ-стандарты #интеграция Ланит

-

Зачем Нужны Чехлы Для Мобильных Телефонов?

19 Oct, 24 -

Apple Внутри Palm

19 Oct, 24 -

Универсальное Зарядное Устройство Usb

19 Oct, 24 -

Интерактивный Пол На Android

19 Oct, 24