Программист Google Клиф Янг объясняет, как взрывной рост алгоритмов глубокого обучения совпадает с провалом закона Мура, эмпирического правила прогресса компьютерных чипов, существующего десятилетиями, и заставляет разрабатывать радикально новые вычислительные схемы.

Бурное развитие алгоритмов искусственного интеллекта и машинного обучения меняет саму природу вычислений, как говорят в одной из крупнейших компаний, практикующих искусственный интеллект, Google. Программист Google Клиф Янг выступил на открытии осенней конференции Linley Group по микропроцессорам, популярного симпозиума по компьютерным чипам, проводимого уважаемой компанией по анализу полупроводников.

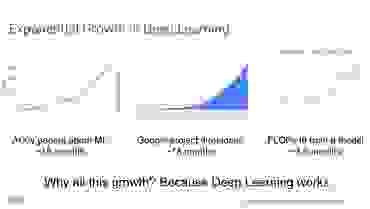

Янг сказал, что использование искусственного интеллекта вступило в «экспоненциальную фазу» в тот же момент, когда закон Мура, действующий десятилетиями эмпирический принцип прогресса компьютерных чипов, полностью остановился.

«Сейчас довольно нервные времена», — задумчиво сказал он.

«Цифровая CMOS замедляется, мы видим проблемы с 10-нм техпроцессом от Intel, мы видим их в 7-нм техпроцессе от GlobalFoundries, и одновременно с развитием глубокого обучения существует экономический спрос».

КМОП, комплементарная структура металл-оксид-полупроводник, является наиболее распространенным материалом, используемым для изготовления компьютерных чипов.

В то время как классические чипы изо всех сил пытаются повысить эффективность и производительность, требования со стороны исследователей искусственного интеллекта растут, отметил Ян.

Он привел некоторые статистические данные: количество научных статей по машинному обучению, хранящихся на сайте препринтов arXiv, поддерживаемом Корнелльским университетом, удваивается каждые 18 месяцев.

По его словам, количество внутренних проектов Google, посвященных искусственному интеллекту, также удваивается каждые 18 месяцев.

Потребность в количестве операций с плавающей запятой, необходимых для обработки нейронных сетей, используемых в машинном обучении, растет еще быстрее — она удваивается каждые три с половиной месяца.

Весь этот рост требований к компьютерным технологиям объединяется в «Суперзакон Мура», сказал Янг, и он назвал это «немного пугающим», «немного опасным» и «есть повод для беспокойства».

«Откуда весь этот экспоненциальный рост» ИИ, спросил он.

«В частности, вся суть в том, что глубокое обучение просто работает. «Я долгое время игнорировал машинное обучение в своей карьере», — сказал он.

«Не было очевидно, что эти штуки смогут летать».

Но затем быстро начали появляться такие прорывы, как распознавание образов, и стало ясно, что глубокое обучение является «невероятно мощным», сказал он.

«На протяжении большей части последних пяти лет мы были компанией, ориентированной на искусственный интеллект, и мы заново изобрели большинство видов бизнеса, связанных с искусственным интеллектом», от поиска до рекламы и многого другого.

По словам Янга, команде Google Brain, ведущего исследовательского проекта в области искусственного интеллекта, нужны «гигантские машины».

Например, нейронные сети иногда измеряются количеством используемых ими «весов», то есть переменных, применяемых к нейронной сети и влияющих на то, как она обрабатывает данные.

И хотя обычные нейронные сети могут содержать сотни тысяч или даже миллионы весов, которые необходимо вычислить, исследователям Google требуются «тера-весы», то есть компьютеры, способные вычислять триллионы весов.

Потому что «каждый раз, когда мы удваиваем размер нейронной сети, мы повышаем ее точность».

Правило развития ИИ — становиться все больше и больше.

В ответ на запросы Google разрабатывает собственную линейку чипов для МО — Tensor Processing Unit. TPU и ему подобные нужны, потому что традиционные CPU и графические чипы GPU не справляются с нагрузками.

«В течение очень долгого времени мы сдерживали себя и говорили, что Intel и Nvidia отлично умеют создавать высокопроизводительные системы», — сказал Янг.

«Но мы пересекли эту черту пять лет назад».

ТПУ вызвал ажиотаж, когда впервые появился на публике в 2017 году, заявив, что он быстрее обычных чипов.

Google уже работает над третьим поколением TPU, использует его в своих проектах и предлагает вычислительную мощность по требованию через сервис Google Cloud. Компания продолжает производить ТПУ все больших и больших размеров.

По словам Яна, в конфигурации «капсулы» 1024 TPU соединены вместе, образуя суперкомпьютер нового типа, и, по словам Яна, Google планирует продолжать расширять систему.

«Мы создаем гигантские мультикомпьютеры с десятками петабайт емкости», — сказал он.

«Мы неустанно продвигаемся вперед на нескольких фронтах одновременно, и операции в терабайтном масштабе продолжают расти».

Подобные проекты поднимают все проблемы, связанные с разработкой суперкомпьютеров.

Например, инженеры Google переняли приемы, использованные в легендарном суперкомпьютере Cray. Они объединили гигантский «блок умножения матриц» — часть чипа, которая несет основную часть вычислительной нагрузки для нейронных сетей, с «векторным блоком общего назначения» и «скалярным блоком общего назначения», как это было сделано в Cray. «Сочетание скалярных и векторных модулей позволило Крею превзойти всех», — сказал он.

Google разработала собственные инновационные арифметические структуры для программирования чипов.

Определенный способ представления действительных чисел, называемый bfloat16, обеспечивает повышенную эффективность обработки чисел в нейронных сетях.

В просторечии это называют «поплавком мозгов».

TPU использует самые быстрые чипы памяти, память с высокой пропускной способностью или HBM (память с высокой пропускной способностью).

Он сказал, что спрос на большие объемы памяти для обучения нейронных сетей быстро растет. «Во время тренировок память используется более интенсивно.

Говорят о сотнях миллионов весов, но есть и проблемы при обработке активации переменных нейронной сети.

Google также корректирует способ программирования нейронных сетей, чтобы максимально эффективно использовать свое оборудование.

«Мы работаем над параллелизмом данных и моделей» с такими проектами, как Mesh TensorFlow, адаптацией программной платформы TensorFlow, которая «объединяет данные и параллелизм в масштабе модуля».

Янг не раскрыл некоторые технические подробности.

Он отметил, что компания не говорила о внутренних соединениях, о том, как данные перемещаются по чипу — он просто отметил, что «наши разъемы гигантские».

Он отказался распространяться на эту тему, что вызвало смех в зале.

Янг указал на еще более интересные области вычислений, которые вскоре могут открыться нам.

Например, он предположил, что важную роль могут сыграть вычисления с использованием аналоговых микросхем — схем, которые обрабатывают входные данные как непрерывные значения вместо нулей и единиц.

«Возможно, мы обратимся к аналоговой области; в физике есть много интересного, связанного с аналоговыми компьютерами и NVM-памятью».

Он также выразил надежду на успех представленных на конференции стартапов, связанных с чипами: «Здесь есть несколько действительно крутых стартапов, и нам нужно их запустить, потому что возможности цифровых КМОП не безграничны; Я хочу, чтобы все эти инвестиции работали».

Теги: #Машинное обучение #Google #искусственный интеллект #нейронные сети #ТПУ #ТПУ

-

Может Ли Природа Быть Неестественной?

19 Oct, 24 -

Встреча Codenet 2010

19 Oct, 24 -

Сервис Сбора Статистики С Помощью Flussonic

19 Oct, 24 -

Каждому По-Своему

19 Oct, 24 -

Проблемы С Пользовательскими Поддоменами

19 Oct, 24