Разработчики из Google Brain доказали, что «конфликтующие» изображения могут обмануть как людей, так и компьютеры; и возможные последствия пугают.

На картинке выше, несомненно, слева изображен кот. Но можете ли вы сказать наверняка, кот ли это справа или просто собака, похожая на него? Разница между ними в том, что правильное делается с помощью специального алгоритма, который не позволяет компьютерным моделям, называемым «сверточными нейронными сетями» (CNN, convolutional нейронная сеть, далее CNN), однозначно сделать вывод о том, что изображено на картинке.

В данном случае в соцсетях считают, что это скорее собака, чем кошка, но что самое интересное, большинство людей думают так же.

Это пример того, что называется «картиной противоречия» (далее КарП): она специально изменена таким образом, чтобы обмануть СНС и не дать ей правильно определить контент. Исследователи из Google Brain хотели посмотреть, можно ли таким же образом обмануть биологические нейронные сети в нашей голове, и в итоге создали варианты, которые одинаково влияют как на машины, так и на людей, заставляя их думать, что они смотрят на то, что смотрят. в.

не совсем.

Что такое «спорные изображения»?

Практически повсеместно для распознавания в CNN используются алгоритмы визуальной классификации.«Показывая» программе большое количество различных иллюстраций с пандами, вы можете обучить ее распознавать панд, поскольку она учится посредством сравнения, чтобы выявить общий признак для всего представленного множества.

Как только SNS (также называемая "классификаторы" ) соберет на обучающих данных достаточный массив «признаков панды», тогда она сможет распознавать панду на любых новых картинках, которые ей будут предоставлены.

Мы узнаем панд по абстрактным характеристикам: маленькие черные уши, большие белые головы, черные глаза, мех и все такое.

СНС делает все по-другому, и это неудивительно, поскольку объем информации об окружающей среде, которую люди интерпретируют каждую минуту, гораздо больше.

Поэтому, учитывая специфику моделей, можно воздействовать на изображения таким образом, чтобы сделать их «противоречивыми», смешивая их с тщательно рассчитанными данными, после чего результат будет выглядеть для человека почти как оригинал, но совершенно отличается от классификатор , который начнет выдавать ошибки при попытке определить содержимое.

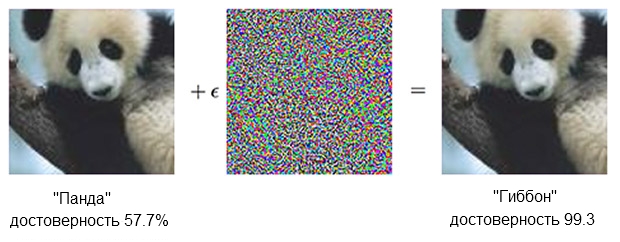

Вот пример с пандой:

Изображение панды в сочетании с беспокойством может убедить классификатора в том, что это на самом деле гиббон.

Источник: ОпенАИ Классификатор Судя по СНС, я уверен, что панда слева, около 60%.

Но если вы слегка дополните («возмутите») источник, добавив что-то, похожее на просто хаотический шум, тот же классификатор будет на 99,3 процента уверен, что сейчас он смотрит на гиббона.

Небольшие изменения, которые даже невозможно четко увидеть, порождают очень успешную атаку, но она сработает только на конкретной модели компьютера и не осуществит те, которые можно было бы «обучить» на чем-то другом.

Чтобы создать контент, вызывающий неправильную реакцию у большого и разнообразного числа искусственных аналитиков, нужно действовать грубее — малейшие корректировки не окажут влияния.

То, что работает надежно, невозможно сделать «малыми средствами».

Другими словами, если вы хотите получить контент, работающий под любым углом и расстоянием, вам придется вмешаться более существенно или, как сказал бы человек, более очевидно.

В поле зрения есть мужчина

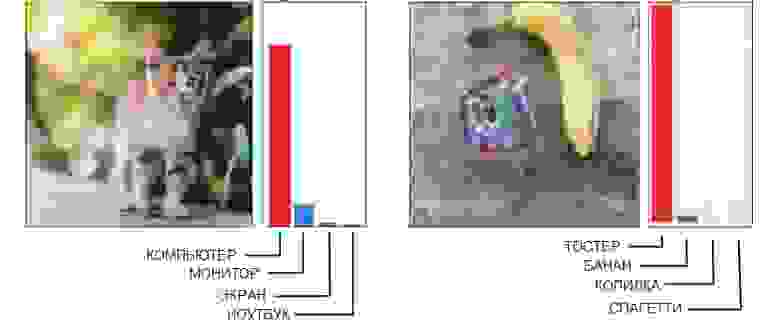

Вот два примера грубых КарП, где человек легко может обнаружить помехи.

Источник: Открытый ИИ слева, Google Brain справа

Фотография кота слева, которую CNN идентифицирует как компьютер, сделана с использованием «сломанной геометрии».

Если присмотреться (или даже не слишком близко), то можно увидеть несколько угловатых и коробчатых конструкций, которые могут напоминать очертания системного блока.

А изображение банана справа, по которому распознается тостер, стабильно дает ложное срабатывание с любой точки зрения.

Люди тут же найдут банан, но странная штуковина рядом с ним имеет какие-то признаки тостера — и это обманывает технологию.

Когда ты делаешь гарантированно подходящий «противоречивый» образ, который нужно обыграть целую компанию моделей узнаваемости, то очень часто это приводит к появлению «человеческого фактора».

Другими словами, то, что сбивает с толку одну нейронную сеть, может вообще не восприниматься человеком как проблема, а при попытке получить ребус, явно подходящий для обмана сразу пяти или десяти, оказывается, что он работает на основе механизмов, которые в случае с людьми совершенно бесполезны.

В результате совершенно не нужно пытаться заставить человека думать, что угловатый кот — это компьютерный корпус, а сумма банана и странной мазни похожа на тостер.

Гораздо лучше при создании CarP, предназначенных для нас с вами, сразу сосредоточиться на использовании моделей, воспринимающих мир так же, как это делают люди.

Обман глаз (и мозга)

CNN глубокого обучения и человеческое зрение в чем-то схожи, но по сути нейронная сеть «смотрит» на вещи «как компьютер».Например, когда ей дают картинку, она «видит» статическую сетку прямоугольных пикселей одновременно.

Глаз работает иначе: человек воспринимает высокую детализацию в секторе примерно пяти градусов в каждую сторону от луча зрения, но за пределами этой зоны внимание к деталям снижается линейно.

Таким образом, в отличие, скажем, от машины, размытие краев изображения на человеке не подействует и просто останется незамеченным.

Исследователи смогли смоделировать эту особенность, добавив «слой сетчатки», который изменял данные, предоставляемые CNN, так, как они выглядели глазу, с целью ограничить нейронную сеть той же структурой, в которой работает нормальное зрение.

Следует отметить, что человек справляется со своими недостатками восприятия тем, что его взгляд не направлен в одну точку, а постоянно движется, рассматривая изображение в целом, но компенсировать это оказалось возможным за счет условия эксперимента, нивелирующие различия между СНС и людьми.

Примечание из самой работы: Каждое испытание начиналось с того, что в центре экрана на 500–1000 миллисекунд отображалось позиционирующее перекрестие, и каждому испытуемому предлагалось зафиксироваться на перекрестии.

Использование «слоя сетчатки» стало последним шагом, который пришлось сделать в рамках «тонкой настройки» машинного обучения под «человеческие особенности».

При генерации семплов прогоняли десять разных моделей, каждая из которых должна была однозначно называть, скажем, кошку, например, собаку.

Если результат был «10 из 10 ошибочны», то материал передавали на тестирование на людях.

Это работает?

В эксперименте участвовали три группы картинок: «домашние животные» (кошки и собаки), «овощи» (кабачки и брокколи) и «угрозы» (пауки и змеи, хотя я как змеевладелец предложил бы для оценки другой термин).В каждой группе успех засчитывался, если испытуемый делал неправильный выбор — называл собаку кошкой и наоборот. Участники сидели перед монитором, на котором в течение 60–70 миллисекунд отображалось изображение, и должны были нажать одну из двух кнопок, изображающих объект. Поскольку изображение было показано лишь на короткое время, оно сгладило разницу между тем, как люди и нейронные сети воспринимают мир; Иллюстрация в заголовке, кстати, поражает упорством ошибки.

Испытуемым показывалось немодифицированное изображение (изображение), «обычный» CarP (adv), «перевернутый» CarP, в котором шум перед применением был перевернут вверх дном, или «ложный» CarP, в котором слой с шумом было применено к изображению, не принадлежащему ни одному из типов в группе (ложь).

Последние два варианта использовались для контроля характера возмущения (оказывала бы структура шума в инвертированном виде иной эффект или просто «да или нет»?), плюс позволяли понять, действительно ли шум полностью обманывает людей или просто немного снижает точность.

Примечание из самой работы: «ложь»: условие добавлено для того, чтобы заставить испытуемого совершить ошибку.

Мы добавили его потому, что если первоначальные изменения снижают точность наблюдателя, то это может быть связано с ухудшением непосредственного качества изображения.

Чтобы показать, что CarP действительно работают в каждом классе, мы ввели варианты, в которых ни один выбор не мог быть правильным и, соответственно, их точность была равна 0, и наблюдали, какой именно «правильный» ответ был в этом случае.

Мы показывали произвольные картинки из ImageNet, к которым было применено влияние того или иного класса группы, но которые не вписывались ни в один.

Участник эксперимента должен был определить, что находится перед ним.

Например, мы могли показать изображение самолета, искаженное добавлением «собачьего» шума, хотя в ходе эксперимента испытуемый должен был узнавать только кошку или собаку.

Вот пример, показывающий процент людей, которые смогли четко идентифицировать на картинке собаку, в зависимости от того, как использовался шум.

Напомню, на то, чтобы посмотреть и принять решение, было всего 60-70 миллисекунд.

Источник: Google Brain

Оригинальная картинка с собакой; CarP с собакой, которую и человек, и компьютер принимают за кошку; эталонное изображение с перевернутым слоем шума.

И вот окончательные результаты:

Источник: Google Brain

Результаты исследования показывают, насколько точно люди идентифицируют реальные картинки по сравнению с искаженными.

На диаграмме показана точность совпадения.

Если вы выберете кошку и это действительно кошка, точность увеличится.

Если выбрать кошку, а на самом деле это собака, преобразованная шумом в подобие кошки, точность снижается.

Как видите, люди гораздо более корректны в выборке неисправленных изображений или с инвертированными слоями шума, чем в «несогласованной» выборке.

Это доказывает, что принцип атаки на восприятие можно перенести с компьютеров на нас.

Эффекты не только, несомненно, эффективны, но и более тонкие, чем ожидалось - никаких коробочных кошек, псевдотостеров или чего-то в этом роде.

Поскольку мы видели и слои шума, и изображения до и после обработки, нам нужно разобраться, что именно нас в этом смущает. Хотя исследователи осторожны, заявляя, что «наши примеры специально созданы для того, чтобы обмануть людей, поэтому стоит быть осторожными, используя людей в качестве подопытных для изучения эффекта».

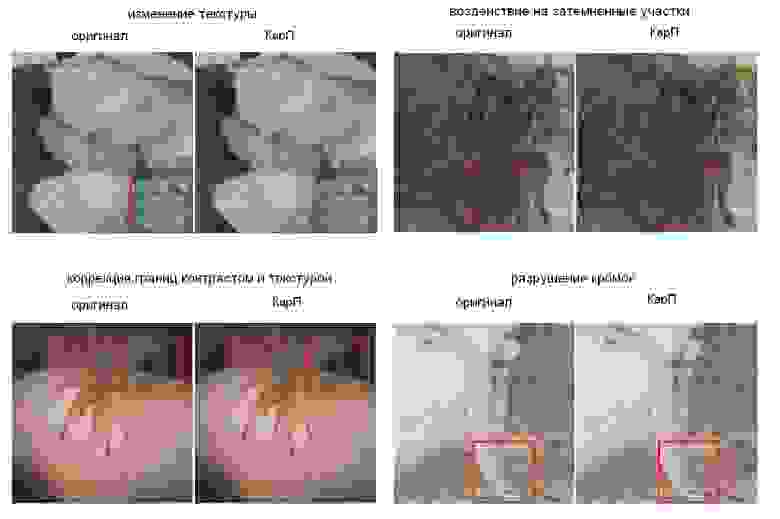

В будущем команда попытается вывести некоторые общие правила для определенных категорий модификаций, в том числе « разрушение краев объекта , особенно при умеренных ударах, перпендикулярных линии края; корректировка приграничных территорий за счет увеличения контраста при текстурировании границы; изменение текстуры ; использование темных частей изображения , при котором уровень воздействия на восприятие высок даже несмотря на малейшие возмущения».

Ниже показаны примеры, где красным выделены области, в которых лучше всего видны описываемые методы.

Источник: Google Brain

Примеры картинок с разными принципами искажения

Каков конечный результат?

Дело в том, что это нечто большее, гораздо больше, чем просто хитрый трюк.Ребята из Google Brain подтвердили, что могут создать эффективную методику обмана восприятия, но не до конца понимают, почему она работает, учитывая уровень абстракции, и не исключено, что это буквально базовый уровень реальности.

:

Наш проект ставит фундаментальные вопросы о том, как работают CarP, как работают нейронные сети и мозг.Наконец, если вы действительно хотите стать немного параноиком, исследователи будут рады оказать вам услугу, указав, что «визуальное распознавание объектов.Можно ли было перенести атаки с CNN на мозг, поскольку семантические представления информации в них схожи? Или потому, что обе эти идеи соответствуют некоторой общей смысловой модели, естественно существующей в окружающем нас мире?

трудно оценить объективно.

Является ли «Рисунок 1» объективно собакой или объективно кошкой, которая может заставить людей думать, что она собакаЭ» Другими словами, действительно ли картинка превращается в объект или просто заставляет думать по-другому? Самое жуткое здесь (и я серьезно говорю «жуткие») в том, что в итоге можно получить способы влияния на любые факты, ведь дистанция между манипулированием соцсетями и манипулированием человеком явно не слишком велика.

Соответственно, технологии машинного обучения потенциально могут быть использованы для искажения картинок или видео нужным образом, что заменит наше восприятие (и соответствующую реакцию), и мы даже не поймем, что произошло.

Из отчета:

Например, кластер моделей глубокого обучения можно обучить на оценках людьми уровня доверия к определенным типам лиц, чертам лица и выражениям.Конечно, такие методы можно использовать и «во благо», и уже предложен ряд вариантов, таких как «уточнение характерных особенностей изображений с целью повышения уровня концентрации внимания, например, при наблюдении за воздушной обстановкой».Можно будет генерировать «противоречивые» волнения, которые будут увеличивать или уменьшать ощущение «подлинности», и такие «подправленные» материалы можно будет использовать в новостных роликах или политической рекламе.

Заглядывая в будущее, теоретические риски включают в себя возможность создания сенсорных стимуляций, которые взламывают мозг множеством способов и с очень высокой эффективностью.

Как известно, многие животные оказались уязвимы к надпороговой стимуляции.

Например, птенцы кукушки могут одновременно притворяться беспомощными и издавать жалобный крик, что в совокупности заставляет птиц других пород кормить птенцов кукушки раньше собственного потомства.

«Конфликтные» выборки можно рассматривать как уникальную форму надпороговой стимуляции нейронных сетей.

И вызывает большую тревогу то, что чрезмерные стимулы, которые теоретически окажут на человека гораздо более сильное воздействие, чем просто заставить его пометить «это кот» на фотографии собаки, могут быть созданы машиной, а затем переданы людям.

.

или анализ рентгеновских снимков, так как эта работа монотонна и последствия невнимательности могут быть ужасными».

Кроме того, «дизайнеры пользовательских интерфейсов могут использовать пертурбации для разработки более интуитивно понятных интерфейсов».

Хм.

Это определенно круто, но меня больше беспокоит вся эта штука со взломом моего мозга и раскрытием моего уровня доверия людям, понимаешь? Некоторые из поставленных вопросов станут предметом будущих исследований — возможно, станет ясно, что именно делает конкретные картинки более подходящими для передачи человеку ошибки, и это может дать новые ключи к разгадке принципов работы мозга.

А это, в свою очередь, поможет создать более совершенные нейронные сети, которые будут обучаться быстрее и лучше.

Но нам следует быть осторожными и помнить, что, как и компьютеры, нас иногда не так уж сложно обмануть.

Проект " Состязательные примеры, обманывающие как человеческое, так и компьютерное зрение , авторы Гамалельдин Ф.

Эльсайед, Шрея Шанкар, Брайан Чунг, Николас Паперно, Алекс Куракин, Ян Гудфеллоу и Яша Сол-Дикштейн, из Google Brain. , можно скачать с arXiv .

А если вам нужны более противоречивые картинки, действующие на людей, то вспомогательный материал здесь .

Теги: #Популярная наука #искусственный интеллект #ИИ #нейронные сети #мозг #распознавание образов #ИИ #Google Brain

-

Что Такое Сублимационные Чернила?

19 Oct, 24 -

Новые «Фишки» Последней Картинки Dev-Build 1

19 Oct, 24 -

Подкаст Unclesoky – Эпизод №13

19 Oct, 24 -

Атака Банкомата С Помощью Raspberry Pi

19 Oct, 24