Привет, Хабр! В этом году исполняется 10 лет со дня нашего первого Дата-центр ОСТ-1 .

За это время мы с коллегами из службы эксплуатации и капитального строительства успели провести не одну модернизацию инженерной инфраструктуры дата-центра.

Сегодня я расскажу вам о самых интересных случаях.

200-тонный кран устанавливает на раму новый чиллер Stulz. Модернизация системы холодоснабжения системы ЦОД ОСТ-1 в 2015 году.

Дата-центр — это живой организм, он растет, меняется, ломается :) Все, что можно отнести к модернизации, я условно делю на:

- плановые замены и ремонты.

Оборудование морально устаревает и истекает срок его службы.

Мы бюджетируем, планируем и выполняем такие работы без спешки, когда нам удобно (например, полная модернизация «внутренностей» ИБП или замена отслуживших свой срок аккумуляторов).

- ошибки проектирования .

По заветам Uptime, всё должно потребляться и заканчиваться одновременно.

Из-за неправильного проектирования баланс «холод – электричество – пространство» может быть нарушен, например: есть куда поставить стеллажи, но в зале уже нет ни электричества, ни кондиционера.

Самое неприятное в этих ошибках то, что они появляются не сразу, а когда дата-центр выходит на проектную мощность.

- несчастные случаи.

Бывает, что оборудование выходит из строя полностью, безвозвратно и неожиданно, и его необходимо заменить.

Почти все, что там находится, находится под нашим контролем.

Расскажу три истории об ошибках проектирования и послеаварийной модернизации.

История 1. В машинном зале не хватало холода

Это история об одном из наших первых залов на Боровой.Он все еще работает. Зал проектной мощностью 80 стоек по 5 кВт. По мере заполнения зала холода перестало хватать: температура в холодных коридорах была выше необходимой, постоянно происходили локальные перегревания.

И только потом, с высоты нашего опыта, мы поняли, что допустили ошибки в проектировании, и из-за этого пострадал кондиционер.

| Ошибка | Проблема |

| Длинный ряд стоек – более 20 в ряд. | Горячий воздух застоялся в середине ряда |

| Низкие потолки – до 3 метров.

|

Недостаточно места для полноценного воздухообмена.

Появились локальные зоны перегрева |

| Низкий фальшпол со множеством коммуникаций под ним | Нарушение циркуляции холодного воздуха под фальшполом |

Ряд настолько длинный, что кондиционеры на противоположном конце едва видны.

Фото 2009 года.

Никакой «волшебной таблетки» от этих проблем мы тогда не увидели, поэтому решили действовать поэтапно и по всем фронтам.

Сначала мы проверили, все ли оборудование установлен правильно и есть ли заглушки в бесплатных модулях.

Также мы перепроверили укладку перфорированной плитки и удалили лишнюю, установив под фальшполом дополнительные воздуховоды.

Мы постарались найти и заделать все отверстия, куда мог выходить холодный воздух.

Советую вам также проверить, что находится между вашим кондиционером и стеной.

Зазор в 5-7 см – это уже много.

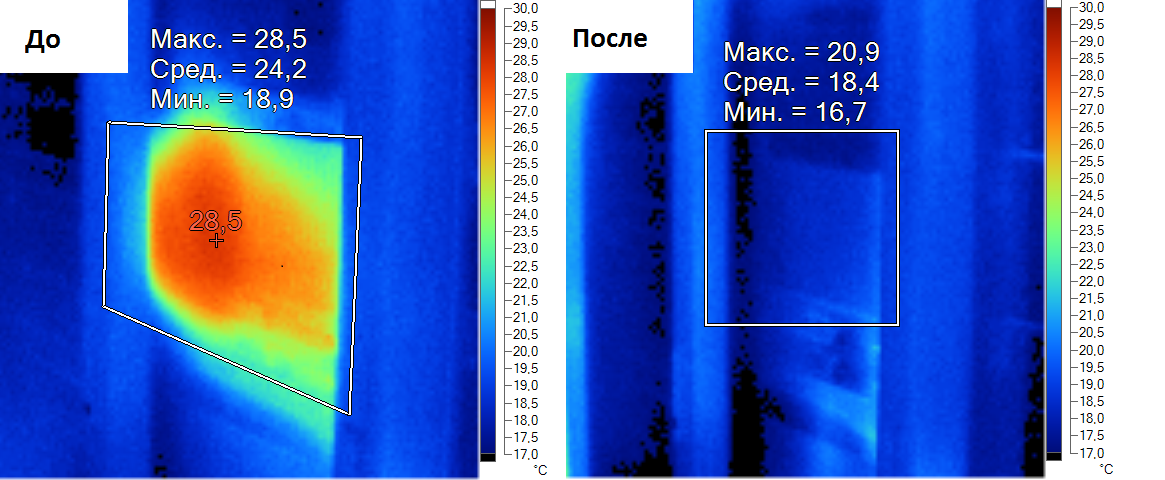

Вот результат, который мы получили, просто разместив заглушки в свободных модулях.

Стало лучше, но недостаточно хорошо.

Тогда мы решили изолировать холодные коридоры.

Мы построили крышу и двери из поликарбоната.

Вышло дешево и сердито.

В результате мы избавились от паразитного смешивания горячего и холодного воздуха и повысили эффективность холодильной системы.

Изолированный холодный коридор той же комнаты.

Мы понимали, что это не продлится долго.

По мере роста ИТ-нагрузки нехватка мощностей снова даст о себе знать.

Эту проблему пытались решить установкой фреонового кондиционера, хотя в зале было гликолевое охлаждение.

Нас очень волновали габариты кондиционера (пролезет ли он в дверь, достаточен ли угол поворота), поэтому выбрали модель с возможностью частичной разборки.

Кондиционер установили не со стороны горячего коридора, как это обычно делают, а там, где его можно было втиснуть.

Это добавило нам 80 киловатт охлаждения.

Вот тот самый «гутаперчевый» кондиционер Emerson.

Вся эта история оказалась непростой: нужно было придумать, как подключить фреоновые магистрали к внешним блокам, как подать электроэнергию на эти кондиционеры, где разместить внешние блоки кондиционирования.

Все это в рабочем зале.

Просто чтобы понять, как мало места.

После всех этих манипуляций мы избавились от локального перегрева, температура распределилась равномерно в холодном и горячем коридорах.

Удалось увеличить мощность зала и разместить в нем заявленные пятикиловаттные стойки.

Мораль этой истории в том, что не нужно бояться делать маленькие шаги для решения проблемы.

Само по себе каждое из действий может показаться (и нам тогда казалось) неэффективным, но в совокупности оно дает результат.

История 2. В машинном зале отключились кондиционер и электроснабжение.

Для клиента был спроектирован компьютерный зал на 100 стоек по 5 кВт. Конструктивная ширина стеллажа 800 мм, в каждом ряду по 10 стоек.

Потом клиент передумал заселяться, и зал был сдан в аренду на общих основаниях.

В реальной жизни стойки шириной 800 мм нужны в основном для сетевого оборудования; для всего остального нужны стойки шириной 600 мм.

В результате вместо 10 стоек подряд у нас получилось 13, и место еще оставалось.

Но электричества и холода уже было недостаточно.

В ходе модернизации было выделено новое помещение для двух дополнительных ИБП по 300 кВт.

В зале появились дополнительные распределительные щиты.

Новую власть нужно было распределить равномерно.

Для разделения новых и старых балок под фальшполом проложили отдельные кабельные лотки.

Часть действующего ИТ-оборудования была переведена на новые распределительные щиты путем последовательного включения каждого луча мощности.

Для решения проблемы нехватки холода установили 1 дополнительный кондиционер мощностью 100 кВт холода.

Во время такелажа, монтажа и пуско-наладки всего оборудования зал продолжал работать в штатном режиме.

Это был самый сложный момент в проекте.

В результате модернизации мы добавили электрическую и холодовую комнату еще на 30 стоек по 5 кВт.

Проектная мощность и мощность зала увеличены на 30%.

История 3. О замене чиллеров

Немного предыстории.Все началось в 2010 году, когда 3 чиллера дата-центра ОСТ сильно пострадал во время урагана.

Тогда, чтобы выжить, нам пришлось несколько дней эксплуатировать чиллеры без защиты, и компрессоры быстро вышли из строя.

Сначала они их поменяли.

Нагрузка на ИТ росла по мере заполнения центра обработки данных, а чиллеры Emicon так и не достигли заявленной охлаждающей способности.

В 2012 году в том же гидравлическом контуре был установлен дополнительный чиллер Hiref. Так мы прожили еще три года.

Со временем чиллеры Emicon столкнулись с увеличением эксплуатационных проблем.

Их мощности было недостаточно, поэтому в жару приходилось поливать их водой от Керхерс.

С годами теплообменники зарастали известковыми отложениями.

Зазор между теплообменником естественного охлаждения и фреоновым конденсатором был заполнен тополиным пухом и другим мусором, который невозможно было удалить из-за специфического строения теплообменников.

Там образовался настоящий валенок, который не пропускал воздух нормально.

В 2015 году мы только что приобрели партию чиллеров Stulz для НОРД-4 .

Для этой цели мы решили заменить два из трёх чиллеров Emicon. Теперь подробности.

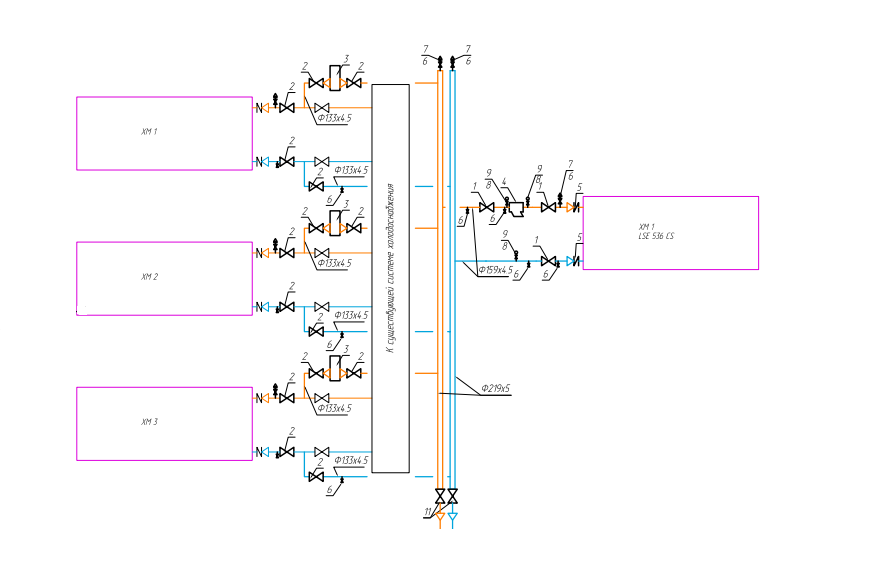

Установка дополнительного чиллера Hiref без установки дополнительного насоса.

Нагрузка на ИТ росла, а эффективность поврежденных во время урагана чиллеров падала.

Летом резерва едва хватало.

Мы решили добавить еще один чиллер, чтобы увеличить их общую мощность.

В ходе работ холодильная система должна была продолжать функционировать.

Самое сложное в этой операции – организация гликолевого контура.

Мы сделали гликолевую петлю: гликолевое кольцо было переведено от каждого чиллера к новому чиллеру.

Чиллеры выводили из эксплуатации один за другим, а к новому охладителю подключали гликолевую трубку.

Фрагмент гидравлической схемы.

На нем видно, что от каждого из трех чиллеров были сделаны ответвления к новому чиллеру.

Основная задача этого чиллера – поддержка холодильной системы в летнее время.

Благодаря Hiref у нас теперь есть гарантированный резерв N+1 в жаркие месяцы.

Но поврежденные во время урагана чиллеры начали медленно изнашиваться, и пришлось задуматься об их замене.

Тот самый «летний» чиллер Hiref. Замена Эмикона на Штульц.

Такие замены лучше делать осенью или весной: летом без запаса совсем страшно, а зимой проводить работы просто неприятно.

Операция была запланирована на февраль/март, но подготовка началась в октябре.

За эти подготовительные месяцы мы проложили новые кабели, сварили участки трубопровода, разработали план подъезда автомобиля с оборудованием (у нас во дворе тесно), расчистили площадку для подъезда крана.

Чиллеры пришлось менять в работающем дата-центре, и около 1,5 дней он оставался без резервного чиллера.

На этапе подготовки мы проводили тесты, чтобы понять, как будет себя чувствовать дата-центр без резервного копирования, придумывали различные ситуации, когда во время работы что-то могло пойти не так (например, длительное отключение электроэнергии при замене чиллеров), и разработали план действий.

Вот краткая хроника этих работ. Холодильник прибыл вечером того же дня.

После того как кран успешно въехал в дата-центр, можно было приступать к отключению старого чиллера.

Старый чиллер все еще стоит на месте, пока ведутся подготовительные работы.

Готовим каркас для нового чиллера.

Затем к месту проведения работ пришлось подъехать машине с рефрижератором.

Там, мягко говоря, тесновато.

Мне пришлось изрядно потрудиться, чтобы вписаться во все эти сложные повороты в ограниченном пространстве.

Чиллер, разобранный и распиленный пополам, был демонтирован.

Старый и новый чиллер различаются по размеру.

Еще немного времени ушло на подготовку металлического каркаса.

Осталось только поднять и установить чиллер.

На заднем плане фото видно, что параллельно варятся участки гликолевого контура нового чиллера.

После установки вся гидравлика монтируется на раму, и чиллер подключается к электросети.

Опрессовка проводится ночью.

На следующий день происходит пуско-наладка и подключение к системе мониторинга.

Вся операция заняла менее двух дней: утром старый чиллер отключили, в конце следующего дня включили новый чиллер.

Через две недели был заменен второй чиллер.

Казалось бы, все должно было просто сделать по проверенной схеме, но что-то пошло не так.

Всю ночь шел снег.

Сначала нам пришлось потратить время на расчистку территории, чтобы кран мог заехать.

Мы приступили к демонтажу старого чиллера, когда в двухстах метрах от нас сломалась машина с новым чиллером.

Точка невозврата уже пройдена, и у грузовика сломался механизм поворота колес прицепа (его панель управления).

Отремонтировать его на месте не удалось; мы пошли за дополнительным пультом, который чудесным образом оказался в офисе этой компании в субботу.

С помощью пульта я смог завести машину.

В итоге на один поворот у нас ушло более 3 часов.

Несмотря на все логистические сложности, работы продолжались до ночи.

Хорошо, что мы подумали об освещении для работы в темное время суток.

Остальные работы шли в обычном режиме, и в понедельник в дата-центре заработал еще один новый чиллер.

В марте этого года мои коллеги заменили третий чиллер, последний, уцелевший после урагана.

Сейчас на Боровой работают три чиллера Stulz и один Hiref. Благодаря такой постепенной модернизации мы теперь имеем большой запас на случай холодов, нам не страшна самая жаркая погода и тополиный пух.

Новые чиллеры поддерживают естественное охлаждение в более широком диапазоне температур, потребляют меньше энергии и работают очень тихо.

Также их очень удобно обслуживать за счет отдельных компрессорных отсеков: ремонтные работы можно проводить без полной остановки чиллера.

Теги: #Управление проектом #ЦОД #ИТ-инфраструктура #ЦОД #ЦОД #модернизация #DataLine #инженерная инфраструктура #чиллеры #энергоснабжение #линии передачи данных #машинное помещение #линия данных #хладоснабжение #линия данных #линия данных #линия данных

-

Восстановление Мертвых Mbr И Таблиц Разделов

19 Oct, 24 -

Чпу. Очевидное — Невероятное

19 Oct, 24 -

О Тестировании Веб-Приложений

19 Oct, 24 -

Превентивный Ядерный Удар

19 Oct, 24