Недавно мы решили выйти за рамки сегмента бюджетных серверов: пересмотреть свое видение хостинга виртуальных машин и создать максимально отказоустойчивый сервис.

В этой статье я расскажу вам, как устроена наша стандартная VPS-платформа и какие приемы мы использовали для ее улучшения.

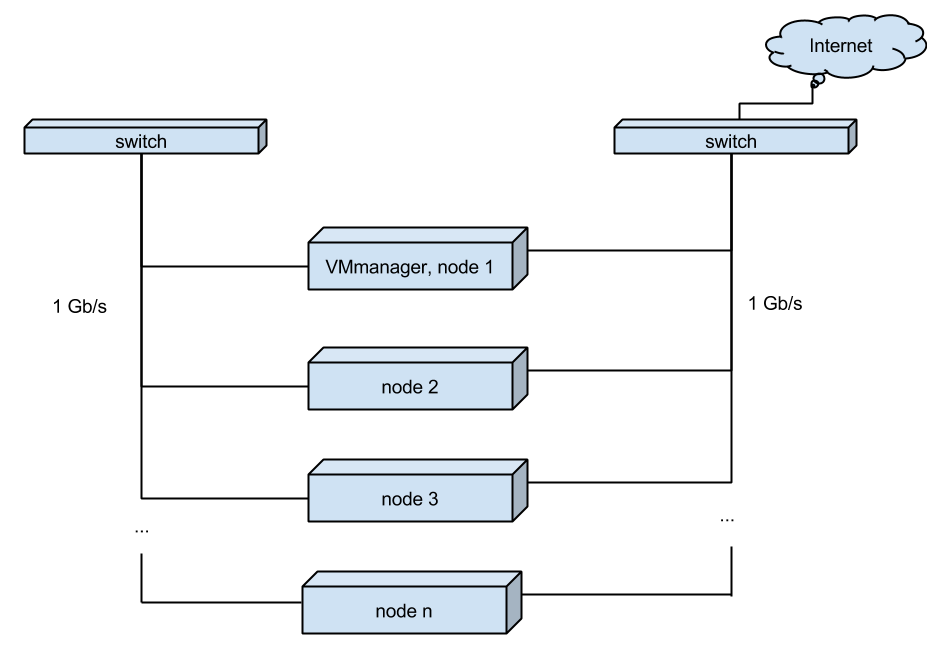

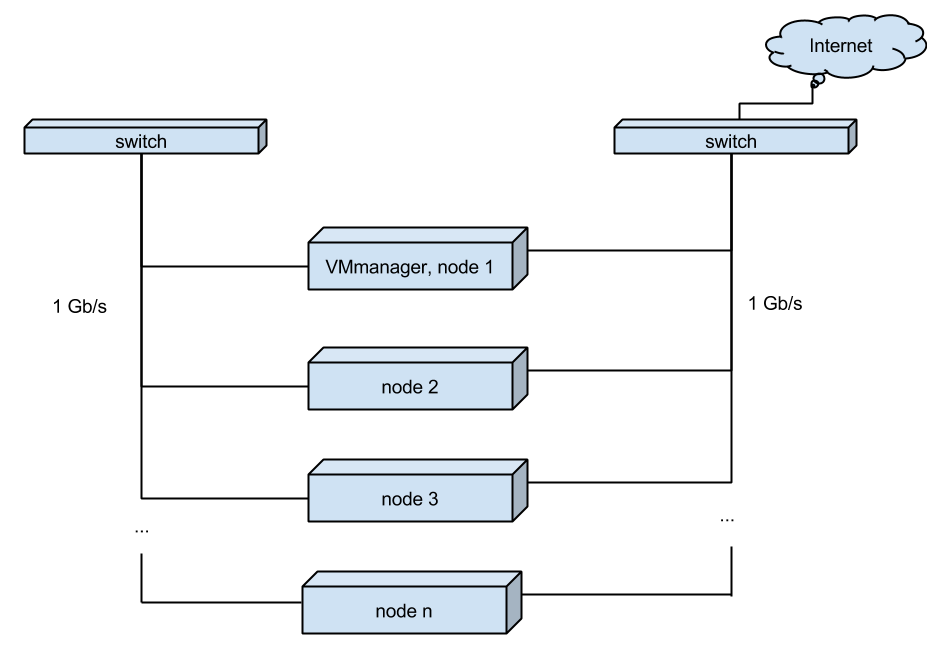

Наша стандартная технология создания VDS Сейчас наш хостинг виртуальных серверов выглядит так: В стойках размещены одноюнитовые серверы примерно следующей конфигурации:

- Процессор — 2 процессора Intel Xeon E5-2630 v2 @ 2,60 ГГц

- Материнская плата: Intel Corporation S2600JF

- Оперативная память: 64 ГБ

- ДИСК: 2 x HGST HDN724040ALE640/4000 ГБ, INTEL SSDSC2BP480G4 480 ГБ

На нем установлен VMmanager и к нему подключены узлы — дополнительные серверы.

Помимо VMmanager, на основном сервере располагаются клиентские виртуальные серверы.

Каждый сервер «смотрит» на мир через свой сетевой интерфейс.

А для увеличения скорости миграции VDS между узлами серверы соединяются между собой отдельными интерфейсами.

(Рис.

1. Текущая схема размещения виртуального сервера) Все серверы работают независимо друг от друга, и в случае проблем с производительностью на одном из серверов все виртуальные серверы можно разделить (функция «Миграция» в VMmanager) на соседние узлы, либо перенести на вновь добавленный узел.

Ситуации, когда сервер выходит из строя (паника ядра, вышедшие из строя диски, отключенный блок питания и т. д.), приводят к недоступности клиентских виртуальных машин.

Разумеется, система мониторинга сразу же оповещает о проблеме ответственных специалистов, и они начинают определять причины и устранять аварию.

В 90% случаев замена вышедших из строя компонентов занимает не более часа, плюс время требуется на устранение последствий аварийного отключения сервера (синхронизация системы хранения, ошибки файловой системы и т.п.

).

Все это, конечно, неприятно для нас и наших клиентов, но простая схема позволяет избежать ненужных расходов и удерживать цены на низком уровне.

Новое облачное VDS Чтобы удовлетворить самых требовательных клиентов, для которых важна работоспособность сервера, мы создали сервис с максимально возможной надежностью.

Итак, нам понадобилось новое программное обеспечение и оборудование.

Так как мы уже работаем с продукцией компании ISPсистема , логичным шагом было присмотреться к VMmanager-Cloud. Эта панель создана специально для решения проблемы отказоустойчивости; на данный момент оно хорошо развито и достигло определенной стабильности.

Нас это устроило и альтернативы мы не рассматривали.

Безоговорочно принята в качестве распределенной файловой системы.

Цеф .

Он бесплатный, свободно развивающийся, гибкий и масштабируемый.

Мы пробовали другие системы хранения, но Ceph оказался единственным продуктом, который полностью удовлетворял нашим требованиям к хранению.

Поначалу это казалось сложным, но после некоторых попыток мы наконец разобрались.

И они не пожалели об этом.

Узлы нового кластера собраны на том же оборудовании, что и рабочий кластер VMmanager, но с небольшими изменениями: Мы перешли на мультиноды с резервированием питания.

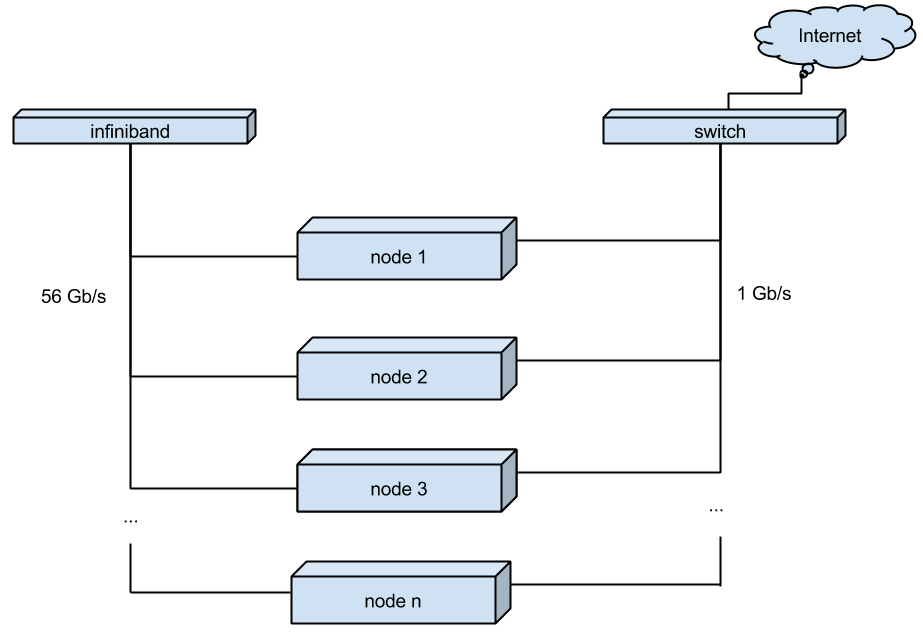

Для переключения между узлами кластера вместо обычного гигабитного соединения мы использовали Infiniband. Позволяет увеличить скорость соединения до 56Gb (IB-карты Mellanox Technologies MT27500 Family ConnectX-3, коммутатор - Mellanox SX6012)

В качестве операционной системы для узлов кластера был выбран дистрибутив CentOS 7. Однако, чтобы все вышеперечисленное работало вместе, мне пришлось собрать собственное ядро, пересобрать qemu и запросить некоторые модификации в VMmanager-Cloud.

(Рис.

2. Новая схема облачного хостинга виртуальных серверов) Преимущества использования новой технологии В результате мы получили следующее:

- еще более профессиональная услуга виртуального сервера с высоким временем безотказной работы.

Его стабильность не зависит от проблем с аппаратной частью узлов кластера.

- повышение надежности хранения данных за счет распределенной файловой системы с хранением нескольких копий.

- быстрая миграция виртуальных машин.

Перенос работающего VPS с узла на узел происходит практически мгновенно без потери пакетов и пингов.

При необходимости это быстро освобождает агрегат для обслуживания.

- При сбое узла клиентские виртуальные машины автоматически запускаются на других узлах.

Для клиента это выглядит как внеплановая перезагрузка; время простоя равно времени перезагрузки ОС.

ситуации.

Пока мы продолжаем тестирование, экономисты подсчитывают стоимость.

За счет дополнительного резервирования и использования более дорогих технологий оно получилось выше, чем у предыдущего кластера.

Мы учли это и разрабатываем новый тариф для самых требовательных клиентов.

Остается ряд рисков, которые мы никак не можем закрыть, это электроснабжение дата-центра и внешние каналы связи.

Для решения подобных задач обычно создаются географически распределенные геокластеры; возможно, это будет одно из наших следующих исследований.

Если вас интересуют технические подробности реализации описанной выше технологии, мы готовы поделиться ими в комментариях или сделать отдельную статью по итогам обсуждения.

Теги: #ceph #kvm #centos #облачное хранилище #QEMU #vps #облачный хостинг #ispsystem #vmmanager #infiniband

-

Как Писать Веб-Контент, Который Продает

19 Oct, 24 -

Демокрит

19 Oct, 24 -

Устройство Измерения Co2

19 Oct, 24 -

Рэш, Реализация Fpga

19 Oct, 24 -

Свежий Воздух 2.0

19 Oct, 24