Тема отказоустойчивости систем хранения данных всегда актуальна, поскольку в наш век повсеместной виртуализации и консолидации ресурсов системы хранения являются тем звеном, выход из строя которого приведет не просто к обычной аварии, а к длительному простою сервисов.

Поэтому современные системы хранения содержат множество дублированных компонентов (даже контроллеров).

Но достаточна ли такая защита?

Абсолютно все производители, перечисляя характеристики систем хранения, всегда упоминают высокую отказоустойчивость своих решений, всегда добавляя термин «без единой точки отказа».

Давайте подробнее рассмотрим типичную систему хранения.

Чтобы избежать простоев в обслуживании, в СХД дублируются блоки питания, модули охлаждения, порты ввода-вывода, накопители (имеется в виду RAID) и, конечно же, контроллеры.

Если внимательно присмотреться к этой архитектуре, то можно заметить как минимум две потенциальные точки отказа, о которых скромно умалчивают:

- Наличие одной объединительной платы

- Наличие одной копии данных

И поэтому крайне редки случаи, когда он полностью выходит из строя.

Однако даже в случае частичных проблем, например, неработающего слота накопителя, потребуется его замена с полным отключением СХД.

Создание нескольких копий данных также не является проблемой на первый взгляд. Например, достаточно широко распространен функционал «Клонирование» в системах хранения, позволяющий обновлять полную копию данных через определенные промежутки времени.

Однако в случае проблем с тем же бэкплеем копия будет так же недоступна, как и оригинал.

Совершенно очевидным решением для преодоления этих недостатков является репликация на другую систему хранения.

Если закрыть глаза на ожидаемое удвоение стоимости оборудования (мы все равно предполагаем, что люди, выбирающие такое решение, мыслят адекватно и принимают этот факт заранее), все равно возможны затраты на организацию репликации в виде лицензий, дополнительных программное и аппаратное обеспечение.

И самое главное, вам нужно будет как-то обеспечить согласованность реплицируемых данных.

Те.

построить виртуализатор хранения/vSAN/и т. д., что также требует денежных и временных ресурсов.

AccelStor Создавая наши системы High Availability, мы ставили цель избавиться от вышеперечисленных недостатков.

Так появилась трактовка технологии Shared Nothing, которая в вольном переводе означает «без использования общих устройств».

Концепция Ничего общего архитектура представляет собой использование двух независимых узлов (контроллеров), каждый из которых имеет свой набор данных.

Синхронная репликация происходит между узлами через интерфейс InfiniBand 56G, полностью прозрачная для программного обеспечения, работающего поверх системы хранения.

В результате использование виртуализаторов хранения, программных агентов и т. д. не требуется.

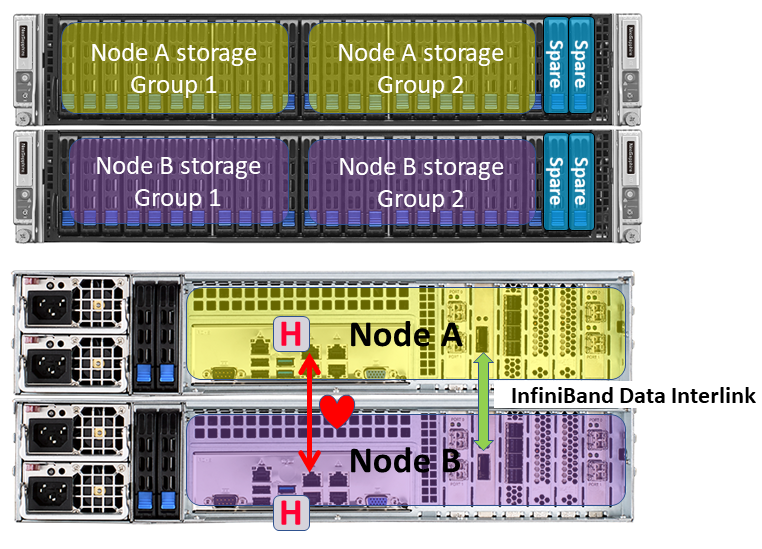

Физически двухузловое решение от AccelStor можно реализовать в двух моделях:

- H510 — на базе серверов Twin в корпусе 2U, если требуется умеренная производительность и емкость до 22 ТБ;

- H710 — на базе отдельных серверов высотой 2U, если требуется высокая производительность и большая емкость (до 57 ТБ).

Модель H510 на базе сервера Twin

Модель H710 на базе отдельных серверов Использование разных форм-факторов обусловлено необходимостью разного количества твердотельных накопителей для достижения заданного объема и производительности.

Плюс платформа Twin дешевле и позволяет предлагать более доступные решения, хотя и с некоторым условным «недостатком» в виде единой объединительной платы.

Все остальное, включая принципы работы, у обеих моделей полностью идентично.

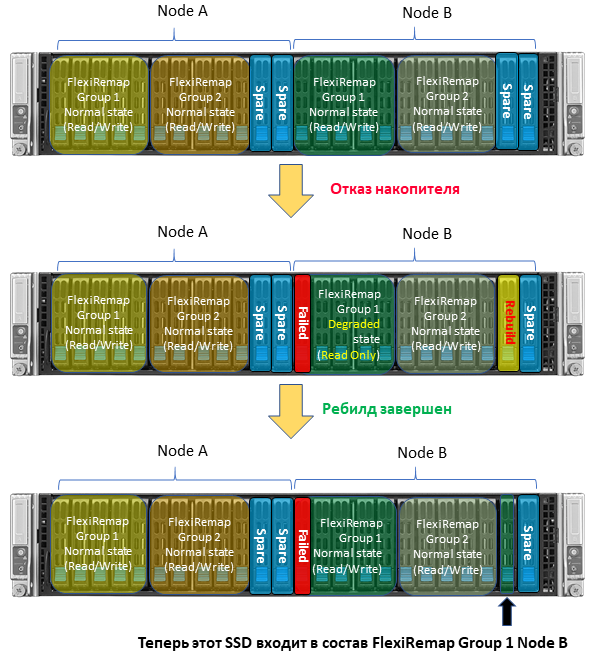

Набор данных для каждого узла состоит из двух групп.

FlexiRemap , плюс 2 «горячих» резерва.

Каждая группа способна выдержать выход из строя одного SSD. Все входящие запросы на запись узла в соответствии с идеология FlexiRemap перестраивает блоки размером 4КБ в последовательные цепочки, которые затем записываются на SSD в наиболее комфортном для них режиме (последовательная запись).

При этом хост получает подтверждение записи только после физического размещения данных на SSD, т.е.

без кэширования в оперативной памяти.

Результатом является очень впечатляющая производительность: до 600 000 операций ввода-вывода в секунду при записи и более 1 миллиона операций ввода-вывода в секунду при чтении (модель H710).

Как упоминалось ранее, наборы данных синхронизируются в режиме реального времени через интерфейс InfiniBand 56G, который имеет высокую пропускную способность и низкую задержку.

Для того, чтобы максимально эффективно использовать канал связи при передаче небольших пакетов.

Т.

к.

канал связи только один; выделенный канал 1GbE используется для дополнительной проверки сердечного ритма.

Через него передается только сердцебиение, поэтому требований к скоростным характеристикам нет. В случае увеличения емкости системы (до 400+ТБ) за счет полки расширения они также соединены попарно для соблюдения концепции «отсутствия единой точки отказа».

Для дополнительной защиты данных (помимо того, что у AccelStor уже есть две копии) используется специальный алгоритм поведения в случае выхода из строя любого SSD. В случае сбоя SSD узел начнет восстановление данных на одном из дисков горячего резерва.

Группа FlexiRemap, находящаяся в ухудшенном состоянии, перейдет в режим только для чтения.

Это сделано для устранения помех между операциями записи и восстановления на резервном диске, что в конечном итоге ускоряет процесс восстановления и сокращает время, в течение которого система потенциально уязвима.

По завершении перестроения узел возвращается в обычный режим чтения-записи.

Конечно, как и у других систем, при пересборке общая производительность падает (ведь одна из групп FlexiRemap не работает на запись).

Но сам процесс восстановления происходит максимально быстро, что отличает системы AccelStor от решений других вендоров.

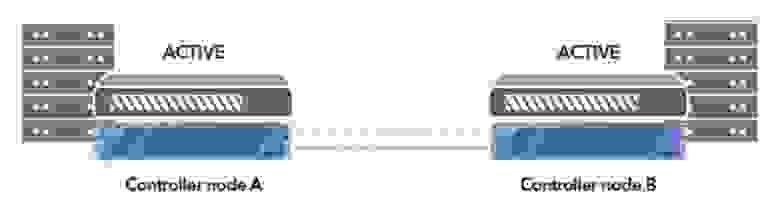

Еще одним полезным свойством технологии архитектуры Nothing Shared является работа узлов в так называемом истинном активно-активном режиме.

В отличие от «классической» архитектуры, где только один контроллер владеет определенным томом/пулом, а второй просто выполняет операции ввода-вывода, в системах AccelStor каждый узел работает со своим набором данных и не передает запросы своему «соседу».

В результате повышается общая производительность системы за счет параллельной обработки запросов ввода-вывода узлами и доступа к накопителям.

Такого понятия, как аварийное переключение, также практически не существует, поскольку в случае сбоя передавать управление томами на другой узел просто нет необходимости.

Если сравнивать технологию архитектуры Nothing Shared с полноценным дублированием СХД, то, на первый взгляд, она будет немного уступать полной реализации аварийного восстановления по гибкости.

Особенно это актуально для организации линии связи между системами хранения.

Так, в модели H710 возможно разнесение узлов на расстояние до 100м за счет использования не очень дешевых активных оптических кабелей InfiniBand. Но даже если сравнивать с обычной реализацией синхронной репликации других вендоров через доступный FibreChannel, то даже на больших расстояниях решение от AccelStor будет дешевле и проще в установке/эксплуатации, поскольку нет необходимости устанавливать виртуализаторы хранения и/или интегрироваться с ПО (что не всегда возможно в принципе).

Плюс не стоит забывать, что решения AccelStor — это All Flash-массивы с производительностью выше, чем у «классических» СХД только с SSD.

При использовании архитектуры AccelStor Nothing Shared можно достичь доступности системы хранения на уровне 99,9999% при очень разумной цене.Теги: #Хранение данных #Виртуализация #ИТ-инфраструктура #Системы хранения #Системы хранения данных #SAN #Accelstor #Accelstor #Accelstor #Accelstor #Accelstor #AccelstorНаряду с высокой надежностью решения, в том числе за счет использования двух копий данных, и впечатляющей производительностью благодаря фирменным алгоритмам.

FlexiRemap , решения из AccelStor являются отличными кандидатами на ключевые позиции при построении современного дата-центра.

-

Интернет-Безопасность: Почему Это Важно

19 Oct, 24 -

(Дополненная) Реальность Имитирует Искусство

19 Oct, 24 -

Мультисенсорные Дисплеи - Видеоинструкции

19 Oct, 24