Введение

Современные системы распознавания ограничены классификацией на относительно небольшое количество семантически не связанных между собой классов.Привлечение текстовой информации, даже не связанной с картинками, позволяет обогатить модель и в некоторой степени решить следующие проблемы:

- если модель распознавания допускает ошибку, то зачастую эта ошибка не является семантически близкой к правильному классу;

- невозможно предсказать объект, принадлежащий новому классу, который не был представлен в наборе обучающих данных.

В результате модель делает меньше прогнозов, которые семантически далеки от истинного класса.

Более того, модель, учитывая как визуальную, так и семантическую близость, может правильно классифицировать изображения, принадлежащие к классу, который не был представлен в обучающем наборе данных.

Алгоритм.

Архитектура

- Мы предварительно обучаем языковую модель, которая дает хорошие семантически значимые вложения.

Размерность пространства равна n. Далее n будем принимать равным 500 или 1000.

- Мы предварительно обучаем визуальную модель, которая хорошо классифицирует объекты по 1000 классам.

- Мы отсекаем последний слой softmax от предварительно обученной визуальной модели и добавляем полносвязный слой с 4096 на n нейронами.

Мы обучаем полученную модель прогнозированию встраивания, соответствующего метке изображения для каждого изображения.

Пусть LM — языковая модель, VM — визуальная модель с отрезанным softmax и добавленным полносвязным слоем, I — изображение, L — метка изображения, LM(L) — метка, встраиваемая в семантическое пространство.

Затем на третьем этапе мы обучаем виртуальную машину так, чтобы:

Архитектура:

Языковая модель

Для обучения языковой модели использовалась модель Skip-gram — корпус объемом 5,4 миллиарда слов, взятый с сайта wikipedia.org. В модели использовался иерархический слой softmax для прогнозирования связанных понятий, окно — 20 слов, количество проходов по корпусу — 1. Экспериментально установлено, что размер встраивания лучше брать 500-1000. На картинке расположения классов в пространстве видно, что модель усвоила качественную и насыщенную смысловую структуру.Например, для определенного вида акул в полученном семантическом пространстве 9 ближайших соседей — это остальные 9 видов акул.

Визуальная модель

Архитектура-победитель конкурса ILSVRC 2012 года была взята в качестве визуальной модели.Он удалил softmax и добавил полностью связный слой, чтобы на выходе получить желаемый размер встраивания.

Функция потерь

Оказалось, что выбор функции потерь важен.Использовалась комбинация косинусного подобия и потери ранга шарнира.

Функция потерь вознаграждала большее скалярное произведение между вектором результата визуальной сети и соответствующим внедрением метки и наказывала большее скалярное произведение между результатом визуальной сети и встраиванием случайных меток изображения-кандидата.

Количество произвольных случайных меток не было фиксированным, а ограничивалось условием, при котором сумма скалярных произведений с ложными метками становилась больше, чем скалярное произведение с правильной меткой минус фиксированная маржа (константа, равная 0,1).

Разумеется, все векторы были предварительно нормализованы.

Тренировочный процесс

Вначале обучался только последний добавленный полносвязный слой; остальная часть сети не обновила веса.В данном случае использовался метод оптимизации SGD. Затем вся визуальная сеть была разморожена и обучена с помощью оптимизатора Adagrad, чтобы при обратном распространении на разных слоях сети градиенты масштабировались правильно.

Прогноз

В ходе прогнозирования по изображению с помощью визуальной сети мы получаем определенный вектор в нашем семантическом пространстве.Далее мы находим ближайших соседей, то есть некоторые возможные метки, и особым образом отображаем их обратно в синсеты ImageNet для оценки.

Последняя процедура сопоставления не так проста, поскольку метки в ImageNet представляют собой набор синонимов, а не одну метку.

Если читателю интересно узнать подробности, рекомендую оригинальную статью (Приложение 2).

Результаты

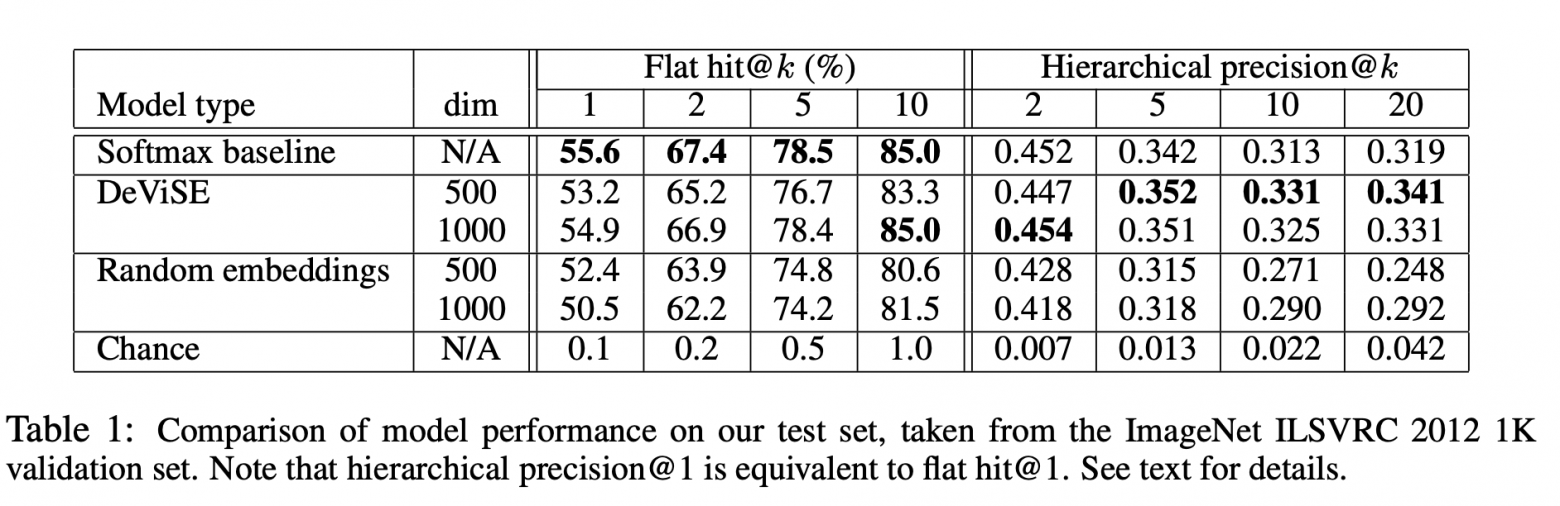

Производительность модели DEVISE сравнивалась с двумя моделями:- Базовая модель Softmax – современная модель видения (SOTA – на момент публикации)

- Модель случайного встраивания — это версия описанной модели DEVISE, в которой встраивания не изучаются языковой моделью, а инициализируются случайным образом.

Иерархическая метрика Precision@k использовалась для оценки качества семантического соответствия.

Эта метрика основана на иерархии меток в ImageNet. Для каждой истинной метки и фиксированного k был определен набор семантически правильные теги — основной список истины.

При получении предсказания (ближайшие соседи) был найден процент пересечения с основным списком истинности.

Авторы ожидали, что модель softmax должна продемонстрировать лучшие результаты на плоской метрике за счет того, что она минимизирует кросс-энтропийные потери, что очень подходит для «плоских» метрик hit@k. Авторы были удивлены, насколько близка модель DEVISE к модели softmax, достигая четности при больших k и даже превосходя ее при k = 20. По иерархической метрике модель DEVISE показывает себя во всей красе и превосходит по производительности базовый план softmax на 3% для k=5 и на 7% для k=20.

Обучение с нулевым выстрелом

Особым преимуществом модели DEVISE является ее способность обеспечивать адекватный прогноз для изображений, метки которых сеть никогда не видела во время обучения.Например, во время обучения сеть видела изображения с пометками тигровая акула, бычья акула и синяя акула, но никогда не встречала метку акула.

Поскольку языковая модель имеет представление акулы в семантическом пространстве и близка к вложениям разных типов акул, модель с высокой вероятностью даст адекватное предсказание.

Это называется способностью к обобщению – генерализации.

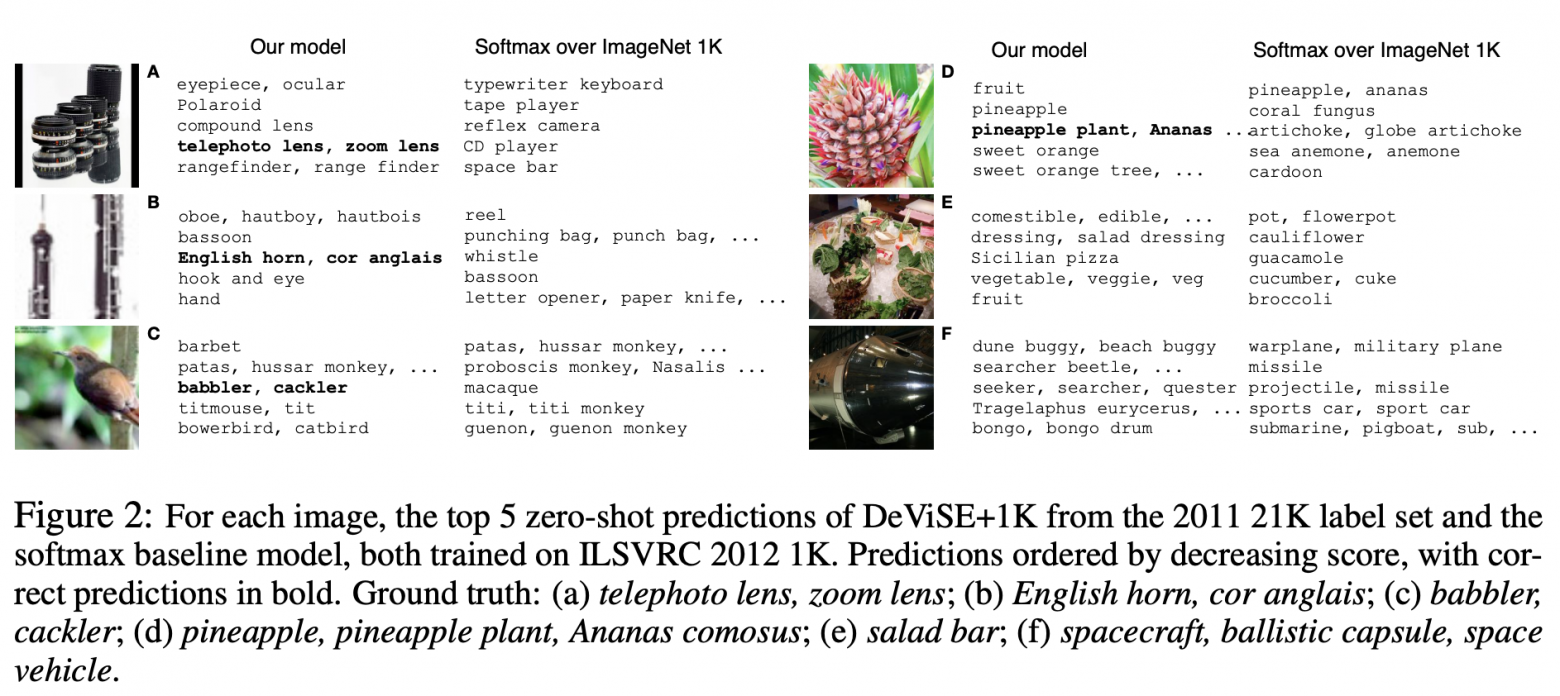

Давайте продемонстрируем несколько примеров предсказаний Zero-Shot:

Обратите внимание, что модель DEVISE, даже в своих ошибочных предположениях, ближе к правильному ответу, чем ошибочные предположения модели softmax. Таким образом, представленная модель довольно сильно проигрывает базовой линии softmax по плоским метрикам, но значительно выигрывает по иерархической метрике Precision@k. Модель обладает способностью обобщать, создавая адекватные прогнозы для изображений, метки которых сеть не встречала (обучение с нулевым выстрелом).

Описанный подход легко реализовать, поскольку он основан на двух предварительно обученных моделях — лингвистической и визуальной.

Теги: #Машинное обучение #модель #DeViSE #Deep #Визуально-семантическое #Встраивание

-

Я Mac: Половина Youtube

19 Oct, 24 -

Годвилль — Игра Без Игрока

19 Oct, 24 -

Чемпионат #Pghack. Платформа

19 Oct, 24 -

Что Звучит Лучше? Windows Против Os X

19 Oct, 24 -

Тонкий Клиент Как Альтернатива Офисному Пк

19 Oct, 24