На этом ресурсе часто рассказывают о работе со случайными величинами — ну много где они нужны.

Иногда случается, что нужно определить зависимость двух случайных величин друг от друга.

Тут вы воскликнете – «Пффф, мы это в школе проходили – корреляция».

Здесь я хочу вас разочаровать — корреляция Пирсона — это лишь один из многих способов показать зависимость двух случайных величин.

Плюс он линейный.

То есть, если связь между X и Y не линейная, а, скажем, квадратичная, то есть X = Y^2, то корреляция Пирсона покажет отсутствие зависимости.

Но мы знаем, что это не так.

Если вы раньше об этом не задумывались, то теперь у вас должны возникнуть идеи – «Как такое может бытьЭ», «Что нам делатьЭ», «Аааа, мы все умрем!» На все эти непростые вопросы я постараюсь дать ответы под катом.

Для начала напомню, что кумулятивные функции распределения могут быть определены на любых наборах значений, но сами они имеют значения от 0 до 1. То есть они преобразуют значения из заданного набора в строго заданный набор значений.

задан диапазон от 0 до 1. Можно представить, что они «архивируют».

Например, обычная функция «архивирует» диапазон от минус бесконечности до плюс бесконечности в этот самый пресловутый (0,1).

Логнормальное распределение «архивирует» только диапазон от 0 до бесконечности.

И так далее.

Теперь представьте себе процесс «разархивирования».

Это делается с помощью обратных функций распределения.

Их еще называют квантильными функциями ( функция квантиля ).

Суть вы уже поняли — эти функции преобразуют диапазон (0,1) в диапазон значений, заданный этой функцией.

Все это, конечно, имеет массу ограничений, но для «визуального представления» такое сравнение вполне подходит.

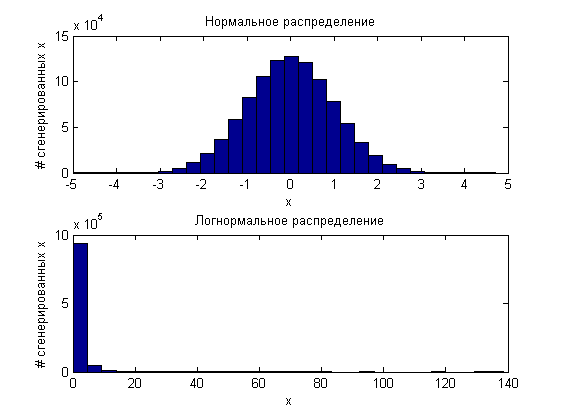

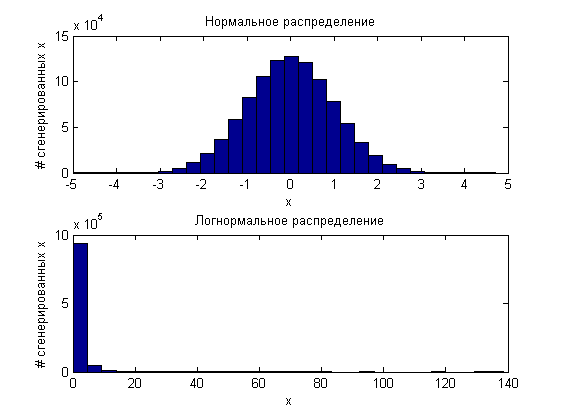

Что интересно, если мы возьмем 10^6 случайных величин, сгенерированных по одному принципу (например, по стандартному нормальному распределению) и еще 10^6 по логнормальному закону распределения:

а затем «заархивировать» их, тогда оба полученных миллиона значений будут распределены равномерно от 0 до 1.

То есть, по сути, любое распределение можно сформировать из равномерно распределенных значений и обратной функции распределения.

Если бы была такая функция.

Давайте закончим этот ликбез.

Сейчас я познакомлю вас с копулами.

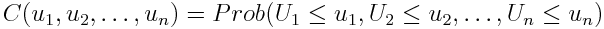

Формульное определение таково:

где u — «архивное» значение (u = F(x), F — маргинальная функция распределения).

Мы также можем написать это

То есть это совместная функция распределения нескольких «архивных» величин.

Вы можете сказать: «э-э… мы только что показали, что «архивные» величины одинаково распределены для всех функций распределения».

Это справедливо для отдельных объемов, но мы работаем сразу с несколькими.

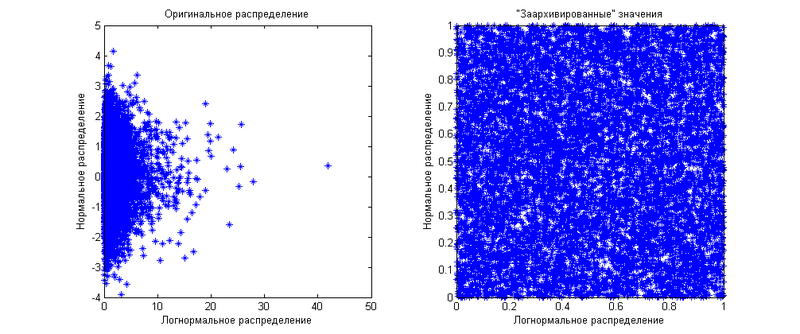

Допустим, у нас есть две величины — одна нормально распределенная, другая логнормальная.

Начнем с того, что они будут независимы друг от друга.

Маргинальные (когда мы рассматриваем значения отдельно) распределения мы уже показывали выше.

Теперь я покажу вам, как выглядит их совместное распределение:

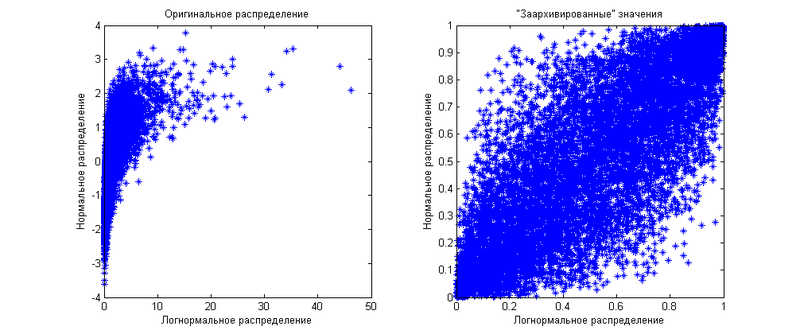

Как видите, «архивные» значения равномерно распределены по квадрату 1 на 1. Теперь мы сгенерируем те же значения, но скажем, что между ними существует корреляция, равная 0,8. Результат показан на следующем графике

Как видите, распределение «архивных» значений теперь неравномерное — оно более сконцентрировано по диагонали.

Именно здесь и проявляются ограничения использования корреляции как меры зависимости величин.

Действуя только им, вы сможете распределить «архивные» значения только ближе или дальше от диагонали.

Диагональ будет либо 45 градусов, если корреляция положительная, либо 135 градусов, если корреляция отрицательная.

Что делать, если вы хотите показать другой шаблон зависимостей? Здесь вам на помощь приходят копулы.

Из шаблонного определения связки ясно, что она показывает функцию распределения на этом квадрате 1 на 1, если имеется два значения.

Если их больше двух, то копула покажет распределение в n-мерном кубе 1 на 1 на 1. на 1. С помощью различных копул можно показать любые распределения «архивных» величин.

Еще одним важным преимуществом копул является их независимость от маргинальных распределений.

То есть вам все равно, какие предельные распределения имеют значения — вы работаете напрямую с зависимостями, выраженными через зависимости «архивных» значений.

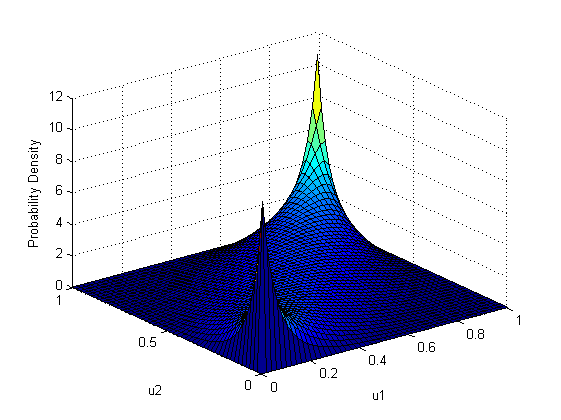

Поскольку копула по-прежнему является функцией вероятности, а не распределением величин как таковым, графически она изображается как поверхность, каждая точка которой равна совместной вероятности двух величин.

Другими словами, это совместный график плотности распределения.

Для наглядности приведу пример нескольких копул:

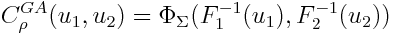

Для начала покажем функцию плотности распределения самой гауссовой копулы, а также ее графическое отображение:

Где

– функция нормального распределения, а

является обратной функцией i-го предельного распределения, то есть распределения конкретной ценности как таковой.

Как видите, оно очень похоже на распределение «архивных» случайных величин в последнем примере.

В этом нет ничего странного, поскольку в последнем примере мы использовали гауссову копулу с тем же параметром корреляции, равным 0,8, с нормальной и логнормальной маргинальными функциями распределения.

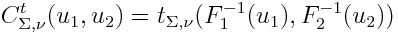

Далее я хотел бы показать копулу Стьюдента:

Где t — функция распределения Стьюдента с заданной ковариационной матрицей и заданным числом степеней свободы.

Видно, что в отличие от гауссовой копулы копула Стьюдента имеет большее значение на крайних значениях (1-1 и 0-0), что означает более толстые хвосты распределения.

Еще более заметны высокие значения углов 0-1 и 1-0, что означает выраженную обратную зависимость на концах диапазонов определений предельных функций.

Стоит отметить, что этот график был построен для положительной корреляции между значениями.

В случае нулевой корреляции, в отличие от гауссовой копулы, где в этом случае распределение было бы равномерным по всему квадрату, копула Стьюдента имеет одинаковые веса для всех углов.

Это означает, что если одно значение принимает «хвостовое» значение, то и другое примет «хвостовое» значение, но с одинаковой вероятностью оно будет правым или левым.

Чтобы было легче читать график плотности копулы, можно мысленно сделать разрез перпендикулярно одной из осей.

Полученный график будет графиком плотности вероятности появления одного «архивного» значения при фиксации другого.

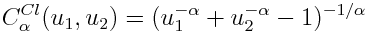

Еще хотелось бы показать копулу Клейтона, определяющую степень родства двух величин только по параметру альфа, который должен быть строго больше 1.

Здесь основной вес лежит на угле 0-0, то есть значения скорее будут брать значения из левого хвоста маргинальных функций.

В целом копулы позволяют показать любую зависимость нескольких величин друг от друга, расширяя диапазон моделирования.

Для дальнейшего использования я предоставляю небольшой список литературы.

Копулы в Matlab Понимание отношений с помощью копул —Эдвард Фрис, Эмилиано Вальдес Борьба с копулами — Торстен Шмидт Теги: #математика #случайные переменные #теорвер #зависимость #связка #связка #Алгоритмы #математика

-

Микробиология

19 Oct, 24 -

Пользовательский Интерфейс Firebird На Java

19 Oct, 24 -

13 Вопросов Бре Петтису

19 Oct, 24