Практическое применение знаний о работа с массивами EVA И iLO на серверах ProLiant , который вы получили чуть ранее, может представлять собой развертывание высокодоступного кластера на vSphere. Кластер можно использовать для предприятий среднего и крупного размера, чтобы сократить время незапланированных простоев.

Поскольку для бизнеса важны такие параметры, как доступность своего сервиса или сервиса для клиента 24x7, данное решение основано на кластере высокой доступности.

Кластер всегда включает в себя как минимум 2 сервера.

В нашем решении серверы под управлением VMware следят за состоянием друг друга, и в любой момент времени только один из них будет лидером; на ней будет развернута виртуальная машина с нашим бизнес-приложением.

В случае выхода из строя ведущего сервера его роль автоматически берет на себя второй сервер, при этом доступ клиента к бизнес-приложению практически беспрепятственный.

1. Описание задачи

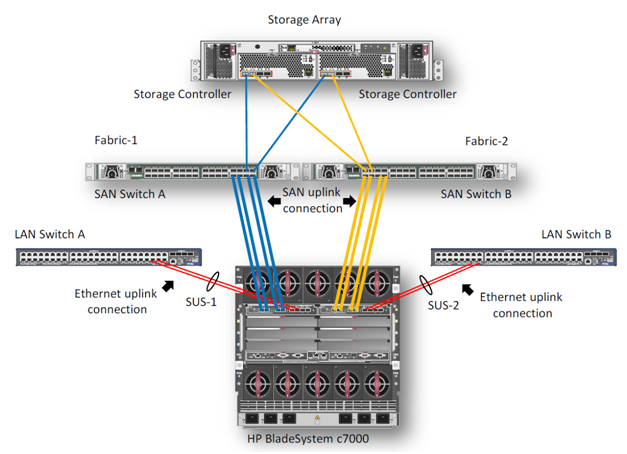

В этом примере мы опишем процесс создания высокодоступного кластера VMware на блейд-серверах BL460c G7. Оборудование состоит из блейд-корпуса HP c7000 и двух блейд-серверов BL460c G7, на которых настроен кластер VMware HA (High Available).В демо-центре HP в Москве на данный момент доступны только модели блейд-серверов G7, но на основе описанного примера можно построить кластер на новых блейд-серверах Gen8. Конфигурация, в целом, не будет отличаться.

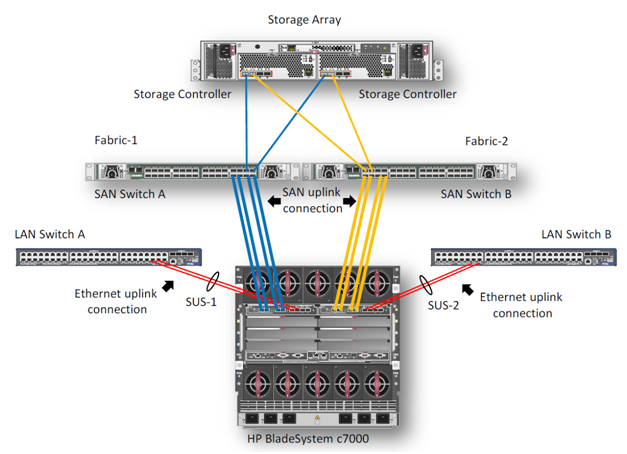

Система хранения данных — HP EVA 4400. Для подключений Ethernet и Fibre Channel в корзине c7000 в отсеках 1 и 2 установлены 2 модуля HP Virtual Connect Flex Fabric.

2. Описание компонентов

Virtual Connect FlexFabric — это конвергентный виртуализированный модуль ввода-вывода для блейд-корпуса c7000. Модуль HP Virtual Connect FlexFabric использует технологии Flex-10, FCoE, Accelerated iSCSI для коммутации блейд-серверов и сетевой инфраструктуры (SAN и LAN) на скорости 10 Гбит. Среди возможностей: передача «профилей» (таблицы MAC и WWN серверов) не только между разными блейдами в шасси, но и на удалённые площадки, где есть тот же блейд-сервер.

Также при использовании Virtual Connect каждый из двух портов сетевой карты блейд-сервера можно разделить на 4 виртуальных порта 1GbE/10GbE/8Gb FC/iSCSI с общей пропускной способностью 10GbE на порт. Это позволяет получить 8 виртуальных портов на сервер (на BL460c G7), которые необходимо указать при первой инициализации.

Единственное ограничение заключается в том, что HP Virtual Connect FlexFabrics не являются полноценными коммутаторами.

Это агрегаторы, для которых необходимо иметь отдельные коммутаторы Ethernet и SAN (впрочем, в последней прошивке стало возможным Direct Connect с HP P10000 3PAR).

Общий вид используемого оборудования отображается в бортовом администраторе.

Двухпортовая карта FlexFabric NC553i 10 Гбит, интегрированная в ProLiant BL460c G7, может работать напрямую с модулями HP Virtual Connect FlexFabric без дополнительных мезонинных карт. Два модуля HP Virtual Connect FlexFabric установлены для обеспечения отказоустойчивых путей связи между блейд-серверами, системой хранения данных EVA 4400 и коммутаторами Ethernet.

В этом примере мы рассмотрим сценарий, в котором трафик от модуля HP Virtual Connect FlexFabric разделяется на коммутаторы Ethernet и структуру FC. FCoE в данном случае используется для соединения модулей с блейд-серверами внутри корзины.

Модулям HP Virtual Connect FlexFabric требуются трансиверы для поддержки нескольких протоколов.

В этом примере трансиверы FC SFP 4 Гбит были установлены в порты 1 и 2 на каждом из модулей, а трансиверы SFP 10 Гбит/с были установлены в порты 4 и 5. В этом тесте использовались каналы 10 GbE для включения сетевого оборудования в нашем примере.

демо-центр.

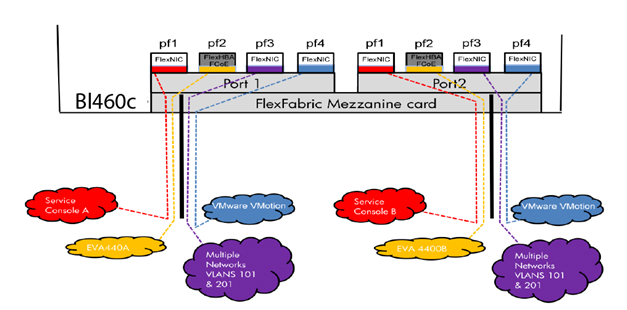

На схеме видно, что 3 порта сетевого адаптера NC553i Dual Port FlexFabric 10Gb настроены как FlexNIC для взаимодействия между виртуальными машинами и подключения к сетевой инфраструктуре.

Оставшийся порт был настроен как FCoE для связи с инфраструктурой SAN и системой хранения данных EVA 4400. Вместе с каждым модулем Virtual Connect поставляется программное обеспечение управления HP Virtual Connect Manager; для модулей Enterprise поставляется HP Virtual Connect Enterprise Manager. Используя Enterprise Manager, вы можете управлять до 256 доменами с одной консоли (1 домен — 4 блейд-системы с Virtual Connect).

После подключения модуля его необходимо настроить.

Это делается либо путем подключения к Бортовому Администратору самой корзины, либо с использованием IP-адреса, который присвоен модулю по умолчанию на заводе.

3. Настройка профилей в Virtual Connect Manager

После подключения HP FlexFabric мы должны определить домен, сеть Ethernet, структуру SAN и профили серверов для хостов.

Эти настройки выполняются в HP Virtual Connect Manager или в командной строке.

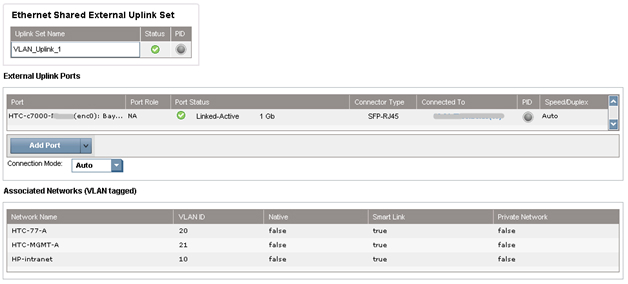

В нашем примере домен уже создан, поэтому следующим шагом будет определение наборов восходящих каналов совместного использования VC для поддержки сетей Ethernet виртуальных машин с именами HTC-77-A и HTC-77-B. Включите функцию «Сопоставить теги VLAN» в мастере установки.

Функция «Сопоставить теги VLAN» дает возможность использовать один физический интерфейс для работы с несколькими сетями с использованием Shared Uplink Set. Таким образом, вы можете настроить несколько VLAN на интерфейсе сетевой карты сервера.

Общие наборы восходящих каналов были настроены в мастере установки VCM. Пример задания SUS:

Обе сети «HTC-77-A» и «HTC-MGMT-A» были назначены: VLAN_Uplink_1 на порт 5 модуля 1; второй общий набор восходящих каналов (VLAN_Uplink_2) был назначен порту 5 модуля 2 и включает сети HTC-77-B (VLAN 20) и HTC-MGMT-B (VLAN 21).

Пример создания сетей Ethernet в VCM: Модуль HP Virtual Connect позволяет создать внутреннюю сеть без восходящих каналов, используя высокопроизводительные соединения 10 Гбит/с с объединительной платой C7000. Внутреннюю сеть можно использовать для VMware vMotion, а также для организации отказоустойчивости сети.

Трафик из этой сети не выходит на внешние порты стойки c7000. В нашем случае были настроены 2 сети VMware vMotion. Консоль управления настроена на две сети с именами HP-MGMT-A и HP-MGMT-B. Порт 6 модулей HP Virtual Connect FlexFabric в отсеках 1 и 2 использовался для подключения к консоли управления.

После этого начинается настройка SAN Fabric. Все довольно просто: в VCM выбираем Define – SAN Fabric. Выберите модуль SAN-1 в отсеке 1, порт X1. Для второго модуля SAN-2 порт также X1. Пример конфигурации SAN:

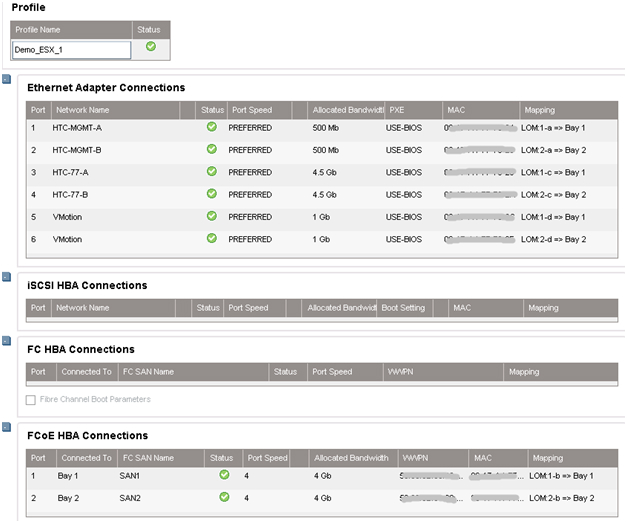

Последним шагом будет «склейка» всех ранее сделанных настроек в профиль сервера.

Это можно сделать несколькими способами: например, через веб-интерфейс VCM или через командную строку Virtual Connect — Virtual Connect Scripting Utility (VCSU).

Перед установкой ОС необходимо убедиться, что все драйверы системы, сетевых карт и FC обновлены, а также установлены все сетевые параметры.

Пример создания профиля в CVM: В VCM выберите Define – Server Profile, введите имя профиля и выберите сетевые подключения профиля из созданных ранее.

В нашем случае все порты были нами назначены заранее: 6 портов Ethernet и 2 порта SAN для каждого профиля.

Профили для отсеков 11 и 12 идентичны, т.е.

каждый сервер видит один и тот же набор портов.

Суммарная скорость не превышает 10Гбит/с для каждого порта сетевой карты сервера.

Если вы планируете расширять свою сеть в будущем, рекомендуется назначить в профиле неназначенные порты.

Сделав это, вы сможете позже включить эти порты, не выключая и не перезагружая сервер.

При создании профиля по умолчанию в разделе Ethernet доступны только 2 порта.

Чтобы добавить еще, нужно вызвать контекстное меню правой кнопкой мыши и выбрать «Добавить подключение».

Мы назначаем скорости для каждого типа портов: порты управления – 500 Мбит/с, порты vMotion – 1 Гбит/с, порты SAN – 4 Гбит/с и порты виртуальных машин – 4,5 Гбит/с.

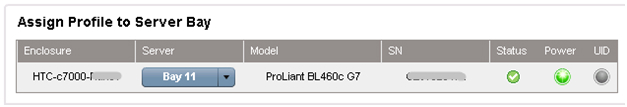

После создания профилей они связываются с лопастным отсеком корзины в том же меню.

4. Настройка кластера VMware

На этом настройка корзины завершена.Далее идет удаленное подключение к самим блейдам и развертывание VMware ESX 5.0, пример удаленной установки ОС на серверах ProLiant через iLO. уже было описано .

В нашем случае вместо Windows в выпадающем меню установщика выбрана VMware и указан путь к дистрибутиву.

После установки сервер перезагружается и можно приступать к настройке виртуальных машин.

Для этого подключитесь к ESX-серверу.

Заходим в раздел Configuration, создаем по 6 vmnics для каждого хоста, как в модуле Virtual Connect: Service Console (vSwitch0), VM Network (vSwitch1), vMotion (vSwitch2).

Таким образом, мы получаем отказоустойчивую конфигурацию, где каждой сети соответствует 2 вмника.

Как только vmnics будут добавлены, вы заметите, что для каждого адаптера автоматически устанавливается скорость, указанная в профиле сервера при настройке в Virtual Connect Manager.

После добавления vmnics объединяем их в группу с помощью vSwitch: вкладка Port – в поле Configuration выбираем vSwitch – Edit, выбираем NIC Teaming, убеждаемся, что оба vmnics видны.

Для балансировки нагрузки выбираем «Маршрутизация на основе идентификатора исходного виртуального порта» — эти настройки рекомендуется установить по умолчанию (подробнее об этом методе можно прочитать здесь).

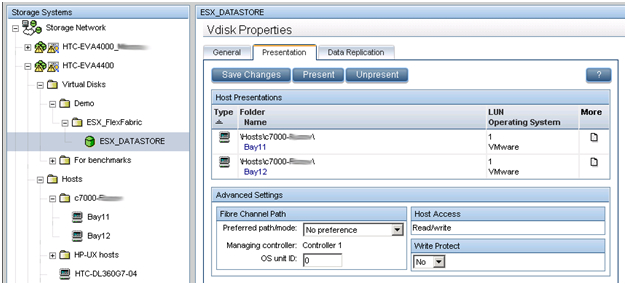

5. Настройка дискового массива EVA 4400

В предыдущем обзоре было описано, как работать с интерфейсом управления дисковым массивом EVA — Command View.

В этом примере мы создаем LUN объемом 500 ГБ, который используется совместно двумя хостами виртуальных машин.

Используя метод, описанный в предыдущей статье, создается виртуальный диск и предоставляется двум хостам ESX. Размер LUN определяется типом ОС и ролями, которые будет выполнять кластер.

Обязательным условием кластера (в частности, для VMware vMotion) является то, что LUN должен быть общим.

Новый LUN должен быть отформатирован в VMFS, а для виртуальных машин должна быть включена функция Raw Device Mappings (RDM).

6. Внедрение VMware HA и VMware vMotion.

HP Virtual Connect в сочетании с VMware vMotion обеспечивает тот же уровень резервирования, что и два модуля VC-FC и два модуля VC-Eth, за исключением того, что требуются только 2 модуля HP FlexFabric. HP Virtual Connect FlexFabric обеспечивает возможность организации отказоустойчивых путей к общему LUN и отказоустойчивому объединению сетевых интерфейсов (NIC Teaming) для работы в сети.Все настройки VMware vSphere соответствуют рекомендациям.

Доступность кластера проверена.

На одном из хостов была развернута виртуальная машина Windows 2008 Server R2.

Виртуальную машину несколько раз вручную переносили с одного сервера на другой; во время миграции кластер оставался доступным.

Схема кластера:

HTC DC — наш DC, Demo-FlexFabric Cluster — наш кластер, Demo-ESX1 и Demo-ESX2 — хосты VMware, vmhba2 — контроллеры блейд-серверов SAS, подключенные к внутренней дисковой подсистеме.

Vmhba0 и vmhba1 — это два порта встроенного сетевого адаптера NC553i Dual Port FlexFabric 10Gb, подключенного к общему LUN EVA 4400. Demo-VM-W2K8R2-01 — это виртуальная машина.

Литература: 1. Блейд-сервер HP BL460c Gen8 2. HP Virtual Connect FlexFabric 3. Развертывание кластера VMware vSphere HA с помощью HP Virtual Connect FlexFabric 4. Лучшие практики VMware vSphere 5.0 5. Концепции виртуальных сетей VMware Теги: #сервер #VMware #отказоустойчивость #Хранилище данных #Высокая производительность #аппаратное обеспечение #бизнес #HP #системы #высокая доступность #proliant #ilo #blades. #ЕВА

-

Все О Toshiba Satellite-L655-S5078

19 Oct, 24 -

Исследование Puredata

19 Oct, 24 -

Akamai Собирается Открыть P2P-Сервис

19 Oct, 24 -

Байт-Код Efi И Операции С Памятью

19 Oct, 24