Привет! В предыдущих статьях (часть один , два , три , четыре ) мы рассказывали о том, как мы строили свой мини дата-центр.

В этой статье мы попытаемся рассказать о проблемах, с которыми нам пришлось столкнуться за последний год нашей работы.

Надеемся, что эта статья поможет вам предотвратить ошибки, которые мы допустили с самого начала и которые пришлось устранять «на месте».

Идти!

Как вы знаете из предыдущих статей, нам нужно было быстро «продлить» нашу оптическую линию на новый аплинк для защиты от DDoS-атак (поскольку сервис подвергался массированным DDoS-атакам со стороны конкурентов).

Так как мы сделали это крайне быстро, то допустили ряд ошибок, за которые потом поплатились сполна.

Первый перерыв

Первый случай не заставил себя долго ждать.Уже в апреле (да, именно в апреле) случился сильный шторм со снегопадом, который повалил множество деревьев, а в нашем случае даже множество опор (столбов), по которым мы прокладывали оптический кабель.

Также возникла проблема - раздобыть оптический кабель, распределительные коробки и муфты, а главное найти бригаду, которая бы это сделала, так как в тот день, пожалуй, половина провайдеров города Днепра остались без связи из-за погодные условия, приведшие к падению деревьев, столбов, обрывам оптических линий и т.п.

Жители вырубили деревья, чтобы расчистить дорогу и пойти на работу.

Оптоволокно порвалось сразу в четырех местах и это было очень печально.

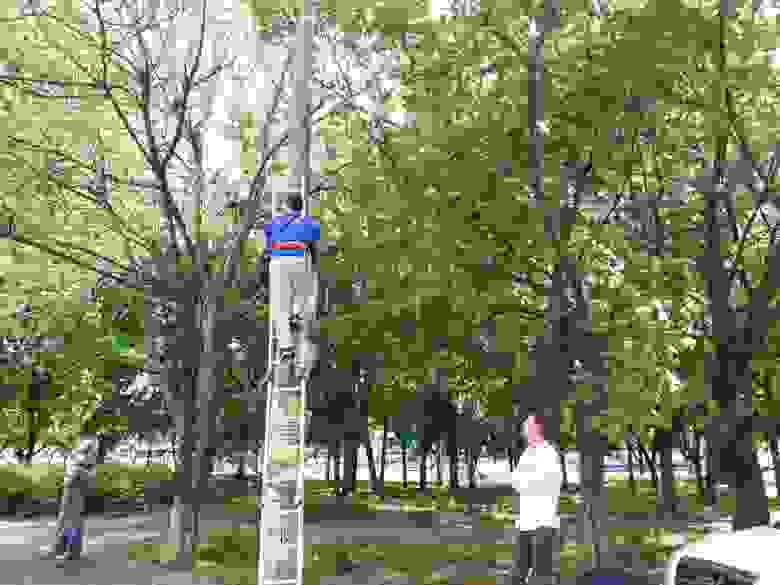

Ситуация осложнялась еще и тем, что высота, на которой монтажники крепили оптический кабель, была недостижима для наших «стандартных» лестниц, но мы нашли выход из этой ситуации.

Пришлось взять вторую машину, которая используется для перевозки грузов и «поездок», и установить лестницу прямо внутри, уперев ее в сиденье.

Мы приступили к работе.

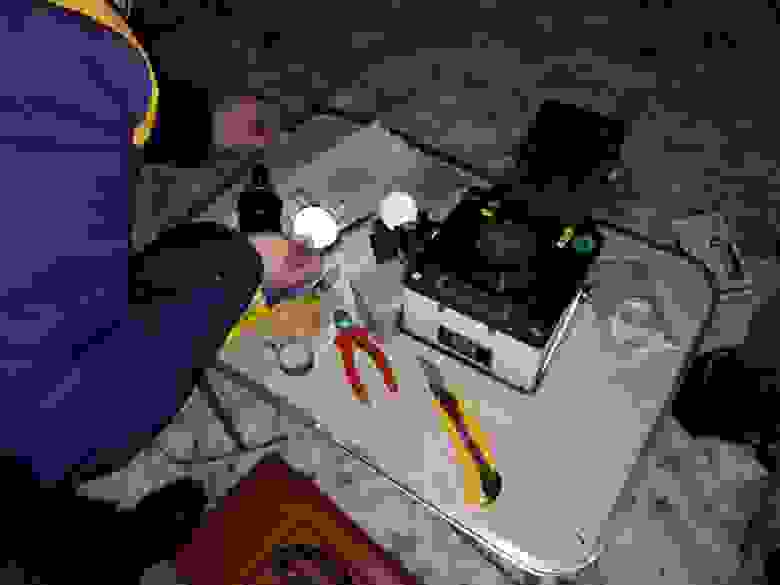

Чистим оптоволокно.

Привариваем последнюю сердцевину.

Мы были заняты весь день, практически с раннего утра до вечера.

Огромное спасибо команде, которая нам помогала, лазила по ледяным столбам, мокла в полуметровых лужах и мерзла под «легким» апрельским ветерком.

Второй перерыв

Второй разрыв произошел через полтора месяца, там же, где и первый, как всегда в самый неподходящий для этого момент. И произошло это по вине коммунальных служб, которые решили убрать поваленные деревья и заодно вырвать все, до чего мог дотянуться ковш их экскаватора.(надеюсь случайно).

В этот раз мы уже знали, куда идти и что взять с собой, готовились тщательно.

В это время наш мини «дата-центр» уже сидел на резервном аплинке с полностью рабочим функционалом, что давало нам возможность особо не торопиться.

Устранение последствий прошло успешно; они старались закрепить кабель как можно выше.

Как оказалось позже, этого было недостаточно.

Третий обрыв

Через некоторое время (очень короткий период) у нас снова пропал сигнал и первым делом мы пошли осматривать этот участок дороги.Все осложнялось тем, что нам нужно было иметь в наличии и оптоволокно, и «фольги/муфты», в которые мы это волокно укладывали.

Но при такой частоте аварий резервов становилось все меньше.

Обрыв произошел ровно в одном и том же районе, в двух местах.

Первую часть оторвал большегрузный грузовик вместе с электрическими проводами, а вторую «добил» мусоровоз, который намотал на себя и без того свисающий кабель и оторвал его от трех опор.

Мы порядком устали от этой ситуации и решили действовать наверняка.

Вызвали автовышку и стали закреплять трос так, чтобы его мог оторвать только падающий самолет (не дай Бог, конечно).

Сращивание волокон прошло успешно, Интернет был доступен.

Четвертый обрыв

Последний обрыв произошел в конце лета и в самом неудобном для нас месте, над высоковольтными троллейбусными проводами, над оживленной дорогой.Как позже выяснилось, электрики меняли крепеж и случайно задели наш кабель.

Мы должны отдать должное команде, которая устранила обрыв; они сделали это бесстрашно.

Высота, даже по сравнению с нашими предыдущими скалами, была очень серьёзной (около 10м).

Нагревать

Но в этом году мы столкнулись не только с обрывами и снежной весной, но и с аномальной жарой, которая практически парализовала работу нашего мини-дат-центра.В середине лета в Украине началась аномальная жара.

Температура в тени поднялась до 45 градусов по Цельсию.

У нас есть мощный, дорогой, канальный кондиционер, который, к сожалению, обслуживается не так часто, как требуется.

И вот, когда неделю-две жара стояла 45 градусов, а ночью 30 градусов, начались наши приключения.

Во-первых, наш дата-центр начал «взлетать» за счет блейд-систем HP C7000. Есть кулеры типа «турбина» и звучат они весьма специфично.

Температура была (в самой горячей точке) около 40 градусов, на лопастных системах около 30.

Первым делом мы, конечно, начали обслуживать кондиционер, проверили и залили фреон, почистили систему и радиатор, и вроде бы помогло, но ровно на неделю.

Мы решили добавить еще один кондиционер, напольный, в помощь основному.

Но это дало обратный эффект, температура только начала повышаться.

Мы следовали принципу «удаления теплого воздуха» и приступили к реконструкции выхлопной системы.

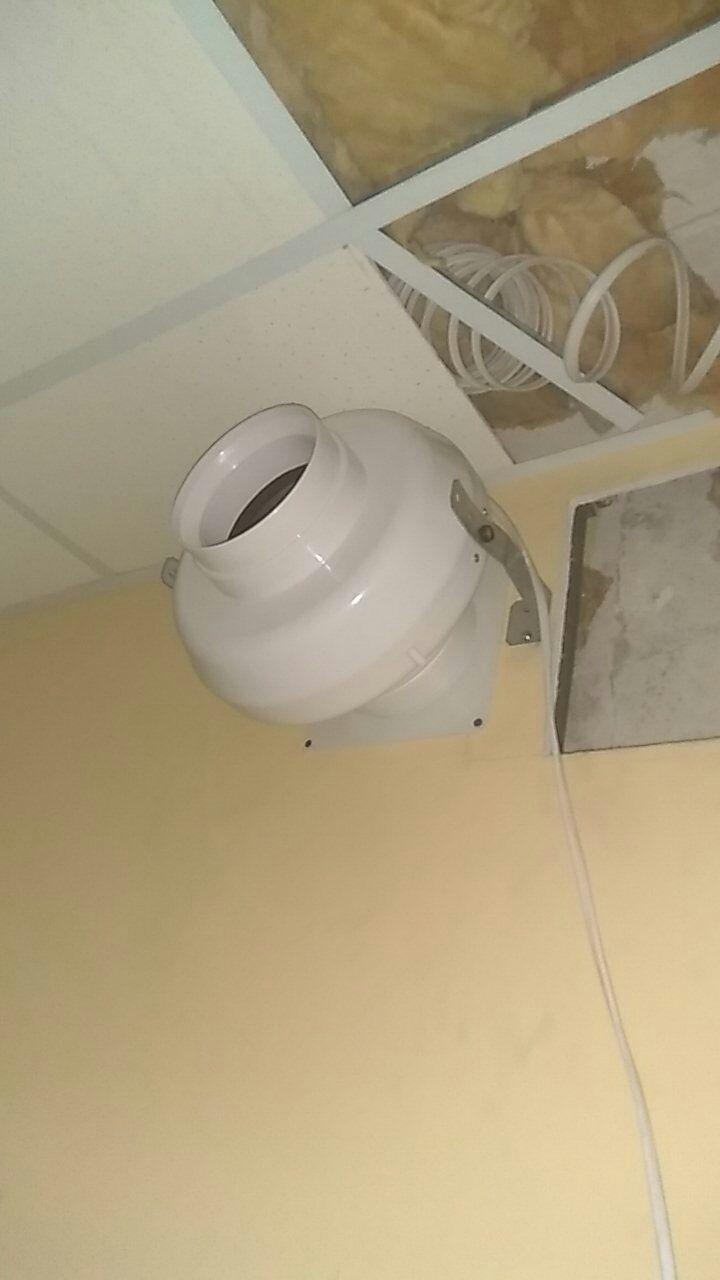

Купили и установили вытяжку, проложили вытяжные каналы и т.д.

Тест капюшона, впитывание листа А4:

Они даже сделали это:

На какое-то время это дало желаемый эффект, и месяц мы жили относительно без проблем, но с повышенными температурами в серверной зоне.

Мы решили заменить кондиционер на новый, так как посчитали, что старый вышел из строя (на это нам указали специалисты).

Мы установили новый, более мощный кондиционер (тоже канальный), потратили кучу денег, но эффекта практически не было.

Перепробовав все возможные варианты, пообщавшись с десятком подрядчиков, мы не нашли ни одного адекватного решения, температура была в пределах нормы, но в своей пограничной части, что нас тоже не устраивало.

Хотя серверы не перегревались, это могло бы стать проблемой при расширении оборудования.

И вот один умный человек (привет НМ из ПИНСПБ!) предложил нам, казалось бы, нереальное решение проблемы.

Вся проблема была в том, что горячий воздух скапливался в некоторых углах и никуда не уходил, и сколько бы холод мы ни подавали, он сразу становился теплым.

Мы прислушались к совету коллеги и попытались сделать тестовое решение подручными средствами.

Честно говоря, я отнесся к этому скептически, и выглядело это глупо.

Но уже через час работы температура в дата-центре упала с 29-30 до 22-24 градусов! Конечно, бытовой вентилятор был временной мерой, и через 2 дня мы установили систему вентиляции, которая перемещала воздух по серверной в промышленных масштабах и еще лучше помогала вытяжке.

Но фанат и совет коллеги помогли нам понять суть проблемы, которую не понимали десяток подрядчиков.

Поэтому мы хотим, чтобы наш опыт помог не допустить ошибок другим нашим коллегам, которые только думают о «построении» своего решения или уже это делают. Спасибо за внимание! Теги: #Сетевые технологии #дата-центр #ит-инфраструктура #дата-центр #Системное администрирование #Администрирование серверов #аварии в дата-центре

-

Spdy Не Так Быстр На Реальных Сайтах

19 Oct, 24 -

Неизвестные Злоумышленники Украли Карму

19 Oct, 24