Несколько месяцев назад показатель отказов Google Analytics значительно увеличился.

Мы проделали стандартный набор действий, которые рекомендуется делать в Сети: создали в аналитике представление «без пауков и ботов» (настройка «Фильтрация роботов» в представлении), проверили качество настроек кода Аналитики, проверили и отрегулировал продолжительность сеанса и так далее.

Все это заняло время, но не дало результатов.

Процент отказов в некоторые дни превышал 90%.

При этом качество контента на нашем сайте или структура входящего трафика сколько-нибудь очевидным образом не изменились.

Это просто «произошло в одночасье» и всё.

Поскольку ничего подобного описанного в Интернете я не нашел, решил описать, как мы нашли и устранили проблему и снизили процент отказов до приемлемых 42-55%.

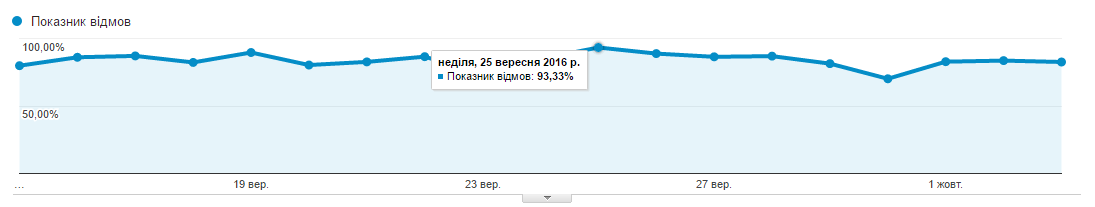

Вот скриншот, иллюстрирующий исходную проблему:

Поскольку все стандартные схемы не дали результата, пришлось думать самостоятельно и искать проблему.

Аналитика не помогла, поэтому начал проверять через Яндекс.

Метрику.

Общие показатели по Метрике были вполне приемлемыми (до 10% отказов).

Прочитав несколько статей о том, почему сбои в Метрике могут быть допустимы, а в Аналитике зашкаливать, стало понятно, где искать проблему.

Вкратце: Метрика считает отказами все посещения длительностью менее 15 секунд, а Аналитика считает все посещения, после которых не было других посещений страницы.

Итак, я начал смотреть отчет о продолжительности посещений в Метрике и Аналитике и понял, что у меня нереально большой процент посещений длительностью 0:00 секунды, до 50% ежедневных сессий.

Еще несколько прочитанных статей позволили мне отбросить гипотезу о неработающем коде и ботах, пробивающихся через фильтр Аналитики.

У меня также не было никаких признаков реферального спама.

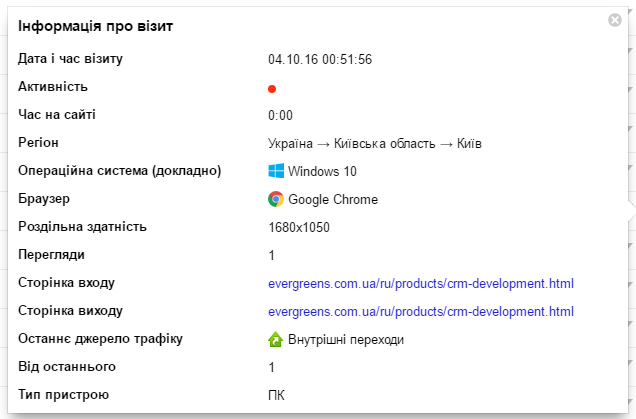

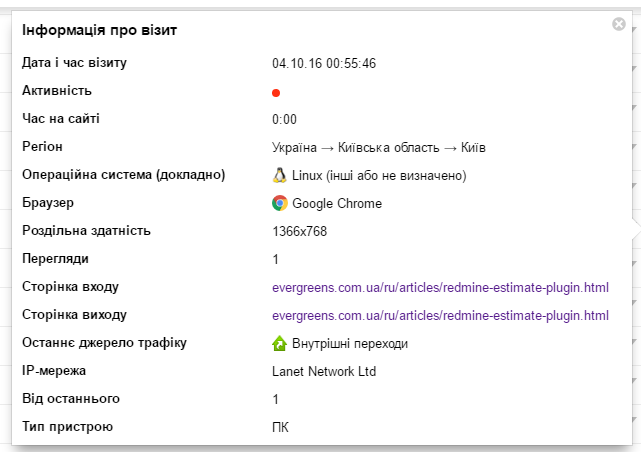

В итоге я просто отфильтровал в Вебвизоре посещения длительностью 0:00 и решил попробовать найти закономерность.

Вот что я получил:

Каждый «посетитель» приходил из своей подсети, с явно указанным User Agent, разрешением экрана и операционной системой, то есть для Метрики и Аналитики он никоим образом не воспринимался как бот.

Единственное, что выдавало, так это ритмичный характер посещений каждые 1 час 1 минуту и 0 продолжительность просмотра.

Я отправил скриншоты нашему сисадмину Андрею и попросил его посмотреть, что в логах сервера.

Первый участник IP нас удивил: к нам пришёл кто-то из подсети Лига.

Закон.

IP адрес у меня на 4:56, сейчас проверю другие звонки инетнум: 193.150.7.0 - 193.150.7.255 сетевое имя: LIGA-UA-NET2 примечания: ЛИГА ЗАКОНВсего в журналах было выявлено 43 IP-адреса, с которых осуществлялся доступ к разным страницам нашего сайта от разных провайдеров и с разными пользовательскими агентами.

Ничего интересного на RIPE мы не нашли, ничем не примечательные IP из обычных подсетей.

Кроме того, что боты ходили с интервалом 1:01, больше ничего явно общего между ними не было.

Мы заблокировали весь список найденный в iptables. За день мы также поймали несколько новых IP, набросали алгоритм автоматической фильтрации такого бот-трафика на случай, если после блокировки некоторых ботов на смену им придут новые.

Однако больше никого подобного ему не нашлось.

Любопытных юзер-агентов было всего пара-тройка, но с интервалом 1:01 ни одного.

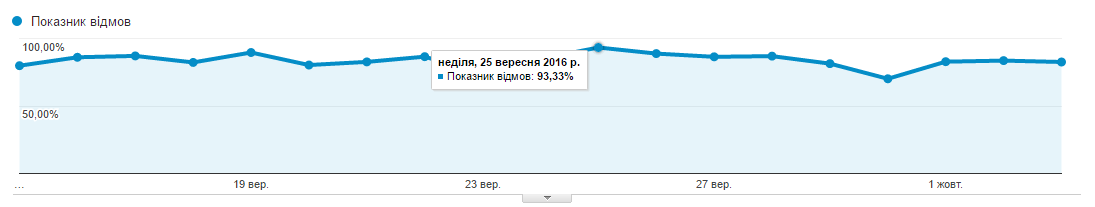

Еще через день показатель отказов по данным Google Analytics начал приходить в норму и резко упал с 89% до 42,75%.

Сегодня, спустя почти неделю после описываемых событий, процент отказов остается в пределах допустимых 42-55%; Общую динамику можно увидеть на графике.

Там, где резкий спад, мы отфильтровали ботов.

У нас есть только две гипотезы о том, «что это было».

Во-первых, один из нас неправильно настроил некоторых ботов-мониторов.

Одно время мы экспериментировали с разными программами, чтобы проверить состояние сервера.

Могли что-то включить и забыть.

Минус этой теории в том, что я не помню ни одного сервиса, который бы заявлял, что отправляет запросы из разных подсетей на разные страницы сайта от разных пользовательских агентов.

Поэтому, скорее всего, это не так.

Вторая гипотеза: это некая неизвестная широкой публике форма атаки ботов, возможно, направленная именно на увеличение показателя отказов и, как следствие, пессимизацию результатов поиска Google. Если вы тоже столкнулись с этим, буду рад услышать ваши комментарии.

Если вам нужна более подробная инструкция, как мы его искали и блокировали, тоже пишите.

Теги: #показатель отказов #бот-атака #боты #аналитика трафика #Google Analytics #Яндекс.

метрика #поисковая оптимизация

-

Маллис, Кэри

19 Oct, 24 -

Где 4.3.4

19 Oct, 24 -

Kotlinconf 2018 – Доклад И Первые Видео

19 Oct, 24