Распознавание изображений с помощью нейронных сетей становится все лучше, но исследователи до сих пор не преодолели некоторые его фундаментальные недостатки.

Например, там, где человек может ясно видеть велосипед, даже продвинутый ИИ может увидеть птицу.

Зачастую причиной являются так называемые «вредные данные» (или «конкурентные элементы», или «вредоносные экземпляры» или еще куча вариантов, поскольку «противоположные примеры» так и не получили общепринятого перевода).

Это данные, которые обманывают классификатор нейросети, придавая ему признаки других классов — информацию, не важную и не видимую для человеческого восприятия, но необходимую для машинного зрения.

Исследователи Google опубликовали в 2015 году работа , где они проиллюстрировали проблему на следующем примере:

К изображению панды применили «вредный» градиент. Человек на полученной картинке, естественно, продолжает видеть панду, а нейросеть распознает в нем гиббона, поскольку в те части изображения, по которым нейросеть научилась распознавать панд, были специально подмешаны признаки другого класса.

В областях, где компьютерное зрение должно быть чрезвычайно точным, а ошибки, взломы и злонамеренные действия могут иметь ужасные последствия, вредоносные данные являются серьезным препятствием для развития.

Прогресс в борьбе идет медленно, и GoogleAI (отдел исследований искусственного интеллекта Google) решил привлечь сообщество и организовать соревнование.

Компания предлагает каждому создать свои механизмы защиты от вредоносных данных или наоборот — идеально испорченных изображений, которые ни один алгоритм не распознает правильно.

Тот, кто лучше всех справится с работой, получит крупную сумму денег (сумма пока не объявлена).

Соревнования начнутся с разминки и запуска первых алгоритмов простых атак с вредоносными данными.

Google выбрал три набора данных с распространенными и хорошо изученными видами обмана.

Участники должны создать алгоритмы, которые распознают все предложенные изображения без единой ошибки или расплывчатого ответа.

Поскольку условия, на которых основаны вредоносные данные в наборах данных для разминки, известны и доступны, организаторы ожидают, что участники легко создадут алгоритмы, специально адаптированные к этим атакам.

Поэтому они предупреждают, что самые очевидные существующие решения не имеют шансов во втором туре.

Он стартует после разминки, а уже будет соревновательная часть, где участники будут разделены на нападающих и защитников.

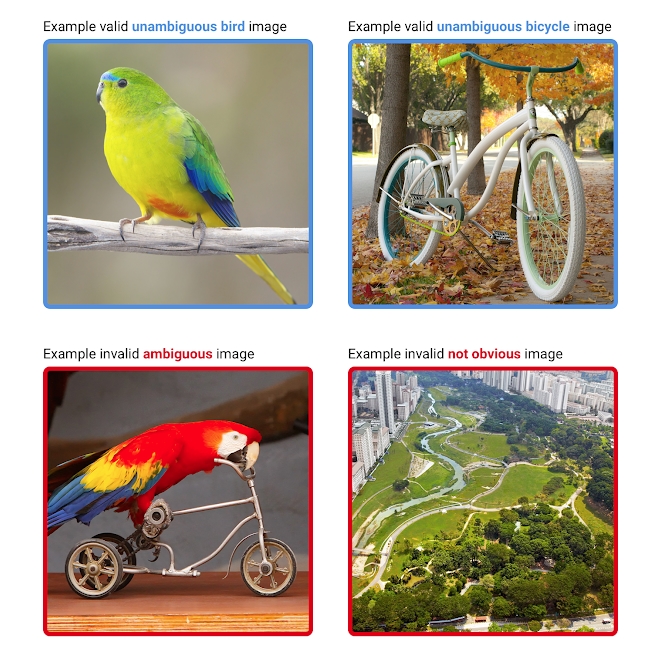

Конкурс будет построен на распознавании изображений птиц и велосипедов.

Сначала люди будут смотреть каждую предложенную картинку и выносить анонимный вердикт о том, что там изображено.

Изображение войдет в набор данных только в том случае, если все судьи согласятся, что на нем четко изображена либо птица, либо велосипед, и нет никаких признаков явной путаницы (например, птицы на велосипедах или просто абстрактные узоры и фотографии).

Вверху примеры подходящих изображений, внизу – неуместных.

Защищающиеся участники должны создать алгоритм, который без единой ошибки распределит картинки на три категории – «птицы», «велосипеды» и «неопределенные».

То есть на соревновательном этапе – в отличие от разминки – алгоритм может воздержаться от ответа, но по результатам обработки набора данных не более 20% изображений должны быть отнесены к категории неопределенных.

Технические требования к алгоритмам следующие:

- 80% изображений должны быть распознаны.

Никакие ошибки не допускаются.

Если участники присоединяются уже во время конкурсного этапа, они должны успешно обработать 2 предыдущих набора данных.

- Пропускная способность должна составлять не менее 1 изображения в минуту на Tesla P100.

- Система должна быть легко читаемой, написанной на TensorFlow, PyTorch, Caffe или NumPy. Системы, слишком сложные и трудно воспроизводимые, по решению судей могут быть сняты с конкурса.

Злоумышленники получают доступ к необученным моделям и всему исходному коду алгоритмов.

Их задача — создать картинку, которую все судьи примут как четкое изображение велосипеда или птицы, но алгоритм примет неправильное решение.

Google будет собирать все предложенные изображения в течение каждой недели, затем отправлять их на проверку и только после этого включать в наборы данных.

Если злоумышленникам удастся обмануть алгоритм, справившийся с предыдущими задачами, они получат деньги из второй половины призового фонда.

Если несколько команд добьются успеха, деньги будут разделены между собой.

Конкурс не имеет четких сроков и будет продолжаться до тех пор, пока не появится лучший защитный алгоритм.

По словам организаторов, их цель — не просто система, которую сложно обойти, а нейросеть, полностью неуязвимая для любых атак.

Правила участия можно найти на сайте страница проекта на Github .

Теги: #Машинное обучение #искусственный интеллект #нейронные сети #Обработка изображений #GoogleAI #конкуренция атак #примеры противников

-

Очистите Реестр — Ускорьте Свой Компьютер

19 Oct, 24 -

Как Оптимизировать Реестр Windows

19 Oct, 24 -

Поговорим О Шпаргалках?

19 Oct, 24