В предыдущем статья В серии «Глубокое обучение» вы узнали о сравнении фреймворков для символического глубокого обучения.

В этом материале будет обсуждаться глубокая настройка сверточных нейронных сетей для повышения средней точности и эффективности классификации медицинских изображений.

Цикл статей «Глубокое обучение»

1. Сравнение символических фреймворков глубокого обучения .2. Перенос обучения и тонкая настройка глубоких сверточных нейронных сетей .

3. Объединение глубокой сверточной нейронной сети с рекуррентной нейронной сетью .

Примечание: дальнейшее повествование будет вестись от имени автора.

Введение

Распространенной причиной потери зрения является диабетическая ретинопатия (ДР) – заболевание глаз, вызванное диабетом.Исследование пациентов с помощью флуоресцентной ангиографии может снизить риск слепоты.

Текущие тенденции исследований показывают, что глубокие сверточные нейронные сети (DCNN) очень эффективны для автоматического анализа больших наборов изображений и выявления отличительных особенностей, которые можно использовать для классификации изображений по различным категориям практически без ошибок.

Обучение DGNN редко происходит с нуля из-за отсутствия предопределенных наборов с достаточным количеством изображений, относящихся к определенной области.

Поскольку для обучения современным GPSN требуется 2–3 недели, Центр видения и обучения Беркли (BVLC) опубликовал окончательные тесты для GPSN. В этом посте мы используем предварительно обученную сеть: GoogLeNet. Сеть GoogLeNet обучена на большом наборе естественных изображений ImageNet. Мы передаем распознанные веса в ImageNet в качестве начальных значений для сети, затем настраиваем предварительно обученную сеть общего назначения для распознавания изображений глазной флуоресцентной ангиографии и повышения точности прогнозирования DR.

Использование явного выделения признаков для прогнозирования диабетической ретинопатии

В настоящее время уже проведена обширная работа по разработке алгоритмов и методов обработки изображений, позволяющих явно выделить отличительные особенности, характерные для пациентов с ДР.Стандартная классификация изображений использует следующий универсальный рабочий процесс:

- Методы предварительной обработки изображения для удаления шума и повышения контрастности.

- Методы выявления отличительных признаков.

- Классификация.

- Прогноз.

создали бинарный классификатор на основе набора данных о 55 пациентах, четко выделяя индивидуальные отличительные особенности поражений.

Некоторые авторы использовали методы обработки морфологических изображений для извлечения отличительных особенностей кровеносных сосудов и кровотечений, а затем обучили машину опорных векторов на наборе данных из 331 изображения.

Другие сообщают о точности 90% и чувствительности 90% при выполнении задачи двоичной классификации на наборе данных из 140 изображений.

Однако все эти процессы требуют значительных затрат времени и усилий.

Для дальнейшего повышения точности прогнозирования требуются огромные объемы размеченных данных.

Обработка изображений и извлечение отличительных особенностей из наборов данных изображений — очень сложный и трудоемкий процесс.

Поэтому мы решили автоматизировать обработку изображений и этап выявления отличительных особенностей с помощью GPSN.

Глубокая сверточная нейронная сеть (DCNN)

Извлечение отличительных особенностей изображений требует экспертных знаний.Функции извлечения в GPSN автоматически генерируют изображения для определенных областей без использования каких-либо функций обработки объектов.

Благодаря этому процессу GPSN подходят для анализа изображений:

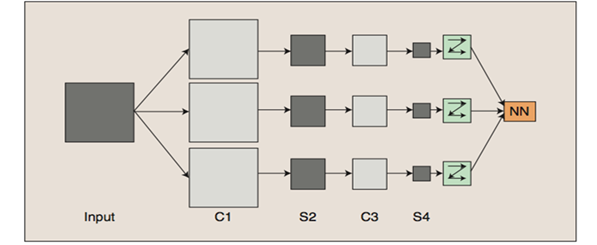

- GNN обучают многоуровневые сети.

- Несколько слоев работают вместе, образуя улучшенное пространство объектов.

- Начальные слои изучают первичные признаки (цвет, края и т. д.).

- Дальнейшие слои изучают функции более высокого порядка (в соответствии с набором входных данных).

- Наконец, характеристики полученного слоя передаются в классификационные слои.

Слои C — это свертки, слои S — это пулы и образцы.

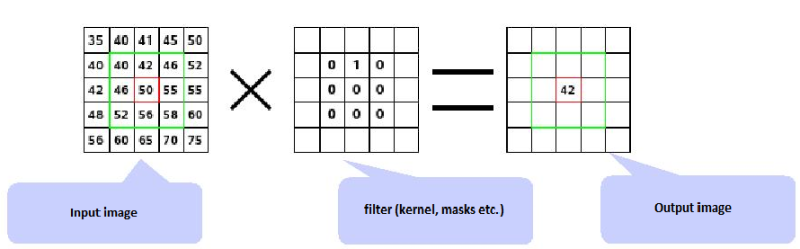

Свертка .

Сверточные слои состоят из прямоугольной сети нейронов.

Веса одинаковы для каждого нейрона в сверточном слое.

Веса сверточного слоя определяют сверточный фильтр.

Опрос .

Слой объединения берет небольшие прямоугольные блоки из сверточного слоя и подвыборки, чтобы получить один выходной сигнал из этого блока.

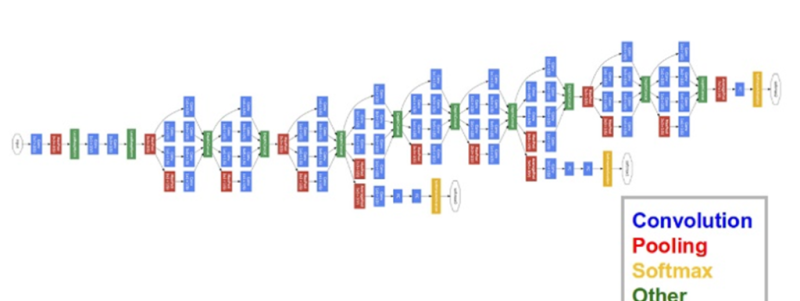

В этой публикации мы используем GoogLeNet GPS, разработанный в Google. Нейронная сеть GoogLeNet выиграла конкурс ImageNet в 2014 году, установив рекорд по лучшим разовым результатам.

Причинами выбора этой модели являются глубина работы и экономное использование архитектурных ресурсов.

Перенос обучения и тонкая настройка глубоких сверточных нейронных сетей

На практике обучение целых GNN обычно не проводится с нуля с произвольной инициализацией.Причина в том, что обычно невозможно найти набор данных достаточного размера, необходимый для сети желаемой глубины.

Вместо этого чаще всего предварительно обучают DGNN на очень большом наборе данных, а затем используют веса обученной DNN либо в качестве инициализации, либо для извлечения признаков для конкретной задачи.

Тонкая настройка .

Стратегии трансферного обучения зависят от различных факторов, но двумя наиболее важными являются размер нового набора данных и его сходство с исходным набором данных.

Учитывая, что характер работы ГНСС является более общим на ранних уровнях и становится более тесно связанным с конкретным набором данных на последующих уровнях, можно выделить четыре основных сценария:

- Новый набор данных меньше по размеру и аналогичен по содержанию исходному набору данных.

Если объем данных небольшой, то нет смысла проводить тонкую настройку GPS из-за переобучения.

Поскольку данные аналогичны исходным данным, можно предположить, что отличительные особенности GPSN будут актуальны для этого набора данных.

Поэтому оптимальным решением является обучение линейного классификатора с отличительной чертой CNN.

- Новый набор данных относительно большой и по содержанию аналогичен исходному набору данных.

Поскольку у нас больше данных, нам не нужно беспокоиться о переоснащении, если мы попытаемся точно настроить всю сеть.

- Новый набор данных меньше по размеру и существенно отличается по содержанию от исходного набора данных.

Поскольку объем данных невелик, достаточно будет только линейного классификатора.

Поскольку данные существенно различаются, лучше обучать классификатор не с вершины сети, где содержатся более конкретные данные.

Вместо этого лучше обучить классификатор, активировав его на более ранних уровнях сети.

- Новый набор данных относительно большой и существенно отличается по содержанию от исходного набора данных.

Поскольку набор данных очень большой, вы можете позволить себе обучить всю GPSN с нуля.

Однако на практике зачастую оказывается выгоднее использовать предварительно обученную модель для инициализации весов.

В этом случае у нас будет достаточно данных для тонкой настройки всей сети.

Решая вопрос прогнозирования ДР, действуем по сценарию IV. Мы точно настраиваем веса предварительно обученной CNN, продолжая обратное распространение ошибки.

Вы можете либо точно настроить все слои сети GPS, либо оставить некоторые из ранних слоев без изменений (во избежание переобучения) и настроить только высокоуровневую часть сети.

Это связано с тем, что ранние уровни GPSN содержат функции более общего назначения (например, обнаружение границ или цвета), которые полезны для многих задач, в то время как более поздние уровни GPSN уже ориентированы на классы набора данных AR. Ограничения трансферного обучения .

Поскольку мы используем предварительно обученную сеть, наш выбор архитектуры модели несколько ограничен.

Например, мы не можем случайным образом удалить сверточные слои из предварительно обученной модели.

Однако благодаря совместному использованию параметров можно легко запустить предварительно обученную сеть на изображениях разных пространственных размеров.

Это наиболее очевидно в случае сверточных слоев и слоев выборки, поскольку их передающая функция не зависит от пространственного размера входных данных.

В случае полносвязных слоев этот принцип справедлив, поскольку полностью связные слои можно преобразовать в сверточный слой.

Скорость обучения .

Мы используем пониженную скорость обучения для точно настроенных весов DGNN, основываясь на том факте, что качество весов предварительно обученной DGNN относительно высокое.

Вы не хотите искажать эти данные слишком быстро или слишком сильно, поэтому и скорость обучения, и скорость затухания должны быть относительно низкими.

Увеличение данных .

Одним из недостатков нерегулярных нейронных сетей является их чрезмерная гибкость: они одинаково хорошо распознают как детали одежды, так и шум, что увеличивает вероятность переобучения.

Чтобы избежать этого, мы используем регуляризацию Тихонова (или регуляризацию L2).

Однако даже после этого между обучением и тестированием AR-изображений наблюдался значительный разрыв в производительности, что указывает на переобучение в процессе тонкой настройки.

Чтобы устранить этот эффект, мы применяем увеличение данных к набору данных изображений AR. Существует множество способов расширения данных, таких как горизонтальное зеркальное отображение, случайное кадрирование и изменение цветов.

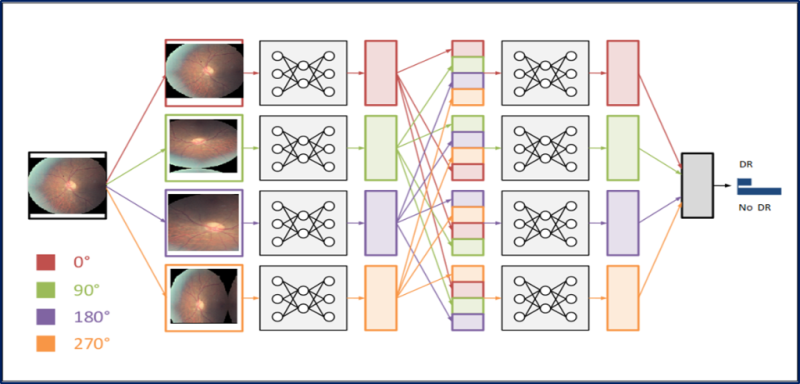

Поскольку информация о цвете этих изображений очень важна, мы поворачиваем изображения только на разные углы: 0, 90, 180 и 270 градусов.

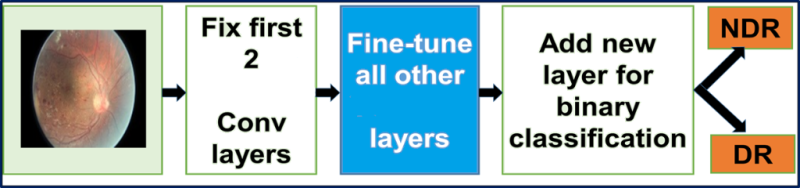

Замена входного слоя предварительно обученной сети GoogLeNet на AR-изображения.

Мы настраиваем все слои, кроме двух верхних предварительно обученных слоев, содержащих универсальные веса.

Тонкая настройка GoogLeNet. Сеть GoogLeNet, которую мы используем, изначально была обучена на наборе данных ImageNet. Набор данных ImageNet содержит около 1 миллиона естественных изображений и 1000 меток/категорий.

Наш размеченный набор данных AR содержит около 30 000 изображений, относящихся к рассматриваемому региону, и четыре метки/категории.

Следовательно, этого набора данных AR недостаточно для обучения такой сложной сети, как GoogLeNet: мы будем использовать веса из сети GoogLeNet, обученной на ImageNet. Мы настраиваем все слои, кроме двух верхних предварительно обученных слоев, содержащих универсальные веса.

Начальный уровень классификации потерь3/классификатора выдает прогнозы для 1000 классов.

Заменяем его новым бинарным слоем.

Заключение

Благодаря точной настройке усовершенствованные модели GPSN можно применять в новых областях, где в противном случае их было бы невозможно использовать из-за нехватки данных или ограничений по времени и затратам.Такой подход позволяет добиться существенного повышения средней точности и эффективности классификации медицинских изображений.

Если вы заметили неточность в переводе, сообщите об этом в личные сообщения.

Теги: #Машинное обучение #microsoft #Алгоритмы #Google #нейронные сети #Обработка изображений #нейронные сети #глубокое обучение #глубокое обучение #технологии будущего #медицина будущего #медицинские технологии #трансферное обучение #CNN #классификация изображений #глубокие сверточные нейронные сети

-

Органическая Химия

19 Oct, 24 -

Разбитое Стекло И Пиксель

19 Oct, 24