Я хотел рассказать об интересном эксперименте учёных, которые пытались запрограммировать человеческие культурные императивы морали в память роботов, чтобы проверить, смогут ли они вести себя как люди при принятии решений.

Замечу, что эксперименты достаточно жестокие, однако оценить возможности искусственного интеллекта каким-либо другим способом ученым показалось невозможным.

Сегодня роботы разрабатываются для автономного существования без вмешательства человека.

Как мы можем убедиться, что полностью автономная машина может действовать в соответствии с человеческой моралью и этикой? Именно этот вопрос и положил начало проблеме – «Машинная этика».

Можно ли запрограммировать машину так, чтобы она могла действовать в соответствии с моралью и этикой? Может ли машина действовать и оценивать свои действия с моральной точки зрения? Знаменитые фундаментальные законы Айзека Азимова (Три закона робототехники WIKI) призваны навязать этическое поведение автономным машинам.

Во многих фильмах можно встретить элементы этического поведения роботов, то есть автономных машин, принимающих решения, подобные человеческим.

Так что же это за «настоящий человек»? Международный журнал интеллектуальных систем, основанных на рассуждениях, опубликовал статью, в которой описываются методы компьютерного программирования, которые позволяют машинам действовать на основе гипотетических моральных рассуждений.

Работа называется - «Моделирование морали с помощью перспективной логики» Авторы работы Луис Мониш Перейра (Португалия) и Ари Саптавиджая (Индонезия) заявили, что «тика» больше не является уникальным свойством человеческой природы.

Ученые полагают, что они успешно провели эксперименты, моделирующие сложные моральные дилеммы роботов.

«Проблема с троллейбусом» (Задача о тележке) — такое название дали дилемме, предложенной роботам для решения.

И они считают, что смогли запрограммировать человека в соответствии с морально-этическими принципами человека.

«Проблема троллейбуса» моделирует типичную моральную дилемму — можно ли причинить вред одному или нескольким людям, чтобы спасти жизни других.

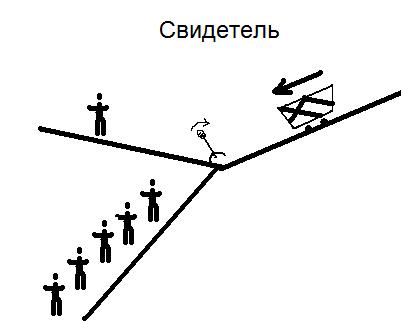

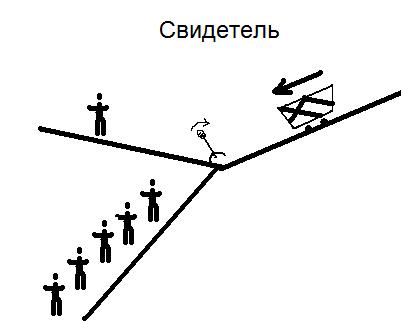

Первый эксперимент. «Свидетель»

Тележка вытаскивается из туннеля автоматическим тросом.

Почти на самом верху трос рвется и тележка летит вниз, а на ее пути стоят 5 человек, которые не успеют убежать, так как она едет слишком быстро.

Но выход есть – перенести стрелки и поставить троллейбус на запасной путь.

Однако на этом пути встречается один человек, который ничего не знает об аварии и тоже не успевает спастись.

Робот стоит на переключателе и, получив информацию о оборванном кабеле, должен принять моральное решение – что правильнее поступить в данной ситуации – дать умереть 5 людям или спасти их и принести в жертву одного на запасном пути.

Допустимо ли с моральной точки зрения щелкнуть выключателем и позволить человеку умереть на запасном пути? Авторы провели кросс-культурные исследования, в ходе которых людям задавали один и тот же вопрос.

Большинство людей во всех культурах согласились с тем, что робот может сдвинуть стрелку с мертвой точки и спасти больше людей.

И это именно то, что сделал робот. Сложность программирования заключалась в логике, которая не только вычитает число погибших, но и проникает в глубины морали.

Чтобы доказать, что решение не так просто, как кажется, ученые провели еще один эксперимент. Второй эксперимент. "Пешеходный мост" Ситуация такая же, как и в описанном выше случае (обрыв троса), только пути эвакуации нет. Теперь робот включен мост , рядом с ним стоит мужчина.

Прямо под мостом есть тропа, по которой после обрыва троса помчится троллейбус.

Робот может столкнуть человека на пути перед троллейбусом, затем он остановится или ничего не сделает, и тогда троллейбус раздавит пятерых человек, находящихся на путях внизу.

Допустимо ли с моральной точки зрения толкать кого-то на пути спасения других? Опять же, учёные провели кросс-культурные исследования по этому вопросу и получили результат – НЕТ, это не приемлемо.

В двух описанных выше вариантах люди дают разные ответы.

Можно ли научить машину думать так же? Ученые говорят, что им удалось запрограммировать компьютерную логику для решения таких сложных моральных проблем.

Они добились этого, изучая скрытые правила , которые люди используют при вынесении своих моральных суждений, а затем они смогли смоделировать эти процессы в логических программах.

В результате можно отметить, что компьютерные модели передачи морали до сих пор используют человека как образ и подобие.

Таким образом, от нас во многом зависит, какими будут новые, ответственные машины, которые будут принимать те или иные решения, исходя из этических императивов, заложенных в их программы.

Статью подготовил Евгений Евроевгений , получивший приглашение на эту статью, отклоненное в песочнице, от черт возьми , за что ему спасибо.

Теги: #искусственный интеллект #Робототехника #искусственный интеллект

-

Антивирус – Защитите Свой Компьютер

19 Oct, 24 -

Как Скачать Aol Gold Desktop

19 Oct, 24 -

Three.js И Геометрия

19 Oct, 24 -

Кори Доктороу, «Маленький Брат»

19 Oct, 24 -

Настройка Быстрого Набора

19 Oct, 24 -

Asp.net Mvc Урок F. Работа Как Есть

19 Oct, 24