Сегодня мы хотим поговорить о концепции Insight-Driven и о том, как реализовать ее на практике с помощью DataOps и ModelOps. Подход Insight-Driven — сложная тема, о которой мы подробно рассказываем в нашей недавно созданной библиотеке полезных материалов об управлении данными (ссылка будет ниже).

В сегодняшней хабратопике мы сосредоточимся на ключевых этапах жизненного цикла моделей машинного обучения, потому что… это одна из главных тем в рамках концепции.

В чем суть Insight-Driven подхода?

Многие эксперты говорят о важности Управляемый данными , что в целом, конечно, абсолютно правильно, поскольку данный подход предполагает более эффективное принятие управленческих решений посредством анализа данных, а не только интуиции и личного опыта управления.Аналитики Форрестера примечание что компании, которые полагаются на анализ данных в своей деятельности, растут в среднем на 30% быстрее конкурентов.

Но мы все понимаем, что компания движется вперед не от наличия данных как таковых, а от умения с ними работать — то есть находить инсайты, которые можно монетизировать и ради которых стоит собирать, обрабатывать и анализировать данные.

Поэтому мы говорим именно о подходе Insight-Driven, как о более продвинутой версии Data-Driven. Чаще всего, когда речь идет о работе с данными, большинство специалистов в первую очередь имеют в виду структурированную информацию внутри компании, однако не так давно мы говорили о том, почему подавляющее большинство предприятий вообще не используют около 80% потенциально доступных данных.

Insight-Driven создает основу для дополнения картины внешней неструктурированной информацией, а также результатов интерпретации данных для поиска неявных зависимостей между ними.

Обещанная ссылка на полную библиотеку материалов по управлению данными , где также есть упомянутое видео о неиспользованных данных.

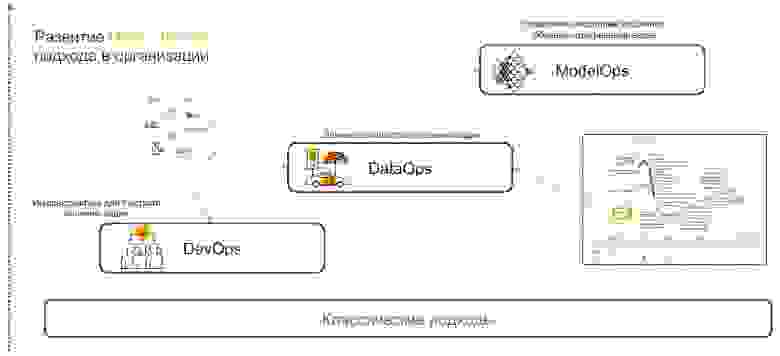

DevOps + DataOps + ModelOps

Insight-Driven основан на практиках DevOps, DataOps и ModelOps. Давайте поговорим о том, почему сочетание именно этих практик может обеспечить полную реализацию подхода.

DevOps+DataOps .

DevOps предполагает сокращение времени выпуска продукта, его обновлений и минимизацию затрат на дальнейшую поддержку за счет использования инструментов контроля версий, непрерывной интеграции, тестирования и мониторинга, а также управления релизами.

Если к этим практикам добавить понимание того, какие данные доступны внутри компании, как управлять их форматом и структурой, тегированием, контролем качества, преобразованием, агрегированием и умением быстро анализировать и визуализировать, то мы получим Операции с данными .

Целью этого подхода является реализация сценариев с использованием моделей машинного обучения, которые обеспечивают поддержку принятия решений, понимание и прогнозирование.

Модельные операции .

Как только компания начинает активно использовать модели машинного обучения, возникает необходимость управлять ими, отслеживать метрики качества, переобучать, сравнивать, обновлять и версионировать.

ModOps — это набор практик и подходов, упрощающих управление жизненным циклом таких моделей.

Его используют компании, которые имеют дело с большим количеством моделей в различных сферах бизнеса, например, стриминговых сервисах.

Внедрение Insight-Driven подхода в компании — нетривиальная задача.

Но для тех, кто все же хотел бы начать с ним работать, мы расскажем, как это сделать.

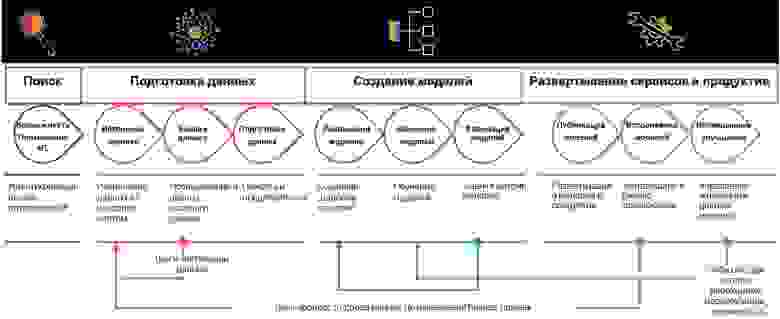

Поиск и подготовка данных

Внедрение практик Insight-Driven начинается с поиска и подготовки данных.Позже они анализируются и используются для построения моделей ML, но сначала выявляются случаи, в которых интеллектуальные алгоритмы могут быть полезны.

Определение задач .

На этом этапе компания ставит перед собой бизнес-цели, такие как увеличение прибыли на рынке.

Далее определяют бизнес-метрики для их достижения, такие как рост количества новых клиентов, размер среднего чека и процент конверсии.

Это создает сценарии, в которых вы можете искать соответствующие данные.

Поиск источников и анализ данных .

Когда цели и направления поиска данных определены, наступает время анализа источников.

На этом и последующих этапах разработки интеллектуальных сценариев, касающихся подготовки листья 70–80% бюджета компании при реализации.

Дело в том, что качество набора данных влияет на точность проектируемых моделей машинного обучения.

Но необходимая информация часто «разбросана» по различным системам — она может лежать в реляционных базах данных, таких как MS SQL, Oracle, PostgreSQL, на платформе Hadoop и многих других источниках.

И на этом этапе необходимо понять, где находятся соответствующие данные и как их собрать.

Аналитики часто загружают и обрабатывают все вручную, что сильно замедляет процессы и увеличивает риск ошибок.

Мы в SAP предлагаем нашим клиентам внедрить метасистему, которая подключается к нужным источникам и собирает данные по требованию.

Таким образом, вы можете каталогизировать все таблицы, внешние пулы с неструктурированными данными и другие источники — устанавливать теги (в том числе иерархические) и быстро собирать актуальную информацию.

Условно, если информация о клиенте находится в разных базах данных, то достаточно обозначить эти сущности.

В следующий раз, когда вам понадобится «набор клиентских данных», вы выберете уже готовую витрину.

После определения источников данных вы можете перейти к мониторинг качества данных и профилирование .

Эта операция необходима, чтобы понять количество пропущенных значений, уникальных значений и проверить общее качество данных.

Для всего этого вы можете строить дашборды с правилами и отслеживать любые изменения.

Преобразование данных .

Следующий шаг — непосредственная работа с данными, которые должны решить поставленные задачи.

Для этого данные очищаются: проверяются, дедуплицируются и заполняются пробелы.

Вы можете упростить этот процесс, используя программирование на основе потоков.

В данном случае мы имеем дело с последовательностью операций – конвейером.

Его выходные данные могут быть отправлены в графический интерфейс или другую систему для последующей работы.

Здесь обработчики данных собираются в виде конструктора (и в зависимости от сценария).

Это может быть периодическая или потоковая обработка или служба REST.

Концепция потокового программирования подходит для решения широкого круга задач: от прогнозирования продаж и оценки качества обслуживания до поиска причин оттока клиентов.

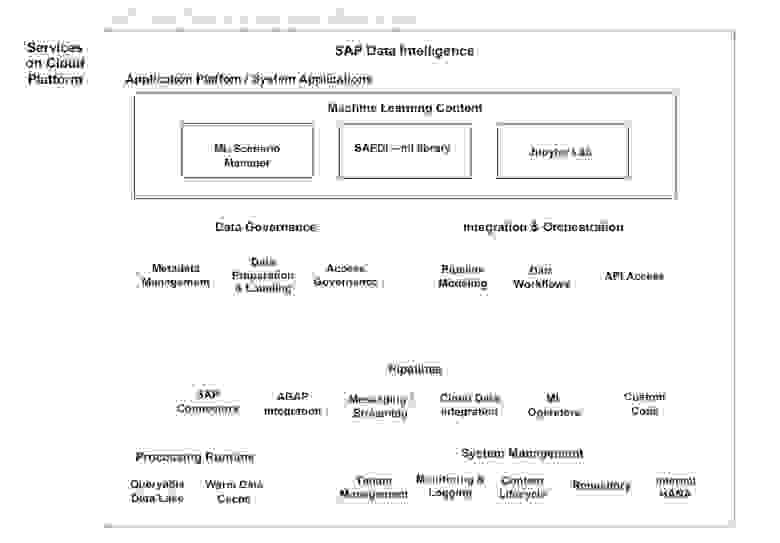

В SAP есть два инструмента для поиска и подготовки данных.

Первый - SAP-аналитика данных для аналитиков данных.

В отличие от аналогичных платформ, это решение работает с распределенными данными и не требует централизации — оно предоставляет единую среду для внедрения, публикации, интеграции, масштабирования и поддержки моделей.

Второй инструмент - Подготовка данных SAP Agile — небольшой сервис по подготовке данных, предназначенный для аналитиков и бизнес-пользователей.

Он имеет простой интерфейс, который помогает собирать набор данных, фильтровать, обрабатывать и сравнивать информацию.

Его можно опубликовать на витрине для передачи в Self-Service BI — системы самообслуживания для создания аналитических сценариев (они не требуют глубоких знаний в области науки о данных).

Создание моделей

После подготовки пришло время создавать модели машинного обучения.Здесь различают: исследование, прототипирование и продуктивность.

Последний этап предполагает внедрение конвейеров для обучения и применения моделей.

Исследования и прототипирование .

В настоящее время доступно множество тематических фреймворков и библиотек.

Лидерами по частоте использования являются TensorFlow и PyTorch, популярность которых за последний год вырос на 243%.

Платформа SAP позволяет использовать любой из этих фреймворков и может быть гибко дополнена такими библиотеками, как CatBoost от Яндекса, LightGBM от Microsoft, scikit-learn и pandas. Вы также можете использовать Кадр данных HANA в библиотеке Ханамл.

Этот API имитирует панды, а HANA позволяет обрабатывать большие объемы данных с помощью отложенной оценки.

Для прототипирования моделей мы предлагаем Jupyter Lab. Это инструмент с открытым исходным кодом для специалистов по данным.

Мы интегрировали его в экосистему SAP, одновременно расширив его функционал.

Jupyter Lab работает на платформе Data Intelligence и благодаря встроенной библиотеке sapdi может подключаться к любым источникам данных, подключенным на предыдущих шагах, отслеживать эксперименты и показатели качества для их дальнейшего анализа.

Отдельно стоит отметить, что блокноты, наборы данных, конвейеры обучения и вывод , а также сервисы для развертывания моделей должны быть согласованными.

Для объединения всех этих объектов используется скрипт ML (версионный объект).

Модельное обучение .

Есть два варианта работы со скриптами ML. Есть модели, которые вообще не нужно обучать.

Например, в SAP Data Intelligence мы предлагаем распознавание лиц, автоматический перевод, OCR (оптическое распознавание символов) и другие.

Все они работают из коробки.

С другой стороны, есть те модели, которые нуждаются в обучении и продуктивности.

Такое обучение может проходить как в самом кластере Data Intelligence, так и на внешних вычислительных ресурсах, подключаемых только на время вычислений.

«Под капотом» в SAP Data Intelligence находится платформа Kubernetes, поэтому все операторы привязаны к докер-контейнерам.

Для работы с моделью достаточно описать docker-файл и прикрепить к нему теги для используемых библиотек и версий.

Другой способ создания моделей — использование AutoML. Это автоматизированные системы МО.

Такие инструменты разрабатываются H2O , Майкрософт , Гугл и т. д. .

Они тоже работают в этом направлении в Массачусетском технологическом институте .

Но университетские инженеры не сосредотачиваются на внедрении и производительности.

SAP также имеет систему AutoML, которая обеспечивает быстрые результаты.

Он работает в HANA и имеет прямой доступ к данным — его не нужно никуда перемещать или изменять.

Сейчас мы разрабатываем решение, ориентированное на качество моделей — о выпуске сообщим позже.

Управление жизненным циклом .

Условия меняются, информация устаревает, поэтому точность моделей ML со временем снижается.

Соответственно, накопив новые данные, вы сможете переобучить модель и уточнить результаты.

Например, один крупный производитель напитков использует информацию на предпочтениях потребителей в 200 разных странах для переподготовки интеллектуальных систем.

Компания учитывает вкусы людей, количество сахара, калорийность напитков и даже продукцию, предлагаемую конкурирующими брендами на целевых рынках.

Модели машинного обучения автоматически определяют, какой из сотен продуктов компании будет лучше всего принят в данном регионе.

Повторное использование компонентов на основе операторов в SAP Data Hub

Но модели также нуждаются в версии и обновлении по мере выпуска новых алгоритмов и обновлений аппаратных компонентов.

Их реализация позволяет повысить точность и качество моделей, используемых в работе.

Инсайты для роста бизнеса

Описанный выше подход к управлению этапами жизненного цикла моделей машинного обучения представляет собой, по сути, универсальную структуру, которая позволяет компании стать Insight-Driven и использовать данные в качестве ключевого драйвера роста бизнеса.Организации, воплощающие эту концепцию, знают больше, растут быстрее и, на наш взгляд, гораздо интереснее работают на этом переднем крае технологий! Узнайте больше о создании концепции Insight-Driven в нашем библиотека полезных материалов по управлению данными , где мы собрали видеоролики, полезные брошюры и пробный доступ к системам SAP. Теги: #Машинное обучение #базы данных #postgresql #DevOps #Большие данные #Hadoop #машинное обучение #Бизнес-модели #oracle #data-driven #база знаний #sap #library #инструменты баз данных #agile development #dataops #dataops #ms sql #insight -Driven #modelops #программирование на основе потоков #концентратор данных

-

Сайт Сына Подруги Моей Матери

19 Oct, 24 -

Создайте Шрифт, Имитирующий Ваш Почерк

19 Oct, 24 -

Outernet: Где Не Работает Интернет

19 Oct, 24 -

Россия Может Спасти Mysql

19 Oct, 24 -

Канобувости, 39-Й Выпуск

19 Oct, 24