После презентации новой линейки видеокарт серии RTX 3000 производитель графических чипов Nvidia столкнулся с беспрецедентным спросом на свои новинки.

Превышение розничной цены на топовые модели RTX 3080 и RTX 3090 составляет $500 и более, что на 30-60% превышает рекомендованную цену.

Причем проблемы с новыми RTX не заканчиваются просто завышением цен относительно заявленных на презентации.

Таким образом, одним из официальных торговых партнеров MSI стал попал в спекуляцию новые видеокарты на интернет-аукционах, а сами Nvidia заявляют, что купить новые RTX 3080 и RTX 3090 по адекватной цене можно будет не раньше следующего года.

При этом выпуск и поступление в продажу «вкусной» карты RTX 3070 и вовсе перенесли на две недели, с 15 на 29 октября 2020 года.

Человек, далекий от ПК-гейминга и выпуска флагманских моделей железа, справедливо спросит: «Вы там совсем с ума сошли? Какие $1200-1500 за видеокарту? Что такое срочный спрос? Что происходит?" Итак, теперь я, автор статьи, объясню, почему у Nvidia такой ажиотаж вокруг серии RTX 3000 и почему геймеры с нетерпением ждут продажи этих видеокарт по заявленной цене.

Нет сомнений в том, что серия RTX 3000 — это игровые карты.

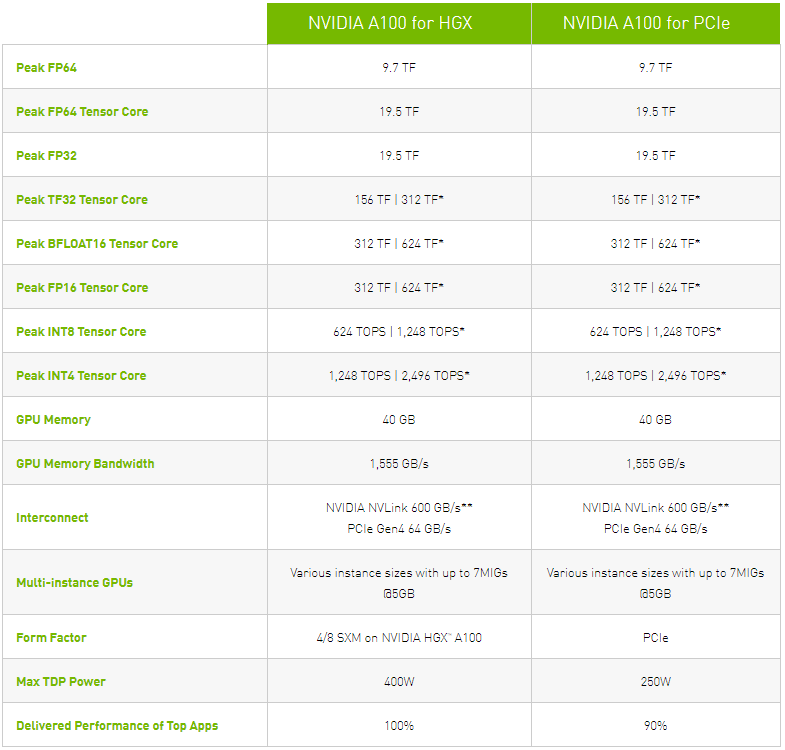

Для вычислений и науки у Nvidia уже давно есть серии карт Тесла В100 И Тесла А100 .

Это мощные графические ускорители стоимостью в тысячи долларов, задача которых предельно проста и очевидна – считать.

Более того, рассмотрим, по сути, всякие «научные штучки» в составе вычислительного кластера.

Новый A100, который сейчас выходит на ограниченное тестирование, по данным Nvidia, в 6 раз производительнее далеко не слабого V100. Собственно, о возможностях этих карт можно судить по официальным характеристикам с сайта Nvidia:

Я говорю о семействе ускорителей Tesla по одной причине: Амперная архитектура .

Именно это лежит в основе графических ускорителей Tesla, а до сих пор карты Ampere стоили до $10 тысяч и имели очень узкую специализацию.

В первую очередь ускорители Ampere были нацелены на обучение нейронных сетей и, по словам производителя, с этой задачей они справились на порядки лучше других решений.

По официальным данным, карты на базе Ampere ускорили обучение нейросетей до 20 раз.

Но теперь Nvidia выпускает потребительские видеокарты для геймеров, использующие ту же технологию.

Это как если бы Intel с 2016 года клепала серверные процессоры на 2 нм литографиях для суперкомпьютеров, каждый из которых стоил бы $10 тысяч и выше, а потом вдруг вбрасывает новую серию Intel Core по $500 за штуку, использующую ту же технологию.

Там будет длинная очередь.

Для Nvidia все выглядело прекрасно: больше мощности за меньшую цену по сравнению с триумфальной серией RTX 2000, «научная» архитектура в геймерских компьютерах, поддержка более высоких разрешений и так далее, и тому подобное.

Но коридоры Nvidia не ожидали, насколько потребителю нужна мощная видеокарта и что RTX 2080 Ti уже давно не удовлетворяет всем потребностям рынка.

Хотя серия RTX 3000 не демонстрирует многократного превосходства над RTX 2080 и RTX 2080 Ti, и грядущий хит продаж — «бюджетная» карта RTX 3070 всего на десять процентов производительнее флагмана предыдущего поколения (опустим полунизкая стоимость на данный момент), рынку очень нужны эти видеокарты.

Давайте немного проанализируем, как измеряют себя на своих презентациях производители нестандартного железа, то есть каких «попугаев» они используют, чтобы продемонстрировать свое превосходство.

Нанометры, количество ядер, частоты, TDP и так далее

Если говорить о процессорах и видеокартах, то главным аргументом любого выступающего, идущего по сцене и представляющего публике новый продукт, будет размер техпроцесса и количество логических и других ядер.Сколько потоков, какой термопакет у нового камня, какую систему охлаждения придумали аккумуляторные конструкторы в недрах компании.

Конечно, есть абстрактное сравнение «производительности» с оборудованием конкурентов и с оборудованием собственного производства, но предыдущего поколения.

Все это добавляет презентационности и заставляет аудиторию покачивать головой в такт наставлениям спикера.

На самом деле иронии здесь минимум.

Компании действительно достигают впечатляющих результатов по всем этим показателям.

Особенно радует TDP процессоров «красного лагеря»: AMD последовательно увеличивает производительность своих «камней», сохраняя при этом стандартный тепловой пакет на уровне 65-105 Вт. Это позволяет избежать громоздких систем охлаждения, как во времена «электровафельниц» поколения FX, чей недостаточно большой термопакет стал легендой.

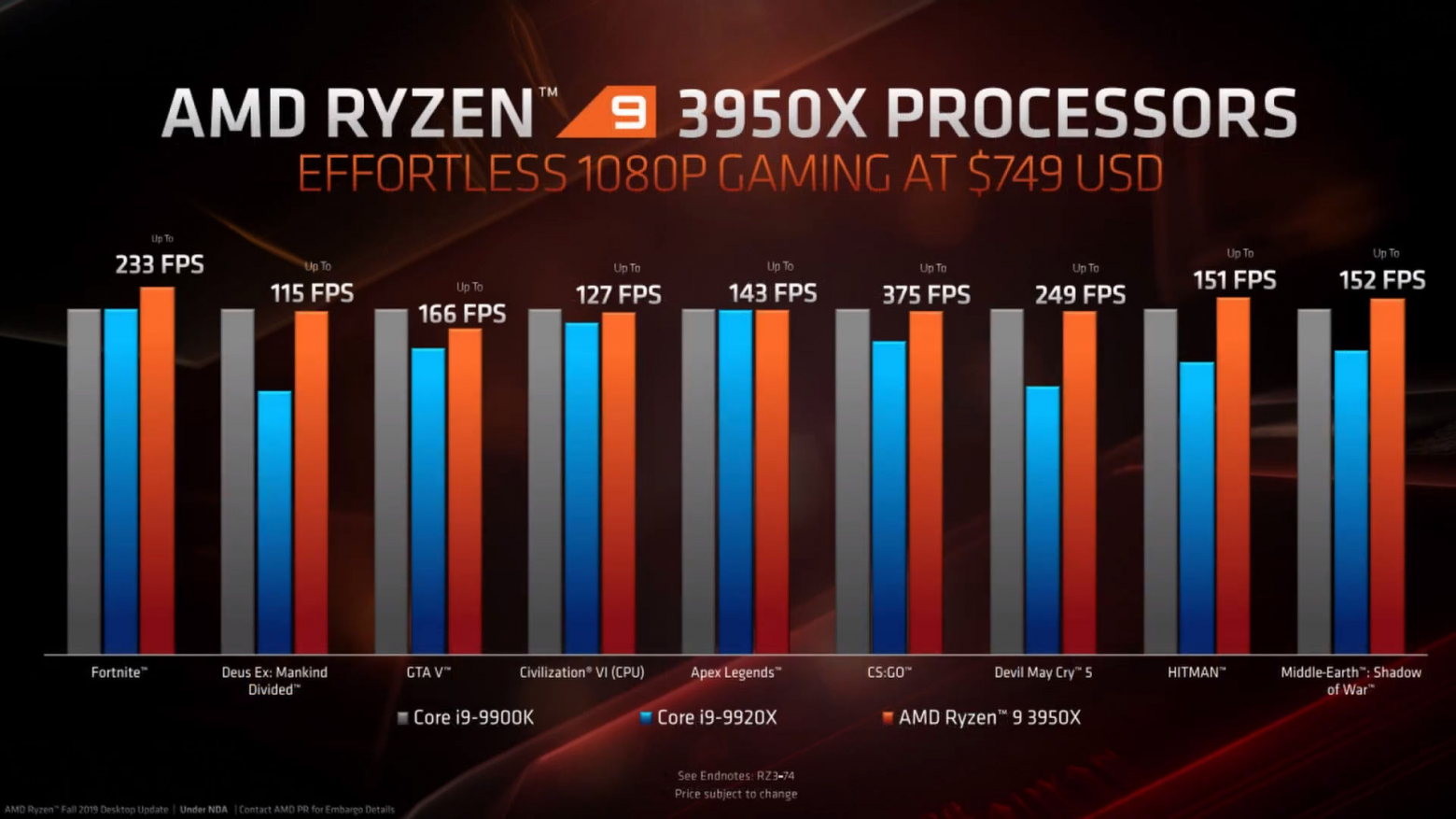

ФПС в играх

Но этот параметр всегда стоит отдельно.Как не удивительно, но и на презентации центральных процессоров, и на презентации видеокарт всегда показывают количество кадров в секунду в самых последних и популярных играх.

Последние несколько лет от презентации к презентации мелькают Fortnite, Call of Duty, Battlefield, Apex Legends, Control — словом, все те игры, которые вредят видеокарте на максимальных настройках графики.

В этом году «задели» в разрешении 8к.

Для закрепления можно показать точно такой же слайд с презентации процессоров серии Ryzen 5000, которая прошла около двух недель назад:

И все эти колонны всегда выглядят очень красиво и приятно.

С каждым поколением производительность видеокарт и центральных процессоров в играх увеличивается, и именно для игр в основном производится это железо.

Но все не так просто.

Почему все геймеры мира хотят оторвать руки разработчикам игр?

Одна из главных причин, почему геймеры всего мира бросились заказывать новые RTX 3080 и RTX 3090 в надежде получить карту любой ценой, — это не глупость этих самых геймеров и даже не желание «опробовать революционные 8К» и так далее.Основная причина — желание получить хоть сколько-нибудь стабильную производительность, соответствующую возможностям современной периферии, в первую очередь мониторов.

Для людей далеких от игровой индустрии открою один секрет: 60 FPS больше не стандарт .

Да, почему-то на презентациях производители до сих пор говорят о «стабильных 60 кадрах в секунду», как будто такая производительность обеспечивает идеальный игровой процесс, но дело в том, что на рынке игрового оборудования уже давно доминируют мониторы с частотой обновления экрана в 144. Гц, а на пятках, стремительно дешевеющих, идут мониторы с частотой 240 Гц.

Это значит, что для плавной картинки на этих экранах нужен соответствующий FPS: 144 и 240 кадров соответственно.

И здесь кроется корень проблем всей отрасли.

Если раньше экраны с высокими Гц были прерогативой киберспортсменов, игроков в CS:GO и Quake, то теперь у любого уважающего себя игрока есть 144 Гц.

60 кадров ушли в прошлое: теперь это стандарт для бюджетных «офисных» мониторов, ведь частота 144 Гц дает ощутимое преимущество.

Трудно описать словами эффект от высокогерцового монитора, но я попробую: представьте, что все вдруг стало двигаться немного медленнее и гораздо плавнее.

В движении эффект размытия пропадает и начинаешь замечать мельчайшие детали.

Вращение камеры вокруг своей оси больше не вызывает дезориентации, вы продолжаете ясно видеть мир вокруг персонажа.

На рабочем столе движение курсора теперь стало гораздо более очевидным: если на частоте 60 Гц резким движением мыши вы зафиксируете взгляд на курсоре мыши в 5-6 местах, то уже на частоте 144 Гц вы увидите его одновременно.

в 15-20 баллов.

На экранах с частотой 240 Гц эффект еще более впечатляющий; вы можете буквально захватить глазами весь путь курсора мыши на высокой скорости.

Для иллюстрации хорошо подходит знаменитый кадр из CS:GO, демонстрирующий разницу в тикрейтах серверов.

Примерно то же самое происходит и на высокогерцовых мониторах с точки зрения рендеринга движения:

Именно поэтому, чтобы наглядно отображать происходящее в мельчайших деталях, все геймеры на планете уже плавно перешли на дисплеи с частотой 144 и 240 Гц, а те, кто не перешел, либо мечтают о переключении, либо играют исключительно в пасьянсы.

Но при этом мы по-прежнему упорно убеждены, что 60 FPS — это достаточный показатель производительности.

Разработчики игр и производители оборудования уделяют особое внимание этому параметру.

Однако как только дело доходит до запуска игры на стабильных 144 FPS или, не дай Бог, 240 FPS, даже на минимальных настройках графики, начинает происходить нечто непонятное: никакое существующее оборудование толком не справляется с этой задачей.

Возьмем две самые «отмененные» игры современности с точки зрения производительности: Call of Duty: Warzone и Apex Legends. Оба были сделаны совершенно разными студиями.

Первую производит Activision Blizzard, вторую — Respawn Entertainment под патронажем Electronic Arts. Обе игры принадлежат к популярному жанру Battle Royale, обе имеют обширные карты и огромную базу фанатов.

Для обеих игр буквально с момента их выхода инженеры Nvidia истерично клепали патчи видеодрайверов, чтобы хоть как-то заставить их работать.

Именно инженерные команды авторов драйверов наверняка в курсе, что игроков совершенно не волнуют 60 FPS, вертикальная синхронизация и все, что увеличивает инпут-лаг.

Им нужен максимально стабильный персонал.

по крайней мере на топовых видеокартах .

Если не верите этому утверждению, можете сами погуглить: в сети есть сотни статей об увеличении FPS в Call of Duty и Apex Legends, сотни тредов о конфигах, позволяющих уменьшить графику или удалить «лишние» модели для уменьшения нагрузка на видеокарты, а также много историй про шаманство, ускорение железа и прочие танцы с бубном.

Просадки производительности в топовых онлайн-играх, особенно в динамичных шутерах, — болезненная реальность игровой индустрии последних лет. Разработчики буквально забивают производительность своих продуктов за пределы 60 FPS и включенной вертикальной синхронизации, которая погружает камеру в желе и создает чудовищную задержку ввода, заставляя игроков вкладывать средства во все более мощное оборудование.

Скажу больше, все настолько плохо, что RTX 2080 Ti в этих играх способна выдавать стабильные 144-190 кадров в секунду только при минимальных настройках графики, но и тогда иногда случаются падения FPS! Любая граната, блики или огонь в кадре - и все, твои кадры машут на тебя рукой и говорят "ну когда это закончится, ты наберешь", FPS падает до сотни.

Ситуация уже стала настолько безумной, что Nvidia вынуждена выпустить официальные руководства по настройке видеокарты и графики в игре, чтобы выжать из нее нужные значения кадров, комфортные для игроков! Именно по этой причине значительная часть геймеров бросилась покупать новые RTX 3080 и RTX 3090 просто в надежде, что на этих картах их любимые игры смогут стабильно работать хотя бы на минимальных настройках графики.

Это не заговор, это культура нулевого развития

Сейчас рынок буквально в ловушке.С одной стороны, с каждым годом выходит все более мощное оборудование.

Банально, что память DDR4-1600, считавшаяся пять лет назад «неплохой», теперь перешла в разряд «медленных офисных», а некогда топовая DDR4-2400 теперь является просто середнячком.

То же самое происходит с процессорами, видеокартами, скоростями дисков и так далее и тому подобное.

Неопытному, далекому от игр пользователю, может показаться, что конфигурации i9-10900k, DDR4-3200, разогнанной до 4000 МГц, всего этого с быстрым SSD и RTX 2080 Ti должно хватить на что угодно на ультра настройках, но это правда.

в том, что эта конфигурация едва обеспечивает 144-200 FPS в новых проектах.

Вычеркните любой компонент из списка выше и вставьте что-нибудь «попроще и дешевле», например, RTX 2060S или Core i7, и частота кадров упадет как минимум на 30%.

И тут виновата не жадность производителей оборудования, а неуклюжесть разработчиков и жажда наживы их издателей.

Промышленность настолько заморачивалась с тестированием и оптимизацией потребления ресурсов в 2019-2020 годах, что если бы это было реально, это было бы видно с МКС.

Лучшим примером является сравнение Apex Legends и предыдущей игры Respawn Entertament Titanfall 2.

Первый был сделан в спешке, под постоянным давлением со стороны издателя, который бормотал на ухо команде разработчиков: «Нам срочно нужна своя королевская битва со скинами и лутбоксами».

В результате мы получили перспективный с точки зрения геймплея проект (он основан на многих механиках и лоре Titanfall 2), с абсолютно нулевой оптимизацией и отвратительным сетевым кодом.

Titanfall 2, вышедший в 2016 году, почти всегда выглядит лучше и работает в разы стабильнее даже на средних конфигурациях железа, чем модная Apex Legends, которую быстро собрали, чтобы составить конкуренцию PUBG и Fortnite. Человек, не знакомый с проектами, вообще подумает, что Apex вышел в 2015-2016 году, а Titanfall 2 — свежий релиз, если показать ему их одновременно, хотя все с точностью до наоборот. Та же мрачная история происходит с Call of Duty и другими недавними проектами.

Потребитель превратился в бесконечного бета-тестера, которому постоянно приходится выбирать между покупкой нового, более мощного железа или лагами.

.

Кстати, именно по этой причине многие сомневаются в будущем новых Xbox и PS5: если даже современные ПК не могут толком справиться с современными играми, то что же могут сделать консоли? Будут ли кроссплатформенные онлайн-проекты достаточно оптимизированы для игры? Опыт PS4 Pro и Call of Duty или Apex Legends показывает, что консоли просто не справляются с продуктами, почти полностью состоящими из кода сомнительного качества.

А размер Call of Duty в 200+ ГБ просто легендарный.

Как это изменить

Я надеюсь, что однажды Nvidia устанет тратить силы и ресурсы на выпуск бесконечных патчей драйверов, улучшающих производительность в проблемных популярных играх.За последние два-три года, с ростом популярности Fortnite, Apex Legends и Call of Duty Warzone, производитель железа выпустил очень много патчей драйверов и технологий, которые позволили бы улучшить производительность в этих проектах (а это как минимум того стоит).

Нвидиа Рефлекс , что программно значительно уменьшает задержку ввода в Apex Legends и Warzone), от чего кружится голова.

За этот период я обновлял драйверы чаще, чем за предыдущие 10 лет вместе взятые.

Абсолютно знакомая картина при входе в NVIDIA GeForce Experience

Кажется, из этой ситуации есть только один выход. Остановить порочную практику «ошибка и ошибка в производстве, а потом Nvidia выкатит патч оптимизации» можно только в том случае, если сама Nvidia объявит, что разработчики игр ведут себя, мягко говоря, плохо, и вдолбит оптимизацию .

Должна быть очередная война в стиле «Epic Games VS Apple», только в этом случае с одной стороны будет производитель видеокарт, а с другой — издатели игр, которые стоят с кнутом и гоняются за разработчиками, требуя от них новые лутбоксы и сезоны в ущерб качеству основного кода.

Но это произойдет только в том случае, если Nvidia наконец преодолеет свое желание продавать как можно больше флагманских карт и выступит против творящейся в игровой индустрии вакханалии, у нас есть шанс получить нормальную производительность в игровых проектах и отсутствие ажиотажного спроса на новое видео.

модели карт. Просто трудно в это поверить.

Теги: #Разработка игр #Производство и разработка электроники #Игры и игровые приставки #nvidia #Компьютерное оборудование #Видеокарты #железо #спрос #хайп

-

Macosx Leopard (10.5) Появился В Торрентах

19 Oct, 24 -

У Вас Есть Ощущение, Что Нас Обманывают?

19 Oct, 24 -

Блоги На Русском Языке

19 Oct, 24 -

Первая Книга О Джанго На Русском Языке

19 Oct, 24