Не так давно Сбер, а затем и Яндекс объявили о создании сверхбольших русскоязычных моделей, аналогичных GPT-3. Они не только генерируют правдоподобный текст (статьи, песни, блоги и т. д.), но и решают множество различных задач, причем зачастую эти задачи можно ставить на русском языке без программирования и дополнительного обучения — что-то очень близкое к «универсальному» искусственному интеллекту.

Но, как пишут в своем блоге авторы «Сбера», « такие эксперименты доступны только компаниям со значительными вычислительными ресурсами Обучение моделей с миллиардами параметров стоит несколько десятков, а то и сотен миллионов рублей.

Получается, что отдельные разработчики и небольшие компании теперь исключены из процесса и теперь могут использовать только модели, обученные кем-то другим.

В этой статье я расскажу попробуйте оспорить этот тезис, рассказав о результатах попытки обучения модели с 30 миллиардами параметров на двух картах RTX 2080Ti.

Как построена эта статья, какие части читать не нужно

В первой части я кратко объясню, что такое языковая модель и что она предоставляет. Если вы это знаете, вы можете пропустить первую часть без каких-либо повреждений.Во второй части объясняется, в чем проблема с обучением больших моделей, и обсуждаются возможности ее решения.

Третья часть рассказывает о результатах попытки обучения модели с 30 миллиардами параметров на двух картах RTX 2080Ti. В заключение обсудим, почему нужно заморачиваться с самообучением языковых моделей.

Эта часть несколько субъективна и выражает мое личное мнение, если субъективное мнение вам не интересно, то можете ее пропустить.

В целом я постарался сделать статью понятной для широкого круга разработчиков и самодостаточной, поэтому включил небольшую предысторию по вопросу и пояснение важных терминов, в результате чего статья получилась немного раздутой.

Знатоки могут отметить, что некоторые вещи не объяснены точно или полностью, но здесь я постарался предпочесть интуитивное изложение математически строгому.

После этого предисловия перейдем к основному изложению.

Что такое языковые модели и почему это важно?

Говоря простым языком, языковая модель — это способ оценки вероятности получения следующего слова на основе предыдущего текста (вместо слова может использоваться буква или часть слова, но для сути это не важно) .Представьте, например, что мы хотим сгенерировать что-то похожее на текст. В первом приближении мы можем просто взять словарь всех слов и расположить их в случайном порядке.

паразитическая мания цзяо прозорова яшара левый берег для борьбы с последователями волноводной птицыВыглядит не очень хорошо.

Во втором приближении мы можем взять реальный текст и расставить слова с частотами, с которыми они в нем встречаются.

Вы получите что-то более интересное:

большие обработанные счета для писем составили бумажные миллионы, несмотря на первоеЭто все еще ерунда, но выглядит более знакомо.

Продолжая процесс, мы можем учесть вероятность встретить следующее слово после предыдущего:

из числа сохранившихся - книги лучших поэтов, из которых выполнена форма книгиЗдесь уже можно попытаться представить какой-то смысл, но ничего особенно сложного мы не сделали.

Языковые модели на основе нейросетей работают по похожему принципу, но правила выбора слова в них не заложены изначально — они просто берут большую нейросеть, ставят на выходе задачу «угадать» следующее слово и тренироваться на большом массиве текстов.

Такие модели после обучения создают текст, который очень сложно отличить от того, что написал человек, например такой:

Удача – это способность человека, обладающего ею, использовать благоприятные обстоятельства для достижения своих целей.Помимо очевидной возможности замены копирайтеров языковой моделью, есть и более серьезные последствия.Если вы хотите разбогатеть, то вам необходимо позаботиться о том, чтобы обстоятельства, с которыми вы столкнетесь, были благоприятными.

Дело в том, что умение предсказывать следующее слово подразумевает и умение решать различные задачи, например, умение правильно предсказать слово в контексте « Петя подарил Васе два арбуза.

Сколько арбузов у Васи? Отвечать:" равно способности решить простую задачу.

На другой стороне " Программа для определения того, является ли строка палиндромом: «Это тоже текст, а дальше все ограничивается размером модели и степенью нашей фантазии.

Понятно, что такая магия интересует многих и имеет потенциально серьезные последствия для многих сфер.

Упоминания о возможности этого явления можно встретить в литературе десятилетней давности, но убедительно оно было продемонстрировано лишь недавно в работах исследователей Google Brain [1] и OpenAI [2,3] Следует, однако, добавить, что языковая модель, используемая в этом режиме, является простым, но зачастую не лучшим способом решения задачи с точки зрения точности и стоимости вычислительных ресурсов, однако это позволяет сэкономить рабочее время, необходимое для разработки.

специализированное решение.

В чем проблема с обучением больших моделей?

Что необходимо для создания языковой модели? Исходный код нейронной сети теперь не является проблемой; он общедоступен в различных версиях.Основная проблема – ресурсы.

Ресурсы нужны двух типов – тексты и расчеты.

Посмотрим, сколько вычислительных ресурсов потребовалось Сберу и Яндексу для обучения моделей русского языка: Таблица 1. Ресурсы, необходимые для обучения больших языковых моделей*

| Модель | Количество параметров в модели | Время обучения графического процессора/час | Количество графических процессоров, используемых во время обучения | Ориентировочная стоимость вычислений при аренде ресурсов в облаке, руб.

|

| RuGPT3-маленький | 117 миллионов | 5376 | 32 | 940 тысяч |

| RuGPT3-средний | 345 миллионов | 32256 | 64 | 5,6 миллиона |

| RuGPT3-большой | 762 миллиона | 43008 | 128 | 7,5 миллионов |

| РуГПТ3-XL | 1.3 миллиарда | 61440 | 256 | 10,7 миллиона |

| РуГПТ3-12Б | 12 миллиардов | 609484.8* | ? | 106 миллионов |

| ЯЛМ-10Б | 13 миллиардов | 626688.0 | ? | 109 миллионов |

На самом деле эта работа требует множества предварительных экспериментов и работы специалистов, что также является значительной статьей затрат. **Для этих моделей точных данных о затратах на обучение найти не удалось, цифры приблизительные, исходя из количества параметров и стоимости обучения аналогичных моделей от OpenAI. Заметка об истории обучения российских GPT-подобных моделей Фактически, еще до Сбербанка существовали российские версии GPT-2 с 340 млн и 1,5 млрд параметров.

Их обучали энтузиасты, инициализируя веса моделей с весами английского GPT-2 и постепенно «размораживая» веса этих слоев (можно прочитать например здесь ).

Поэтому заявление Сбера о первом российском GPT-3 не совсем корректно, учитывая, что модели ruGPT3-small и ruGPT3-large являются GPT-2 и по размерам, и по архитектуре, отличаясь лишь длиной контекста.

Главным преимуществом GPT-3 перед GPT-2 является не длина контекста, а его размер, а главным в публикации OpenAI был анонс модели со 175 миллиардами параметров, тогда как ценность остальных вариантов была в возможности сравнительного анализа.

Поэтому ruGPT3 лишь формально является GPT-3, но на самом деле он ближе к GPT-2, поскольку в очень больших языковых моделях размер принципиально важен.

Поэтому было бы неплохо, если бы крупные компании, рассказывая о своих достижениях, помещали их в общий контекст, а не игнорировали предыдущие работы, как будто их вообще не существовало.

Другое дело, что степень «доподготовки» предыдущих моделей, вероятно, была недостаточной и убедительного численного сравнения их характеристик не проводилось (или я об этом не знаю).

Обучение «настоящего» GPT-3 со 175 миллиардами параметров требует в этих условиях абсурдно большой суммы в миллиард рублей.

С другой стороны, на самом деле подход, когда берут монолитную модель и увеличивают ее в размерах, довольно топорный.

Это легко для компаний, у которых много денег и которые не хотят рисковать, придумывая другие подходы, потому что это концептуально просто и предсказуемо.

Но есть основания полагать, что этот метод не самый лучший.

Например, биологический мозг не работает таким образом.

Мозгу не нужно рассчитывать выходы каждого из 100 миллиардов нейронов для какого-либо действия — он умеет использовать только те части, которые действительно нужны для конкретной задачи.

Аналогично, если мы выучим новое слово, это не означает, что «веса» всех нескольких триллионов синапсов обновятся.

Примечание: маленький мозг не значит глупый Часто полагают, что «интеллектуальная» функция — сложное и гибкое поведение, способность к инновациям и обучению — требует большого, высокоразвитого мозга и присуща только людям и, в некоторой степени, высокоинтеллектуальным животным, таким как шимпанзе и дельфины.

Более примитивные существа, поведение которых обычно определяется инстинктами, имеют небольшой, относительно простой мозг, состоящий из сравнительно небольшого числа нейронов.

Но есть много интересных примеров обратного.

Например, пауки рода Порция имеют мозг размером с булавочную головку, но весьма замечательные интеллектуальные способности.

Порция не обычный паук – это хищник, ловящий в пищу пауков других видов.

Одной из его замечательных способностей является способность прокладывать путь к своей добыче.

Для животного, действующего инстинктивно, если что-то находится вне поля зрения, то оно находится вне разума.

Однако Порция часами выслеживать свою жертву, даже если это означает надолго потерять жертву из виду, решая при этом задачу, сложную даже для человекообразных обезьян [4] Обычные пчелы могут научиться распознавать абстрактные атрибуты объектов, такие как радиальная и двусторонняя симметрия, использовать символы, нарисованные на стенах, для навигации по лабиринту и даже освоить сопоставление отложенного стимула с образцом — задача, которая лежит в основе многих батарей когнитивных тестов, ориентированных на человека.

.

Эта идея реализована, например, в архитектуре Mixture of Experts (MoE).

Этот подход стал известен после публикации [5].

Суть в том, что существует некий переключатель, который для каждого шага выбирает несколько «экспертов», т.е.

частей модели со своим набором весов, что уменьшает необходимое количество вычислительных операций (общий принцип упрощен на рис.

1).

Рисунок 1. Упрощенная иллюстрация механизма «Смесь экспертов» В 2020 году исследователи Google Brain упростили этот подход, оставив на каждом этапе только одного эксперта, что улучшило масштабируемость и сделало обучение более стабильным.

Это позволило Google обучить Switch Transformer [6].

Switch Transformer — это не совсем языковая модель в стиле GPT-2/3, поскольку она основана на предсказании не следующего слова, а случайного слова в середине предложения.

(так называемая цель маскированного языка).

Для этого есть причины, но для целей данной статьи я не буду сейчас вдаваться в их подробности.

В результате Switch Transformer обучается до тех же значений целевой функции в 2,5-6 раз быстрее, чем та же монолитная (или плотная) модель, но есть два недостатка.

Во-первых, улучшение способности предсказывать слова не всегда приводит к улучшению способности модели решать определенные проблемы.

Например, Switch Transformer с 390 миллиардами параметров показывает в тесте SuperGlue в среднем немного хуже, чем обычная модель с 13 миллиардами параметров (SuperGlue — это широко используемый набор из 10 различных задач на понимание естественного языка).

Если посмотреть на рисунок из статьи (рис.

2, перевод названий осей), то можно увидеть, что результаты увеличиваются с увеличением количества параметров для всех моделей, но результаты плотных моделей относительно моделей Switch смещаются.

по определенной константе.

Причина этого, по-видимому, в том, что модели Switch уменьшают замешательство в первую очередь за счет способности запоминать больше деталей из конкретных областей, а не за счет общей «умности».

А вот в задачах, требующих знания фактов (например, ответы на вопросы пользователей типа «Сколько звезд видно на небе невооруженным глазомЭ»), большие модели Switch показывают лучшие результаты.

Рисунок 2. Сравнение результатов моделей Switch с монолитными (Dense) моделями Хочется думать, что именно поэтому Яндекс и Сбер тренируют монолитные модели (альтернатива – они просто идут по более простому маршруту).

С точки зрения самообучения Switch обучается быстрее (что обходится дешевле), но для одновременного хранения весов и градиентов все равно требуется большое количество графических процессоров, иначе эти веса придется постоянно загружать из оперативной памяти или даже с диска (т.е.

потому что оперативная память в сотни гигабайт тоже дорогая).

Скорость будет совершенно неприемлемой.

Нам нужна архитектура, компоненты которой можно обучать независимо или хотя бы так, чтобы переключения происходили редко и, следовательно, не отнимали много времени.

Как можно больше? Многие учёные считают, что правило обучения биологического нейрона должно быть локальным (т.е.

зависеть только от непосредственного окружения нейрона, без передачи градиентов).

Существует даже множество попыток заменить обратное распространение ошибки локальным правилом [7, 8], однако для задачи построения языковых моделей такие вещи работают не очень хорошо.

Поэтому я пошел компромиссным путем — каждый эксперт обучается обычным способом (и является обычным преобразователем), а эксперты учатся взаимодействовать по локальному правилу.

Данные и условия обучения модели

Для целей первого эксперимента я взял 20Гб Russian Common Crawl, кое-как почистил его от мусора и добавил отдельно данные из русской Википедии (7ГБ) и сборник текстов книг (5ГБ).Для обучения модели понадобился месяц работы с двумя картами RTX 2080Ti (стоимость времени при покупке в облаке составляет примерно 70 000 рублей).

Модель, которую я пока обозначил кодовым названием GM30B, содержит 30 миллиардов параметров (и занимает около 160 ГБ места на жестком диске).

Пока что модель сильно недообучена (32 ГБ — это очень мало для модели такого размера), поэтому представленные результаты следует считать промежуточными и цель анализа — понять, имеет ли эта идея смысл и стоит ли продолжать.

работа дальше.

Результаты

Недоумение — наиболее часто используемый показатель «качества» языковой модели, показывающий, насколько хорошо модель описывает фактическое распределение вероятностей слов в тексте.Интуитивно мы можем думать о недоумении как о степени ветвления: например, если модель имеет недоумение 100, то в среднем модель будет колебаться при выборе следующего слова между 100 различными словами.

Таблица 2. Сравнение перплексии с различными моделями

| Модель | недоумение (чем меньше тем лучше) |

| RuGPT3-маленький | 30.91 |

| RuGPT3-средний | 22.96 |

| RuGPT3-большой | 21.34 |

| GM30B | 18.02 |

Цифры, естественно, отличаются от опубликованных Сбербанком, поскольку набор данных другой.

По этой же причине этому сравнению можно доверять с определенными оговорками — модель могла привыкнуть к некоторым особенностям данных.

Однако результаты, достигнутые на данный момент, обнадеживают. На самом деле для меня это весьма удивительно, потому что большинство попыток изобрести какой-то велосипед в глубоком обучении обычно заканчиваются ничем (отсюда и желание крупных компаний использовать вещи, которые уже заведомо хорошо работают).

Генерация тестов

Судить о качестве генерации по отдельным примерам довольно сложно, тем более что все сравниваемые здесь модели генерируют в большинстве случаев достаточно качественный текст. Но так как без примеров статья была неполной, вот некоторые результаты.Все тексты получены с использованием одних и тех же параметров генерации (кроме ЯЛМ, здесь тексты были просто получены через сайт «Балабобы», параметры неизвестны).

Контекст: Ученые также сообщили об открытии метанола в молекулярных облаках, удаленных от центра Млечного Пути.

По мнению исследователей, их открытие ставит под сомнение Сгенерированные продолжения:

ruGPT3-среда: гипотеза о том, что Земля вращается вокруг своей оси.По поводу «замшелых стереотипов» у ruGPT3-large видимо проблема с очисткой текста для обучения — эта модель как-то особенно восприимчива к неожиданным сменам тем.ruGPT3-большой: гипотеза о том, что облака состоят из метана, а не аммиака, как считалось ранее.

Узнайте, как замшелые убеждения, стереотипы, страхи и прочие «глюки» мешают человеку стать финансово независимым и начать жизнь без страха!

ruGPT3-XL: Общепринятое мнение состоит в том, что метанол производится фотосинтезом.Ранее сообщалось, что астрономы впервые увидели молекулярные облака на изображении Млечного Пути.

ЯЛМ (с сайта «Балабобы»): существующее представление о том, что в этих облаках не может быть жизни.

При этом открытие метанола тем более удивительно, что эти молекулы, способные существовать в космосе, были обнаружены именно в молекулярных облаках.

ГТ30Б: общепринятая теория о том, что в галактиках гораздо больше метана, чем считалось ранее.

Ученые проанализировали данные, собранные космическим телескопом «Хаббл», и пришли к выводу, что скопления галактик содержат гораздо больше углекислого газа (CO2), чем считалось ранее.

Контекст: я оглянулся и увидел женщину, торопливо уводящую нескольких детей из наших двух групп.

Она тоже оглянулась, перевела на нас взгляд и приказала своему отпрыску поторопиться.

Младшая скулила, пытаясь удержать ее у витрины со сладостями* Сгенерированные продолжения:

Продолжение: ruGPT3-среда: Мы последовали за ней по длинному коридору, в конце которого была дверь.Женщина открыла ее, и мы вошли в небольшую комнату, полную столов и стульев.

ruGPT3-большой: Пошли, — сказала она, и мы последовали за ней, не обращая внимания на то, что она кричит на нас, как курица на своих птенцов.

Когда мы проходили мимо ларька со свежими фруктами, она схватила меня за руку и потянула за собой, так что я едва мог поспевать за ней.

Мы остановились перед витриной с мороженым.

ruGPT3-XL: Женщина оглянулась на нас и сказала: «Не беспокойте нас».

Мы переглянулись и медленно начали обходить магазин с другой стороны.

Женщина все еще смотрела на нас.

YAML (с сайта «Балабобы»): — Я уже купил! - воскликнула она, вытаскивая из кармана монету.

- Верните эту мерзость! - Я закричал

ГМ30Б: но она не обращала на него ни малейшего внимания, продолжая уводить детей от нас.Мы последовали за женщиной к выходу с рынка, и когда она скрылась из виду, я услышал, как один из моих спутников сказал другому: «Что-то в поведении этой женщины мне показалось странным, но я никак не могу понять».

».

в чем дело.

* Контекст взят из перевода романа К.

Азаро «Инверсия первого примера».

Этот роман не включен в данные обучения для GM30B; для других моделей это неизвестно.

Дополнительное обучение по задачам нового поколения

Важной особенностью предварительно обученных языковых моделей является то, что для изучения новой задачи им требуется гораздо меньше данных.Возможность переобучить модель на небольшом объеме данных очень важна для практики.

Для сравнения я взял задачу генерировать отзывы о магазине и дополнительно обучил разные модели на небольшом наборе текста в 400Кб (400Кб считается малым набором, так как при обучении с нуля обычно нужны сотни мегабайт данных для получения приемлемый результат).

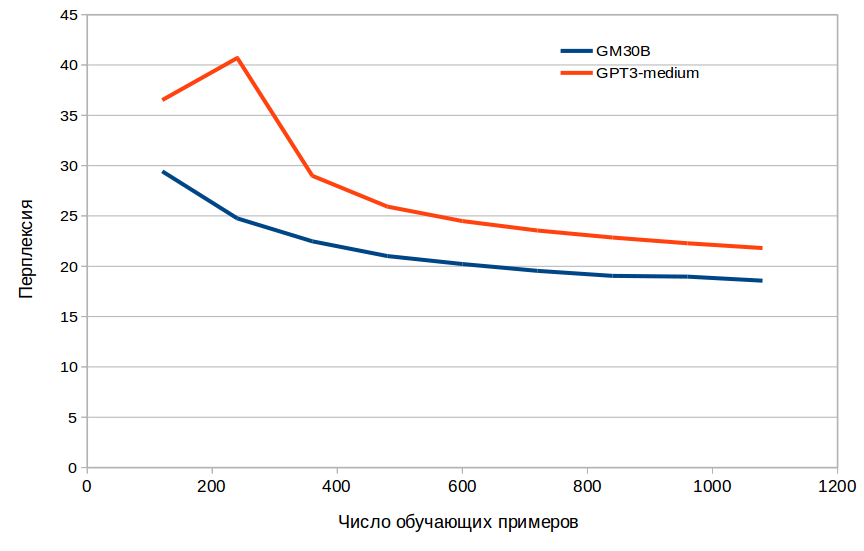

Рисунок 3. Сравнение эффективности дополнительного обучения GM30B и ruGPT3-среды На рисунке 3 показано сравнение дополнительного обучения со средой ruGPT3. Видно, что обучение происходит быстрее и требуется меньше обучающих примеров для достижения тех же значений недоумения.

Теоретически это уже может принести практическую пользу.

Мы часто сталкиваемся с клиентами с задачами по генерации текста, имеющими всего несколько сотен примеров, и оказывается, что, возможно, в этой задаче результат будет лучше при сопоставимых затратах (Однако, чтобы быть уверенным, этот опыт следует повторить на разных типах текстов ).

Решение проблем

Будет интересно посмотреть, как наша модель справляется с распространенными проблемами.Хотя здесь я изначально не жду чудес, так как характер модели не позволяет ей быть особенно хорошей в этой области.

Пока что мне удалось протестировать работоспособность модели на одной такой задаче.

ПАРус — задача, входящая в состав российского набора «СуперКлей».

Судя по описанию на сайте: «Каждый вопрос в PARus состоит из посылки и двух альтернатив, где задача состоит в том, чтобы выбрать ту альтернативу, которая более правдоподобно причинно связана с посылкой.

Правильная альтернатива рандомизируется так, что ожидаемая эффективность случайного угадывания составляет 50%.

Например, учитывая текст «Гости вечеринки прятались за диваном», нужно выбрать причину: «Это была вечеринка-сюрприз» или «Это был день рождения».

Правильные ответы тестовой выборки скрыты, но вы можете проверить результат модели на сайте.

Таблица 3. Сравнение результатов модели в задаче PARus

| Модель | Точность |

| RuGPT3-маленький | 0.562 |

| RuGPT3-средний | 0.598 |

| RuGPT3-большой | 0.584 |

| РуГПТ3-XL | 0.676 |

| GM30B | 0.704 |

| ЯЛМ 1Б | 0.766 |

Результаты GM30B показаны для режима обучения с нулевым выстрелом, когда вообще не используются примеры из обучающего набора, модель полагается только на то, что ей известно.

Точные подробности того, как остальные модели тестировались их разработчиками, неизвестны.

В этой задаче, судя по результатам, GM30B уступает только модели от Яндекса, опережая RuGPT3-XL. Скриншот с российского сайта SuperGlue с результатом выполнения задания PARus

Какие выводы мы можем сделать из всего этого на данный момент? На мой взгляд, есть основания полагать, что обучение языковых моделей, хотя бы по некоторым параметрам существенно не уступающих ruGPT3/YaLM, все еще под силу независимым разработчикам, не обладающим ресурсами крупных компаний.

Правда, для полной картины пока отсутствуют результаты других тестов.

Почему это важно и важно ли это?

Большие языковые модели открывают возможность создания совершенно новых классов приложений, которые ранее было невозможно или трудно реализовать.Это генераторы программного кода (в том числе недавно анонсированный GitHub Copilot), генераторы дизайна, новые классы игр, где ИИ придумывает сюжет и действия персонажей, генераторы сценариев для видеороликов, генераторы контент-планов для социального продвижения.

сетях, толковые помощники-копирайтеры, медицинские консультанты и еще много всего разного.

Кроме того, многие существующие проблемы решаются быстрее, например, значительно упрощается извлечение данных из неструктурированного текста и создание чат-ботов.

В то же время доступ разработчиков к этим чудесам крайне неравномерен.

OpenAI по-прежнему предоставляет доступ к английскому GPT3 лишь избранным, выбирая тех, кто «достоин» с их точки зрения.

При этом критерий «достоинства», по-видимому, совершенно условен.

Заметки о том, как OpenAI выбирает достойных Форму запроса доступа к GPT-3 я заполнил в день ее появления, подробно описав задачи, себя, публикации по теме и т.д. Как и ожидалось, ответа пока не получил.

В принципе, мои достижения довольно скромные, поэтому я особо не удивился.

Но среди клиентов моей компании были люди, у которых был ключ доступа, и некоторые получили его, по их словам, просто «введя в форму какую-то ерунду».

Собрав данные о тех, кто получил ключ, и о тех, кто не получил, я не обнаружил каких-то особенных качеств среди тех, кто его получил.

Конечно, это субъективное наблюдение, основанное на небольшой выборке и на его основе невозможно сделать однозначный вывод. Но это не единственная проблема; становится еще «интереснее», когда сама компания, создатель или владелец такой модели, начинает предлагать не доступ, а создание конечных продуктов.

Например, та же Microsoft, вложив в OpenAI $1 млрд, получила эксклюзивные права решать, что делать с GPT3 (по соглашению с OpenAI).

Сейчас Microsoft создает уникальные продукты, например в области автоматизированного написания кода, тот же GitHub Copilot, имеющий преимущество в возможности дальнейшего обучения самой большой версии GPT3. Неясно, к чему это приведет, но потенциал создания монополии кажется значительным, поскольку подобным стартапам вроде source.dev, имеющим доступ только к API генерации, будет трудно конкурировать с такими возможностями, и они платят за это.

API, что означает, что продукт должен быть оплачен клиентом.

Ситуация с российскими моделями не лучше (если не хуже).

Позвольте мне привести вам сравнительный пример.

В то время, когда OpenAI обучала GPT-2, они постепенно выпускали модели в открытый доступ, и энтузиасты начали создавать простые интернет-страницы, на которых можно было генерировать текст с их помощью.

Один из таких проектов, talktotransformer, собрал миллионы просмотров и превратился в популярный сервис InferKit. Позже вокруг InferKit появилось несколько клонов и сайтов, расширяющих функционал, и теперь это целая область со своим окружением.

Плюс многие сервисы, не имеющие доступа к GPT-3 API OpenAI, теперь используют InferKit и подобные вещи, например, ряд популярных сервисов для копирайтеров.

Теперь вопрос, что будет, если OpenAI разместит на своем сайте такую форму для генерации текста? Это противоречит цели таких сайтов, как talktotransformer, барьер для входа в эту область резко возрастет, и, скорее всего, InferKit никогда бы не возник.

Те.

Некоторые случайные движения разработчика языка могут создавать и разрушать довольно большие ниши для независимых разработчиков и небольших компаний.

Как мы знаем, Сбер разместил такую форму на своем сайте, а Яндекс пошел еще дальше и сделал целый сервис бесплатной генерации текста, который убивает потенциально большое количество сторонних приложений, поскольку небольшие компании не могут предложить такие вещи бесплатно даже при наличии модель от Сбера - GPU серверы запускающие большие монолитные модели стоят значительных денег, а качество открытого ruGPT3-XL заметно ниже.

Здесь можно утверждать, что люди только выиграют, если какую-то услугу предоставит крупная компания и бесплатно.

Но у этой ситуации есть и минусы – она приводит к образованию монополий, что плохо для развития отрасли (меньшее разнообразие всегда плохо с точки зрения эволюции) и в конечном итоге плохо для потребителя – монополия может начать навязывают всевозможные условия, от которых невозможно отказаться.

Конечно, все это характерно не только для языковых моделей, и мы можем вспомнить множество областей ИТ, где существует подобная ситуация.

Это в какой-то степени «естественный» процесс, вызванный объективными причинами, и повлиять на него каким-либо серьезным образом вряд ли возможно.

Однако если бы языковую модель можно было, приложив некоторые усилия, сделать более доступной для отдельных разработчиков и небольших компаний, это могло бы принести некоторую пользу.

Еще один момент, на который необходимо обратить внимание, заключается в том, что важен исследовательский процесс разработки и обучения новых архитектур в этой области.

Ну и действительно, оказывается, что все сверхбольшие модели для русского языка являются копиями GPT-3 с небольшими вариациями или вообще без вариаций.

Да, технически задача параллельного обучения на кластере непростая, но это именно техническая задача, и выполняя ее, мы ничему не учимся в плане проектирования архитектуры и понимания того, как ведут себя различные модификации.

Это может закончиться тем, что мы совсем забудем, как создавать что-то оригинальное, и сможем лишь копировать с небольшими изменениями (сами названия ruGPT3 и YaLM — Yet Anoter Language Model — красноречивы, мне кажется).

Заключение

В этой статье я попытался подвергнуть сомнению тезис о том, что эксперименты с обучением сверхбольших языковых моделей доступны только крупным компаниям.Хотя представленные результаты пока не позволяют с уверенностью опровергнуть этот тезис, они дают повод для надежды.

Библиография

1. Трин, Триу Х.и Куок В.

Ле.

«Имеют ли языковые модели здравый смыслЭ» (2018).

https://openreview.net/forumЭid=rkgfWh0qKX 2. Рэдфорд, Алек и др.

«Языковые модели — это многозадачные ученики без присмотра».

Блог OpenAI 1.8 (2019): 9. 3. Браун, Т.

Б.

, Манн, Б.

, Райдер, Н.

, Суббия, М.

, Каплан, Дж.

, Дхаривал, П.

, .

и Амодей, Д.

(2020).

Языковые модели учатся с небольшим количеством попыток.

Препринт arXiv arXiv:2005.14165 .

4. Прет, Фредерик Р.

, e. Теги: #Машинное обучение #Алгоритмы #Будущее уже здесь #искусственный интеллект #языковые модели #Обработка естественного языка #rugpt-3 #нейронные сети #глубокое обучение #GPT-2 #OpenAI #GPT-3 #обработка естественного языка #глубокие нейронные сети #генератор текста

-

Шакал

19 Oct, 24 -

Как «Перепрограммировать» Рак

19 Oct, 24 -

«Сделай Меня Красивой!» Выпуск №27

19 Oct, 24 -

Вопросы О Заработке В Интернете.

19 Oct, 24